边缘智能:深度学习与边缘计算的完美结合

一、深度学习的发展

近年来,机器学习普遍应用于各个领域。我们也被机器学习的应用所包围,比如:在计算机程序、媒体等领域经常接触。本质上,机器学习使用算法从数据中提取有用的信息,然后将其呈现在一个模型中,最后使用该模型在生活中应用实验或未建模的数据。

神经网络是机器学习的模型之一,已经存在了数十年之久。这个概念是由研究哺乳动物大脑中生物神经元的科学家定义的。随着时间的推移,生物体大脑中的神经元节点会进化,而神经网络中神经元节点之间的连接也会发展。

许多重要的神经网络框架是在 80 年代中期和 90

年代早期发展和完善的。然而在某种程度上来讲,它花费了大量的时间和数据为了获得更好的结果,但由于当时计算机的计算能力不足,阻碍了神经网络的发展,并逐渐被人们所淡忘。

在 21 世纪初,计算机的计算能力飞快增长,人们见证了计算机技术出现前所未有的大爆发。

就在这个时候,深度学习出现在计算能力爆炸式增长的十年中,赢得了许多重要的机器学习竞赛,在众多领域取得较好成绩。

实现对人脑的进一步模拟,是各种深度学习算法不断进步的原因。目前,只能针对不同类型的学习进行不同的算法模型选择。其中卷积神经网络是深度学习中较为优秀的一部分,具有较长久的应用历史。

1989 年研究者使用反向传播算法首次提出卷积神经网络,再由LeCun等人提出的 LeNet-5

模型应用于手写数字识别。目前卷积神经网络已经衍生为一个繁荣的大家族,能够实现不同的图像处理的工作。其模型包括最典型的卷积网络组成:卷积层,池化层和完全连接层。卷积神经网络使用多个卷积组(由卷积层和池化层组成)来逐层从图像数据中提取特征。最后,使用多个全连接层和分类算法来完成分类任务。其中池化层的作用主要是降低输入维度。

早期的图像分类任务是研究基于特征的分类任务。涉及的特征主要包括:图像的颜色和形状。常用的分类器有:BP 神经网络、支持向量机(SVM)等。

在 AlexNet 赢得 2012 年Imagenet 图像分类竞赛冠军之前,该模型的 Top-5 错误率仅为

16.4%,与传统方法的第二和第三名的 26.17%和 26.79%相比,大幅度降低。这是 CNN 在大规模图像分类中的巨大成功。 继 AlexNet

模型成功后,学术研究人员进一步改善了神经网络的性能,并提出了诸如GoogLeNet,VGG,ResNet和其他可以有效分类和检测的网络结构。这些结构层越来越深,ResNet

已达到 152 层。随着网络的深入,提取的特征数量增加,解决了过拟合、欠拟合等问题。

目前,在一些具有特定环境的工业和农业生产领域,机器视觉已经具备了远超生物视觉的表现。 神经网络的结构复杂是一种趋势,但过于复杂的网络结构也制约了深度网络的发展,对于学习成本和改进成本都大幅度提升。目前从全局上都以卷积神经网络为代表的深度网络进行结构改进成为了主流之一,这种宏观上的改革包括将 dropout 技术引入卷积神经网络中,并进一步将 maxout 和 dropout 配合始终对整体网络效果进行优化。

一方面,深度学习是机器学习的延展,作为现如今支撑现代技术最为火热的深度学习,如何合理的与物联网结合,并应用在农业领域,成为当下非常重要的研究方向。

另一方面,目前深度学习广泛应用于各种农业场景,包括物联网的传感器和摄像头等终端设备正在获取的农作物数据。这些数据需要使用深度学习进行实时分析,或用于训练深度学习模型。

然而,深度学习模型需要消耗大量的计算资源。此时,边缘计算技术能为以各类神经网络技术为主的深度学习提供充足的计算资源,用边缘端在终端附近、拥有一定计算能力和低延迟的特点,将边缘计算和深度学习结合在一起成为一种可行的方法。

二、边缘计算的产生与应用

随着众多产业向数字化的转型,大流量的使用让云计算获得了巨大的发展,计算、存储和各种网络功能一起管理的方式使计算具有极高的成本效益和灵活性。

近年来,移动设备和联网设备的数量呈爆炸式增长,甚至预测,到 2025 年全球将有近千亿台物联网设备,云计算正在努力应对物联网设备产生的海量数据和物联网设备所需的低延迟,但云计算配置的更新速度远不及数据增长的速度,这就急需一种可以分担云端压力的计算思想和传输设备。

边缘计算是一种新的概念,而物联网的快速发展,也为边缘计算带来更多机会。数十亿的移动设备和物联网设备连接到互联网,在网络边缘产生海量字节的数据。在这一趋势的推动下,迫切需要将人工智能前沿推向网络边缘,充分释放边缘大数据的潜力。

物联网技术的发展离不开边缘计算技术的发展。学术界和业界对边缘计算的评价和期望都很高。

2015 年 9 月,欧洲电信标准化协会发表了有关移动边缘计算的白皮书,现已在全球推广;

2016 年 5 月,美国 Wayne State 大学的施教授给出了边缘计算正式定义:一种运行在网络边缘的计算模型;美国自然科学基金委在 2016 年将边缘计算列为突出领域;

2016 年10 月,边缘计算的顶级学术会议 SEC 由 ACM 和 IEEE 正式首次举办,在界内引起很大的反响。

2016 年 11月,华为、中科院自动化所联合英特尔等国内外机构合作组织了边缘计算产业同盟。

2018 年 12月,我国工信部而也表示国内各研究领域要加大对边缘计算的支持力度,边缘计算的产业发展得到了更好的推动。

随着移动计算和物联网(IoT)的普及,边缘计算作为一种将计算任务和服务从网络核心推向网络边缘的新兴范式,被广泛认为是一种很有前途的解决方案。

Khelifi等人研究并讨论深度学习模型和边缘计算结合的适用性。

Zhang等人提出了一种基于移动边缘计算和深度学习的城市街道清洁度评价方法。移动边缘服务器临时存储和提取安装在车辆上的高分辨率摄像头,以收集街道图像,然后将其处理并传输到云端进行分析。

Liu等人提出了一种以无线传输为方法,利用边缘节点计算能力的边缘计算网络框架。对无线信道参数进行预测,对于提前规划系统资源管理和优化系统性能具有重要意义

Beatriz Blanco-Filgueira等人提出在NVIDIA Jetson TX2开发工具包上实现了基于低功耗和实时深度学习的多目标视觉跟踪。深度学习算法在嵌入式平台上的可行性是由其功耗和帧率方面的研究结果所证明的。

S. Chandakkar考虑到在边缘设备上更新、训练 DNN 模型,将一些计算转移到云基础设施的边缘,介绍了修剪网络再训练的概念,这将有助于智能设备的更好表现,并提高它们的容错能力。

在深度学习与边缘计算的结合过程中,每一次重复训练学习都需要消耗大量的计算资源,这个时候就需要通过迁移学习来继续使用训练好的模型。

三、使用云边协同进行深度学习的训练步骤

通过云服务器训练网络模型,然后云服务器将训练好的模型发送到边缘端,最后由边缘设备通过使用迁移学习和训练好的模型对新数据进行再训练、识别等任务,就可以不用考虑云服务器的负载状态。 因此,使用云边协同方式进行深度学习的训练就能够减轻云端压力,提高运行速度,降低总运行时间。

- 1、首先是将我们在终端采集到的训练数据传给云端计算设备,由云端设备训练神经网络模型;

- 2、其次将训练好的模型传到边缘设备;

- 3、最后将终端测试或继续训练的图片传给边缘端,边缘端通过迁移学习来识别或训练图片数据。

四、迁移学习

越来越多的深度学习应用场景的出现,模型的训练和数据的标记都需要大量的时间和资源,所以迁移学习受到越来越多的关注。

Zhao等人提出了一种基于完全预训练 CNets 的利用分类迁移学习方法,加快训练过程的收敛速度。

QI等人提出了一种个性化的 SBIR体系结构。用户将历史反馈与手绘的图像相结合作为迁移学习模型的输入,对特征在向量空间的分布进行微调,使神经网络能够学习个性化的语义信息。

Seker 等人提出了一种迁移学习方法。迁移学习的目的是使用一个预先训练好的网络,而不是从零开始训练它作为新问题的基础。使用数百万张图像训练的AlexNet 模型,迁移学习将训练成功率从 75%提高到> 98%。

对于迁移学习的应用场景,将任务下发到其他计算资源上就变得尤其重要,这样不仅可以加快速度,还可以降低云服务器的计算压力。

迁移学习(Transfer Learning)是一种具有强拓展性的先进机器学习方法,相对于其他传统的机器学习算法,迁移学习采用已有的算法模型作为基础,进一步将存在的模型在新的任务中使用。其最主要特点在于其具有极强的通用性,相比其他算法,无论是深度学习还是机器学习,都需要针对实际问题进行本地化操作才能更好实现既定目标,但迁移学习具有强拓展性的瞩目特点使近年来的人工智能领域对其进行了较多的关注。

| 任务 | 迁移学习 | 传统机器学习 |

|---|---|---|

| 数据分布 | 训练和测试数据不需要同分布 | 训练和测试数据同分布 |

| 数据标签 | 不需要足够的数据标注 | 足够的数据标注 |

| 建模 | 可以重用之前的模型 | 每个任务分别建模 |

迁移学习的关键即使从不同的原始数据集中提取目标的相似性,以建立起从以往的学习模型中向新的进化模型中相互迁移进行进化的可能索引。

从算法的训练集角度来说,迁移学习可以实现小样本的强优化性能。图像识别是最经典的利用不断补充训练集进行大量学习的领域之一,其通过巨型的训练集训练可以将诸多的形态学特征和纹理特征得以学习,然后通过补充数据进行进一步的更正。

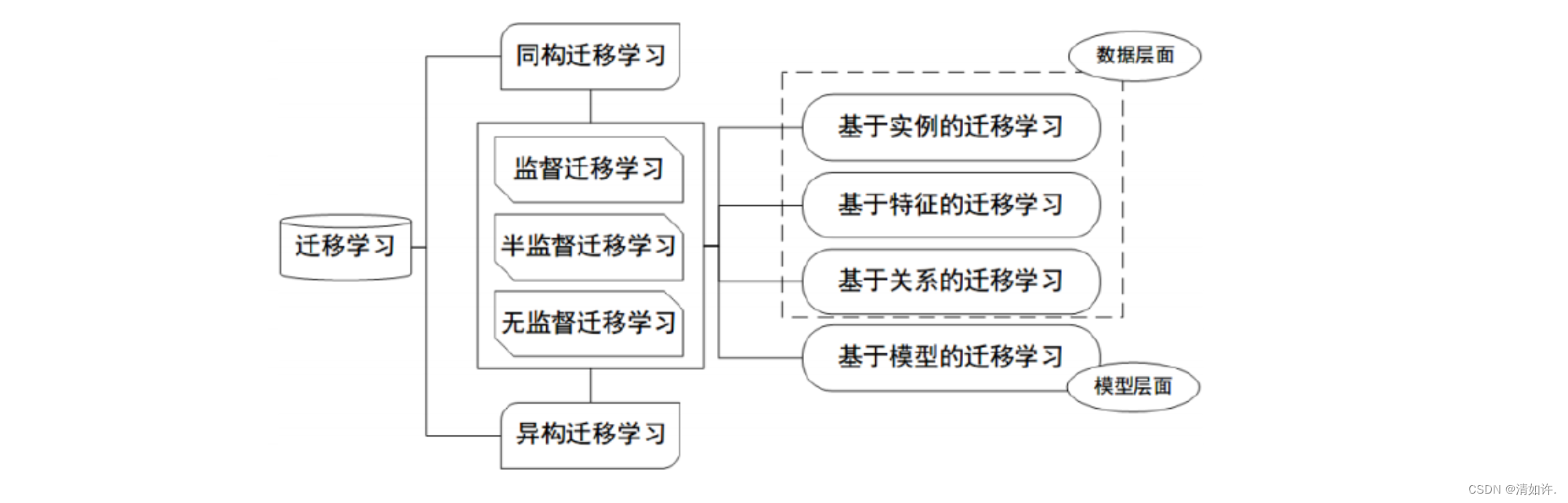

在迁移学习中,算法会根据数据化的训练集在统一字段中进行连续训练和识别,有选择地进行基于样本迁移后特征的迁移,最终完成模型迁移与逻辑迁移。其中,样本迁移的基本是需要将源数据和目标标签进行变换最终进入到新的维度空间,该空间可能和原始空间具有复杂的变换关系,最终在变换中通过对各类距离的最小化约束完成特征的迁移,而经过距离优化过程中同时完成了模型的迁移。整体过程中不仅存在着对有标签数据的监督学习,也囊括了在迁移过程中不可少的无监督和半监督学习

边缘计算优势

由于计算设备和数据源的距离优势,采用边缘技术的领域,可以实时反馈和处理,相对于云计算,类比于电力系统的孤岛和并网运行,更具有先天的安全性。

综上所述,边缘计算具有如下的特点。

(1)分布式和低延时。边缘谁被可以建立在距离数据接收源很近的位置,因此这种设备可以实时获取数据并进行分析,从而可以更好地支持本地企业的实时智能处理和执行。

(2)执行效率高。边缘计算由于先天具有近端分析的结构特性,可以在用户节点就对待处理数据进行相关分析,相比传统的传输到后方进行集中处理,这种分布式的配置具有显著的高效性。

(3)节省网络资源。边缘计算的数据处理任务可以在云端输送前就完成一部分,从而减少集中处理的压力,并有效减少实际传送的流量。一方面针对有限吞吐量时大幅度提高输送的信息载荷,另一方面也减少了服务器端的运算需求。

(4)安全性更高。当大量用户数据输入到云端时,可能会出现某些不良人员盗取数据,在用户不知情的情况下使用用户数据,而边缘计算在接收到数据之后,可以对数据加密或分析处理之后再进行传输,提升了数据的安全性,并且保证了用户的隐私。

(5)协议标准化。分布式运算需要协调各数据节点的通信协议,在进行握手时,避免产生额外的数据的解析计算,另一方面由于数据格式的差异性,也必须避免在多方协作时产生错误。因此需要对整体的计算计算进行协议统一和标准统一。

目前,边缘计算已经成为云计算的重要技术之一。单一的高性能大容量计算单元正在被分布式的云计算协作取代,这样的取代具有更高的速度,并能完成某些实时性工作。

以电商为例,在用户侧进行购物推荐算法的部分计算,可以有效缓解网站上的计算单元的负荷,并可以实现在计算时间内近乎实时性的根据用户的喜好完成推荐任务,这就是边缘计算在云计算大环境下的实际应用。

- 点赞

- 收藏

- 关注作者

评论(0)