机器学习模型从理论到实战|【009-梯度提升树】房价预测

引言

梯度提升树(GBDT)是一种常见的集成学习方法,它结合了多个决策树以提升模型性能。作为一种强大的非线性回归和分类算法,GBDT在各种机器学习任务中表现出色,尤其擅长处理复杂的数据关系。本文将介绍GBDT的基本原理,并通过“房价预测”和“信用评分”两个应用案例,展示其实际效果。

1.什么是梯度提升树(GBDT)?

梯度提升树(GBDT)是通过梯度提升方法(Gradient Boosting)构建的决策树集成。每棵树都在前一棵树的基础上进行改进,旨在减少预测误差。GBDT的基本思想是逐步拟合残差(误差),每次通过新一轮的训练减少上一轮模型的误差。

GBDT的工作原理如下:

- 初始化模型: 一开始使用一个常数(例如训练数据的均值)作为模型的初步预测。

- 计算残差: 对每个样本,计算当前模型的残差(即真实值与预测值的差)。

- 训练新的决策树: 训练一棵新的决策树,使得它能够预测残差。

- 更新模型: 将新决策树的预测值加入当前模型,以更新模型的整体预测。

- 迭代过程: 这一过程会重复进行多轮,每次通过新的树来改进模型的预测。

GBDT通过梯度下降优化损失函数,使用最小二乘法(L2损失)或其他损失函数来优化模型。公式化来说,损失函数最小化的目标可以表示为:

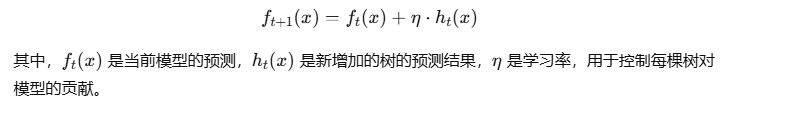

GBDT的更新公式为:

2.应用场景:

- 分类与回归: GBDT适用于大多数分类和回归问题,能够处理数据中的复杂非线性关系。

- 房价预测: 结合多个特征(如地理位置、房屋面积、房龄等),使用GBDT模型预测房价。

- 信用评分: 通过客户的个人数据,预测其信用分数,帮助金融机构评估贷款风险。

3.实现项目:

- 房价预测

房价预测是一个典型的回归问题,使用GBDT可以有效地结合多个特征,进行精准的预测。步骤如下:

- 数据预处理: 清理数据、填补缺失值,并对类别变量进行编码。

- 特征工程: 从多个角度提取特征,比如对房屋的地理位置、面积、楼层等进行数值化处理。

- 训练模型: 使用GBDT算法训练回归模型,预测房价。

- 模型评估: 使用均方误差(MSE)等评估指标来衡量模型的性能。

- 信用评分

信用评分是金融领域的关键任务,通过分析客户的个人信息和历史交易数据,预测客户的信用评分。步骤如下:

- 数据预处理: 处理缺失值、标准化数值特征、对类别特征进行编码等。

- 特征选择: 从客户数据中提取有价值的特征,如收入、信用历史、借款情况等。

- 训练模型: 使用GBDT对客户的信用评分进行预测。

- 模型评估: 使用AUC、精确度等指标评估模型的分类性能。

代码实现:

from sklearn.model_selection import train_test_split

from sklearn.ensemble import GradientBoostingRegressor

from sklearn.metrics import mean_squared_error

import pandas as pd

# 示例数据:房价数据(实际项目中需加载更多数据)

data = {

'面积': [100, 150, 120, 80, 200],

'房龄': [5, 10, 8, 15, 3],

'楼层': [3, 10, 2, 5, 7],

'房价': [500000, 800000, 600000, 400000, 900000]

}

df = pd.DataFrame(data)

# 特征和标签

X = df[['面积', '房龄', '楼层']]

y = df['房价']

# 训练测试分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 初始化GBDT回归器

gbdt = GradientBoostingRegressor(n_estimators=100, learning_rate=0.1, max_depth=3, random_state=42)

# 训练模型

gbdt.fit(X_train, y_train)

# 预测

y_pred = gbdt.predict(X_test)

# 评估

mse = mean_squared_error(y_test, y_pred)

print(f"均方误差: {mse}")

4.优化与缺点:

1.优点:

高精度: GBDT能够处理复杂的非线性关系,并且在许多任务中能够提供高精度的预测。

灵活性: 通过调整超参数(如树的深度、学习率等),可以控制模型的复杂度和拟合能力。

鲁棒性: GBDT对于异常值和噪声具有较强的鲁棒性。

2.缺点:

计算开销: 每次迭代都需要训练新的树,因此计算量较大,训练过程相对较慢。

过拟合风险: 尽管GBDT具有较强的拟合能力,但如果模型过于复杂(如树的深度过大、迭代次数过多),可能会导致过拟合。

调参难度: 需要调整多个超参数(如学习率、树的深度、迭代次数等),调参过程较为复杂。

总结:

梯度提升树(GBDT)是一种非常强大的集成学习方法,适用于各种回归和分类问题。通过逐步拟合残差,GBDT能够捕捉数据中的复杂非线性关系,表现出色。在房价预测和信用评分等实际应用中,GBDT能提供高精度的预测结果。尽管计算开销较大,并且需要进行调参以避免过拟合,但通过适当的正则化和超参数调优,GBDT仍然是一种非常有效的机器学习算法。

- 点赞

- 收藏

- 关注作者

评论(0)