简单可控的音乐生成

@[toc]

摘要

论文连接:https://arxiv.org/pdf/2306.05284v1.pdf

我们解决了条件音乐生成的任务。我们引入MUSICGEN,这是一个单一的语言模型(LM),它可以在几个压缩的离散音乐表示流(即token)上操作。与之前的工作不同,MUSICGEN由单级变压器LM和有效的Token交错模式组成,这消除了层叠多个模型的需要,例如,分层或上采样。按照这种方法,我们将演示MUSICGEN如何生成高质量的样本,同时以文本描述或旋律特征为条件,从而更好地控制生成的输出。我们进行了广泛的经验评估,考虑到自动和人类研究,表明所提出的方法优于标准文本到音乐基准的评估基线。通过消融研究,我们阐明了组成MUSICGEN的每个组件的重要性。音乐示例、代码和模型可在https://github.com/facebookresearch/audiocraft上获得。

1、简介

文本到音乐是指在给定文本描述的情况下生成音乐作品的任务,例如,“90年代吉他即兴摇滚歌曲”。生成音乐是一项具有挑战性的任务,因为它需要对长序列进行建模。与语音不同,音乐需要使用全频谱[Müller, 2015]。这意味着以更高的速率对信号进行采样,即音乐录音的标准采样率为44.1 kHz或48 kHz,而语音的采样率为16 kHz。此外,音乐包含来自不同乐器的和声和旋律,这创造了复杂的结构。人类听众对不和谐非常敏感[Fedorenko等人,2012,Norman-Haignere等人,2019],因此生成音乐不会给旋律错误留下太多空间。最后,以多种方法控制生成过程的能力,如键、乐器、旋律、流派等,对音乐创作者来说是必不可少的。

自监督音频表示学习[Balestriero等人,2023]、序列建模[Touvron等人,2023]和音频合成[Tan等人,2021]方面的最新进展为开发此类模型提供了条件。为了使音频建模更容易处理,最近的研究提出将音频信号表示为表示同一信号的多个离散token流[Défossez等人,2022]。这使得高质量的音频生成和有效的音频建模成为可能。然而,这是以联合建模几个并行的依赖流为代价的。

Kharitonov等人[2022],Kreuk等人[2022]提出了采用延迟方法并行建模语音token的多流,即在不同流之间引入偏移量。Agostinelli等人[2023]提出使用不同粒度的多个离散标记序列来表示音乐片段,并使用自回归模型的层次结构对其进行建模。与此同时,Donahue等人[2023]采用了类似的方法,但针对的是演唱到伴奏生成的任务。最近,Wang等人[2023]提出分两个阶段解决这个问题:(i)只对第一个token流建模;(ii)然后,应用后网络以非自回归的方式联合建模其余流。

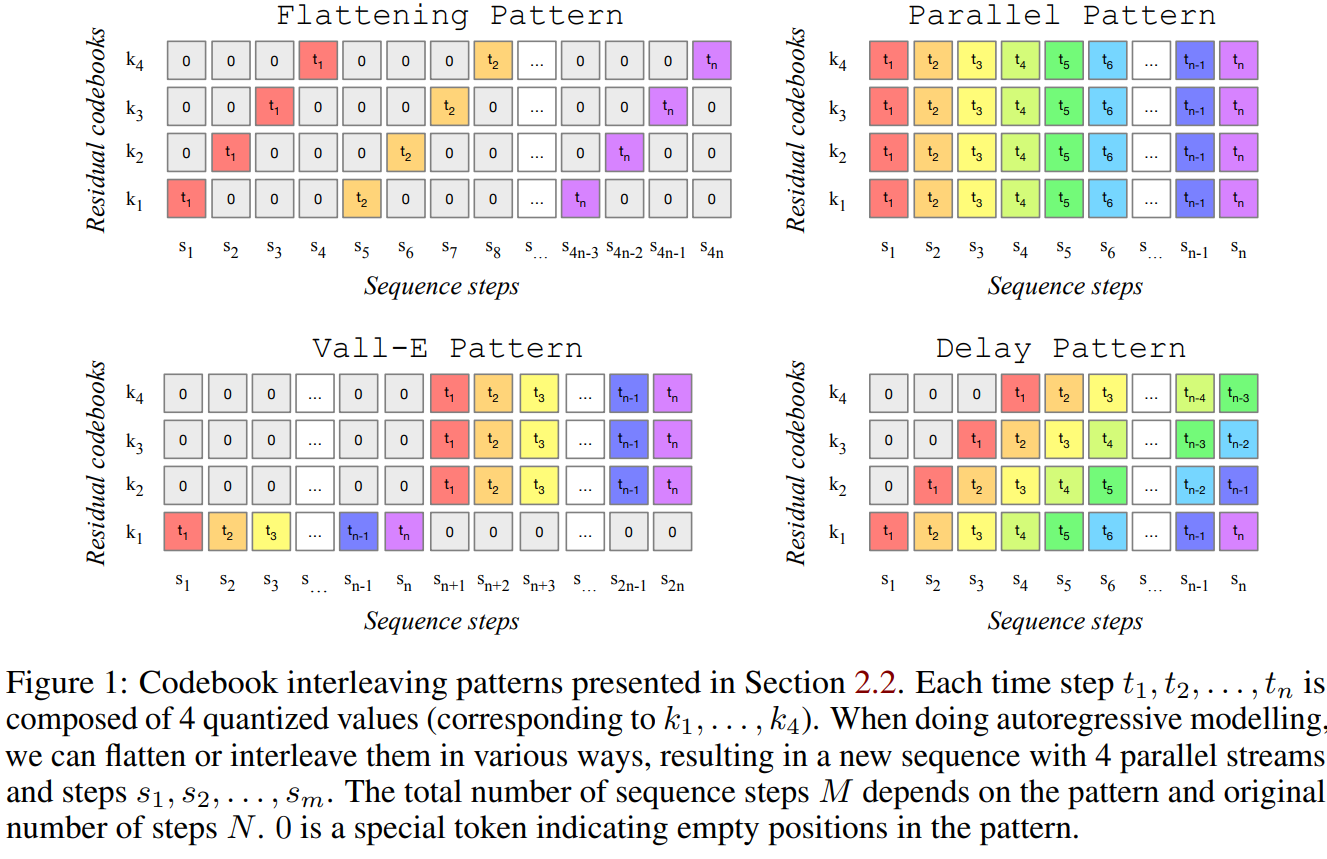

本文提出MUSICGEN,一种简单、可控的音乐生成模型,能在给定文本描述的情况下生成高质量的音乐。本文提出一个对多个并行声学token流进行建模的通用框架,作为以前研究的概括(见图1)。为提高生成样本的可控性,本文还引入了无监督旋律条件,使模型能够生成匹配给定和声和旋律结构的音乐。对MUSICGEN进行了广泛的评估,所提出的方法在很大程度上优于评估基线,MUSICGEN的主观评分为84.8(满分100分),而最佳基线为80.5。还提供了一项消融研究,阐明了每个组件对整体模型性能的重要性。最后,人工评估表明,MUSICGEN产生了高质量的样本,这些样本在旋律上更好地与给定的和声结构对齐,同时符合文本描述。

本文贡献:(i)提出了一个简单高效的模型,可以在32khz产生高质量的音乐。MUSICGEN可以通过有效的码本交错策略,用单阶段语言模型生成一致的音乐。(ii)提出一个单一的模型,来进行文本和旋律条件生成,并证明生成的音频与提供的旋律是一致的,并忠实于文本条件信息。(iii)对所提出方法背后的关键设计选择进行了广泛的客观和人工评估。

2、方法

MUSICGEN由一个基于自回归transformer的解码器组成[Vaswani等人,2017],以文本或旋律表示为条件。(语言)模型位于编码器[Défossez等人,2022]音频分词器的量化单元之上,该音频分词器从低帧率离散表示中提供高保真重建。压缩模型,如[Défossez等人,2022,Zeghidour等人,2021]采用残差矢量量化(RVQ),这会导致多个并行流。在这种情况下,每个流由来自不同学习码本的离散token组成。在之前的工作中,提出了几种建模策略来处理这个问题[Kharitonov等人,2022,Agostinelli等人,2023,Wang等人,2023]。本文提出一种新的建模框架,可推广到各种码本交织模式,并探索了几种变体。通过模式,我们可以利用量化音频标记的内部结构。最后,MUSICGEN支持基于文本或旋律的条件生成。

2.1、音频词元化

我们使用EnCodec[Défossez等人,2022],一个卷积自编码器,使用残差矢量量化(RVQ)对潜空间进行量化[Zeghidour等人,2021],以及一个对抗性重建损失。给定一个参考音频随机变量,其中d为音频时长,为采样率,EnCodec将其编码为一个帧率的连续张量。然后,这种表示被量化为,其中K为RVQ的码本数目,N为码本大小。注意,量化后我们留下K个并行离散token序列,每个长度为,表示音频样本。在RVQ中,每个量化器对前一个量化器留下的量化误差进行编码,因此不同码本的量化值通常是不独立的,而第一个码本的量化值是最重要的。

2.2、码本交错模式(见图1)

精确的扁平自回归分解。一个自回归模型需要一个离散随机序列,其中S为序列长度。按照惯例,我们将使用,这是一个确定性的特殊标记,表示序列的开始。然后我们可以对分布进行建模

让我们递归地定义,对于所有,

然后,我们立即得到和遵循相同的分布。这意味着,如果我们能拟合的完美模型,那么我们就能精确拟合的分布。

如前所述,我们从编码器模型中获得的表示Q的主要问题是每个时间步有K个码本。一种解决方案是将Q平坦化,从而采用,例如,首先预测第一个时间步的第一个码书,然后是第一个时间步的第二个码书,等等。然后,使用(1)和(2),我们可以在理论上拟合q分布的精确模型。然而,缺点是复杂性增加,部分增益来自最低采样率的损失。

存在不止一种可能的扁平化,并不是所有的函数都需要通过单个模型进行估计。例如,MusicLM [Agostinelli等人,2023]使用两个模型,一个对平坦的前K/2码本进行建模,第二个对其他K/2平坦码本进行建模,以第一个模型的决策为条件。在这种情况下,自回归步数仍然是。

非精确自回归分解。另一种可能是考虑自回归分解,其中一些码本是并行预测的。例如,让我们定义另一个的序列,并且对于所有。当删除码本索引k时,例如,我们指的是时间t时所有码本的拼接

让我们再次递归定义,对于所有的t>0,

与(2)不同的是,一般情况下,我们不再认为与V遵循相同的分布,即使假设我们能够获得确切的分布。事实上,只有当对于所有的与是条件独立的时,我们才会有一个合适的生成模型。随着t的增加,误差将会复合,两个分布可能会进一步分开。这种分解是不精确的,但允许保持原始帧速率,可以大大加快训练和推理,特别是对于长序列。有趣的是,VALL-E语音生成器模型[Wang等人,2023]使用了不精确的自回归分解。它首先顺序预测所有时间步的第一个码本,然后并行预测所有剩余的码本,例如隐式假设它们在所有时间步的第一个码本上是独立的。

任意码本交织模式。为了实验各种这样的分解,并准确测量使用不精确分解的影响,我们引入了码书交织模式。让我们考虑为所有时间步长和码本索引对的集合。码书模式是一个序列,其中,,对于所有,使得P是Ω的分割。我们通过并行预测Pt中的所有位置,有条件地预测。实际上,我们将自己限制在每个码本索引最多在任意Ps中出现一次的模式中。

我们现在可以轻松地定义许多分解,例如,给出的“并行”模式

类似地,受VALL-E [Wang等人,2023]启发的模式可以定义为

也可以在码本之间引入“延迟”,如Kharitonov等人[2022],例如:

通过实验评估,展示了各种码书模式的优缺点。阐明了并行码本序列精确建模的重要性。

2.3、模型调节

文本调节。给定一个与输入音频X匹配的文本描述,我们计算一个条件张量, D是自回归模型中使用的内部维度。通常,有三种主要的方法来表示有条件音频生成的文本。Kreuk等人[2022]提出使用预训练的文本编码器,特别是T5 [Raffel等人,2020]。Chung等人[2022]表明,使用基于指令的语言模型可以提供优越的性能。最后,Agostinelli等人[2023],Liu等人[2023],Huang等人[2023a], Sheffer和Adi[2023]声称,联合的文本-音频表示,如CLAP [Wu*等人,2023],可以提供更好的生成质量。我们分别对上述所有方法进行了实验:T5编码器、FLAN-T5和CLAP。

旋律调节。虽然文本是当今条件生成模型中最突出的方法,但对于音乐来说,更自然的方法是对另一个音轨甚至是口哨或哼唱的旋律结构进行条件反射。这种方法还允许对模型的输出进行迭代优化。为支持这一观点,本文尝试通过对输入的色度图和文本描述进行联合条件反射来控制旋律结构。在初步的实验中,我们观察到,对原始色度图的约束通常会导致重建原始样本,从而导致过拟合。为了减少这一问题,我们通过在每个时间步选择主导时频箱来引入一个信息瓶颈。虽然Agostinelli等人[2023]展示了类似的功能,但作者使用了有监督的专有数据,这是繁琐且昂贵的收集。本文采用无监督方法,消除了对监督数据的需求。

2.4、模型架构

码本投影和位置嵌入。给定一个码本模式,在每个模式步骤Ps中只有一些码本出现。我们从Q中检索与Ps中索引对应的值。如2.2节所述,每个码本在Ps中最多出现一次,否则根本不出现。如果它存在,我们使用一个具有N个条目和维度D的学习到的嵌入表来表示来自q的关联值。否则,我们使用一个特殊的标记来表示它的不存在。我们将变换后每个码本的贡献相加。当P0 =∅时,第一个输入总是所有特殊符号的和。最后,我们对正弦嵌入求和以编码当前步骤s [Vaswani等人,2017]。

变压器解码器。输入被馈送到具有L层和维度d的transformer中,每一层由一个因果自注意力块组成。然后,我们使用一个由条件信号C提供的交叉注意力块。当使用旋律条件作用时,我们提供条件张量C作为transformer输入的前缀。该层以一个完全连接的块结束,由一个从D到4·D通道的线性层、一个ReLU和一个返回D通道的线性层组成。注意力和全连接块被残差跳跃连接包裹。在与残差跳跃连接(“预范数”)相加之前,对每个块进行层归一化[Ba等人,2016]。

分对数预测。transformer解码器在模式步长处的输出被转换为对给出的索引处Q值的logits预测。在中,每个码本最多出现一次。如果存在码本,则通过将码本特定的线性层从D通道应用到N通道来获得logits预测。

3、实验设置

3.1、模型和超参数

音频标记模型。我们对32 kHz单声道音频使用非因果五层EnCodec模型,其步幅为640,导致帧率为50 Hz,初始隐藏大小为64,在模型的五层中每层都增加一倍。嵌入用带有四个量化器的RVQ进行量化,每个量化器的码本大小为2048。我们遵循dsamossez等人[2022],在音频序列中随机裁剪的一秒钟音频片段上训练模型。

变压器模型。我们训练了不同尺寸的自回归变压器模型:300M、1.5B、3.3B参数。我们使用xFormers封装[Lefaudeux等人,2022]中的内存高效Flash注意[Dao等人,2022]来提高长序列的速度和内存使用。我们在第4节中研究了模型大小的影响。我们使用300m参数模型进行所有的消融。我们训练的30秒音频作物随机采样从完整的轨道。我们使用AdamW优化器[Loshchilov and Hutter, 2017]训练模型1M步,批量大小为192个样本,β1 = 0.9, β2 = 0.95,解耦权衰减为0.1,梯度裁剪为1.0。对于300M模型,我们进一步依赖基于d - adaptive的自动步长[Defazio和Mishchenko, 2023],因为它提高了模型的收敛性,但对于更大的模型没有任何收益。我们使用余弦学习率计划,热身4000步。此外,我们使用衰减为0.99的指数移动平均线。我们分别使用32、64和96个gpu,以混合精度训练300M、1.5B和3.3B参数模型。更具体地说,我们使用float16是因为bfloat16会导致设置中的不稳定。最后,对于抽样,我们采用top-k抽样[Fan等人,2018],保持前250个Token,温度为1.0。

文本预处理。Kreuk等人[2022]提出了一种文本规范化方案,该方案省略停止词,剩余文本采用词素化。我们用文本规范化来表示这个方法。在考虑音乐数据集时,通常可以使用额外的注释标签,如音乐键、速度、乐器类型等。我们还尝试将这样的注释连接到文本描述。我们用条件合并来表示这种方法。最后,我们探索了使用单词删除作为另一种文本增强策略。对于最后的模型,我们使用概率为0.25的条件合并。在合并时,我们应用概率为0.5的文本描述dropout。我们对结果文本使用概率为0.3的单词删除。不同文本预处理策略的完整比较可以在附录A.2中找到。

码本模式和条件作用。我们使用2.2节中的“延迟”交错模式,这将30秒的音频转换为1500个自回归步骤。对于文本调节,我们使用T5 [Raffel等人,2020]文本编码器,可选地添加2.3节中介绍的旋律调节。我们还对FLAN-T5 [Chung等人,2022]和CLAP [Wu*等人,2023]进行了实验,并在附录A.2中比较了使用这些文本编码器的MUSICGEN的性能。对于旋律调节,我们计算窗口大小为214和希望大小为212的chromagrams。使用大窗口会阻碍模型恢复精细的时间细节。通过在每个时间步长取argmax进一步量化色度图。我们遵循与Kreuk等人[2022]类似的方法,并在从模型的logits中采样时实现无分类器指导。具体来说,在训练期间,我们以0.2的概率丢弃条件,在推理期间,我们使用3.0的指导量表。

3.2、数据集

训练数据集。我们使用2万小时的授权音乐来训练MUSICGEN。具体来说,我们依赖于一个包含10K个高质量曲目的内部数据集,以及分别包含25K和365K只包含乐器曲目的ShutterStock和Pond5音乐数据集。所有数据集都由以32khz采样的全长音乐组成,其元数据由文本描述和额外信息(如流派、BPM和标签)组成。

评估数据集。对于主要结果和与之前工作的比较,在MusicCaps基准上评估了所提出的方法[Agostinelli等人,2023]。MusicCaps由专家音乐家准备的5.5K样本(10秒长)和跨流派平衡的1K子集组成。本文报告了不平衡集上的客观指标,同时从流派平衡集上采样样本进行定性评估。对于旋律评估和消融研究,使用了来自528首乐曲的域内保留评估集的样本,与训练集没有艺术家重叠。

3.3、评价

基线。将MUSICGEN与文本到音乐生成的两个基线进行比较:Riffusion [Forsgren和Martiros]和Mousai [Schneider等人,2023]。我们使用开源的Riffusion模型进行推理。对于Mousai,我们使用authors4提供的开源实现,使用我们的数据集训练一个模型以进行公平比较。此外,如果可能,我们将MusicLM [Agostinelli等人,2023]和Noise2Music [Huang等人,2023b]进行比较。

评价指标。使用客观和主观指标对所提出的方法进行了评估。对于客观方法,我们使用三个指标:Fréchet音频距离(FAD), Kullback-Leiber散度(KL)和CLAP分数(CLAP)。我们报告了使用Tensorflow中官方实现的VGGish模型的FAD [Kilgour等人,2018]。FAD分数较低表明生成的音频是可信的。继Kreuk等人[2022]之后,我们使用在AudioSet [Koutini等人,2021]上为分类而训练的最先进的音频分类器来计算原始音乐和生成音乐之间标签概率的kl散度。当KL较低时,期望生成的音乐与参考音乐共享相似的概念。最后,使用官方预训练的CLAP模型,计算轨道描述和生成音频之间的CLAP分数[Wu* et al., 2023, Huang et al., 2023a],以量化音频-文本对齐。

对于人体研究,我们遵循与Kreuk等人相同的设置。[2022]。要求人工评分者评估音频样本的两个方面(i)总体质量(OVL)和(ii)与文本输入的相关性(REL)。对于整体质量测试,评价者被要求在1到100的范围内对提供的样本的感知质量进行评分。在文本相关性测试中,评分者被要求在1到100的范围内对音频和文本之间的匹配进行评分。评价者是通过亚马逊土耳其机械平台招募的。我们对随机抽样的文件进行评估,其中每个样本都由至少5名评价者评估。

我们使用CrowdMOS包来过滤噪声注释和异常值。我们删除了没有听完整录音的注释者,对参考录音评分低于85的注释者,以及来自CrowdMOS的其他推荐食谱(Ribeiro等人,2011年)。为公平起见,所有样本均按−14dB LUFS进行归一化[ITU-R, 2017]。

4、结果

首先介绍了所提出方法在文本到音乐生成任务上的结果,并将MUSICGEN与该领域之前的工作进行了比较。评估了所提出方法以旋律特征为条件生成音乐的能力。我们以消融研究作为结论。音乐样本、代码和模型可在github.com/facebookresearch/audiocraft上找到。

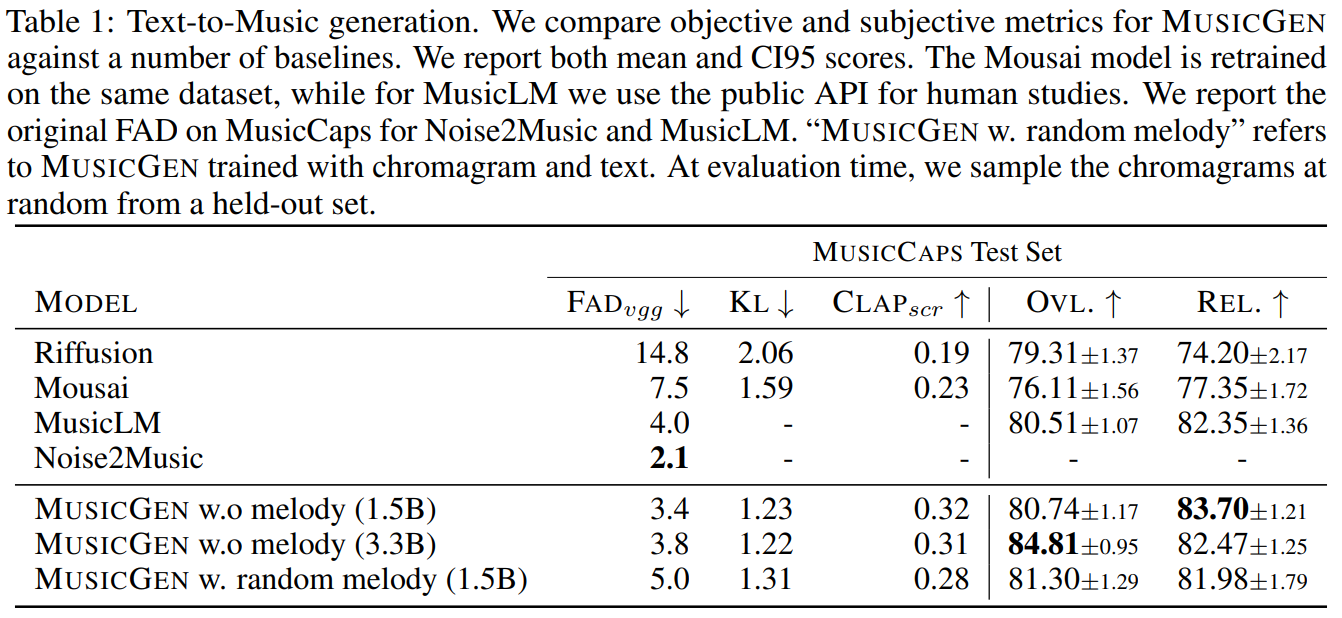

4.1、与基线的比较

表1给出了所提方法与Mousai、Riffusion、MusicLM和Noise2Music的比较。由于没有Noise2Music的官方实现,也没有预训练模型,本文仅报道了在Noise2Music手稿中报道的MusicCaps。类似地,MusicLM的实现也不是公开的。我们使用MusicLM公共demo8进行主观测试,同时报告作者报告的流行趋势。虽然原始的MusicLM模型是在有人声的数据上进行训练的,但API背后的模型只有乐器。对于人类研究,我们将自己限制在40个只有乐器的样本中。为了防止用chromagram训练的MUSICGEN中的泄漏,我们在测试期间从保留集中随机采样chromagram。

结果表明,在音频质量和对提供的文本描述的坚持性方面,MUSICGEN的表现优于人类听众的评估基线。Noise2Music在MusicCaps上的流行度方面表现最好,其次是经过文本条件训练的MUSICGEN。有趣的是,添加旋律条件会降低客观指标,但是,它不会显著影响人类评分,同时仍然优于评估的基线。

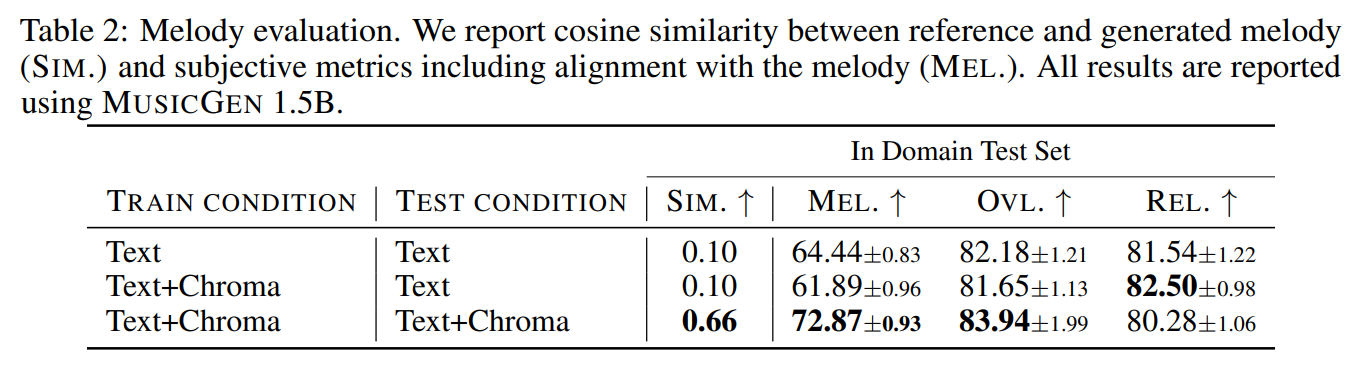

4.2、旋律评价

本文评估了MUSICGEN,联合以文本和旋律表示为条件,在所提出的评估集上使用客观和主观度量。在客观评价方面,引入了一种新的度量指标:色度余弦相似度,从量化的参考图像色度和生成的样本中获取对应于相同时间步长的帧之间的平均余弦相似度。我们使用从保留集中随机抽样的1000个文件进行评估。为了更好地评估条件旋律与生成音乐之间的关系,引入了另一项人工研究。为人类评分者提供了一个参考音乐作品,然后是一组生成的作品。对于每个生成的样本,听众被要求在1到100的范围内评价生成的片段的旋律与参考的匹配程度。我们从保留集中随机抽取40个10秒的样本。结果见表2。结果表明,用chromagram条件反射训练的MUSICGEN成功地生成了遵循给定旋律的音乐。因此,可以更好地控制生成的输出。有趣的是,MUSICGEN在使用两个OVL进行推理时都可以鲁棒地删除色度。而rel,基本保持不变。

4.3、消融

本节提供了不同码本模式的消融研究,以及模型尺度的结果。附录A.2给出了不同的文本增强策略和文本编码器的结果。所有消融都使用1K个30秒的样本,从保留的评估集中随机抽样。

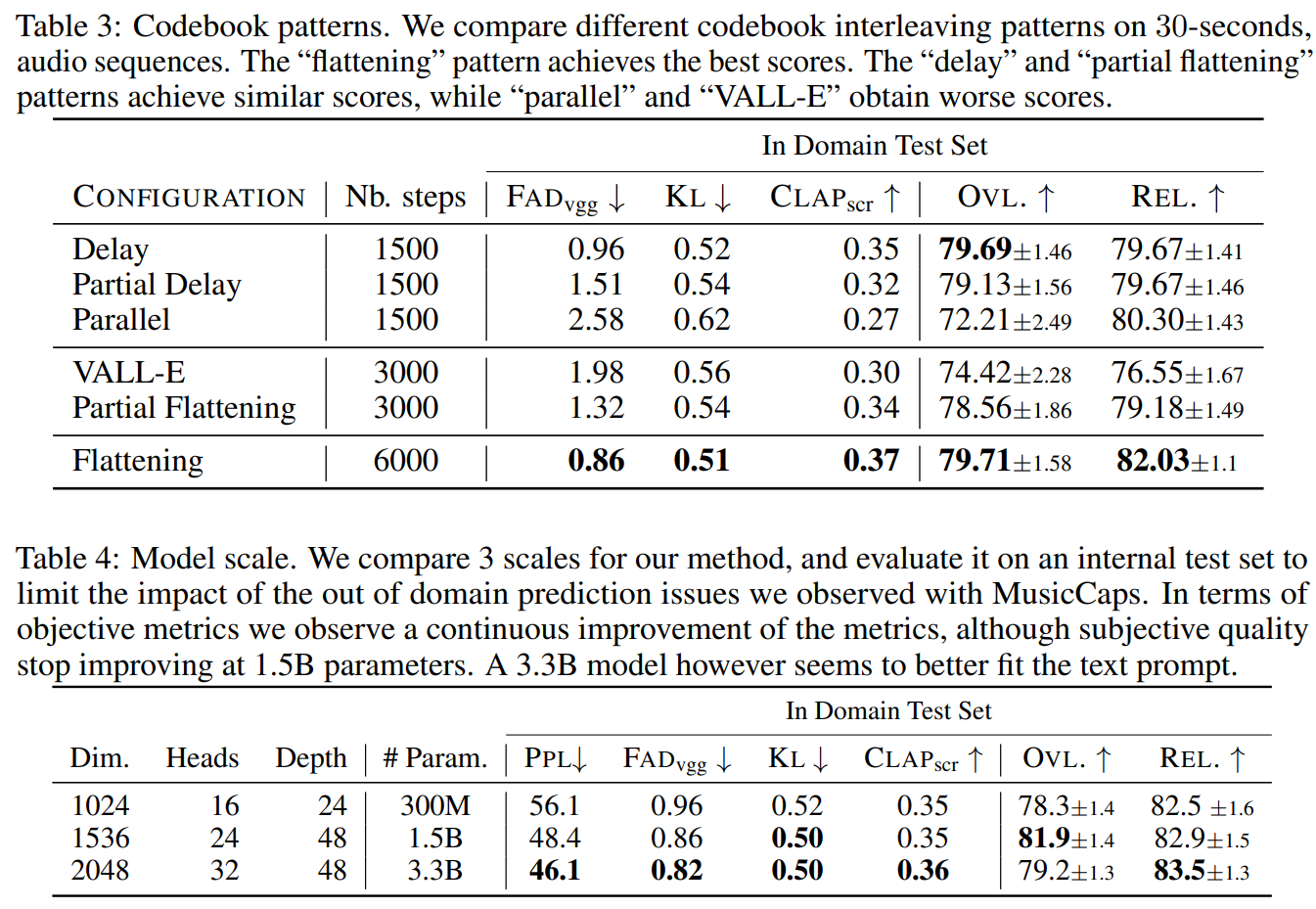

码书交织模式的影响。使用2.2节中的框架评估了各种码本模式,K = 4,由音频标记化模型给出。表1报告了“delay”模式的结果。“部分延迟”是指码本2、3和4的延迟时间相同。“并行”模式并行地预测同一时间步长的所有码本。“VALL-E”模式的灵感来自Wang等人[2023]的工作。它首先预测所有步骤的码书1,然后并行预测码书2、3和4。因此,该模式的步骤是其他模式的两倍。“部分扁平化”与之类似,但它不是对所有步骤先采样码本1,而是将它们与码本2、3和4的并行采样交错进行。最后,“扁平化”模式包括扁平化所有码本,类似于MusicLM [Agostinelli等人,2023]。我们在表3中报告了客观和主观评价。虽然扁平化改善了生成,但它的计算成本很高,而使用简单的延迟方法,可以用该成本的一小部分达到类似的性能。

模型大小的影响。在表4中,我们报告了不同模型大小的结果,即300M、1.5B和3.3B参数模型。正如预期的那样,扩大模型大小可以得到更好的分数,但这是以更长的训练和推理时间为代价的。主观评价方面,在1.5B时整体质量是最优的,但更大的模型可以更好地理解文本提示。

5、相关工作

本文提出一种音乐语言模型。该方法与音频神经表示和建模的最新进展有关。下面,我们回顾这些领域的最新工作。

音频表示。近年来,主要的方法是将音乐信号以压缩的形式表示,无论是离散的还是连续的,并在其基础上应用生成模型。Lakhotia等人[2021]提出使用k-means对语音表示进行量化以构建语音语言模型。最近,Défossez等人[2022],Zeghidour等人[2021]提出使用残差矢量量化将VQ-VAE直接应用于原始波形。后来,一些研究将这种表示用于文本到音频的生成。然后,讨论了音频生成的最新研究进展。

音乐生成。长期以来,人们一直在各种环境下研究音乐生成。Dong等人[2018]提出了一种基于gan的符号音乐生成方法。Bassan等人[2022]提出了一种符号音乐的无监督分割方法,可以稍后用于生成。Ycart等人[2017]提出了使用递归神经网络对复调音乐建模。Ji等[2020]对音乐生成的深度学习方法进行了全面调查。

Dhariwal等人[2020]提出使用分层VQ-VAE在多个离散表示流中表示音乐样本。接下来,在序列上应用两个稀疏变换来生成音乐。Gan等人[2020]提出为给定视频生成音乐,同时预测其midi音符。最近,Agostinelli等人[2023]提出使用“语义标记”和“声学标记”的多个流来表示音乐。然后,他们应用了以文本-音乐联合表示为条件的级联变压器解码器[Huang et al., 2022]。Donahue等人[2023]采用了类似的建模方法,但针对的是歌唱到伴奏生成的任务。

另一种方法是使用扩散模型,它自然适用于连续表示。Schneider等人[2023],Huang等人[2023b], Maina [2023], Forsgren和Martiros提出了文本到音乐任务的潜在扩散模型。Schneider等人[2023]提出将扩散模型用于音频编码器-解码器和潜在生成。Huang等人[2023b]提出了一种级联扩散模型来生成音频,并逐渐提高其采样率。Forsgren和Martiros提出了微调稳定扩散Rombach等[2022],使用谱图生成5秒的片段,然后使用图像到图像映射和潜在插值生成长序列。

音频生成。提出了几项关于文本到音频(环境声音)生成的研究。Yang等人[2022]提出使用VQ-VAE表示音频频谱图,然后在生成部分应用基于文本CLIP嵌入的离散扩散模型[Radford等人,2021]。Kreuk等人[2022]提出在离散音频表示上应用变压器语言模型,该模型是通过使用EnCodec直接量化时域信号获得的[dsamossez等人,2022]。Sheffer和Adi[2023]采用了与Kreuk等人[2022]类似的方法进行图像到音频的生成。Huang等人[2023a], Liu等人[2023]提出将潜在扩散模型用于文本到音频的任务,同时将其扩展到各种其他任务,如绘画、图像到音频等。

6、讨论

本文提出了MUSICGEN,一种最先进的单阶段可控音乐生成模型,可以以文本和旋律为条件。证明了简单的码本交织策略可以用来实现高质量的生成,同时与扁平化方法相比,减少了自回归时间步长的数量。对模型大小、条件调节方法和文本预处理技术的影响进行了全面的研究。我们还介绍了一个简单的基于色度图的条件,以控制生成的音频的旋律。

限制。我们简单的生成方法不允许我们对生成对条件的坚持进行细粒度的控制,我们主要依赖于CF指导。此外,虽然对文本条件进行数据增强是相对直接的,但对音频进行条件增强可以促进对数据增强、指导类型和数量的进一步研究。

道德方面。大规模生成模型提出了伦理挑战。我们首先确保我们训练的所有数据都包含在与权利持有人的法律协议中,特别是通过与ShutterStock的协议。第二个方面是我们使用的数据集可能缺乏多样性,其中包含了更大比例的西方风格音乐。然而,相信本文工作中的简化,例如使用单阶段语言模型和减少自回归步骤,可以帮助扩大对新数据集的应用。

生成模型对艺术家来说可能是一种不公平的竞争,这是一个开放问题。开放研究可以确保所有参与者平等地获得这些模型。通过开发更先进的控制,如我们引入的旋律条件反射,我们希望这样的模型可以对音乐业余爱好者和专业人士都有用。

- 点赞

- 收藏

- 关注作者

评论(0)