Elastic实战:logstash将kafka数据同步到es时,如何将字符串型时间字段转换为时间戳

【摘要】 今天群里有同学问如何将字符串型的时间字段转换为long类型的时间戳。特记录下供后续参考。

原问题:> 我接收数据方传过来的数据,其中有个时间类型是字符串类型,格式为:yyyy-MM-dd hh:mm:ss,我需要转成时间戳保存,我按照网上的方法试了好多种都无法成功转换。

> 数据方把数据发到kafka,我用logstash读kafka,经过处理存到es

0. 引言

今天群里有同学问如何将字符串型的时间字段转换为long类型的时间戳。特记录下供后续参考。

原问题:

我接收数据方传过来的数据,其中有个时间类型是字符串类型,格式为:yyyy-MM-dd hh:mm:ss,我需要转成时间戳保存,我按照网上的方法试了好多种都无法成功转换。

数据方把数据发到kafka,我用logstash读kafka,经过处理存到es

1. 思路

看到这个问题,首先的反应过来的是这是一个数据入库前的处理需求,所以很明显我们可以借助es的pipeline来解决这个问题。

但核心的问题在于字符串转时间,然后获取时间的时间戳,pipeline默认是使用painless语法的,那就要去painless官方文档看看时间转换的方法了。

2. 解决

1、因为painless是类java语法的,所以我的第一反应是看看这个需求用java如何书写

java实现如下

SimpleDateFormat sdf = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

long timestamp = sdf.parse("2021-01-11 00:00:00").getTime();

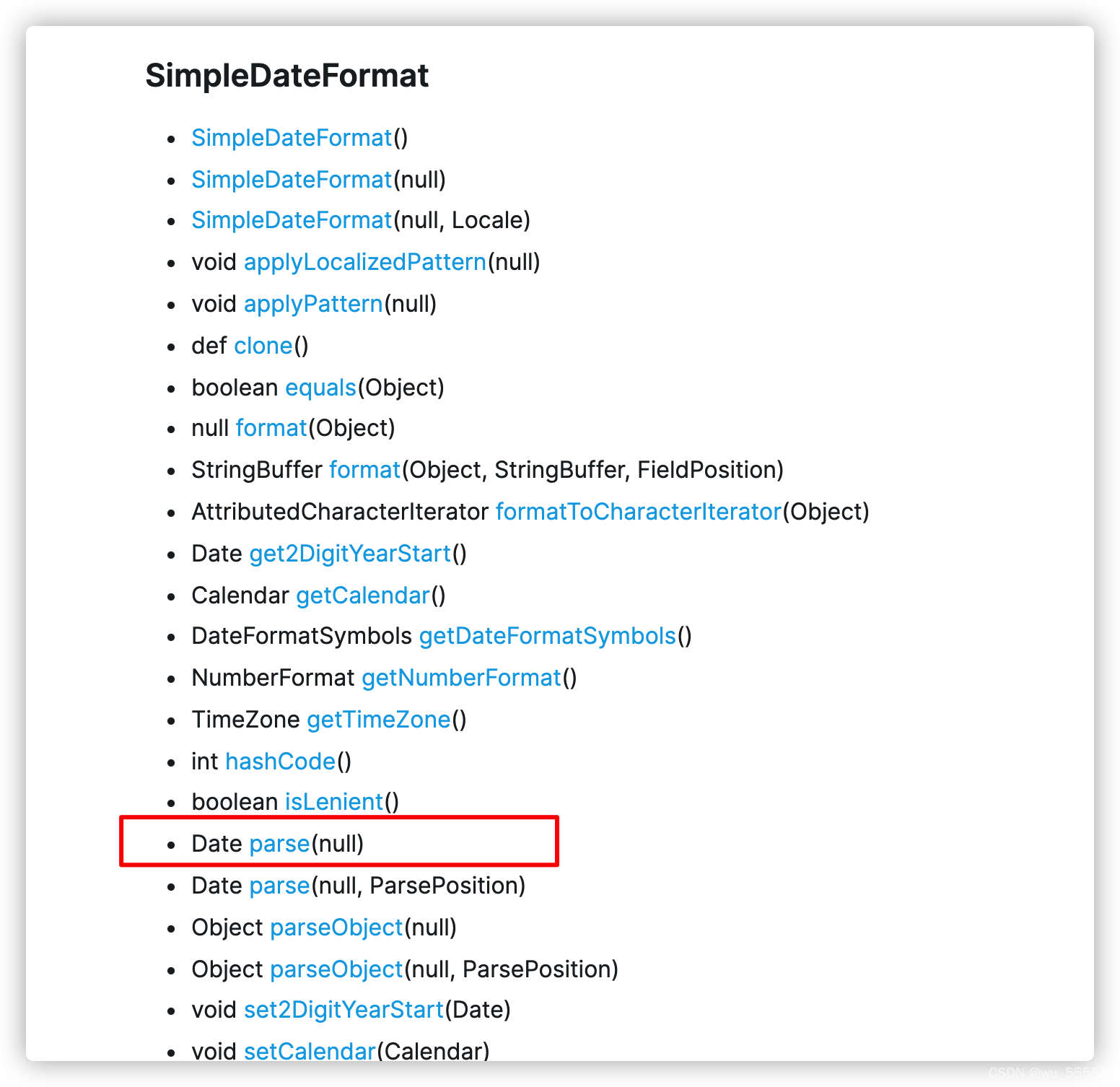

2、下面到painless官方文档中找找是否有SimpleDateFormat类

直接在share-api页面查找SimpleDateFormat

发现是有这个类的,并且也有parse方法

SimpleDateFormat

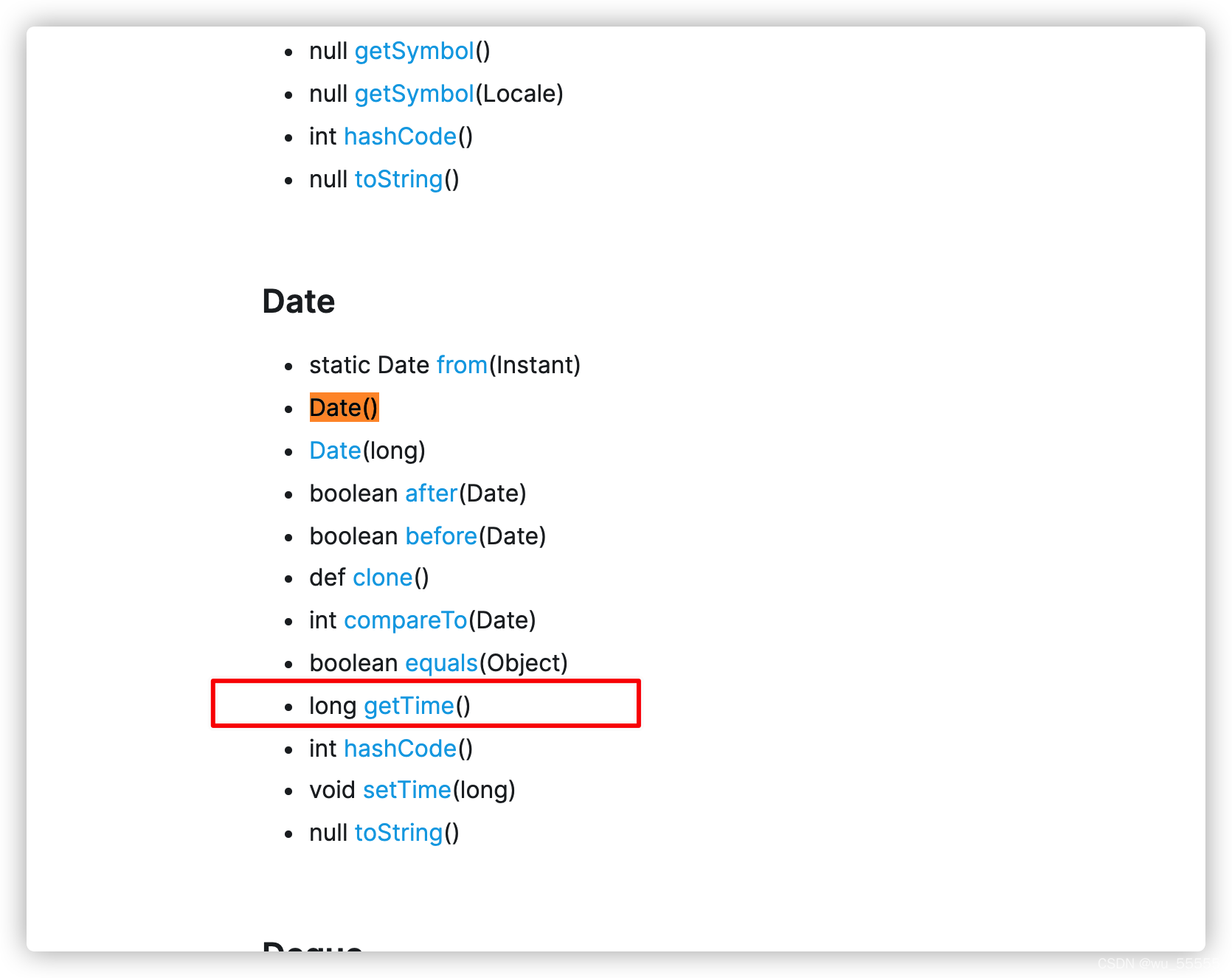

3、同时再看看Date类,很容易也找到了getTime方法

Date

4、于是我们就可以书写pipeline了

PUT _ingest/pipeline/string_to_datelong

{

"description": "",

"processors": [

{

"script": {

"lang": "painless",

"source": """

SimpleDateFormat sdf = new SimpleDateFormat('yyyy-MM-dd HH:mm:ss');

ctx.date_long = sdf.parse(ctx.date).getTime();

"""

}

}

]

}

5、在索引中引用pipeline

PUT date_index

{

"mappings": {

"properties": {

"date": {

"type": "keyword"

},

"date_long": {

"type": "long"

}

}

},

"settings": {

"default_pipeline": "string_to_datelong"

}

}

6、插入一条数据,看看效果

PUT date_index/_doc/1

{

"date": "2021-01-01 00:00:00"

}

7、可以看到成功转换为时间戳,问题解决

GET date_index/_search

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)