面向动态用户行为的 Agent 化推荐系统建模方法

构建一个基于 Agent 的智能推荐系统架构—多 Agent 协作视角下的推荐系统设计与实现

引言

传统推荐系统大多采用集中式流水线架构:数据收集 → 特征工程 → 模型推理 → 结果输出。这种方式在静态场景下表现良好,但在以下场景中逐渐暴露瓶颈:

- 用户兴趣高度动态变化

- 推荐目标多样(点击率、转化率、满意度)

- 需要实时交互与策略调整

- 推荐逻辑复杂、规则与模型并存

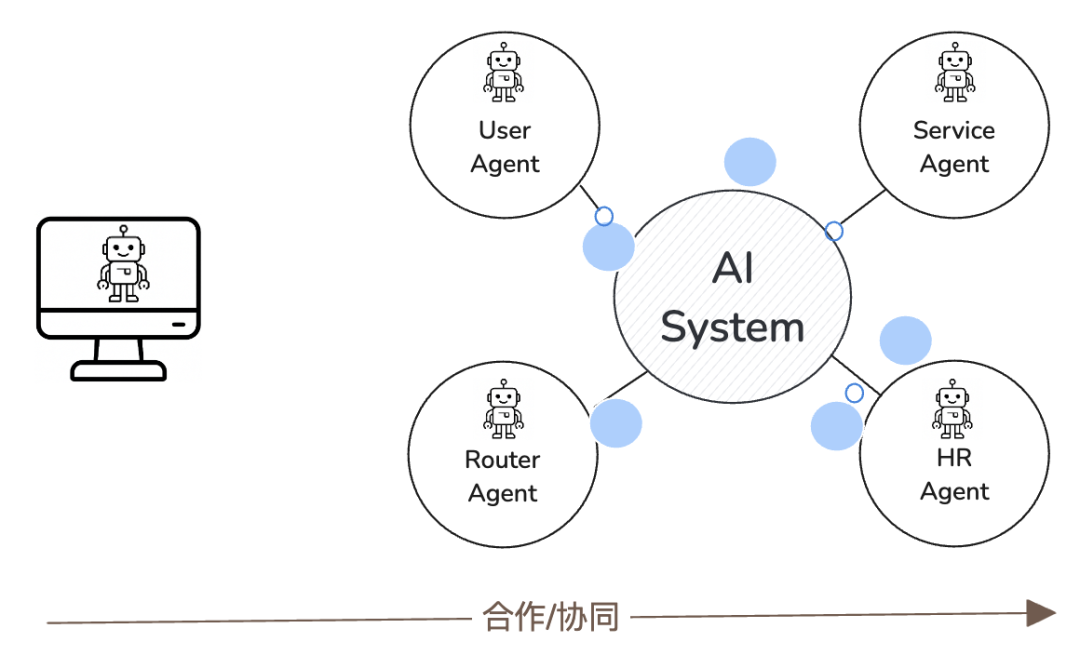

为此,越来越多的系统开始引入 Agent(智能体)思想,将推荐系统拆解为多个具备自治能力、各司其职的 Agent,通过协作完成复杂推荐决策。

本文将设计一个基于 Agent 的智能推荐系统架构,并说明各 Agent 模块的功能与协作方式。

一、Agent 化推荐系统整体架构

在 Agent 视角下,推荐系统不再是“一个模型”,而是一个多 Agent 协作系统。

核心 Agent 划分

一个典型的 Agent 推荐系统可以拆分为以下模块:

- 用户感知 Agent(User Profiling Agent)

- 内容理解 Agent(Item Understanding Agent)

- 策略决策 Agent(Decision Agent)

- 排序执行 Agent(Ranking Agent)

- 反馈学习 Agent(Feedback Agent)

整体协作关系如下:

用户行为

↓

用户感知 Agent

↓

策略决策 Agent ← 内容理解 Agent

↓

排序执行 Agent

↓

推荐结果

↓

反馈学习 Agent → 反向优化各 Agent

二、用户感知 Agent(User Profiling Agent)

职责

- 收集用户行为(点击、浏览、停留)

- 构建与更新用户兴趣画像

- 输出结构化用户状态给其他 Agent

示例实现

class UserProfilingAgent:

def __init__(self):

self.user_profile = {}

def update_profile(self, user_id, behavior):

if user_id not in self.user_profile:

self.user_profile[user_id] = {"interest": {}}

for tag in behavior:

self.user_profile[user_id]["interest"][tag] = \

self.user_profile[user_id]["interest"].get(tag, 0) + 1

def get_profile(self, user_id):

return self.user_profile.get(user_id, {})

该 Agent 持续维护用户兴趣分布,为后续决策提供“状态输入”。

三、内容理解 Agent(Item Understanding Agent)

职责

- 解析内容属性(标签、类别、热度)

- 提供内容的语义或特征表示

- 为策略 Agent 提供候选内容信息

示例实现

class ItemUnderstandingAgent:

def __init__(self, items):

self.items = items

def get_candidate_items(self):

return self.items

在真实系统中,该 Agent 可接入 NLP、CV 模型,生成 embedding 或语义标签。

四、策略决策 Agent(Decision Agent)

职责

- 综合用户画像与内容特征

- 决定推荐目标(探索 / 利用、个性化 / 热门)

- 输出推荐策略或候选集合

示例实现

class DecisionAgent:

def decide(self, user_profile, items):

interests = user_profile.get("interest", {})

scored_items = []

for item in items:

score = sum(interests.get(tag, 0) for tag in item["tags"])

scored_items.append((item, score))

return scored_items

该 Agent 相当于推荐系统的大脑,可由规则、强化学习或 LLM 驱动。

五、排序执行 Agent(Ranking Agent)

职责

- 根据策略 Agent 输出结果进行排序

- 控制多样性、新颖性等约束

- 生成最终推荐列表

示例实现

class RankingAgent:

def rank(self, scored_items, top_k=3):

ranked = sorted(scored_items, key=lambda x: x[1], reverse=True)

return [item for item, _ in ranked[:top_k]]

该 Agent 关注的是执行层逻辑,强调效率与可控性。

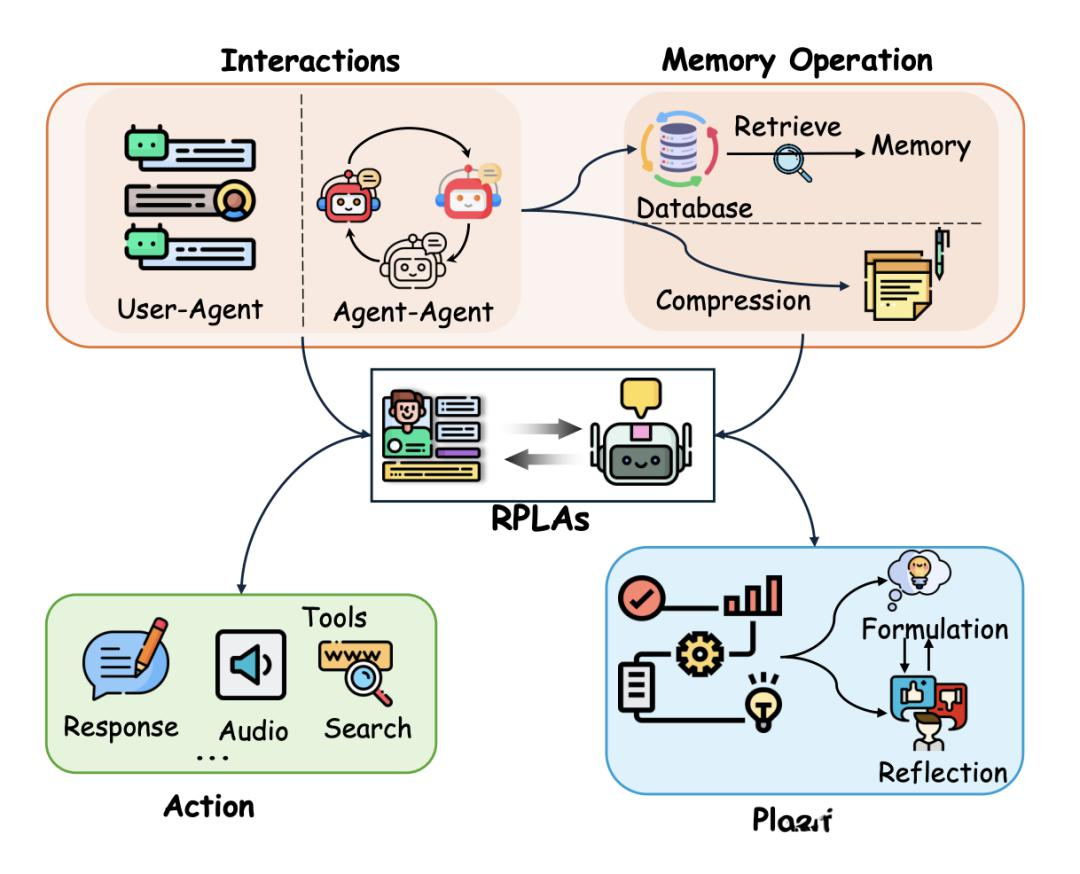

六、反馈学习 Agent(Feedback Agent)

职责

- 采集用户对推荐结果的反馈

- 更新用户画像或策略参数

- 驱动系统自我优化

示例实现

class FeedbackAgent:

def collect_feedback(self, clicked_items):

return clicked_items

在工程实践中,该 Agent 常与在线学习、A/B 实验系统协同。

七、多 Agent 协作的完整推荐流程

将所有 Agent 串联,形成完整推荐闭环:

# 初始化 Agent

user_agent = UserProfilingAgent()

item_agent = ItemUnderstandingAgent([

{"id": 1, "tags": ["AI", "Tech"]},

{"id": 2, "tags": ["Finance"]},

{"id": 3, "tags": ["AI", "ML"]}

])

decision_agent = DecisionAgent()

ranking_agent = RankingAgent()

feedback_agent = FeedbackAgent()

# 用户行为

user_id = "user_001"

user_agent.update_profile(user_id, ["AI", "ML", "AI"])

# 推荐流程

profile = user_agent.get_profile(user_id)

items = item_agent.get_candidate_items()

scored_items = decision_agent.decide(profile, items)

recommendations = ranking_agent.rank(scored_items)

print("推荐结果:", recommendations)

八、为什么 Agent 架构适合推荐系统?

相比传统架构的优势

| 维度 | 传统推荐系统 | Agent 推荐系统 |

|---|---|---|

| 架构 | 集中式 | 模块自治 |

| 可扩展性 | 较弱 | 强 |

| 策略表达 | 固化 | 灵活 |

| 自适应能力 | 依赖离线训练 | 支持在线演化 |

Agent 架构特别适合:

- 实时推荐

- 多目标优化

- LLM + 推荐系统融合

- 复杂业务规则场景

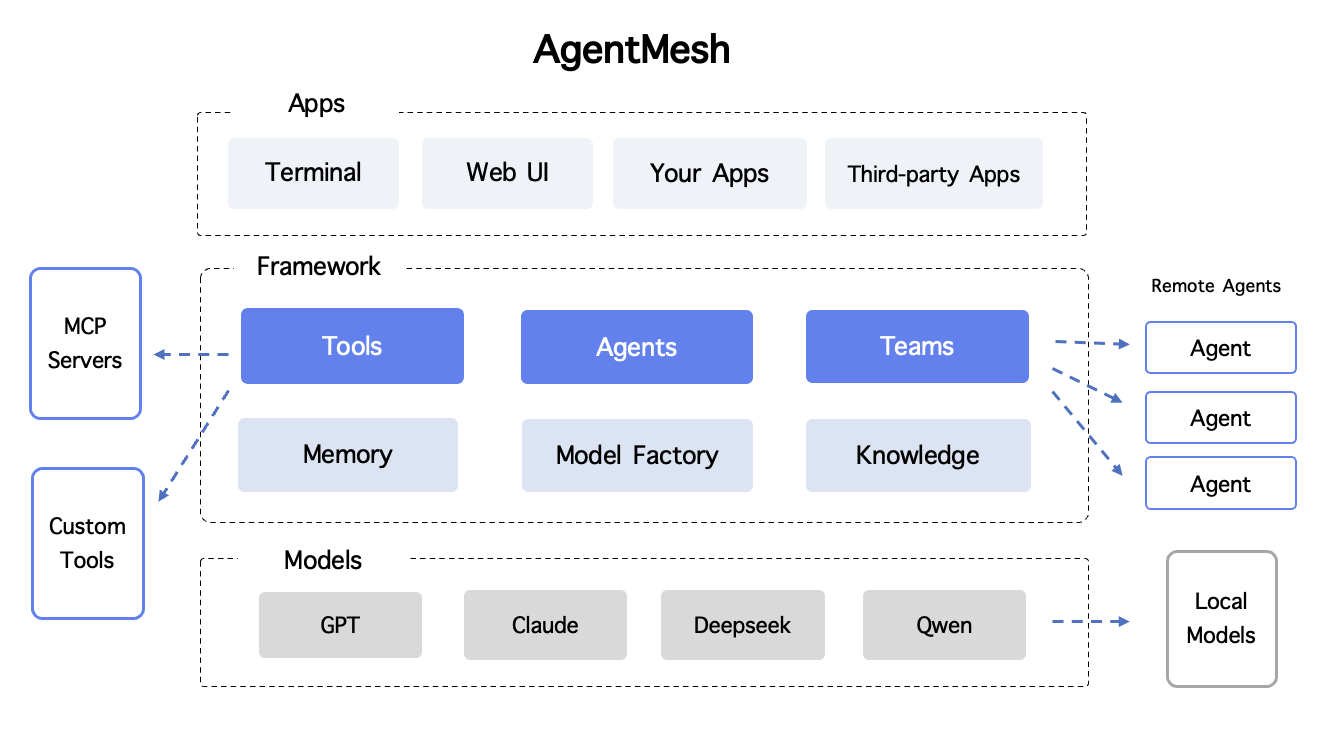

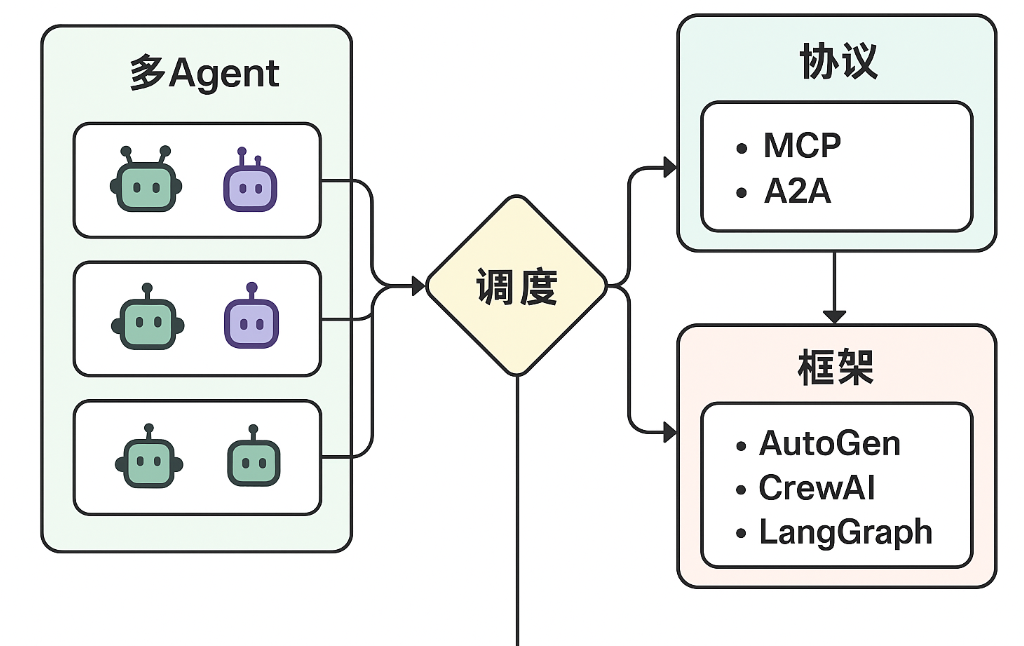

九、可扩展方向

-

引入强化学习 Agent

将 Decision Agent 升级为 RL Agent,实现长期收益优化。 -

引入 LLM 作为策略 Agent

用大模型进行推荐理由生成与策略规划。 -

多 Agent 博弈与协商

不同目标 Agent(平台收益 vs 用户体验)进行博弈决策。

总结

基于 Agent 的智能推荐系统,将传统“模型驱动”的推荐逻辑升级为“多智能体协作决策系统”。通过用户感知、内容理解、策略决策、排序执行与反馈学习等 Agent 的解耦协作,系统在灵活性、可扩展性与智能程度上都具备显著优势。

这种架构不仅适用于推荐系统,也为构建更高级的自主决策智能系统提供了通用范式。

基于 Agent 的智能推荐系统通过将推荐流程拆解为多个具备自治能力的智能体,实现了用户感知、内容理解、策略决策、排序执行与反馈学习之间的高效协作。各 Agent 各司其职、相互解耦,使推荐系统能够更灵活地应对用户兴趣变化和多目标优化需求。相比传统集中式推荐架构,Agent 化设计在可扩展性、自适应能力和系统演进方面具有明显优势,为构建面向复杂业务场景的下一代智能推荐系统提供了可靠的工程范式。

- 点赞

- 收藏

- 关注作者

评论(0)