面向课堂与自习场景的智能坐姿识别系统——从行为感知到可视化部署的完整工程【YOLOv8】

面向课堂与自习场景的智能坐姿识别系统——从行为感知到可视化部署的完整工程【YOLOv8】

一、研究背景:为什么要做“坐姿识别”?

在信息化学习与办公环境中,久坐与不良坐姿已成为青少年与上班族普遍面临的健康问题。长期驼背、前倾、低头等坐姿行为,容易引发:

- 脊柱侧弯、颈椎病

- 注意力下降、学习效率降低

- 视觉疲劳与肌肉劳损

传统的坐姿管理主要依赖人工监督或简单硬件传感器,不仅成本高、实时性差,而且难以规模化推广。

随着计算机视觉与深度学习技术的发展,基于摄像头的坐姿自动识别系统逐渐成为一种可行且低成本的解决方案。

本文将介绍一个 基于 YOLOv8 的智能坐姿检测系统,实现对 标准坐姿 / 不良坐姿(驼背) 的自动识别,并通过 PyQt5 构建完整图形化应用,实现从模型训练到终端部署的完整闭环。

源码下载与效果演示

哔哩哔哩视频下方观看:

https://www.bilibili.com/video/BV1R578zKE3o

包含:

📦完整项目源码

📦 预训练模型权重

🗂️ 数据集地址(含标注脚本)

二、系统总体设计与技术路线

2.1 系统设计目标

本系统的核心设计目标包括:

- 🎯 实时识别学生或用户坐姿状态

- 🎯 支持图片、视频、摄像头等多输入源

- 🎯 检测结果可视化、可保存

- 🎯 非算法人员也可直接使用

2.2 技术架构概览

系统整体采用“检测模型 + 图形界面 + 推理引擎”的三层结构:

输入端(图片 / 视频 / 摄像头)

↓

YOLOv8 坐姿检测模型(2 类)

↓

姿态判定结果(good / bad)

↓

PyQt5 GUI 实时展示与结果保存

三、核心功能模块说明

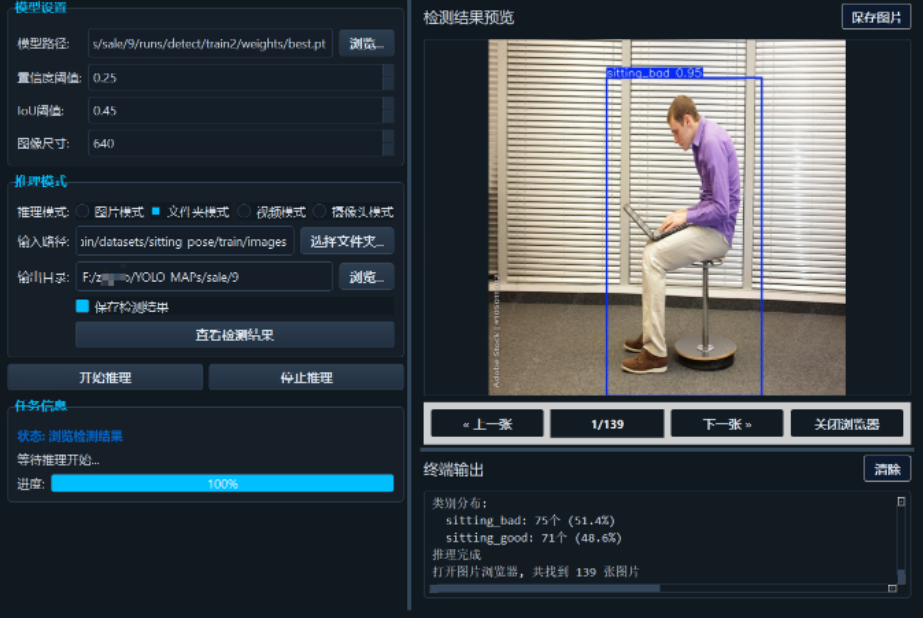

3.1 多模式坐姿检测

系统支持以下几种使用方式:

| 功能模式 | 说明 |

|---|---|

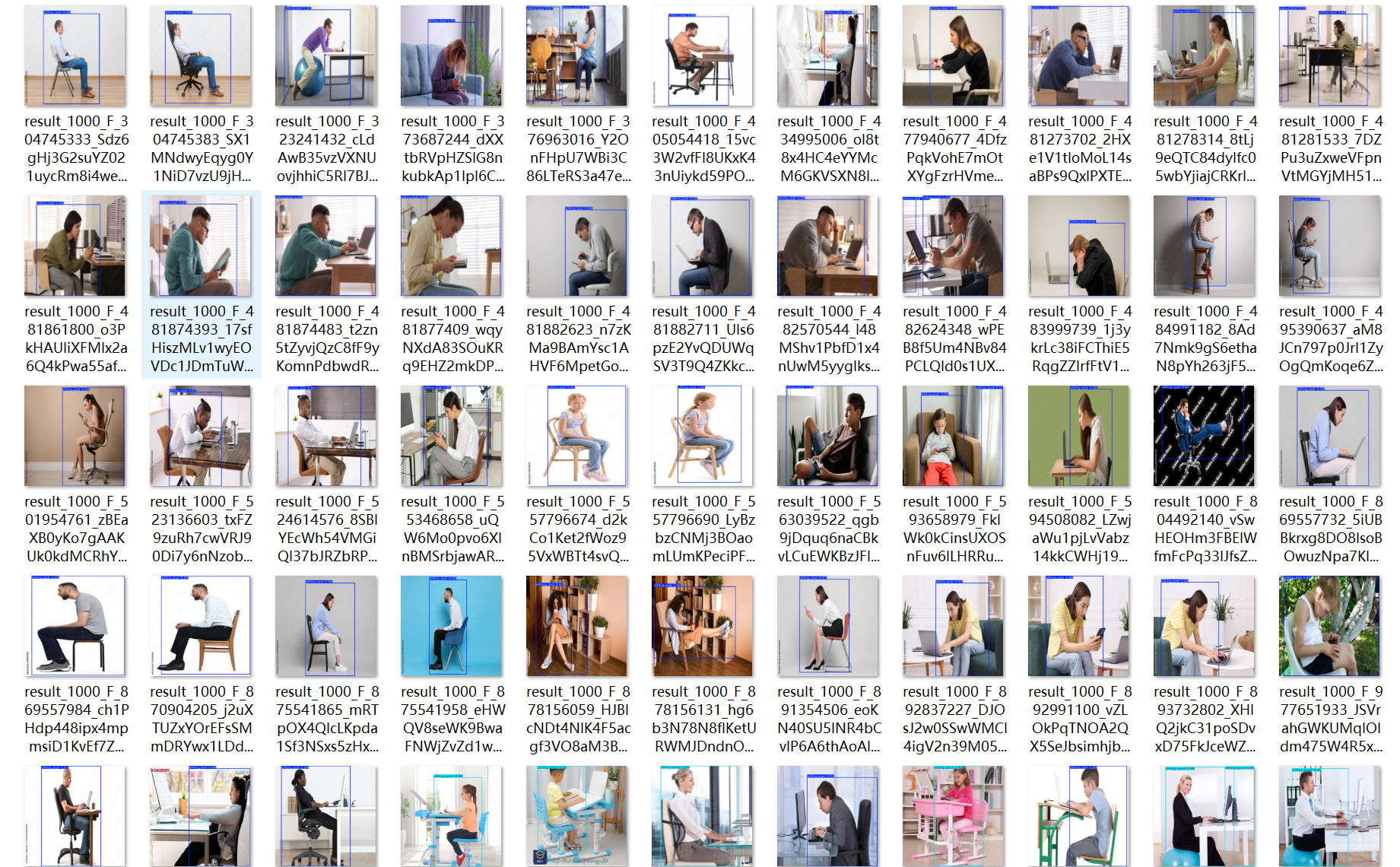

| 单图检测 | 适合样本分析与测试 |

| 文件夹检测 | 批量评估坐姿数据 |

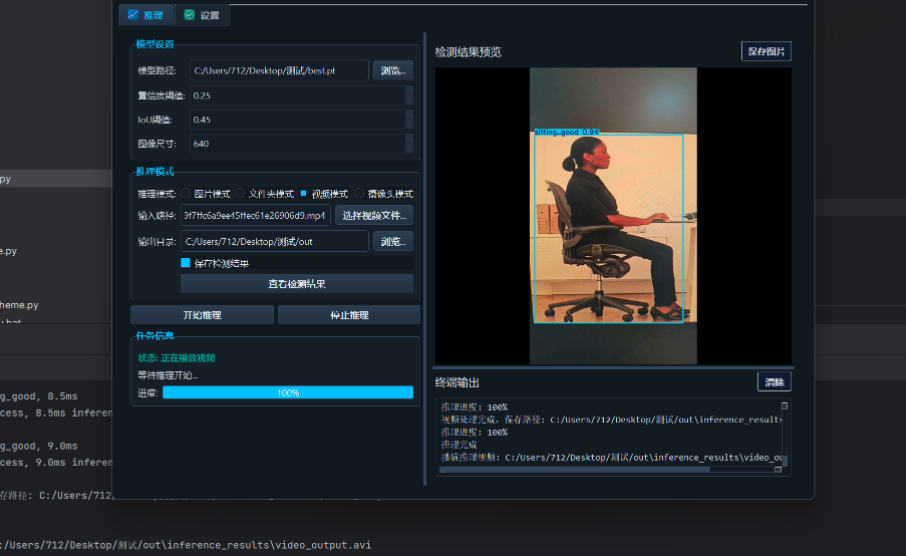

| 视频分析 | 行为回放与统计 |

| 摄像头实时检测 | 实时提醒与监控 |

|

|

|

3.2 坐姿类别定义

当前系统聚焦于最具实用价值的两类坐姿状态:

sitting_good:标准坐姿sitting_bad:不良坐姿(驼背 / 前倾)

该设计有利于提升模型稳定性,并便于后续扩展更多姿态类型。

四、YOLOv8 在坐姿检测中的应用优势

4.1 为什么选择 YOLOv8?

YOLOv8 是 Ultralytics 推出的新一代目标检测模型,在本项目中主要优势体现在:

- 🚀 推理速度快,适合实时摄像头场景

- 🎯 Anchor-Free 架构,对姿态变化更鲁棒

- 🧠 训练与部署流程高度工程化

- 🔌 原生支持 ONNX / TensorRT 导出

4.2 坐姿检测的建模思路

与传统“关键点姿态估计”不同,本项目采用:

基于目标检测的坐姿状态判定

即:

通过检测人体上半身整体姿态区域,直接输出“坐姿类别”,在实时性与工程复杂度之间取得良好平衡。

五、数据集构建与标注规范

5.1 数据来源与特点

训练数据主要来源于:

- 教室与居家学习场景

- 不同光照与拍摄角度

- 多种身高、坐姿习惯

确保模型在真实环境中的泛化能力。

5.2 数据集组织结构

采用 YOLO 标准数据格式:

dataset/

├── images/

│ ├── train/

│ └── val/

├── labels/

│ ├── train/

│ └── val/

标签格式示例:

0 0.51 0.36 0.39 0.32

类别定义:

nc: 2

names: ['sitting_bad', 'sitting_good']

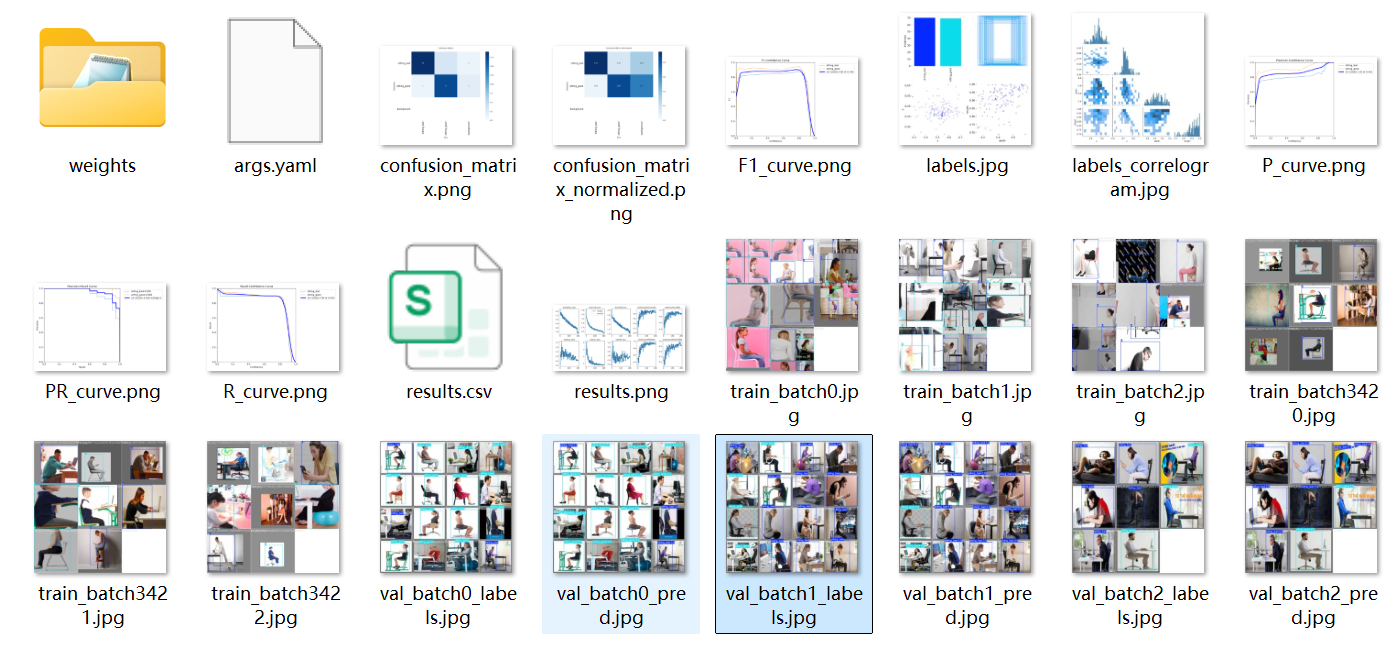

六、模型训练与性能评估

6.1 训练流程

模型训练基于 Ultralytics YOLOv8 官方接口,核心命令如下:

yolo detect train \

model=yolov8n.pt \

data=data.yaml \

epochs=100 \

batch=16

6.2 训练指标分析

训练过程中重点关注:

box_loss:人体区域定位能力cls_loss:坐姿类别区分能力mAP@0.5:整体检测性能

当验证集 mAP@0.5 超过 90%,模型即可用于实际部署。

七、模型推理与结果展示

7.1 推理代码示例

from ultralytics import YOLO

model = YOLO("best.pt")

results = model("test.jpg", conf=0.25, save=True)

7.2 输出结果说明

推理结果包含:

- 坐姿类别(good / bad)

- 置信度评分

- 边界框位置

- 自动保存的标注图像

八、PyQt5 图形界面实现

8.1 GUI 设计理念

图形界面遵循以下原则:

- 🖱️ 零命令行操作

- 👨🏫 面向教育与日常用户

- ⚡ 实时刷新、低延迟

- 💾 支持结果留存与复查

8.2 实时检测流程

摄像头检测流程如下:

- 获取视频帧

- YOLOv8 推理

- 绘制检测框

- 实时显示与存储

系统运行稳定,适合长时间使用。

九、应用场景与拓展方向

9.1 典型应用场景

- 📚 智能教室坐姿管理

- 🧑💻 办公久坐健康监测

- 🏫 校园行为规范系统

- 🧪 行为识别相关科研实验

9.2 可扩展方向

- 增加低头、侧身等细分类别

- 融合关键点姿态估计模型

- 接入声音或消息提醒机制

- 部署至边缘设备(Jetson / RK)

十、总结

本文介绍了一个 基于 YOLOv8 的智能坐姿识别系统,从数据集构建、模型训练到 PyQt5 图形化部署,完整展示了一个计算机视觉项目的工程化落地过程。

该系统具备以下特点:

- ✅ 结构清晰、易复现

- ✅ 实时性强、部署成本低

- ✅ 适合教学、科研与实际应用

- ✅ 支持二次开发与功能扩展

在“智慧校园”“健康办公”等应用背景下,此类基于视觉的行为识别系统具有广阔的落地空间和实践价值。

- 点赞

- 收藏

- 关注作者

评论(0)