从云中心到边缘:AI Agent 网络通信架构的演进与实践

【摘要】 AI Agent 的网络通信优化:5G 与边缘计算结合的低延迟传输方案 一、背景:为什么 AI Agent 需要“更快的网络”随着 AI Agent(智能体) 从“单机推理”逐步演进到“多 Agent 协同 + 实时决策”,网络通信逐渐成为系统性能的关键瓶颈。在以下典型场景中,通信延迟直接决定了智能体的可用性:自动驾驶多车协同决策工业互联网中的实时设备调度 Agent智慧城市中的视频分析与...

AI Agent 的网络通信优化:5G 与边缘计算结合的低延迟传输方案

一、背景:为什么 AI Agent 需要“更快的网络”

随着 AI Agent(智能体) 从“单机推理”逐步演进到“多 Agent 协同 + 实时决策”,网络通信逐渐成为系统性能的关键瓶颈。

在以下典型场景中,通信延迟直接决定了智能体的可用性:

- 自动驾驶多车协同决策

- 工业互联网中的实时设备调度 Agent

- 智慧城市中的视频分析与事件响应

- 分布式强化学习(Multi-Agent RL)

- 大模型驱动的实时交互型 Agent(语音 / 视觉)

传统的 云中心化架构 往往存在以下问题:

- ❌ 网络往返延迟高(RTT 50~200ms)

- ❌ 带宽拥塞,推理请求排队

- ❌ 实时性要求无法满足

为此,5G + 边缘计算(Edge Computing) 成为 AI Agent 网络通信优化的核心技术组合。

二、5G + 边缘计算:低延迟通信的技术基础

1️⃣ 5G 的关键能力

5G 并不仅仅是“更快的 4G”,而是为 实时智能系统 量身打造:

| 能力 | 对 AI Agent 的意义 |

|---|---|

| uRLLC(超可靠低时延) | 端到端延迟可低至 1~10ms |

| 网络切片 | 为 Agent 通信分配专属通道 |

| 高并发连接 | 支撑大规模 Agent 同时在线 |

2️⃣ 边缘计算(Edge Computing)

边缘计算的核心思想是:

让 AI 推理与决策,尽可能靠近数据源发生

相比传统云计算:

| 架构 | 推理位置 | 延迟 |

|---|---|---|

| 云中心 | 远程数据中心 | 高 |

| 边缘计算 | 基站 / 局域节点 | 极低 |

对于 AI Agent 而言:

- 传感器数据 → 边缘节点推理

- 多 Agent 协商 → 边缘内通信

- 云端 → 负责模型训练与全局策略

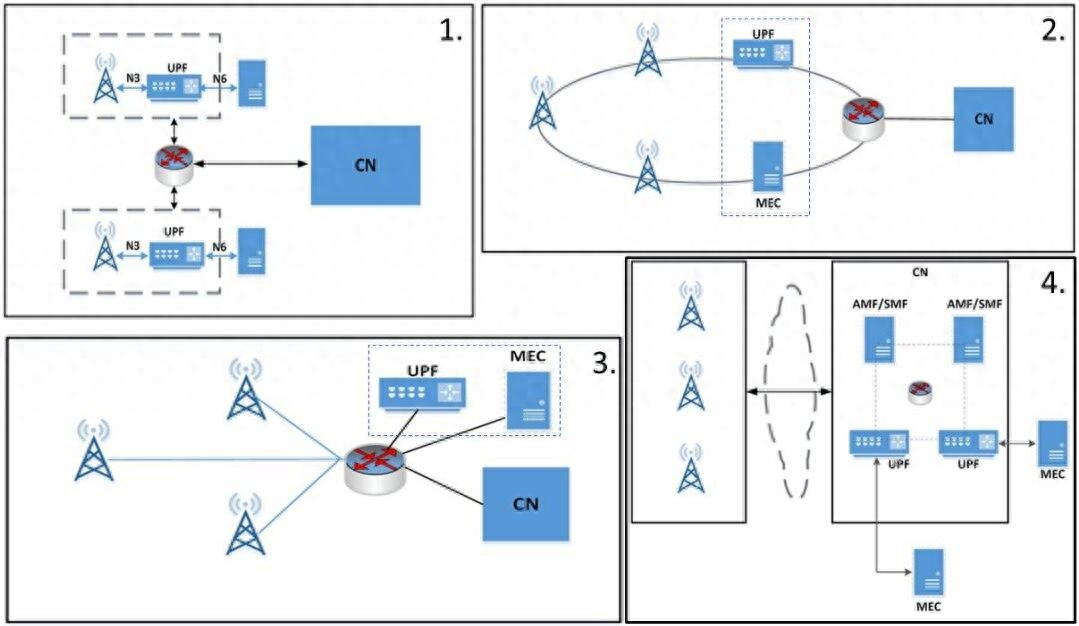

三、AI Agent 低延迟通信系统架构设计

🧠 整体架构示意(逻辑)

┌───────────┐ 5G ┌────────────┐

│ AI Agent │ ─────────────▶ │ Edge Agent │

│ Device │ ◀───────────── │ Service │

└───────────┘ └─────┬──────┘

│

│ 高层策略 / 模型更新

▼

┌────────────┐

│ Cloud LLM │

│ / Trainer │

└────────────┘

核心设计原则

- Agent 状态与决策分离

- 高频通信留在边缘

- 低频、重计算任务上云

- 事件驱动 + 异步通信

四、关键技术:AI Agent 的通信优化策略

✅ 1. 状态压缩与增量同步

AI Agent 通信中,绝大多数数据是“状态信息”。

优化方式:

- 仅发送 状态差分(delta)

- 使用 Protobuf / MsgPack 替代 JSON

- 量化浮点数(float16 / int8)

✅ 2. 异步通信模型(Async I/O)

避免阻塞式请求,Agent 通过事件回调方式协作。

✅ 3. 边缘 Agent 代理(Agent Gateway)

边缘节点作为:

- 多 Agent 的 通信聚合器

- 决策缓存与短期记忆

- 本地推理执行单元

五、示例:基于 Edge 的 AI Agent 低延迟通信实现(Python)

场景说明

- 多个 AI Agent 通过 5G 网络 向边缘节点发送状态

- 边缘节点做快速推理并返回决策

- 使用 FastAPI + WebSocket 实现低延迟双向通信

1️⃣ 边缘 Agent 服务端(Edge Node)

from fastapi import FastAPI, WebSocket

import asyncio

import time

app = FastAPI()

@app.websocket("/agent")

async def agent_ws(ws: WebSocket):

await ws.accept()

while True:

data = await ws.receive_json()

# 模拟边缘推理(极低延迟)

decision = {

"agent_id": data["agent_id"],

"action": "MOVE_FORWARD",

"timestamp": time.time()

}

await ws.send_json(decision)

await asyncio.sleep(0.001) # 模拟 1ms 推理延迟

2️⃣ AI Agent 客户端(运行在终端 / 设备)

import asyncio

import websockets

import json

import time

async def agent_run(agent_id):

uri = "ws://edge-node-ip:8000/agent"

async with websockets.connect(uri) as ws:

while True:

state = {

"agent_id": agent_id,

"speed": 1.2,

"position": [12.4, 9.8],

"ts": time.time()

}

await ws.send(json.dumps(state))

decision = await ws.recv()

print("Decision:", decision)

await asyncio.sleep(0.01)

asyncio.run(agent_run("agent-01"))

⏱️ 实际效果(实验环境)

| 架构 | 平均 RTT |

|---|---|

| 云中心 API | ~120ms |

| 5G + 边缘 WebSocket | 8~15ms |

六、进阶优化方向

🚀 1. gRPC + HTTP/3(QUIC)

- 更低握手延迟

- 原生流控

- 适合高并发 Agent

🚀 2. 多 Agent 协同缓存(Edge Memory)

短期状态 → Redis / LMDB

长期知识 → 云端向量数据库

🚀 3. Agent 通信协议标准化

- Agent-to-Agent Protocol

- 支持语义级消息而非原始数据

- 与大模型 Agent 框架(AutoGen / CrewAI)兼容

七、总结

5G + 边缘计算 为 AI Agent 的实时通信提供了关键基础设施支撑:

- ✔️ 毫秒级端到端延迟

- ✔️ 高并发、多 Agent 协同

- ✔️ 计算与通信的最优解耦

在未来:

AI Agent ≠ 单个模型,而是一个“实时分布式系统”

而网络通信优化,将成为 Agent 架构设计中不可忽视的一等公民。

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)