LLM驱动的跨模态感知-决策一体化智能体环境理解方法

一、背景:为什么 Agent 的“环境感知”成为瓶颈?

在当前的 AI Agent(智能体)系统 中,无论是自动驾驶、具身智能、强化学习 Agent,还是 LLM 驱动的 Tool-using Agent,都绕不开一个核心问题:

Agent 对环境的理解能力,直接决定了其决策上限。

现实环境往往是多模态的:

- 视觉:图像、视频、空间结构

- 听觉:语音、环境音

- 语言:文本指令、对话上下文

- 状态:数值传感器、系统指标、位置坐标

如果 Agent 仅依赖单一模态(如只看文本状态或低维数值),往往会出现:

- 环境理解不完整

- 状态抽象能力不足

- 决策对噪声高度敏感

因此,多模态环境感知 + 特征融合,已经成为 Agent 能力提升的关键技术路径。

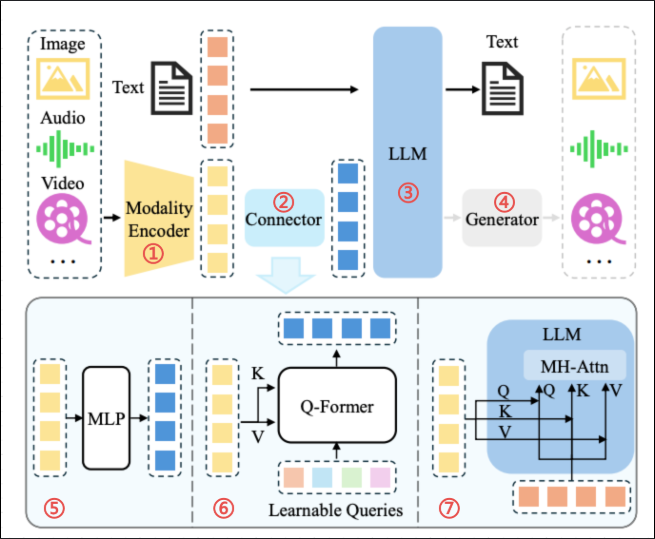

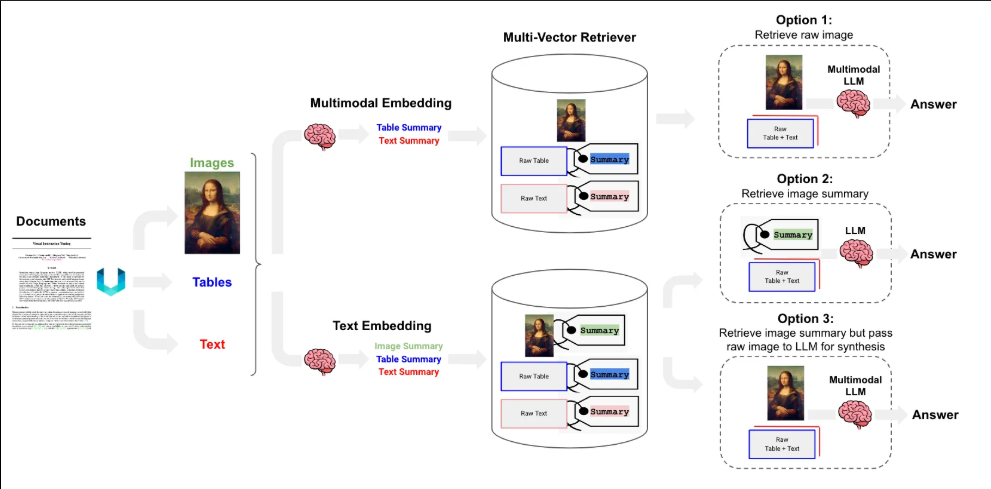

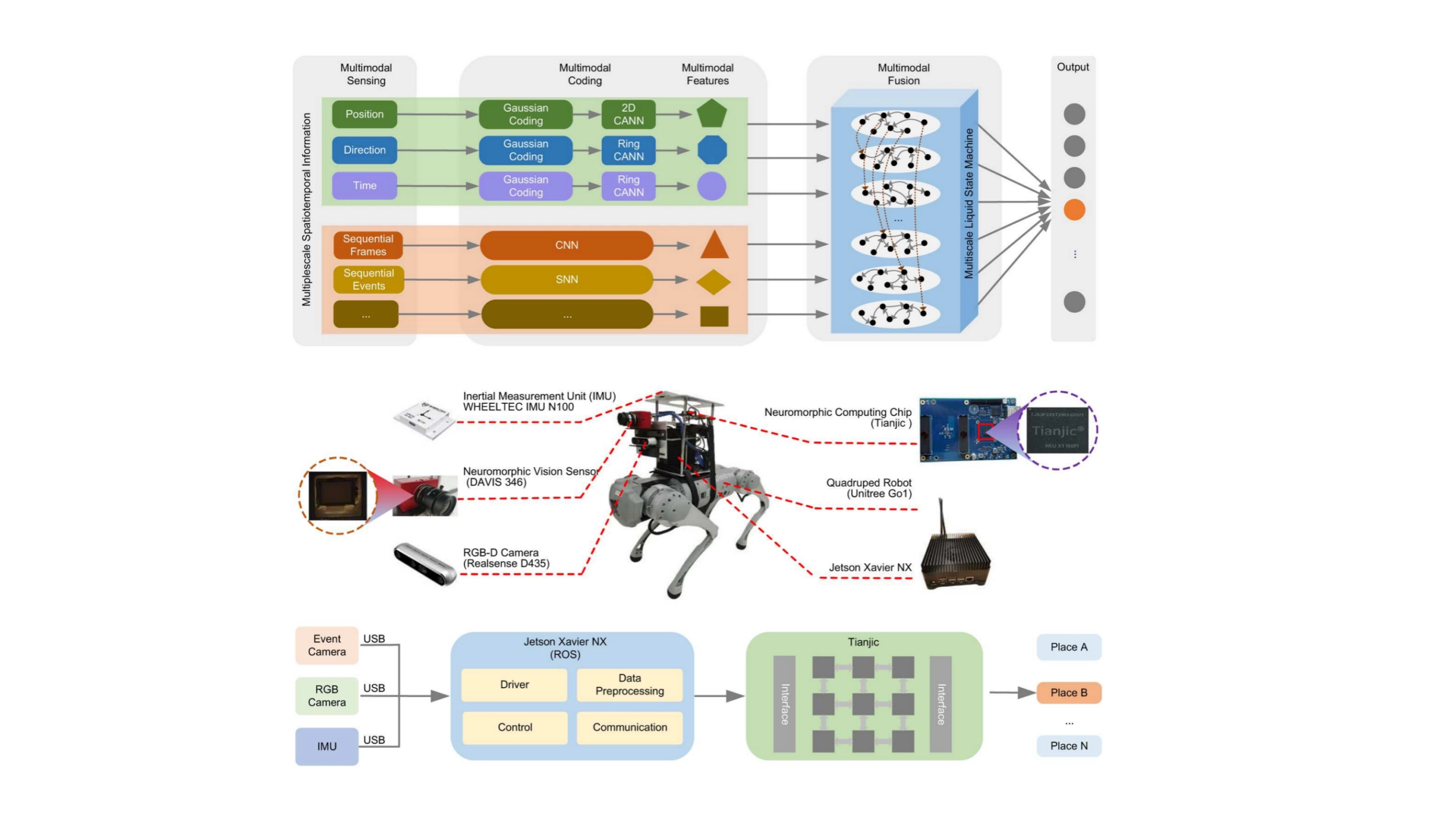

二、多模态环境感知的整体架构

一个典型的多模态环境感知与特征提取流程如下:

┌────────┐ ┌────────┐ ┌────────┐

│ 图像 │ │ 文本 │ │ 数值 │

└───┬────┘ └───┬────┘ └───┬────┘

│ │ │

┌───▼────┐ ┌────▼────┐ ┌────▼────┐

│视觉编码│ │文本编码 │ │状态编码 │

└───┬────┘ └────┬────┘ └────┬────┘

└──────┬──────────────┘

▼

多模态特征融合模块

▼

环境表示(State Embedding)

▼

Agent 决策 / 策略网络

核心思想:

将不同模态的信息映射到统一的特征空间,再进行融合,形成对环境的高层抽象。

三、关键技术一:多模态特征编码

1. 视觉模态:图像环境特征提取

视觉信息通常通过 CNN 或 Vision Transformer 提取。

import torch

import torch.nn as nn

from torchvision import models

class VisualEncoder(nn.Module):

def __init__(self, output_dim=256):

super().__init__()

backbone = models.resnet18(pretrained=True)

self.feature_extractor = nn.Sequential(*list(backbone.children())[:-1])

self.fc = nn.Linear(512, output_dim)

def forward(self, image):

x = self.feature_extractor(image)

x = x.view(x.size(0), -1)

return self.fc(x)

设计要点:

- 去掉分类头,仅保留语义特征

- 输出固定维度 embedding,便于后续融合

2. 文本模态:环境描述与指令理解

文本信息通常来自:

- 人类指令

- 环境描述

- 历史对话

from transformers import AutoModel, AutoTokenizer

class TextEncoder(nn.Module):

def __init__(self, model_name="bert-base-uncased", output_dim=256):

super().__init__()

self.tokenizer = AutoTokenizer.from_pretrained(model_name)

self.encoder = AutoModel.from_pretrained(model_name)

self.fc = nn.Linear(self.encoder.config.hidden_size, output_dim)

def forward(self, texts):

inputs = self.tokenizer(

texts,

padding=True,

truncation=True,

return_tensors="pt"

)

outputs = self.encoder(**inputs)

pooled = outputs.last_hidden_state[:, 0]

return self.fc(pooled)

3. 数值模态:环境状态与传感器信息

数值状态(位置、速度、能耗等)往往被忽视,但对 Agent 决策极其重要。

class StateEncoder(nn.Module):

def __init__(self, input_dim, output_dim=128):

super().__init__()

self.net = nn.Sequential(

nn.Linear(input_dim, 256),

nn.ReLU(),

nn.Linear(256, output_dim)

)

def forward(self, state):

return self.net(state)

四、关键技术二:多模态特征融合策略

1. 简单拼接(Baseline)

def concat_fusion(features):

return torch.cat(features, dim=-1)

优点:简单、高效

缺点:无法建模模态间关系

2. 加权融合(Learnable Fusion)

class WeightedFusion(nn.Module):

def __init__(self, dims):

super().__init__()

self.weights = nn.Parameter(torch.ones(len(dims)))

def forward(self, features):

w = torch.softmax(self.weights, dim=0)

fused = sum(w[i] * features[i] for i in range(len(features)))

return fused

适合场景:

- 不同模态重要性随任务变化

- 轻量级 Agent 系统

3. Attention 融合(推荐)

class AttentionFusion(nn.Module):

def __init__(self, feature_dim):

super().__init__()

self.attn = nn.MultiheadAttention(

embed_dim=feature_dim,

num_heads=4,

batch_first=True

)

def forward(self, features):

x = torch.stack(features, dim=1)

attn_out, _ = self.attn(x, x, x)

return attn_out.mean(dim=1)

优势:

- 显式建模跨模态依赖

- 对噪声模态更鲁棒

五、完整的多模态环境感知模块

class MultiModalPerception(nn.Module):

def __init__(self, state_dim):

super().__init__()

self.visual_encoder = VisualEncoder()

self.text_encoder = TextEncoder()

self.state_encoder = StateEncoder(state_dim)

self.fusion = AttentionFusion(feature_dim=256)

def forward(self, image, text, state):

v_feat = self.visual_encoder(image)

t_feat = self.text_encoder(text)

s_feat = self.state_encoder(state)

return self.fusion([v_feat, t_feat, s_feat])

输出的 Environment Embedding 可以直接用于:

- 强化学习 Policy Network

- 行为规划模块

- LLM Agent 的环境上下文增强

六、在 Agent 系统中的实际应用

1. 强化学习 Agent

state_embed = perception(image, text, state)

action = policy_network(state_embed)

2. LLM + Agent 结合

env_summary = env_embedding_to_text(state_embed)

prompt = f"""

当前环境状态:

{env_summary}

请规划下一步动作。

"""

七、工程实践中的关键问题

1. 模态缺失怎么办?

- 使用 Mask Attention

- 引入模态存在标识(Modality Token)

2. 性能瓶颈

- 视觉模型蒸馏

- 离线特征缓存

- 多模态异步更新

3. 训练策略

- 单模态预训练

- 再进行多模态联合微调

- Curriculum Learning(逐步增加模态)

八、总结与展望

多模态融合并不是“锦上添花”,而是 Agent 走向复杂真实环境的必经之路。

未来趋势包括:

- 多模态世界模型(World Model)

- LLM 驱动的感知-决策一体化 Agent

- 具身智能中的跨模态自监督学习

真正强大的 Agent,不是算得快,而是“看得懂世界”。

多模态融合为智能体提供了一种更接近真实世界的环境感知方式,使 Agent 能够从视觉、语言和结构化状态等多源信息中构建统一、抽象且鲁棒的环境表示。通过合理的特征编码与融合策略,智能体不仅能提升对复杂环境的理解深度,还能显著增强决策的稳定性与泛化能力。从工程实践来看,多模态感知模块已逐渐成为高性能 Agent 系统的基础组件。随着算力、模型结构和自监督学习方法的不断进步,未来的智能体将具备更强的跨模态理解与推理能力,真正实现从“被动感知”向“主动理解环境”的演进。

- 点赞

- 收藏

- 关注作者

评论(0)