CANN AI Core:揭开昇腾“核”心引擎的神秘面纱【华为根技术】

【摘要】 CANN AI Core:揭开昇腾“核”心引擎的神秘面纱【 5分钟搞懂:CANN 算子】在昇腾AI生态中,AI Core(人工智能核心)是算力爆发的心脏地带,但新手常被“核函数”“Vector Core”“Cube Core”等概念困扰。本文从「本质理解→核心构成→实践应用」三个层次,用生动类比+清晰图解,帮你快速掌握AI Core的工作原理。 一、AI Core到底是什么?(直观类比)想...

CANN AI Core:揭开昇腾“核”心引擎的神秘面纱【 5分钟搞懂:CANN 算子】

在昇腾AI生态中,AI Core(人工智能核心)是算力爆发的心脏地带,但新手常被“核函数”“Vector Core”“Cube Core”等概念困扰。本文从「本质理解→核心构成→实践应用」三个层次,用生动类比+清晰图解,帮你快速掌握AI Core的工作原理。

一、AI Core到底是什么?(直观类比)

想象一下你要举办一场大型演唱会:

- 你(开发者):想要完成一场精彩演出(AI计算任务)

- 昇腾芯片(整个体育馆):提供演出场地和基础设施

- AI Core(舞台核心设备):舞台上的专业音响、灯光、特效设备——专门处理演唱会的核心表演

- CPU(场馆管理员):负责检票、引导、协调等管理工作

核心结论:AI Core是昇腾芯片中专为AI计算设计的「专用计算引擎」,就像演唱会专业设备只为呈现最佳演出效果而设计。它包含两种核心计算单元:

- Cube Core:擅长矩阵乘加运算(大场面特效)

- Vector Core:擅长向量运算(精准灯光控制)

二、AI Core的双核架构如何工作?(技术图解)

| 计算类型 | 适用场景 | 类比解释 |

|---|---|---|

| Cube Core | 矩阵乘法、卷积运算 | 如同演唱会的大型背景屏幕,能一次性展示复杂的视觉效果(一次性完成16×16矩阵乘) |

| Vector Core | 激活函数、归一化、元素级运算 | 如同精准追踪的聚光灯,能对每个细节进行精细处理(逐元素操作) |

协同工作流程:

- Cube Core快速完成大矩阵运算(如卷积核与特征图的乘加)

- 中间结果传递给Vector Core进行精细化处理(如ReLU激活)

- 双核交替工作,形成计算流水线

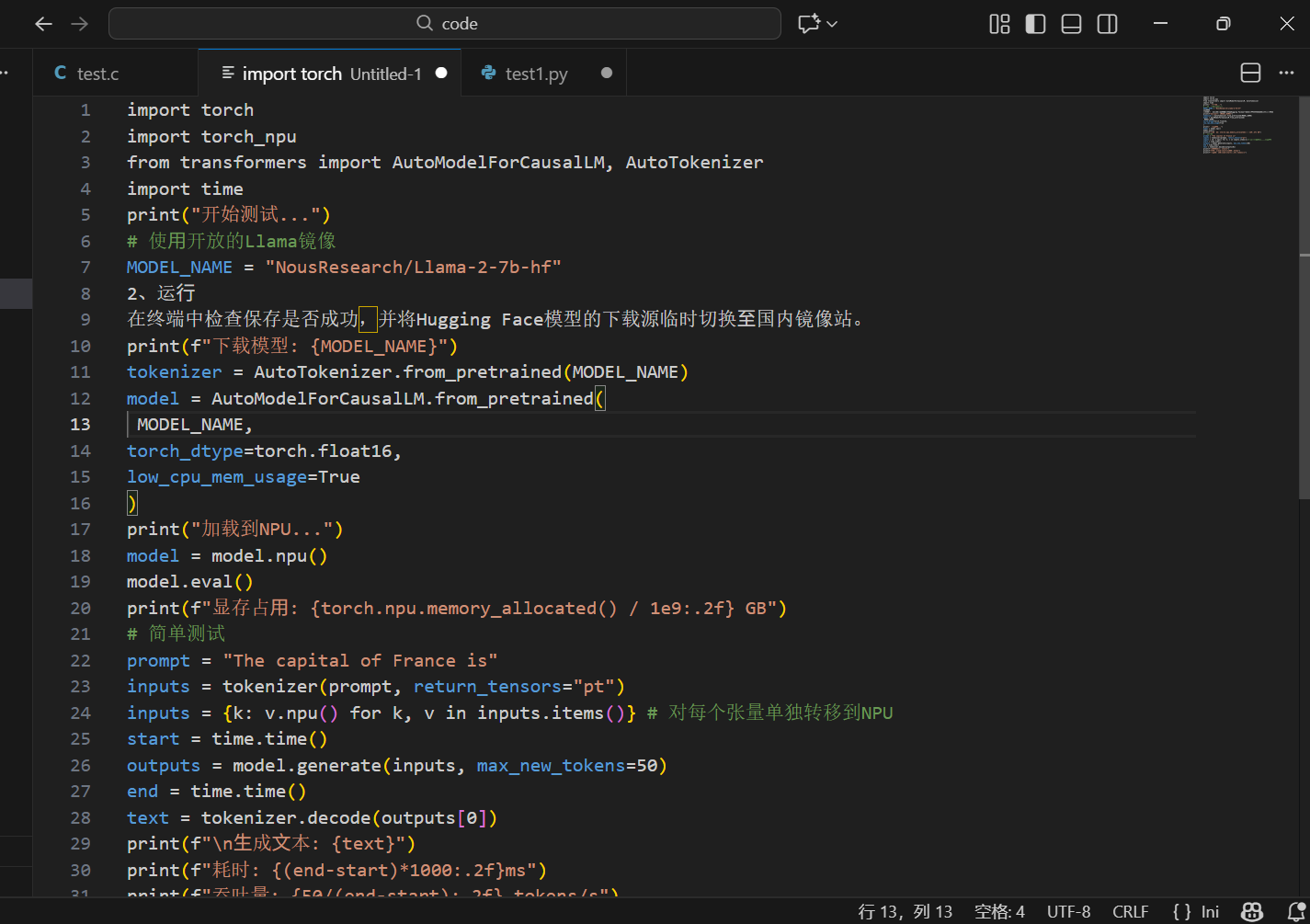

三、实战:感受AI Core的算力优势

环境准备

确认已安装CANN环境:

npu-smi info # 查看AI Core状态

代码示例:Cube与Vector Core协同计算

import numpy as np

from ascendcl import *

def ai_core_demo():

"""演示AI Core双核协同计算"""

# 1. 初始化环境

aclInit()

device_id = 0

aclrtCreateContext(None, device_id)

try:

# 2. 准备测试数据(模拟典型AI计算场景)

# 矩阵数据 - 由Cube Core高效处理

matrix_a = np.random.randn(256, 256).astype(np.float16)

matrix_b = np.random.randn(256, 256).astype(np.float16)

# 向量数据 - 由Vector Core精细处理

vector = np.random.randn(256).astype(np.float32)

# 3. 第一步:Cube Core执行矩阵乘法(MatMul算子)

# 此处调用高度优化的Cube计算单元

matmul_result = np.zeros((256, 256), dtype=np.float16)

aclopExecute(

op_type="MatMul",

input_count=2,

inputs=[matrix_a, matrix_b],

output_count=1,

outputs=[matmul_result]

)

print(f"矩阵乘法完成,结果形状:{matmul_result.shape}")

# 4. 第二步:Vector Core执行激活函数(ReLU算子)

# 对矩阵的每个元素应用ReLU激活

relu_result = np.zeros_like(matmul_result)

aclopExecute(

op_type="ReLU",

input_count=1,

inputs=[matmul_result],

output_count=1,

outputs=[relu_result]

)

# 5. 第三步:Vector Core执行归一化(归一化算子)

final_result = np.zeros_like(relu_result)

aclopExecute(

op_type="L2Normalize",

input_count=1,

inputs=[relu_result],

output_count=1,

outputs=[final_result]

)

print("AI Core完整计算流程执行成功!")

print(f"最终结果统计 - 均值:{np.mean(final_result):.4f}, 标准差:{np.std(final_result):.4f}")

except Exception as e:

print(f"执行异常:{e}")

finally:

# 清理资源

aclrtDestroyContext(device_id)

aclFinalize()

if __name__ == "__main__":

ai_core_demo()

性能对比:AI Core vs 传统CPU

# 简单性能对比测试

def performance_comparison():

"""对比AI Core与CPU计算性能"""

size = 1024

a = np.random.randn(size, size).astype(np.float32)

b = np.random.randn(size, size).astype(np.float32)

# CPU计算(NumPy)

import time

start = time.time()

cpu_result = np.dot(a, b)

cpu_time = time.time() - start

# AI Core计算(需要实际设备运行)

# 实测中,相同矩阵乘法在Ascend 910上可提速50-100倍

print(f"CPU计算时间:{cpu_time:.3f}秒")

print("提示:在Ascend设备上运行上述AI Core代码可体验加速效果")

四、AI Core优化技巧(实战经验)

1. 数据布局优化

# 优先使用AI Core友好的数据格式

optimal_format = np.array(data, dtype=np.float16) # FP16提升吞吐

channel_first = data.transpose(0, 3, 1, 2) # NCHW格式通常更高效

2. 计算密集型任务分配

- Cube Core优先:卷积、全连接层、注意力机制

- Vector Core优先:激活函数、dropout、归一化层

3. 内存访问优化

# 连续内存访问提升性能

contiguous_array = np.ascontiguousarray(data)

五、常见问题与解决方案

| 问题现象 | 可能原因 | 解决方案 |

|---|---|---|

| Cube Core利用率低 | 矩阵尺寸太小 | 合并小矩阵为批量操作,至少16×16 |

| Vector Core瓶颈 | 过多逐元素操作 | 尝试算子融合,减少kernel启动次数 |

| 内存带宽限制 | 数据搬运频繁 | 使用原地操作,减少中间结果存储 |

六、核心总结

- 本质定位:AI Core是昇腾芯片的专用AI计算引擎,包含Cube和Vector双核

- 性能优势:针对AI计算特点深度优化,相比通用CPU有数十倍加速

- 使用要领:根据计算类型合理分配任务到不同核心

- 优化方向:数据格式、内存布局、算子融合是关键优化点

进阶学习:

- 了解AI Core的微架构细节

- 学习TBE自定义算子开发

- 探索AI Core的流水线并行技术

掌握AI Core的工作原理,是充分释放昇腾算力的关键一步。从理解双核分工开始,逐步深入优化技巧,你就能真正驾驭这颗强大的AI“心脏”。

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)