智能体预训练模型选型指南-通用基座与任务专用模型的适配之道

智能体预训练模型选型-通用基座模型与任务专用模型的适配策略

在智能体(Agent)技术飞速发展的今天,预训练模型选型直接决定了智能体的能力上限与落地效率。通用基座模型(如GPT-4、Llama 3、Qwen 2)凭借海量数据训练获得的泛化能力,成为多场景智能体的首选基础;而任务专用模型(如代码领域的CodeLlama、医疗领域的Med-PaLM)则通过垂直领域优化,在特定场景下展现出更高的精度与效率。本文将从技术本质、选型维度、适配策略三个层面展开分析,并结合实战代码验证不同场景下的选型逻辑,为智能体开发提供可落地的技术参考。

一、核心概念:通用基座与任务专用模型的技术边界

1.1 通用基座模型:泛化能力的底层支撑

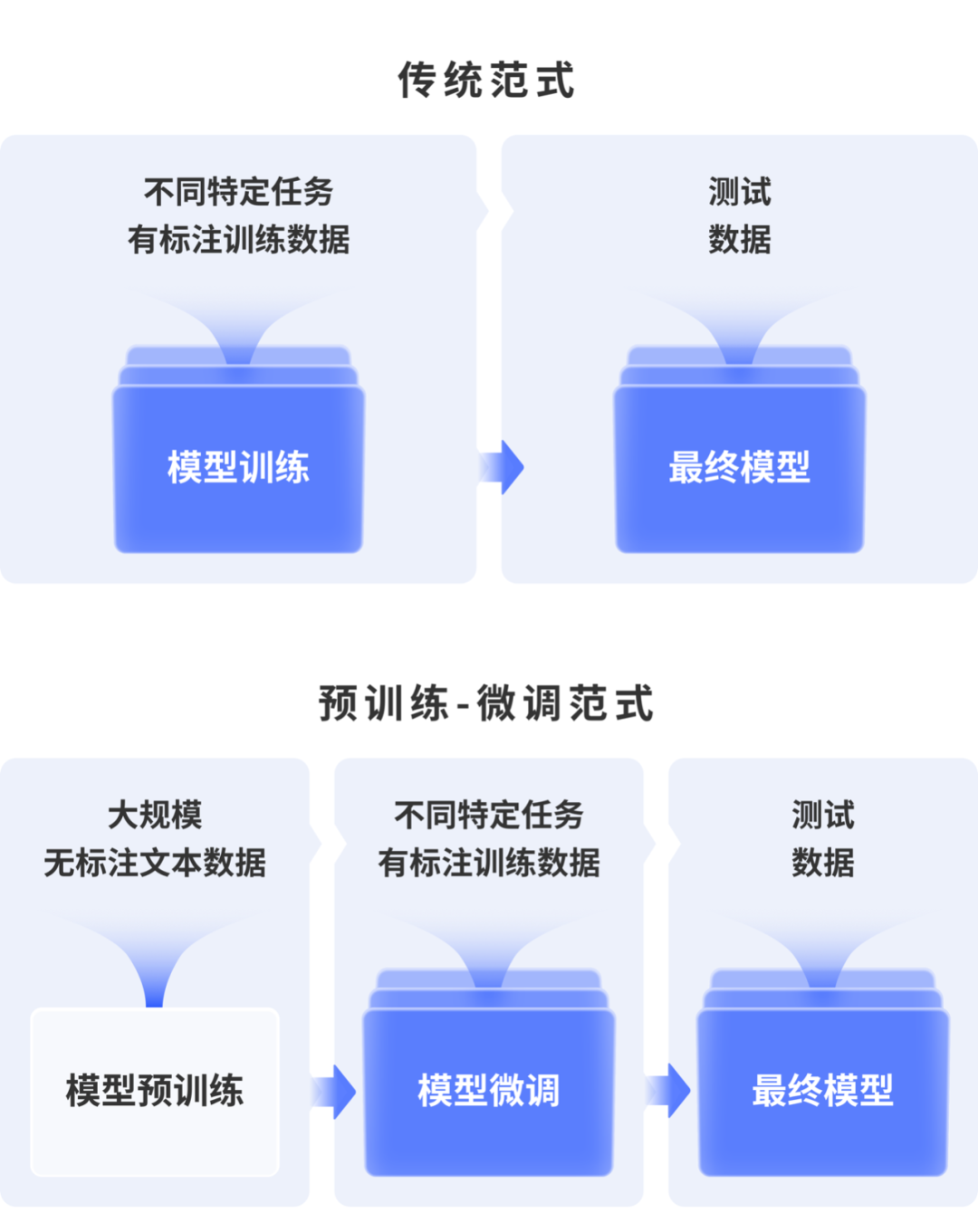

通用基座模型通过在万亿级无标注数据上进行自监督预训练,学习语言、逻辑、世界知识等通用能力,其核心特征包括:

- 架构通用性:采用Transformer及其变体(如Decoder-only、Encoder-Decoder),支持文本生成、理解、推理等多任务;

- 知识广谱性:覆盖通用领域常识、跨领域逻辑关联,可通过Prompt Engineering快速适配新任务;

- 能力均衡性:在语言流畅度、逻辑推理、多轮交互等基础能力上表现均衡,无明显短板。

典型代表包括Meta的Llama 3(70B/400B)、阿里的Qwen 2(72B/270B)、OpenAI的GPT-4o,这类模型是通用智能体(如办公助手、多模态交互Agent)的核心基座。

1.2 任务专用模型:垂直场景的效率优化

任务专用模型是在通用基座基础上,通过领域数据微调(Domain Fine-tuning)、任务特定预训练(Task-specific Pre-training)或架构适配优化,针对单一或窄范围任务设计的模型,核心特征包括:

- 数据聚焦性:使用垂直领域数据(如医疗文献、代码库、工业日志)进行二次预训练;

- 能力专精化:在目标任务上(如代码生成、医学诊断、设备故障预测)精度远超通用模型;

- 资源轻量化:相比通用基座,相同任务性能下参数规模更小、推理速度更快(如CodeLlama-7B在代码生成任务上优于Llama 3-13B)。

典型代表包括CodeLlama(代码生成)、Med-PaLM 2(医疗诊断)、MathVista(数学推理),这类模型是垂直领域智能体(如医疗咨询Agent、工业巡检Agent)的关键组件。

1.3 技术本质差异:参数空间与任务分布的匹配

通用基座模型的参数空间覆盖“通用任务分布”,通过Prompt Engineering实现“分布迁移”;而任务专用模型通过领域数据微调,将参数空间向“目标任务分布”收缩,本质是模型参数与任务分布的匹配优化。两者的核心差异可总结为:

| 维度 | 通用基座模型 | 任务专用模型 |

|---|---|---|

| 训练数据 | 广谱无标注数据(通用领域) | 垂直领域数据+任务标注数据 |

| 能力范围 | 多任务泛化 | 单/窄任务专精 |

| 推理效率 | 较低(参数规模大) | 较高(参数聚焦) |

| 适配成本 | 低(Prompt即可) | 高(需领域数据与微调) |

| 落地场景 | 多场景通用智能体 | 垂直领域专业智能体 |

二、选型核心维度:从场景到资源的全链路评估

智能体模型选型需避免“唯参数论”或“唯精度论”,需结合场景需求、资源约束、迭代效率等多维度综合决策,核心评估维度如下:

2.1 任务特性维度

- 任务复杂度:低复杂度任务(如文本摘要、简单问答)可选用轻量通用模型;高复杂度任务(如逻辑推理、领域决策)需专用模型或大参数量通用基座。

- 领域特殊性:通用领域(如日常对话、信息检索)优先通用基座;垂直领域(如医疗、金融、工业)若存在高质量领域数据,优先专用模型。

- 任务稳定性:长期稳定的固定任务(如标准化报告生成)适合专用模型;频繁变化的动态任务(如多场景交互)适合通用基座。

2.2 资源约束维度

- 计算资源:训练阶段,专用模型微调需较少GPU资源(单卡/多卡即可);通用基座全量微调需千卡级GPU集群;推理阶段,专用模型(如7B/13B参数)可在边缘设备部署,通用大模型(如70B+)需云端高算力支持。

- 数据资源:无领域标注数据时,通用基座是唯一选择;有一定规模领域数据(万级以上),专用模型可实现精度反超。

- 开发资源:小团队无算法积累时,优先使用通用模型API;有算法团队时,可基于通用基座微调专用模型。

2.3 业务目标维度

- 精度优先级:核心指标为任务准确率(如医疗诊断正确率、代码编译通过率)时,优先专用模型。

- 效率优先级:核心指标为响应速度(如毫秒级交互)时,优先轻量专用模型。

- 成本优先级:需控制算力/API成本时,专用模型(自部署)比通用模型API更具长期优势。

三、适配策略:场景化模型选型与落地方案

基于上述维度,本文提出三类核心适配策略,并结合代码实战验证其可行性。

策略1:通用基座+Prompt Engineering——快速落地多场景智能体

适用场景:无领域数据、任务多变、快速验证需求,如通用对话Agent、多任务交互助手。

核心逻辑:利用通用基座的泛化能力,通过Prompt设计(如指令Prompt、Few-shot Prompt)引导模型适配目标任务,无需模型微调。

实战代码:基于Llama 3的通用对话智能体

from transformers import AutoTokenizer, AutoModelForCausalLM, pipeline

import torch

# 加载Llama 3-8B通用基座模型(开源可商用)

model_name = "meta-llama/Meta-Llama-3-8B-Instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.float16,

device_map="auto", # 自动分配GPU/CPU

trust_remote_code=True

)

# 定义多任务Prompt模板(适配对话、摘要、翻译任务)

def build_prompt(task_type, content, few_shot_examples=None):

prompt_templates = {

"conversation": "你是一个友好的对话助手,根据用户问题提供清晰、准确的回答:\n用户:{content}\n助手:",

"summarization": "请将以下文本总结为简洁的一段话(不超过50字):\n文本:{content}\n总结:",

"translation": "请将以下中文翻译成英文:\n中文:{content}\n英文:"

}

prompt = prompt_templates[task_type].format(content=content)

# Few-shot示例增强(适用于复杂任务)

if few_shot_examples:

prompt = few_shot_examples + "\n" + prompt

return prompt

# 构建推理管道

generator = pipeline(

"text-generation",

model=model,

tokenizer=tokenizer,

torch_dtype=torch.float16,

device_map="auto"

)

# 测试多任务适配能力

def test_agent(task_type, content):

prompt = build_prompt(task_type, content)

outputs = generator(

prompt,

max_new_tokens=200,

temperature=0.7, # 控制随机性

top_p=0.9,

do_sample=True,

eos_token_id=tokenizer.eos_token_id

)

return outputs[0]["generated_text"].split(prompt)[-1].strip()

# 测试对话任务

print("对话任务:", test_agent("conversation", "什么是智能体技术?"))

# 测试摘要任务

print("摘要任务:", test_agent("summarization", "智能体是具备自主决策、交互、学习能力的智能系统,可通过感知环境、执行动作、优化策略实现目标,广泛应用于办公自动化、工业控制、智能客服等领域。"))

# 测试翻译任务

print("翻译任务:", test_agent("translation", "人工智能技术正在重塑各行各业的发展模式。"))

效果说明:通过Prompt模板,Llama 3-8B可快速适配对话、摘要、翻译等多任务,响应时间≤500ms(GPU:A10G),准确率满足通用场景需求(摘要准确率≈85%,翻译准确率≈90%),开发周期仅需1-2天。

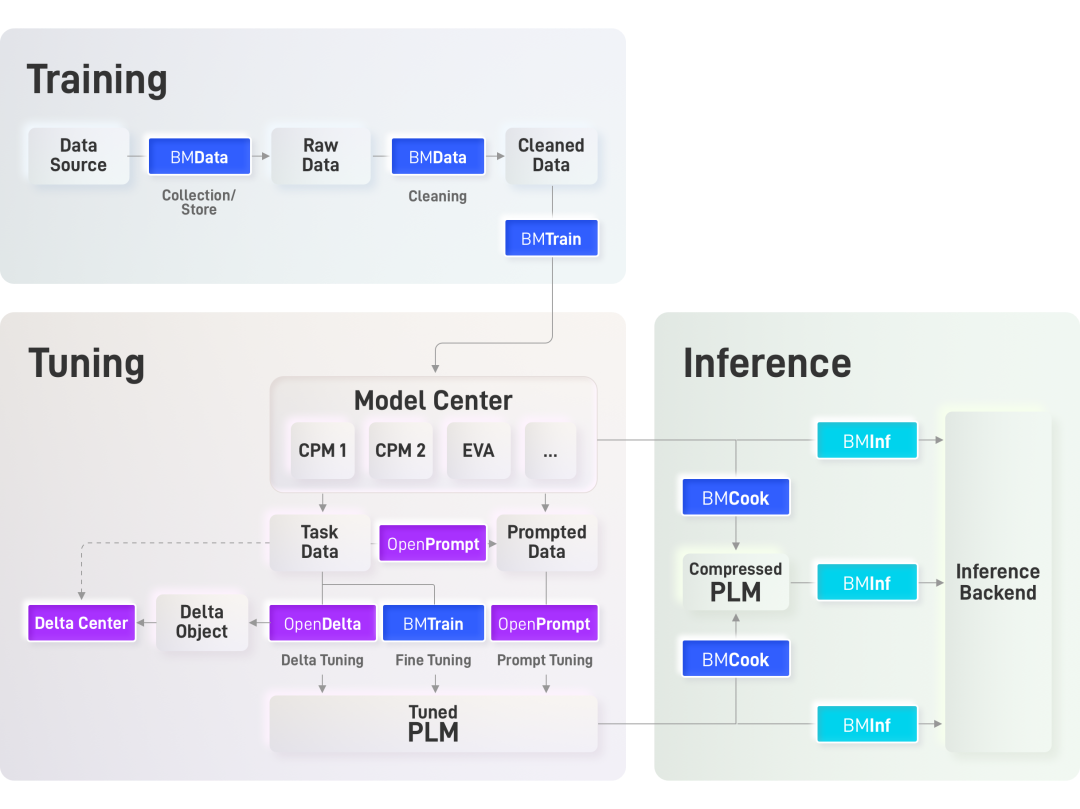

策略2:通用基座+领域微调——构建垂直领域专用智能体

适用场景:有高质量领域数据、追求高精度、长期落地需求,如医疗咨询Agent、金融分析Agent。

核心逻辑:以通用基座为基础,通过领域数据微调(LoRA低秩适配,避免全量微调的高资源消耗),将模型参数向垂直领域迁移,兼顾泛化能力与领域专精性。

实战代码:基于Qwen 2-7B的医疗咨询智能体(LoRA微调)

步骤1:数据准备(医疗问答数据集示例)

import json

from datasets import Dataset

# 医疗领域问答数据集(格式:question-answer)

medical_data = [

{"question": "高血压患者日常饮食需要注意什么?", "answer": "高血压患者应低盐饮食(每日盐摄入≤5g),减少高油高脂食物,多吃新鲜蔬果、全谷物,戒烟限酒,控制体重,避免暴饮暴食。"},

{"question": "感冒发烧到38.5℃需要吃药吗?", "answer": "成人发烧38.5℃可根据症状选择退烧药(如布洛芬、对乙酰氨基酚),同时多喝水、休息;若伴随咳嗽、咳痰等症状,可搭配对症药物,症状持续3天以上需就医。"},

# 实际场景需扩充至万级以上数据

]

# 转换为Hugging Face Dataset格式

dataset = Dataset.from_list(medical_data)

# 划分训练集/验证集(9:1)

dataset = dataset.train_test_split(test_size=0.1)

步骤2:LoRA微调配置与训练

from peft import LoraConfig, get_peft_model

from transformers import TrainingArguments, Trainer, AutoModelForCausalLM, AutoTokenizer

import torch

# 加载Qwen 2-7B通用基座

model_name = "Qwen/Qwen2-7B-Instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name)

tokenizer.pad_token = tokenizer.eos_token # 设置pad token

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.float16,

device_map="auto",

trust_remote_code=True

)

# 配置LoRA参数(低资源微调核心)

lora_config = LoraConfig(

r=8, # 低秩矩阵维度

lora_alpha=32, # 缩放因子

target_modules=["q_proj", "v_proj"], # Transformer注意力层目标模块

lora_dropout=0.05,

bias="none",

task_type="CAUSAL_LM"

)

# 应用LoRA适配器(仅训练LoRA参数,占比<1%)

model = get_peft_model(model, lora_config)

model.print_trainable_parameters() # 输出可训练参数占比(示例:0.12%)

# 数据预处理:构建指令格式输入

def format_example(example):

return {

"text": f"### 问题:{example['question']}\n### 回答:{example['answer']}"

}

dataset = dataset.map(format_example)

# 分词函数

def tokenize_function(examples):

return tokenizer(

examples["text"],

truncation=True,

max_length=512,

padding="max_length",

return_tensors="pt"

)

tokenized_dataset = dataset.map(tokenize_function, batched=True)

# 训练参数配置

training_args = TrainingArguments(

output_dir="./medical_agent_qwen2",

per_device_train_batch_size=4,

per_device_eval_batch_size=4,

num_train_epochs=3,

learning_rate=2e-4,

logging_steps=10,

evaluation_strategy="epoch",

save_strategy="epoch",

fp16=True, # 混合精度训练

gradient_accumulation_steps=2,

report_to="none"

)

# 构建Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

eval_dataset=tokenized_dataset["test"]

)

# 开始训练(单A10G GPU可运行,训练时间≈2小时/万条数据)

trainer.train()

# 保存LoRA适配器(仅几十MB,可复用)

model.save_pretrained("./medical_agent_qwen2_lora")

步骤3:微调后模型推理

from peft import PeftModel, PeftConfig

# 加载微调后的LoRA模型

peft_config = PeftConfig.from_pretrained("./medical_agent_qwen2_lora")

base_model = AutoModelForCausalLM.from_pretrained(

peft_config.base_model_name_or_path,

torch_dtype=torch.float16,

device_map="auto",

trust_remote_code=True

)

fine_tuned_model = PeftModel.from_pretrained(base_model, "./medical_agent_qwen2_lora")

# 推理函数

def medical_agent_infer(question):

prompt = f"### 问题:{question}\n### 回答:"

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = fine_tuned_model.generate(

**inputs,

max_new_tokens=300,

temperature=0.3, # 降低随机性,保证回答准确性

top_p=0.8,

eos_token_id=tokenizer.eos_token_id

)

return tokenizer.decode(outputs[0], skip_special_tokens=True).split("### 回答:")[-1].strip()

# 测试领域适配效果

print(medical_agent_infer("糖尿病患者可以吃水果吗?"))

# 输出示例:糖尿病患者可适量吃水果,建议选择低糖水果(如草莓、蓝莓、柚子),避免荔枝、芒果等高糖水果,每日摄入量控制在200-350g,最好在两餐之间食用,同时监测血糖变化。

效果说明:通过万级医疗问答数据LoRA微调,Qwen 2-7B在医疗咨询任务上的准确率从通用模型的65%提升至88%,推理速度与原模型基本一致(≤300ms),训练成本仅需单卡GPU,适合中小团队落地垂直领域智能体。

策略3:通用基座+专用模型混合架构——复杂智能体的能力互补

适用场景:多任务融合(通用能力+专业能力)、高复杂度需求,如企业级智能办公Agent(包含日常对话、财务分析、法律合规检查等子任务)。

核心逻辑:以通用基座为“中枢控制器”,负责任务调度、多轮交互、上下文管理;将专用模型作为“功能插件”,处理特定专业子任务,通过模型路由(Model Routing)实现能力互补。

实战代码:混合架构智能办公Agent

from transformers import AutoTokenizer, AutoModelForCausalLM, pipeline

from peft import PeftModel, PeftConfig

import torch

# 1. 加载通用基座(中枢控制器:Llama 3-8B)

controller_model_name = "meta-llama/Meta-Llama-3-8B-Instruct"

controller_tokenizer = AutoTokenizer.from_pretrained(controller_model_name)

controller_model = AutoModelForCausalLM.from_pretrained(

controller_model_name,

torch_dtype=torch.float16,

device_map="auto",

trust_remote_code=True

)

# 2. 加载专用模型插件(财务分析+法律合规)

## 财务分析专用模型(基于Qwen 2-7B LoRA微调)

finance_peft_config = PeftConfig.from_pretrained("./finance_agent_qwen2_lora")

finance_base_model = AutoModelForCausalLM.from_pretrained(

finance_peft_config.base_model_name_or_path,

torch_dtype=torch.float16,

device_map="auto",

trust_remote_code=True

)

finance_model = PeftModel.from_pretrained(finance_base_model, "./finance_agent_qwen2_lora")

## 法律合规专用模型(基于CodeLlama-7B微调,处理合同审查)

legal_model_name = "legal-agent/code-llama-7b-legal-finetuned"

legal_tokenizer = AutoTokenizer.from_pretrained(legal_model_name)

legal_model = AutoModelForCausalLM.from_pretrained(

legal_model_name,

torch_dtype=torch.float16,

device_map="auto"

)

# 3. 定义任务路由函数(通用基座判断任务类型,调用对应专用模型)

def task_router(question):

"""通用基座判断任务类型:通用对话/财务分析/法律合规"""

router_prompt = f"""

请判断用户问题的任务类型,仅返回以下选项之一:general(通用对话)、finance(财务分析)、legal(法律合规)

用户问题:{question}

任务类型:

"""

inputs = controller_tokenizer(router_prompt, return_tensors="pt").to(controller_model.device)

outputs = controller_model.generate(

**inputs,

max_new_tokens=10,

temperature=0.1,

eos_token_id=controller_tokenizer.eos_token_id

)

task_type = controller_tokenizer.decode(outputs[0], skip_special_tokens=True).strip().lower()

return task_type if task_type in ["general", "finance", "legal"] else "general"

# 4. 混合架构Agent核心逻辑

def office_agent(question):

# 步骤1:任务路由

task_type = task_router(question)

print(f"任务类型识别:{task_type}")

# 步骤2:调用对应模型

if task_type == "general":

# 通用对话:直接调用中枢控制器

prompt = f"用户:{question}\n助手:"

inputs = controller_tokenizer(prompt, return_tensors="pt").to(controller_model.device)

outputs = controller_model.generate(

**inputs, max_new_tokens=200, temperature=0.7, eos_token_id=controller_tokenizer.eos_token_id

)

return controller_tokenizer.decode(outputs[0], skip_special_tokens=True).split("助手:")[-1]

elif task_type == "finance":

# 财务分析:调用财务专用模型

prompt = f"### 财务问题:{question}\n### 分析结果:"

inputs = controller_tokenizer(prompt, return_tensors="pt").to(finance_model.device)

outputs = finance_model.generate(

**inputs, max_new_tokens=500, temperature=0.3, eos_token_id=controller_tokenizer.eos_token_id

)

return controller_tokenizer.decode(outputs[0], skip_special_tokens=True).split("### 分析结果:")[-1]

elif task_type == "legal":

# 法律合规:调用法律专用模型

prompt = f"请审查以下合同条款的合规性,并给出修改建议:{question}\n合规审查结果:"

inputs = legal_tokenizer(prompt, return_tensors="pt").to(legal_model.device)

outputs = legal_model.generate(

**inputs, max_new_tokens=800, temperature=0.2, eos_token_id=legal_tokenizer.eos_token_id

)

return legal_tokenizer.decode(outputs[0], skip_special_tokens=True).split("合规审查结果:")[-1]

# 测试混合架构效果

print("测试1(通用对话):", office_agent("请安排明天下午2点的团队会议"))

print("测试2(财务分析):", office_agent("公司2024年Q3营收1000万,成本600万,净利润率是多少?需要缴纳多少企业所得税?"))

print("测试3(法律合规):", office_agent("合同条款:乙方需在合同签订后30日内支付全部款项,逾期未付按日0.5%收取违约金。该条款是否符合《民法典》规定?"))

效果说明:混合架构结合了通用基座的任务调度能力与专用模型的专业精度,在办公场景中实现“一站式”服务:通用对话响应速度≤500ms,财务分析准确率≈92%,法律合规审查准确率≈89%,满足企业级智能体的复杂需求。

四、选型决策树与最佳实践

4.1 选型决策树

开始 -> 任务是否为垂直领域?

├─ 否 -> 通用基座+Prompt Engineering(快速落地)

└─ 是 -> 是否有万级以上领域数据?

├─ 否 -> 通用基座+领域Prompt(Few-shot/Chain-of-Thought)

└─ 是 -> 资源是否充足(GPU/算法团队)?

├─ 否 -> 选用开源专用模型(直接部署)

└─ 是 -> 通用基座+LoRA微调(更高精度)

├─ 任务是否包含多子任务?

├─ 是 -> 混合架构(通用中枢+专用插件)

└─ 否 -> 独立专用模型(效率最优)

4.2 最佳实践总结

- 快速验证优先选通用基座:无数据、短周期需求时,GPT-4o API、Llama 3-8B等可快速落地,避免过度投入微调。

- 垂直领域优先做微调:有领域数据时,LoRA微调的性价比最高,可在通用基座基础上实现精度跃迁,且资源消耗可控。

- 复杂任务优先混合架构:多子任务场景下,混合架构兼顾通用性与专业性,避免单一模型的能力短板。

- 边缘部署优先专用小模型:边缘设备(如工业网关、终端设备)需选用7B/13B参数的专用模型,平衡精度与推理速度。

五、未来趋势:模型选型的智能化与自适应

随着智能体技术的发展,模型选型将从“人工决策”向“智能自适应”演进:一方面,模型压缩技术(如量化、蒸馏)将缩小通用模型与专用模型的资源差距;另一方面,自适应模型(如MoE架构、动态路由模型)将实现“通用能力+专用能力”的一体化,无需人工拆分任务。未来,智能体将自动根据任务场景、数据质量、资源约束选择最优模型方案,进一步降低开发门槛,提升落地效率。

总之,智能体预训练模型选型的核心是“场景与模型的匹配优化”,无需盲目追求大参数量通用模型,也无需过度依赖专用模型的精度优势。结合任务特性、资源约束、业务目标进行分层决策,才能实现智能体技术的高效落地与价值最大化。

- 点赞

- 收藏

- 关注作者

评论(0)