华为CANN自定义算子开发全流程解析 —— 以Add算子为例

华为CANN自定义算子开发全流程解析 —— 以Add算子为例

随着AI算力的快速发展,硬件加速器在深度学习模型的高效执行中扮演着重要角色。华为Ascend系列NPU提供了强大的计算能力,而CANN(Compute Architecture for Neural Networks)则为开发者提供了丰富的算子开发工具和接口。在本文中,我们将通过一个具体示例——Add自定义算子,详细解析Ascend C算子的开发流程,帮助开发者掌握从环境搭建到核函数实现再到验证的一整套流程。

一、Ascend C算子开发概览

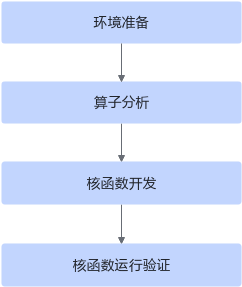

在正式开发之前,我们需要对整个算子开发流程有一个清晰的认知。通常,开发Ascend C算子主要包括三个阶段:

- 算子分析:明确算子的数学表达式、输入输出规格、数据格式及计算逻辑。

- 核函数开发:根据分析结果,在Ascend C上实现算子的具体计算逻辑。

- 运行验证:通过Host端调用核函数,验证算子的计算正确性。

整个流程可以抽象为如下步骤:

- 搭建开发环境并配置CANN软件;

- 对算子进行需求分析,明确输入输出、计算逻辑和核函数参数;

- 实现核函数,包括内存分配、数据搬运、核心计算以及结果搬出;

- 编写Host端程序调用核函数;

- 验证计算结果是否正确。

二、环境准备

在开发之前,必须完成Ascend CANN的环境准备:

2.1 CANN软件安装

开发算子前,需在开发机上安装CANN软件包,并确保安装路径正确。具体安装步骤请参考官方《CANN软件安装指南》。

2.2 环境变量配置

安装完成后,使用CANN运行用户登录环境,执行:

source ${install_path}/set_env.sh

其中${install_path}为CANN的安装路径,例如/usr/local/Ascend/ascend-toolkit。该操作会将CANN相关的编译工具链和运行库加入环境变量。

三、算子分析

以Add算子为例,分析算子实现所需的数学逻辑和数据特性。

3.1 数学表达式与计算逻辑

Add算子功能是对两个张量逐元素相加,其数学表达式为:

[z = x + y]

计算逻辑如下:

- 将输入数据从Global Memory搬运到Local Memory;

- 在Local Memory中进行矢量加法计算;

- 将计算结果搬运回Global Memory。

3.2 输入输出规格

| 类型 | 名称 | Shape | 数据类型 | Format |

|---|---|---|---|---|

| 输入 | x | (8, 2048) | float | ND |

| 输入 | y | (8, 2048) | float | ND |

| 输出 | z | (8, 2048) | float | ND |

3.3 核函数与接口选择

核函数命名为add_custom,接收三个参数x, y, z。实现过程中主要使用以下接口:

- DataCopy:Global Memory与Local Memory的数据搬运;

- Add:矢量加法计算;

- AllocTensor / FreeTensor:内存申请与释放;

- EnQue / DeQue:多核并行队列管理。

四、核函数开发

核函数开发是算子实现的核心。Add算子采用多核并行 + 数据切块流水线策略。

4.1 数据分片与核函数设计

假设使用8个核进行并行计算,总数据量为8 * 2048个元素,每个核处理2048个元素。进一步可将每核内数据切分成小块(tile),支持双缓冲流水计算。

定义数据切分结构体:

struct AddCustomTilingData {

uint32_t totalLength; // 总数据长度

uint32_t tileNum; // 每核数据块数量

};

4.2 核函数实现

核函数使用__global__和__aicore__限定符,表示在设备端AI Core执行:

__global__ __aicore__ void add_custom(GM_ADDR x, GM_ADDR y, GM_ADDR z, AddCustomTilingData tiling) {

KERNEL_TASK_TYPE_DEFAULT(KERNEL_TYPE_AIV_ONLY);

KernelAdd op;

op.Init(x, y, z, tiling.totalLength, tiling.tileNum);

op.Process();

}

GM_ADDR为Global Memory指针类型,定义如下:

#define GM_ADDR __gm__ uint8_t*

4.3 核心算子类

KernelAdd类实现了Init和Process两大核心函数:

class KernelAdd {

public:

__aicore__ inline KernelAdd(){}

__aicore__ inline void Init(GM_ADDR x, GM_ADDR y, GM_ADDR z, uint32_t totalLength, uint32_t tileNum);

__aicore__ inline void Process();

private:

__aicore__ inline void CopyIn(int32_t progress);

__aicore__ inline void Compute(int32_t progress);

__aicore__ inline void CopyOut(int32_t progress);

// 内存和队列管理对象

AscendC::TPipe pipe;

AscendC::TQue<AscendC::TPosition::VECIN, BUFFER_NUM> inQueueX, inQueueY;

AscendC::TQue<AscendC::TPosition::VECOUT, BUFFER_NUM> outQueueZ;

AscendC::GlobalTensor<float> xGm, yGm, zGm;

uint32_t blockLength;

uint32_t tileNum;

uint32_t tileLength;

};

4.4 流水线计算流程

Process函数调用三个流水任务:

__aicore__ inline void Process() {

int32_t loopCount = tileNum * BUFFER_NUM; // 双缓冲

for (int32_t i = 0; i < loopCount; i++) {

CopyIn(i);

Compute(i);

CopyOut(i);

}

}

- CopyIn:将Global Memory数据搬入Local Memory;

- Compute:使用Add接口完成矢量计算;

- CopyOut:将计算结果搬出至Global Memory。

五、Host端运行验证

核函数开发完成后,需要通过Host程序调用并验证计算结果。

5.1 Host端调用示例

std::vector<float> kernel_add(std::vector<float> &x, std::vector<float> &y) {

// 初始化环境、分配Host/Device内存

// 拷贝输入数据到Device

add_custom<<<blockDim, nullptr, stream>>>(xDevice, yDevice, zDevice, tiling);

aclrtSynchronizeStream(stream);

// 拷贝结果回Host

// 释放资源并返回结果

return z;

}

5.2 结果验证

通过比较计算结果与预期值,实现算子验证:

if (std::equal(output.begin(), output.end(), golden.begin())) {

std::cout << "[Success] Verification passed." << std::endl;

} else {

std::cout << "[Failed] Verification failed!" << std::endl;

}

六、编译与运行

6.1 CMake配置

cmake_minimum_required(VERSION 3.16)

find_package(ASC REQUIRED)

project(kernel_samples LANGUAGES ASC CXX)

add_executable(demo add_custom.asc)

target_compile_options(demo PRIVATE $<$<COMPILE_LANGUAGE:ASC>:--npu-arch=dav-2201>)

6.2 编译运行步骤

mkdir -p build && cd build

cmake ..

make -j

./demo

说明:--npu-arch用于指定NPU架构,不同型号NPU对应不同架构版本。

七、总结与扩展

通过本文的Add算子示例,我们完整演示了:

- Ascend C算子分析与设计;

- 核函数的多核并行与流水线实现;

- Host端调用及结果验证。

理解多核并行、数据切块(Tiling)以及流水线编程是高效实现Ascend算子的核心。在熟练掌握这些概念后,开发者可以进一步实现更复杂的自定义算子,如卷积、矩阵乘法等。

Ascend C算子开发不仅是底层优化的实践,更是理解NPU架构与计算模型的重要途径。掌握这一流程,将为深度学习模型在华为Ascend平台上的高效部署奠定坚实基础。

- 点赞

- 收藏

- 关注作者

评论(0)