基于混合深度序列模型的 AI Agent 计算图优化与推理加速方法研究

基于混合深度序列模型的 AI Agent 计算图优化与推理加速方法研究

1. 引言

智能体(AI Agent)在应对复杂任务时,通常需要具备环境感知、自主推理及预测能力。对于金融量化、智能调度、设备运维预警等任务领域,时间序列预测是智能体核心推理模块中的关键能力。

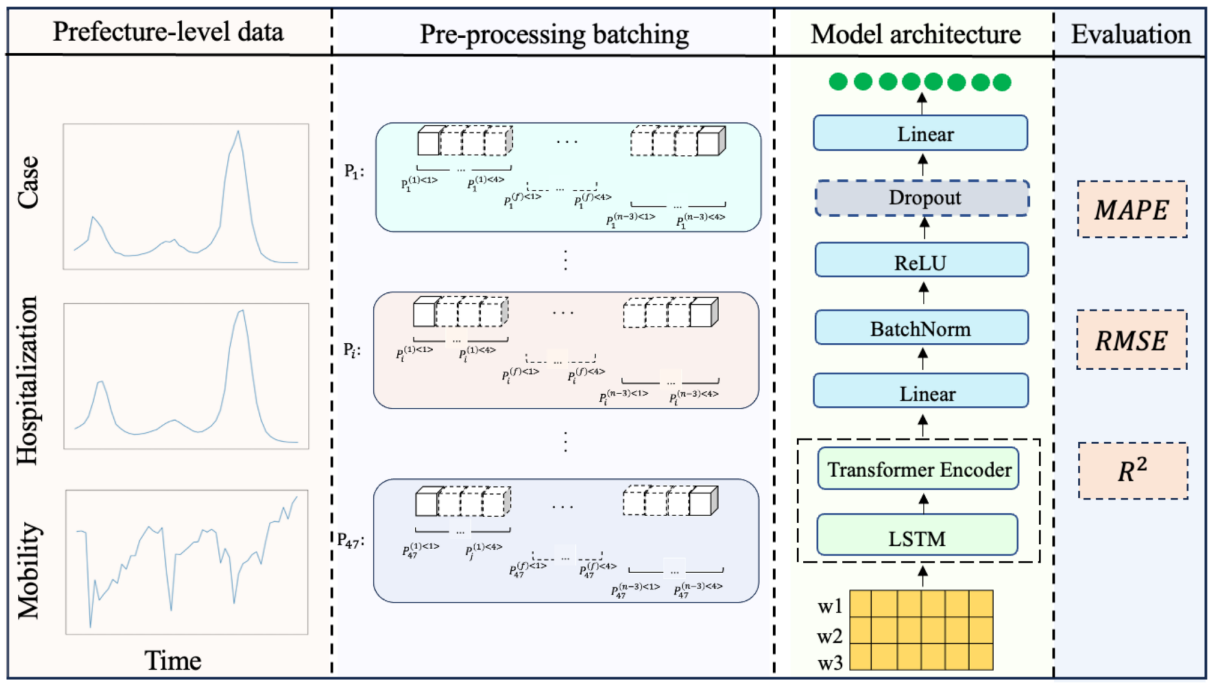

传统的 RNN/LSTM 模型擅长捕捉时间依赖结构,但对长序列能力有限; Transformer 则具备优秀的全局依赖建模能力,却在小规模数据中表现不稳定。因此,将 LSTM 的局部时序优势 与 Transformer 的长期依赖与注意力机制 相结合,可以构造更强鲁棒性与泛化能力的混合预测模块,使 AI Agent 具备真正的数据感知与智能推理能力。

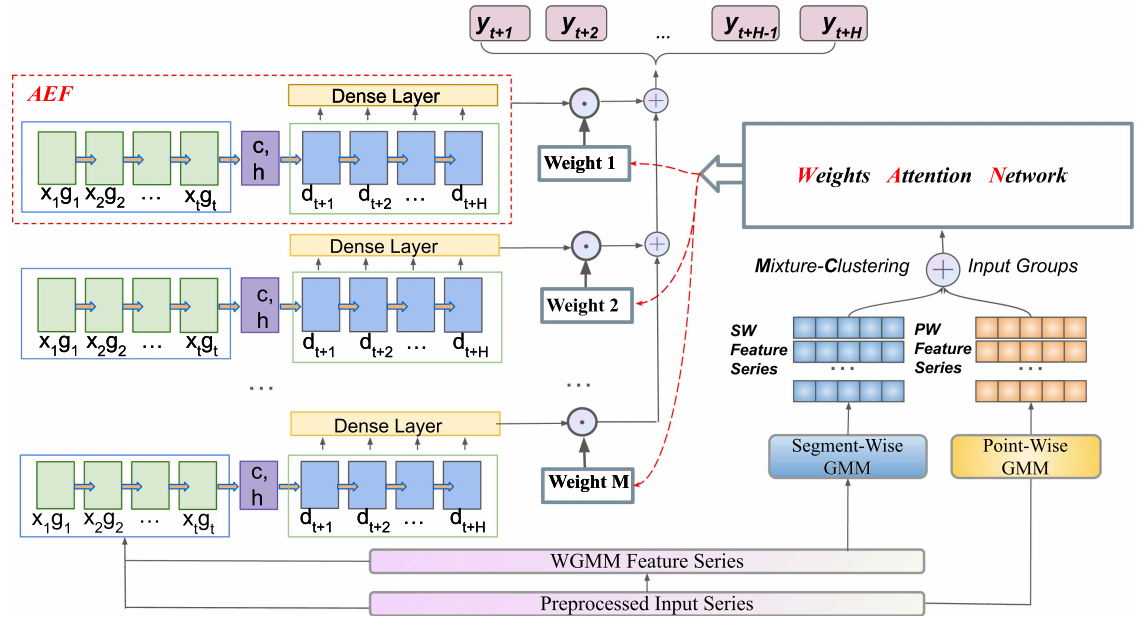

2. 模型设计思路:LSTM + Transformer 的混合结构

混合建模主要目标:

| 模块 | 优势 | 适用作用 |

|---|---|---|

| LSTM | 捕捉连续时间依赖;适用于小数据场景 | 作为前端特征提取器 |

| Transformer Encoder | 学习全局注意力与特征关联 | 作为后端增强预测结构 |

| Linear Regression Layer | 简化输出预测 | 最终预测输出层 |

模型结构示意:

输入序列 -> LSTM -> 中间时间特征 -> Transformer Encoder -> 全局特征 -> 输出预测

3. 环境准备

建议使用 Python + PyTorch

pip install torch numpy matplotlib

4. 代码实战:构建混合时间序列预测模型

4.1 数据构造(模拟时序数据)

import numpy as np

import torch

from torch import nn

import matplotlib.pyplot as plt

# 创建模拟时间序列数据 (sin 曲线 + 噪声)

x = np.linspace(0, 100, 1000)

data = np.sin(x) + np.random.normal(scale=0.1, size=len(x))

def create_dataset(series, input_len=30, pred_len=1):

X, Y = [], []

for i in range(len(series) - input_len - pred_len):

X.append(series[i:i+input_len])

Y.append(series[i+input_len:i+input_len+pred_len])

return np.array(X), np.array(Y)

input_len = 30

pred_len = 1

X, Y = create_dataset(data, input_len, pred_len)

# 转换为 Tensor

X = torch.tensor(X, dtype=torch.float32).unsqueeze(-1)

Y = torch.tensor(Y, dtype=torch.float32)

4.2 创建混合模型 LSTM + Transformer

class HybridLSTMTransformer(nn.Module):

def __init__(self, input_dim=1, hidden_dim=64, num_layers=1, nhead=4, trans_layers=2):

super().__init__()

self.lstm = nn.LSTM(input_dim, hidden_dim, num_layers, batch_first=True)

encoder_layer = nn.TransformerEncoderLayer(d_model=hidden_dim, nhead=nhead, batch_first=True)

self.transformer = nn.TransformerEncoder(encoder_layer, num_layers=trans_layers)

self.fc = nn.Linear(hidden_dim, 1)

def forward(self, x):

lstm_out, _ = self.lstm(x) # [batch, seq, hidden]

trans_out = self.transformer(lstm_out)

out = self.fc(trans_out[:, -1, :]) # 取最后时刻结果

return out

4.3 模型训练

model = HybridLSTMTransformer()

criterion = nn.MSELoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

epochs = 20

for epoch in range(epochs):

model.train()

optimizer.zero_grad()

output = model(X)

loss = criterion(output, Y)

loss.backward()

optimizer.step()

if epoch % 5 == 0:

print(f"Epoch {epoch}/{epochs}, Loss: {loss.item():.6f}")

4.4 模型预测与可视化

model.eval()

preds = model(X).detach().numpy()

plt.plot(Y[:300], label="Real")

plt.plot(preds[:300], label="Prediction")

plt.title("Hybrid Forecast")

plt.legend()

plt.show()

5. 实际部署到 AI Agent 的应用场景

本模块可作为智能体的 “预测 Plug-in”:

| 场景 | 应用方式 | 模块定位 |

|---|---|---|

| 智能电网能耗预测 | 多变量预测 | 预测与策略调度子模块 |

| 金融交易策略 | K线 + 宏观变量建模 | 风控与决策子模块 |

| 工业安全 | 设备传感器异常预警 | 监测与告警模块 |

| 智能运维调度 | CPU/GPU/网络指标预测 | 负载均衡优化决策 |

可结合 Agent 框架(如 LangChain、Autogen、Janus、LazyLLM)进行封装并创建 predict_tool() 工具函数供自主调用。

6. 总结

本文构建了适用于 AI Agent 的 LSTM + Transformer 混合预测模块,能够有效提升小样本与长序列场景下的预测鲁棒性。该结构具有良好的泛化能力,适合作为 AI Agent 的可插拔模块,在决策、控制与风险预判中发挥关键作用。

本文针对 AI Agent 在复杂环境下需要具备的未来趋势判断能力,提出了一种 融合式时间序列预测模块设计方案,将 LSTM 的局部时序建模能力 与 Transformer 的全局依赖特征获取能力 进行结合,从而在小样本、长依赖、多周期波动的预测任务中取得更优表现。同时通过 PyTorch 给出可直接运行的混合模型实现代码,帮助开发者快速构建可扩展的预测模块。

综合来看,该混合结构具有以下优势:

- 兼顾短期与长期依赖,避免 LSTM 的长期衰减与 Transformer 对数据规模的依赖;

- 模型结构通用性强,可轻松嵌入任意 AI Agent 决策系统;

- 适用领域广泛,包括金融量化、设备运维、智能电网、医疗监测及智能运维调度等;

- 可扩展性强,能够与多变量特征融合,并支持与强化学习、AutoML、MLOps 平台结合,实现全流程自治决策。

未来可考虑在以下方向进行升级与迭代:

- 引入 Informer、TimesNet、Mamba、Hybrid CNN 等更先进架构;

- 加入 注意力解释性模块 提升可解释性;

- 与 知识图谱+大模型推理 结合,实现数据驱动 + 知识驱动的混合推理;

- 在 生产环境中加入实时反馈与自适应更新机制,实现端到端闭环智能。

通过以上技术整合,AI Agent 将不仅能够“看见当前”,还能够 预测未来并主动决策,从而迈向真正意义的自主智能体。

- 点赞

- 收藏

- 关注作者

评论(0)