Java 实现延迟追加音频效果,无需 FFmpeg 的纯本地解决方案

Java 实现延迟追加音频效果,无需 FFmpeg 的纯本地解决方案

在音频后期处理中,"延迟"效果是一种常见的音效,广泛应用于语音合成、音轨对齐、背景音乐处理等场景。传统的音频处理工具如 FFmpeg 可以轻松实现这一效果,然而,在一些 Java 项目中,尤其是在需要简化部署、提高性能,或遵守许可协议等情况下,我们可能希望避免依赖外部工具,如 FFmpeg。

本文将介绍如何使用 Java 原生音频 API (javax.sound.sampled) 实现一个延迟音频效果的追加逻辑,完全不依赖任何外部工具,直接生成带延迟的音频文件(WAV 格式)。

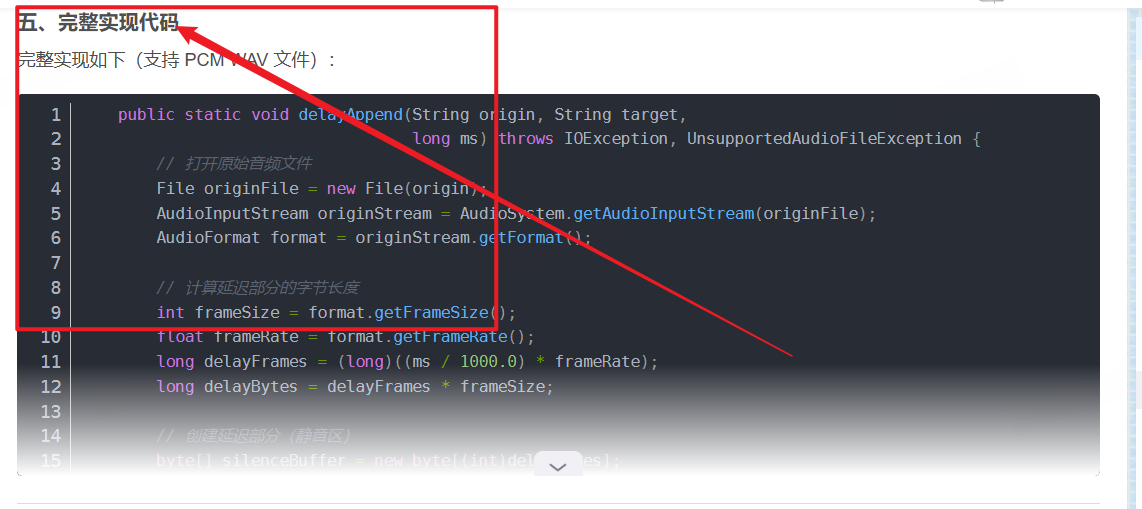

本章完整代码

📦 完整实现代码,之前已经在下面这篇文章内写过了,需要我的完整封装好的代码,可支持下面文章。

(包含完整类定义、异常处理与日志输出逻辑)

到下面文章中获取,亲测完整代码,可运行,目前没有发现bug,运行良好。

https://blog.csdn.net/weixin_52908342/article/details/154388547

一、背景与需求

在音频处理和多音轨合成的过程中,延迟效果是常见需求。例如:

- 语音合成:为语音合成的音频段落添加延迟,实现语音的逐句播放或时间间隔。

- 音轨对齐:在多音轨合成时,根据不同音频段落的节奏和时间,进行延迟处理,使各个音频段落对齐。

- 背景音乐淡入效果:在背景音乐播放时,控制其延迟进入,实现平滑的音频过渡效果。

过去,许多开发者会选择使用 FFmpeg 来实现这种延迟效果,通常通过命令行工具:

ffmpeg -i input.wav -af "adelay=1000|1000" output.wav

然而,这种做法虽然方便,但在某些 Java 应用场景中(如 SaaS 音频服务、Android 应用、桌面端工具等),使用 FFmpeg 会带来一些问题,如部署复杂性、性能瓶颈和许可协议问题。因此,本文将提供一种完全 基于 Java 原生音频 API 的解决方案,避免了对外部依赖的需求。

二、功能目标

我们需要实现的功能是:

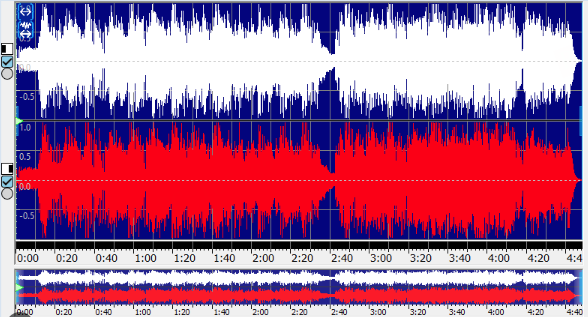

将指定时长的静音区域插入到原始音频文件的前面,从而实现延迟播放效果。

换句话说,原始音频将在延迟后播放,其效果如下所示:

原始音频: |========音频内容========|

延迟后音频: |------静音------|========音频内容========|

功能要求:

- 输入:原始音频文件路径、输出路径、延迟时长(单位:毫秒)

- 输出:新的 WAV 格式音频文件,其中前面增加了指定时长的静音区

三、实现原理

在 Java 中,音频数据流通过 AudioInputStream 进行处理。为实现音频的延迟播放效果,我们的核心步骤如下:

- 读取音频文件:首先读取原始音频文件并获取其格式信息。

- 计算静音区的字节长度:根据用户指定的延迟时间,将延迟时间转换为字节数,生成相应的静音数据。

- 构造静音数据流:通过

ByteArrayInputStream创建静音数据流(字节全为 0),并设置其为音频流格式。 - 拼接音频流:通过

SequenceInputStream将静音音频流与原始音频流拼接,最终生成带有延迟的音频流。 - 输出新音频文件:将拼接后的音频流写入目标文件(WAV 格式)。

整个过程完全在内存中进行,避免了额外的磁盘 I/O 操作,提高了处理速度和效率。

四、设计与实现亮点

1. 动态计算延迟时长

为了实现精确的延迟效果,我们需要根据音频的采样率和帧大小计算出延迟部分的字节长度。通过以下方式,我们能够动态适配不同音频文件:

- 计算延迟帧数:根据延迟时长(毫秒)和音频的帧率,计算出需要延迟的帧数。

- 计算延迟字节数:通过音频的帧大小和延迟帧数,得出静音区需要的字节数。

这种方法确保了无论原始音频的格式如何,延迟的静音区都能够精确匹配音频流的要求。

2. 静音数据流的构造

静音效果实际上就是将所有字节设为零。Java 提供了便捷的方式来构造一个静音数据流,直接用全零的字节填充一个缓冲区,再通过 AudioInputStream 将其转换为音频流。这样,我们就能够将静音区与原始音频拼接在一起,实现延迟效果。

3. 使用 SequenceInputStream 拼接音频流

SequenceInputStream 是 Java 提供的一个非常实用的工具,它允许将多个输入流顺序拼接成一个新的流。在本方案中,我们将静音音频流和原始音频流拼接在一起,生成新的延迟音频流。这个方法简单高效,并且能够灵活应对不同音频文件的拼接需求。

五、应用场景

这种 延迟音频追加 的方法,适用于多种音频处理场景,特别是在语音合成和音频拼接中:

- 语音合成系统:通过在语音段落之间加入延迟,可以控制语音的播放节奏,模拟自然对话中的停顿。

- 音轨对齐:在多音轨合成时,可以对齐不同音轨的播放时间,确保它们在正确的时刻开始播放。

- 背景音乐淡入效果:控制背景音乐在指定时间后才开始播放,实现音频的平滑过渡。

- 多音频片段合并:将多个音频片段按时间顺序拼接,并在每个片段前插入适当的静音,避免音频之间的突兀切换。

六、优点与应用前景

优点

- 纯 Java 实现:完全不依赖 FFmpeg 等外部工具,避免了额外的依赖和部署复杂性。

- 跨平台支持:该方案可以在 Windows、macOS、Linux 等操作系统上无缝运行。

- 内存友好:通过流式处理音频数据,避免了大文件音频的内存消耗,能够高效处理大规模音频文件。

- 可控性强:开发者可以根据具体需求,灵活调整延迟时长和音频格式,进行高度定制。

应用前景

随着语音识别、自然语言处理(NLP)、智能客服等技术的普及,对音频处理的需求日益增多。尤其是在语音合成和音频编辑领域,开发者需要灵活高效的工具来处理音频数据。通过 Java 原生音频 API 实现的延迟效果,不仅提高了系统的性能,还简化了开发流程,广泛适用于各类音频处理应用。

七、总结

通过本文,我们展示了如何仅使用 Java 原生音频 API 实现音频的延迟追加效果。该方案具有高效、跨平台、无外部依赖等优点,适用于各种音频处理应用,如语音合成、多音轨合成、背景音乐淡入等。它为我们在“去 FFmpeg 化”的音频处理方向上,提供了一个高效、简洁的解决方案。

如果你需要更复杂的音频处理功能,可以在此基础上进行扩展,结合 Java 音频 API 实现更多音频效果。

本文介绍了如何使用 Java 原生音频 API 实现音频延迟追加效果,完全摆脱了对 FFmpeg 的依赖。通过计算延迟时长并将静音区域插入到原始音频前,我们可以轻松实现音频的延迟播放效果。整个过程通过 Java 的 javax.sound.sampled 包实现,无需额外的外部工具,简化了部署流程并提高了性能。

这种方案不仅适用于语音合成、音轨对齐、背景音乐淡入等音频处理场景,还具备跨平台支持、内存友好和高效的特点。它适合在 Java 环境下进行音频处理,并能为音频编辑、智能客服、语音识别等领域提供灵活、安全的音频处理能力。

通过本文的示例,开发者可以灵活地将这一延迟追加功能集成到自己的音频处理应用中,进一步拓展 Java 在音频领域的应用潜力。

- 点赞

- 收藏

- 关注作者

评论(0)