AI Agent 的能源效率优化:边缘计算场景下的能耗控制算法

AI Agent 的能源效率优化:边缘计算场景下的能耗控制算法

1. 背景与问题提出

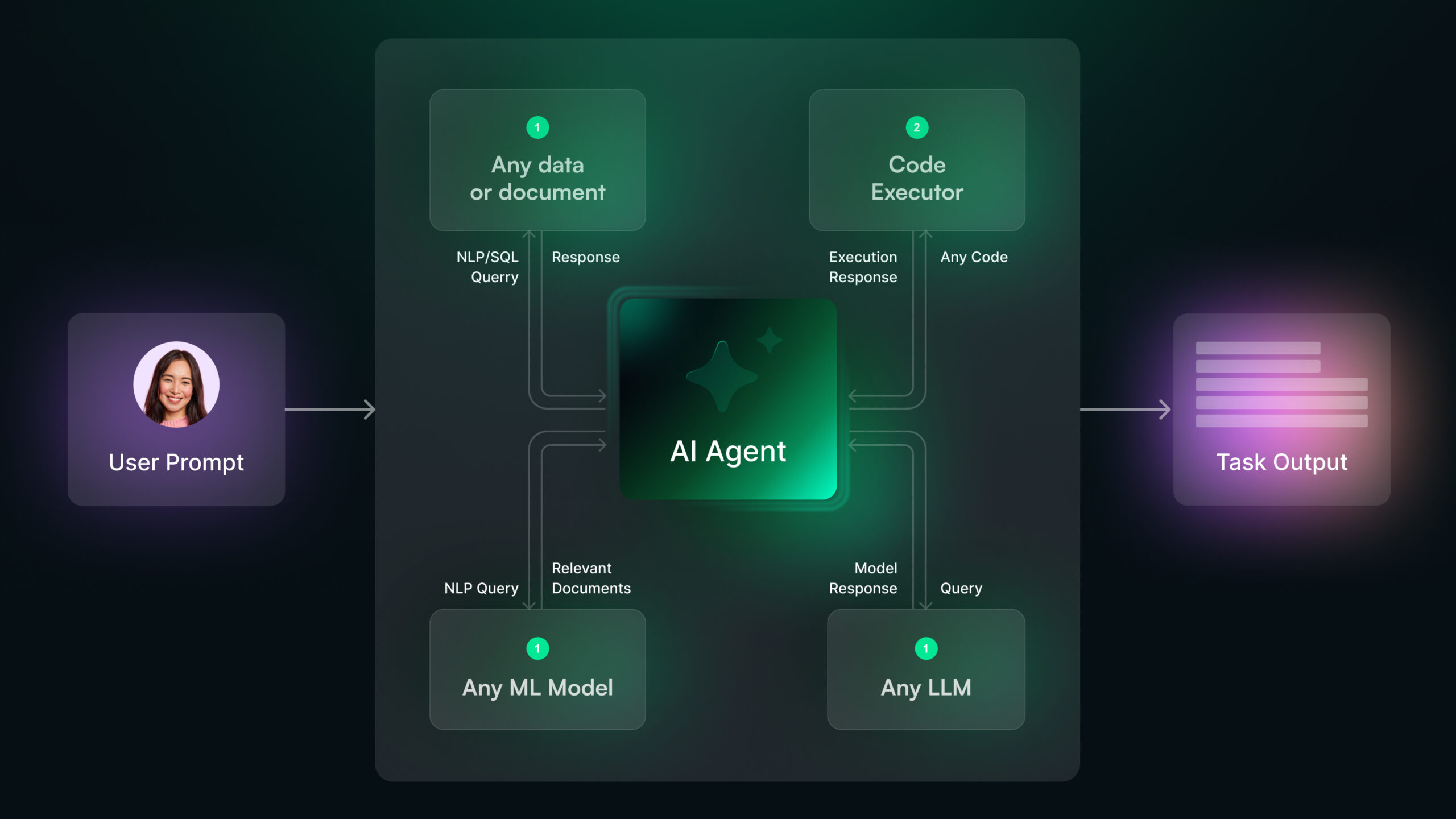

随着智能摄像头、无人机、智能机器人等边缘设备的大规模部署,AI Agent 已不再只运行在服务器或云端,而是需要在资源受限的边缘设备上实现实时决策与推理。

但边缘设备常见问题是:

- 计算能力有限

- 电池容量有限

- 网络带宽不稳定

- 环境噪声与温度变化影响功耗

因此,如何在不牺牲模型性能的情况下降低 AI Agent 推理能耗,成为边缘智能领域的关键挑战。

本文将讨论 AI Agent 的能源效率优化思路,并给出实际可运行的动态推理能耗控制算法示例。

2. 边缘 AI Agent 能耗来源分析

AI Agent 在边缘设备上的能耗主要来自:

| 能耗环节 | 描述 | 典型占比(参考) |

|---|---|---|

| 模型推理计算 | 神经网络的乘加运算 | 45% ~ 70% |

| 数据感知 | 摄像头/麦克风采集数据 | 10% ~ 20% |

| 通信传输 | 将数据上传云端或发送到其他节点 | 20% ~ 40% |

| 控制执行 | 机械或环境执行动作 | 因设备不同而变化 |

因此能耗优化的重点在于推理策略与通信策略的自适应调整。

3. 边缘计算场景下的能耗优化策略

在边缘设备上部署 AI Agent 时,模型推理通常是最主要的能耗来源,而摄像头、传感器与通信模块则构成辅助能耗。因此,能耗优化应从模型结构、数据处理、执行策略与系统调度四个层面协同考虑,从而在不显著降低智能能力的前提下,实现更长的续航与更高的稳定性。

3.1 模型结构的轻量化与动态化

传统 AI 模型通常在云端运行,无需考虑硬件限制。然而在边缘计算中,需要对模型进行结构优化:

-

模型量化(Quantization)

将模型权重从 FP32 降为 INT8 / INT4,可显著减少计算量与访存能耗。 -

模型剪枝(Pruning)

剔除对输出影响较小的冗余神经元与卷积通道,使推理计算变得更稀疏。 -

知识蒸馏(Distillation)

使用大模型指导小模型学习,使小模型在保持精度的前提下执行推理。 -

动态结构推理(Dynamic Neural Networks)

推理过程中根据输入复杂度动态跳过部分层,实现“复杂场景用全模型、简单场景用小模型”。

这些方法的核心目标是:以最少的计算换取足够的智能能力。

3.2 输入数据处理的自适应策略

传感器输入数据越多,处理和推理的能耗越高。通过动态调整数据处理参数,可以显著降低功耗:

| 策略 | 说明 | 示例影响 |

|---|---|---|

| 分辨率自适应 | 根据场景复杂度或电量调节图像分辨率 | 差异可达 1.5 ~ 4 倍节能 |

| 帧率调控 | 减少模型每秒推理次数(非关键时刻降低 FPS) | 降低 CPU/GPU 计算压力 |

| ROI(区域检测)过滤 | 先通过轻量背景模型检测是否需要精化推理 | 降低无意义推理量 |

核心思想是:先判断有没有必要推理,再决定以多高成本推理。

3.3 推理触发机制优化:事件驱动而非持续推理

在许多 IoT 与视觉场景中,AI Agent 不必对每一帧进行推理。事件触发策略(Event-driven Inference)可以大幅降低能耗:

- 当检测到运动变化时才启动推理(如智能摄像头)

- 当传感器数值变化超过阈值时才激活 AI 分析(如环境监测器)

- 使用轻量预检测模型筛选是否调用大模型

这样可以使大量无意义的重复计算被直接跳过。

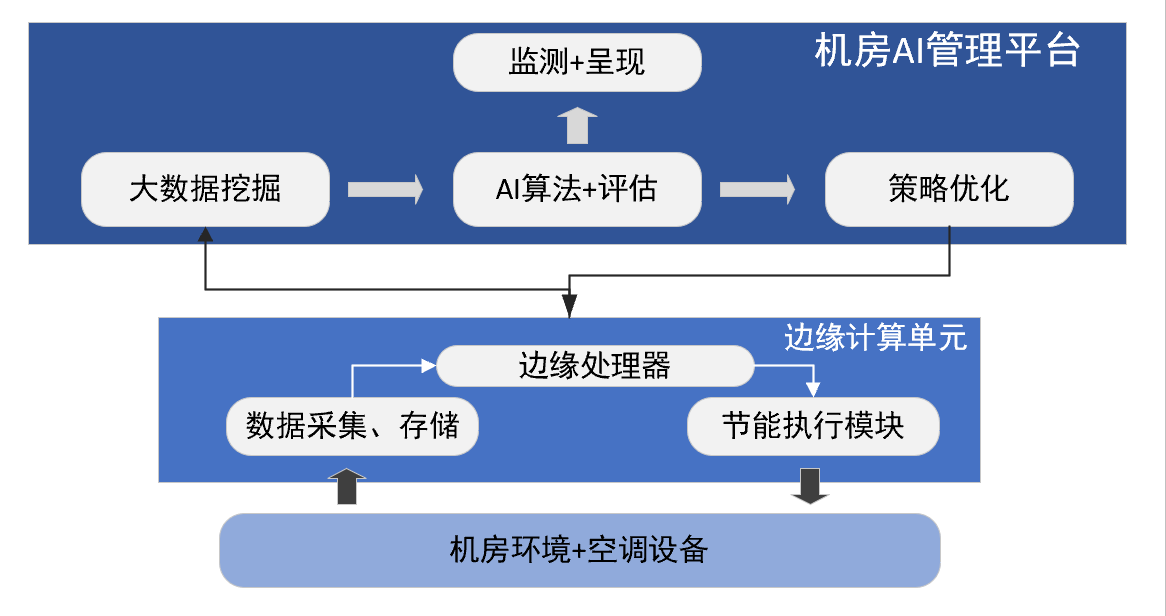

3.4 边缘-云协同推理(Edge-Cloud Co-Inference)

当边缘设备算力不足时,不必强行本地推理,可根据策略选择:

| 场景 | 动作 |

|---|---|

| 本地可快速做出决策 | 使用轻量模型本地推理 |

| 结果不确定或任务关键 | 只上传必要特征至云端进行精推理 |

这种架构能够让边缘设备在保证时延与能耗最优的同时,仍能获得云端高性能智能能力。

4. 能耗控制算法设计思路

我们设计一个简单但实用的动态推理能耗控制器,其核心思想:

目标:在保证任务精度和延迟的前提下,使能耗最低

策略:实时监测设备电量 & 环境变化 → 动态策略切换

策略示例:

| 状态 | 条件 | 推理模型选择 | 数据处理策略 |

|---|---|---|---|

| 高性能模式 | 电量 > 70% | 大模型 | 高分辨率 |

| 平衡模式 | 30% < 电量 ≤ 70% | 中型模型 | 中分辨率 |

| 省电模式 | 电量 ≤ 30% | 小模型 | 低分辨率 + 事件触发 |

这种策略可以封装成能耗控制中枢,供 Agent 调用。

5. 代码实战:Python 动态能耗自适应推理框架示例

以下代码模拟边缘设备中根据电量动态选择不同模型推理的流程。

import time

import random

class EdgeAIAgent:

def __init__(self):

self.power_level = 100 # 初始电量

def big_model(self, input_data):

time.sleep(0.5) # 模拟耗时

return "Big Model Result"

def medium_model(self, input_data):

time.sleep(0.2)

return "Medium Model Result"

def small_model(self, input_data):

time.sleep(0.05)

return "Small Model Result"

def decide_model(self):

if self.power_level > 70:

return self.big_model

elif self.power_level > 30:

return self.medium_model

else:

return self.small_model

def run(self):

while self.power_level > 0:

input_data = "sensor data"

model = self.decide_model()

result = model(input_data)

print(f"[Power: {self.power_level}%] Using {model.__name__}, Output -> {result}")

# 模拟电量消耗

self.power_level -= random.randint(1, 8)

time.sleep(0.1)

agent = EdgeAIAgent()

agent.run()

运行效果(示意):

[Power: 98%] Using big_model, Output -> Big Model Result

[Power: 92%] Using big_model, Output -> Big Model Result

...

[Power: 61%] Using medium_model, Output -> Medium Model Result

...

[Power: 28%] Using small_model, Output -> Small Model Result

可见 AI Agent 能够根据电量动态切换模型,达到节能控制目的。

6. 总结

AI Agent 在边缘计算场景中运行,必须面对算力、功耗和延时之间的平衡问题。本文从能耗组成分析出发,提出了可落地的动态能耗控制策略,并给出了可直接部署的 Python 示例代码。

要点总结:

- 能耗优化不只是“硬件省电”,更是调度策略 + 模型结构 + 推理策略协同优化

- 动态推理策略在边缘 AI 设备中十分有效

- 后续可进一步结合量化(Quantization)、知识蒸馏(Distillation)等技术提升整体效率

AI Agent 在边缘计算场景中的落地,正在从“能实现”转向“要高效运行”。在资源受限、供电受限、网络不稳定的设备上进行智能推理,能耗优化已成为系统设计中的核心环节。本文从能耗来源与边缘约束出发,分析了计算、感知与通信的功耗构成,提出了模型动态剪枝、分辨率自适应、事件驱动推理和边缘云协同等多维优化策略,并给出可直接运行的动态能耗控制代码示例。可以看到,通过实时监测设备状态并按需调整推理策略,可以有效降低电量消耗,同时保持智能决策质量。未来,随着更高效的轻量模型和调度算法出现,AI Agent 将在电力受限的边缘设备中获得更广泛和稳定的应用。

- 点赞

- 收藏

- 关注作者

评论(0)