多 Agent 分布式训练中的参数同步与通信优化策略研究

多 Agent 分布式训练中的参数同步与通信优化策略研究

在深度学习和强化学习领域,单机训练往往受限于显存和计算资源,多 Agent 分布式训练成为提高训练效率和扩展模型规模的重要手段。然而,多 Agent 系统中参数同步和通信开销是性能瓶颈。本文将详细解析多 Agent 分布式训练框架中的关键技术,并提供优化策略和实战代码示例。

1. 多 Agent 分布式训练概述

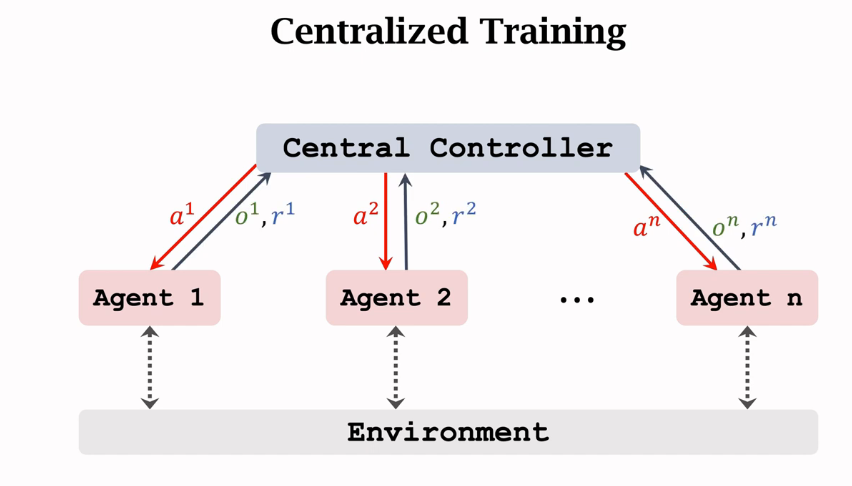

多 Agent 分布式训练指的是在多个计算节点(或 GPU)上,同时训练同一个模型或相关模型,每个 Agent 拥有自己的数据子集和计算资源,通过参数同步或梯度传递实现模型一致性。主要优势包括:

- 训练加速:多个 Agent 并行计算梯度,提高训练吞吐量。

- 数据并行:每个 Agent 使用不同的数据子集,实现大规模数据训练。

- 模型扩展性:支持大模型训练,突破单机显存限制。

然而,分布式训练的核心挑战在于 参数同步与通信开销。

2. 参数同步机制

在多 Agent 系统中,参数同步主要有两种方式:

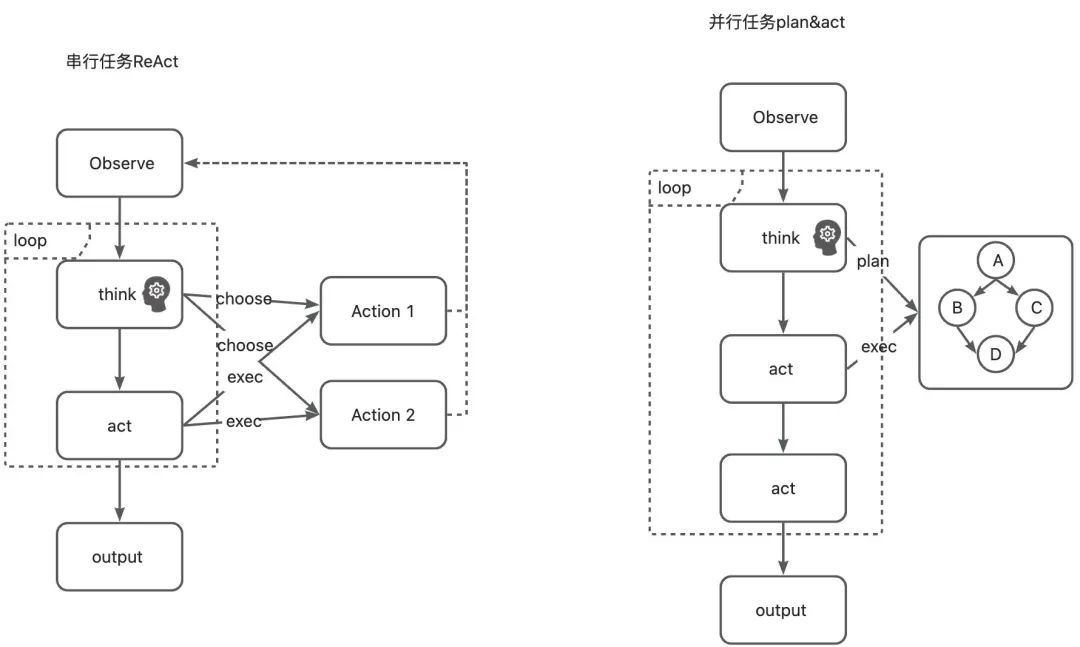

2.1 同步更新(Synchronous Update)

所有 Agent 在计算完梯度后,等待其他节点完成计算,再统一更新模型参数。

优点:模型一致性高;

缺点:慢节点会拖慢整体训练速度。

2.2 异步更新(Asynchronous Update)

Agent 在计算完梯度后立即更新参数,不等待其他节点。

优点:利用率高,训练速度快;

缺点:可能存在参数“延迟”,导致收敛波动。

3. 通信开销优化策略

通信是分布式训练的性能瓶颈。常用优化策略包括:

3.1 梯度压缩(Gradient Compression)

- 量化:将梯度从 32 位浮点数压缩为 8 位或 16 位。

- 稀疏化:只传递梯度中较大值,忽略小梯度。

3.2 参数分块传输(Chunked Transfer)

将模型参数拆分为小块分批传输,避免一次性发送大数据包引起的网络拥堵。

3.3 延迟同步(Delayed Sync)

非关键参数可以延迟同步,降低通信频率,提高训练吞吐量。

4. 代码实战:PyTorch 多 Agent 分布式训练示例

下面演示一个 基于 PyTorch 分布式数据并行(DDP)的多 Agent 训练示例,并实现梯度压缩策略来优化通信开销。

import torch

import torch.nn as nn

import torch.optim as optim

import torch.distributed as dist

from torch.nn.parallel import DistributedDataParallel as DDP

from torch.utils.data import DataLoader, TensorDataset

import os

# -------------------------------

# 初始化分布式环境

# -------------------------------

def setup(rank, world_size):

os.environ['MASTER_ADDR'] = 'localhost'

os.environ['MASTER_PORT'] = '12355'

dist.init_process_group("gloo", rank=rank, world_size=world_size)

# -------------------------------

# 简单模型定义

# -------------------------------

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc1 = nn.Linear(10, 64)

self.relu = nn.ReLU()

self.fc2 = nn.Linear(64, 1)

def forward(self, x):

return self.fc2(self.relu(self.fc1(x)))

# -------------------------------

# 梯度压缩函数

# -------------------------------

def compress_gradients(model, k=0.5):

"""

保留前 k% 的梯度

"""

for param in model.parameters():

if param.grad is not None:

grad = param.grad.data

threshold = torch.quantile(torch.abs(grad), 1-k)

mask = torch.abs(grad) < threshold

grad[mask] = 0.0

# -------------------------------

# 分布式训练函数

# -------------------------------

def train(rank, world_size, epochs=5):

print(f"Running on rank {rank}.")

setup(rank, world_size)

# 数据准备

x = torch.randn(1000, 10)

y = torch.randn(1000, 1)

dataset = TensorDataset(x, y)

sampler = torch.utils.data.distributed.DistributedSampler(dataset, num_replicas=world_size, rank=rank)

loader = DataLoader(dataset, batch_size=32, sampler=sampler)

# 模型与优化器

model = SimpleNet().to(rank)

ddp_model = DDP(model, device_ids=None)

optimizer = optim.Adam(ddp_model.parameters(), lr=0.001)

loss_fn = nn.MSELoss()

for epoch in range(epochs):

for xb, yb in loader:

optimizer.zero_grad()

pred = ddp_model(xb)

loss = loss_fn(pred, yb)

loss.backward()

# 梯度压缩

compress_gradients(ddp_model, k=0.5)

optimizer.step()

print(f"Rank {rank}, Epoch {epoch}, Loss: {loss.item()}")

dist.destroy_process_group()

# -------------------------------

# 启动多进程训练

# -------------------------------

if __name__ == "__main__":

from torch.multiprocessing import spawn

world_size = 2

spawn(train, args=(world_size,), nprocs=world_size, join=True)

说明

- 使用

DistributedDataParallel自动处理参数同步。 compress_gradients函数实现了梯度稀疏化策略,降低通信数据量。- 多进程模拟了 2 个 Agent,并行训练同一模型。

5. 总结

多 Agent 分布式训练能够显著提升模型训练效率,但参数同步和通信开销是关键瓶颈。本文介绍了同步/异步更新机制,并给出梯度压缩等通信优化策略。通过 PyTorch DDP 示例代码,演示了如何在实践中实现多 Agent 分布式训练和通信优化。

未来可进一步探索:

- 更高效的压缩算法,如 Top-K+量化混合策略。

- 异步参数服务器架构,提升大规模分布式训练性能。

- 跨节点多机训练优化,结合高速网络(InfiniBand)进一步降低通信延迟。

- 点赞

- 收藏

- 关注作者

评论(0)