强化学习驱动的自主决策系统在动态环境中的自适应能力研究

一、引言

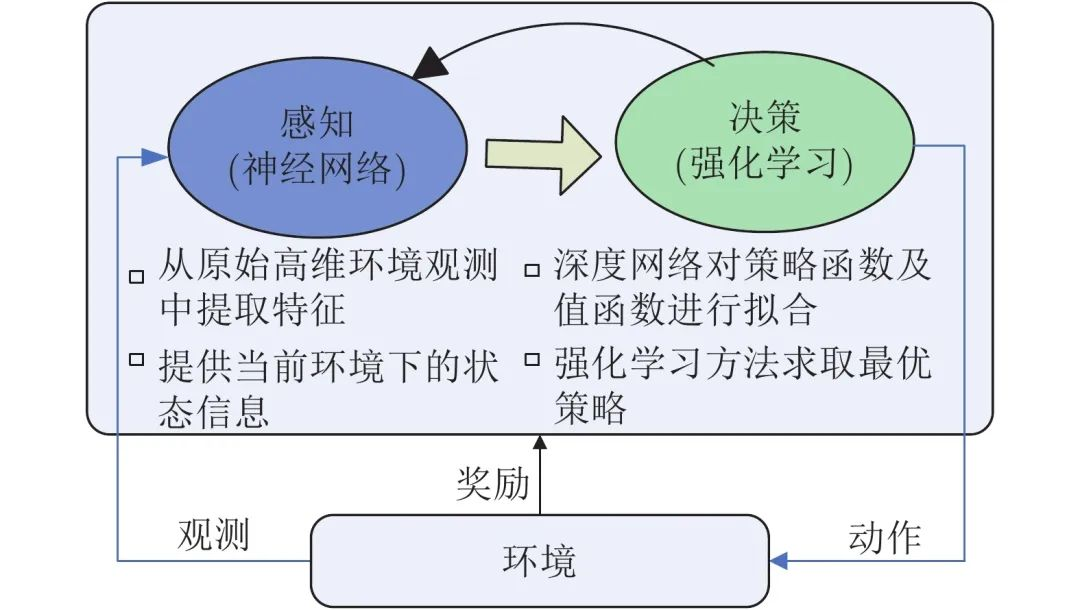

在人工智能的众多分支中,强化学习(Reinforcement Learning, RL) 被视为实现智能体(Agent)自主学习与决策的关键技术。与监督学习不同,强化学习不依赖固定标签,而是通过环境交互和奖励反馈进行策略优化,使智能体逐步学会“如何行动得更好”。

从自动驾驶车辆到股票交易、从机器人控制到游戏智能体,强化学习的应用边界正在不断扩大。本文将系统讲解强化学习驱动的智能体决策系统的核心思想,并以一个代码实战示例展示如何构建一个能够自主学习最优策略的Agent。

二、强化学习的核心机制

强化学习系统通常由以下四个核心元素组成:

| 组件 | 含义 | 示例 |

|---|---|---|

| Agent(智能体) | 执行动作、接收反馈、优化策略的主体 | 自动驾驶系统 |

| Environment(环境) | 智能体交互的外部系统,提供状态和奖励 | 道路与交通系统 |

| Action(动作) | Agent能执行的操作集合 | 加速、刹车、转向 |

| Reward(奖励) | 环境反馈的信号,用于衡量动作好坏 | 行驶安全、能耗效率 |

强化学习的目标是最大化长期累积奖励(Return):

其中,(\gamma)为折扣因子,控制智能体对未来奖励的重视程度。

三、Q-Learning:最经典的强化学习算法

Q-Learning是强化学习中最早被广泛应用的离线值迭代算法。它通过学习状态-动作值函数(Q函数)来近似最优策略。

其中:

- (s, a):当前状态与动作;

- ®:环境奖励;

- (s’):执行动作后的新状态;

- (\alpha):学习率;

- (\gamma):折扣因子。

四、代码实战:智能体在网格世界中寻找最优路径

下面我们通过一个简单的GridWorld(网格世界) 环境来演示强化学习智能体的训练过程。

目标:智能体从起点出发,避开陷阱,最终到达终点。

1. 环境构建

import numpy as np

import random

class GridWorld:

def __init__(self, size=5):

self.size = size

self.start = (0, 0)

self.goal = (size-1, size-1)

self.traps = [(1, 3), (3, 2)]

self.reset()

def reset(self):

self.agent_pos = self.start

return self.agent_pos

def step(self, action):

x, y = self.agent_pos

if action == 0: x -= 1 # 上

elif action == 1: x += 1 # 下

elif action == 2: y -= 1 # 左

elif action == 3: y += 1 # 右

# 边界限制

x = np.clip(x, 0, self.size - 1)

y = np.clip(y, 0, self.size - 1)

self.agent_pos = (x, y)

# 奖励机制

if self.agent_pos == self.goal:

return self.agent_pos, 10, True

elif self.agent_pos in self.traps:

return self.agent_pos, -10, True

else:

return self.agent_pos, -1, False

2. Q-Learning智能体设计

class QLearningAgent:

def __init__(self, state_size, action_size, alpha=0.1, gamma=0.9, epsilon=0.1):

self.q_table = np.zeros((state_size, state_size, action_size))

self.alpha = alpha

self.gamma = gamma

self.epsilon = epsilon

def choose_action(self, state):

if random.random() < self.epsilon:

return random.randint(0, 3)

else:

return np.argmax(self.q_table[state[0], state[1]])

def learn(self, state, action, reward, next_state, done):

predict = self.q_table[state[0], state[1], action]

target = reward + self.gamma * np.max(self.q_table[next_state[0], next_state[1]]) * (1 - done)

self.q_table[state[0], state[1], action] += self.alpha * (target - predict)

3. 训练智能体

env = GridWorld()

agent = QLearningAgent(state_size=5, action_size=4)

for episode in range(300):

state = env.reset()

total_reward = 0

done = False

while not done:

action = agent.choose_action(state)

next_state, reward, done = env.step(action)

agent.learn(state, action, reward, next_state, done)

state = next_state

total_reward += reward

if episode % 50 == 0:

print(f"Episode {episode}, Total Reward: {total_reward}")

4. 测试智能体的学习效果

state = env.reset()

done = False

path = [state]

while not done:

action = np.argmax(agent.q_table[state[0], state[1]])

next_state, reward, done = env.step(action)

path.append(next_state)

state = next_state

print("智能体路径:", path)

输出示例:

智能体路径: [(0, 0), (0, 1), (1, 1), (2, 1), (3, 1), (4, 1), (4, 2), (4, 3), (4, 4)]

说明智能体成功避开陷阱并抵达目标!

五、扩展:从Q-Learning到Deep Q-Network(DQN)

在复杂状态空间(如图像输入或高维环境)下,传统Q表难以存储所有状态。此时我们使用神经网络近似Q函数,即DQN算法。

DQN使用**卷积神经网络(CNN)或多层感知机(MLP)**对Q值进行估计,通过经验回放和目标网络稳定训练过程,是强化学习在复杂场景(如Atari游戏、自动驾驶)中的核心算法。

简化的DQN结构如下:

import torch

import torch.nn as nn

import torch.optim as optim

class DQN(nn.Module):

def __init__(self, state_dim, action_dim):

super(DQN, self).__init__()

self.net = nn.Sequential(

nn.Linear(state_dim, 128),

nn.ReLU(),

nn.Linear(128, action_dim)

)

def forward(self, x):

return self.net(x)

六、总结与展望

本文从理论到实战全面介绍了强化学习驱动的智能体决策系统,包括Q-Learning算法的数学原理、代码实现及其在网格世界任务中的表现。

未来的发展方向主要包括:

- 多智能体强化学习(MARL):智能体间的协作与竞争;

- 模型驱动强化学习(Model-Based RL):构建环境模型加速学习;

- 层次化决策(Hierarchical RL):分层策略提升复杂任务性能;

- 结合大模型(LLM+RLHF):通过人类反馈强化语言与决策能力。

强化学习正从“玩游戏的AI”逐步走向“自主决策的智能体”,其在自动驾驶、机器人、金融决策、能源调度等领域的潜力仍在持续释放。

- 点赞

- 收藏

- 关注作者

评论(0)