具备反思与修正能力的AI Agent:基于ReAct循环的规划优化研究

具备反思与修正能力的AI Agent:基于ReAct循环的规划优化研究

一、引言

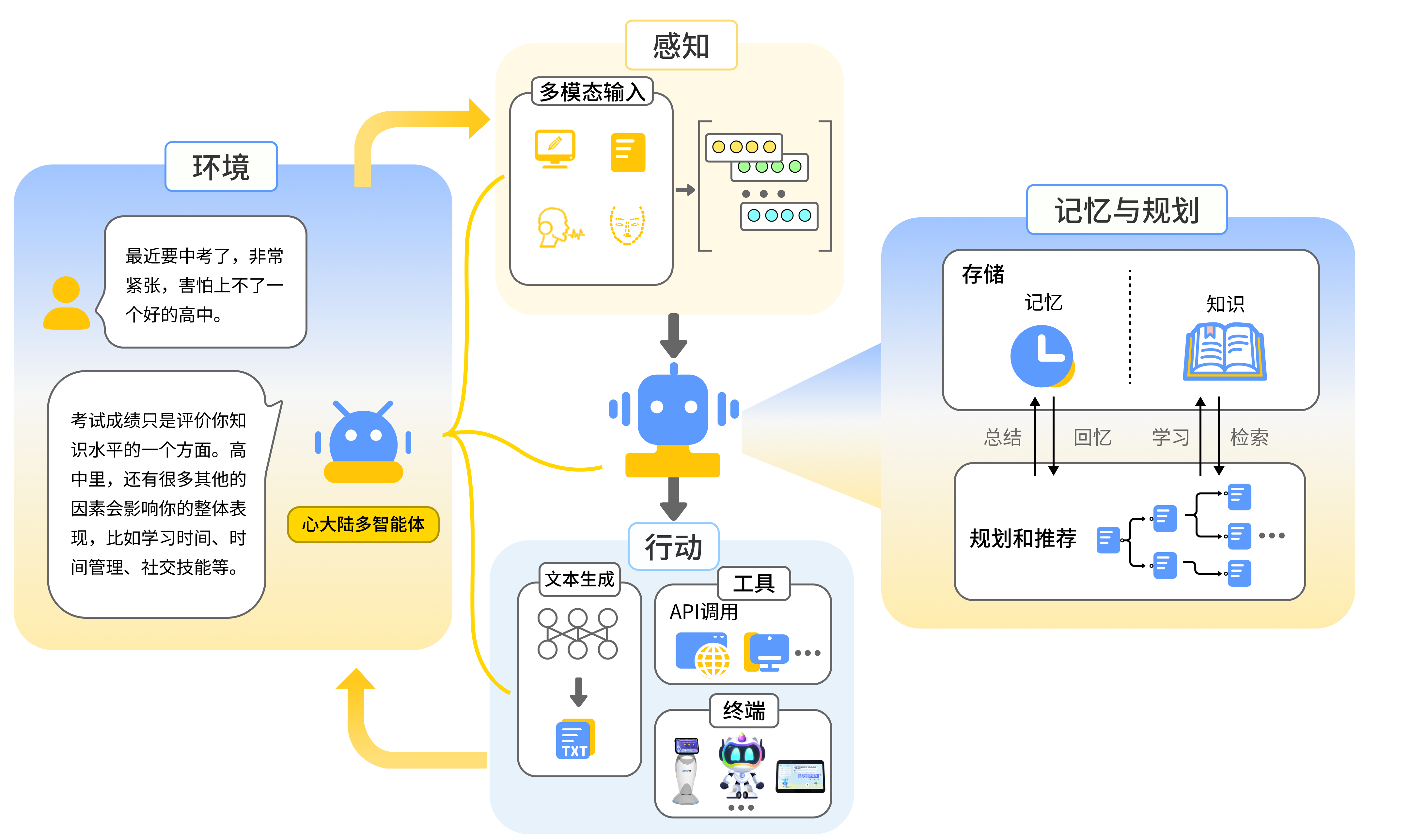

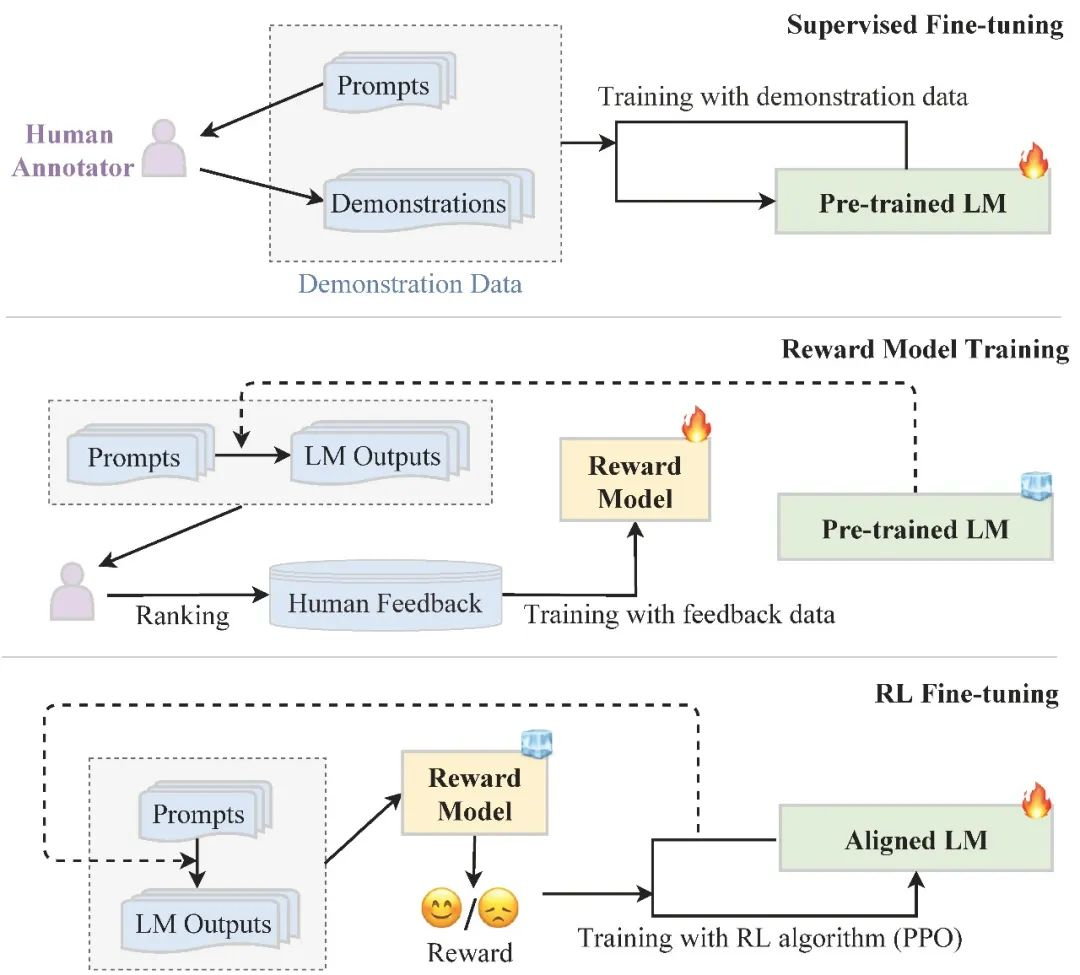

随着大型语言模型(LLM, Large Language Model)的飞速发展,AI 不再仅仅是被动响应的工具,而逐渐演化为具备推理、规划与行动能力的智能体(Agent)。

在这一过程中,AI 不仅理解 Prompt(提示词)的语义,更能够将自然语言转化为可执行计划(Plan),再通过工具调用(Tool Use)与环境交互完成复杂任务。

本文将从理论与实践两个层面,解析 AI Agent 的推理与规划机制,并通过 Python + LangChain 的代码实战,展示从「Prompt → Plan → Action」的完整智能决策流程。

二、Agent推理与规划的核心思想

一个智能体的运行过程通常分为三层:

| 层次 | 描述 | 示例 |

|---|---|---|

| Prompt层 | 接受自然语言输入 | “帮我查一下今天东京的天气,然后发封邮件告诉我” |

| Reasoning层 | 基于上下文与世界知识推理意图 | 天气 → 天气API;发邮件 → 邮件工具 |

| Planning层 | 拆解任务并生成执行计划 | Step1: 调用天气接口;Step2: 生成邮件内容;Step3: 调用邮件发送接口 |

| Action层 | 执行计划并产出结果 | 返回“邮件已发送:今日东京晴天 25°C” |

这种「从语言到行动」的机制,使得 AI 具备了类人思维的连续性:它不仅能理解问题,还能计划与执行。

三、AI Agent的推理流程

从架构上看,现代 AI Agent 的推理流程大致如下:

User Prompt → LLM Reasoning → Task Planning → Tool Selection → Execution → Feedback

例如,当用户输入:

“分析这份CSV文件,并生成一份数据报告。”

Agent 的内部推理大致为:

- 理解语义:识别任务目标(分析 + 生成报告)

- 分解任务:解析为两个步骤(读取CSV → 分析数据 → 输出报告)

- 选择工具:决定调用

pandas、matplotlib等库 - 生成代码:自动编写执行逻辑

- 执行与反馈:运行代码并生成结果报告

四、实战:从Prompt到Plan的LangChain智能体示例

我们使用 LangChain 框架来搭建一个具备推理与规划能力的智能体。

目标任务:

“帮我读取一个CSV文件,分析平均值,并生成自然语言总结。”

1. 环境准备

pip install langchain openai pandas

2. 导入依赖

from langchain.agents import initialize_agent, Tool

from langchain.tools.python.tool import PythonREPLTool

from langchain.llms import OpenAI

import pandas as pd

3. 构建工具集

Agent 需要具备外部工具来实现计划执行,这里定义两个核心工具:

# 读取CSV文件工具

def read_csv_tool(file_path: str):

df = pd.read_csv(file_path)

return f"成功读取文件,共 {len(df)} 行数据。列名:{list(df.columns)}"

# 计算平均值工具

def mean_analysis_tool(file_path: str, column: str):

df = pd.read_csv(file_path)

mean_value = df[column].mean()

return f"列 {column} 的平均值为 {mean_value:.2f}"

4. 定义Agent工具列表

tools = [

Tool(name="read_csv", func=read_csv_tool, description="用于读取CSV文件内容"),

Tool(name="mean_analysis", func=mean_analysis_tool, description="计算指定列的平均值"),

PythonREPLTool() # 提供Python执行能力

]

5. 初始化Agent

llm = OpenAI(temperature=0.3)

agent = initialize_agent(

tools=tools,

llm=llm,

agent_type="zero-shot-react-description",

verbose=True

)

6. 执行Prompt

prompt = "请读取 sample.csv 文件,计算 salary 列的平均值,并生成一段自然语言总结报告。"

result = agent.run(prompt)

print(result)

执行结果示例:

成功读取文件,共 100 行数据。列名:['name', 'age', 'salary']

列 salary 的平均值为 5843.27

报告:经过分析,该CSV文件中共有100位员工,平均工资为5843.27元,整体薪资水平较为稳定。

这正是一个典型的「从Prompt到Plan」的过程:

- LLM 理解任务 →

- 拆分任务 →

- 调用工具执行 →

- 输出总结。

五、核心机制分析

-

推理 (Reasoning):

LLM 通过上下文与语义理解,推断任务的意图与执行步骤。 -

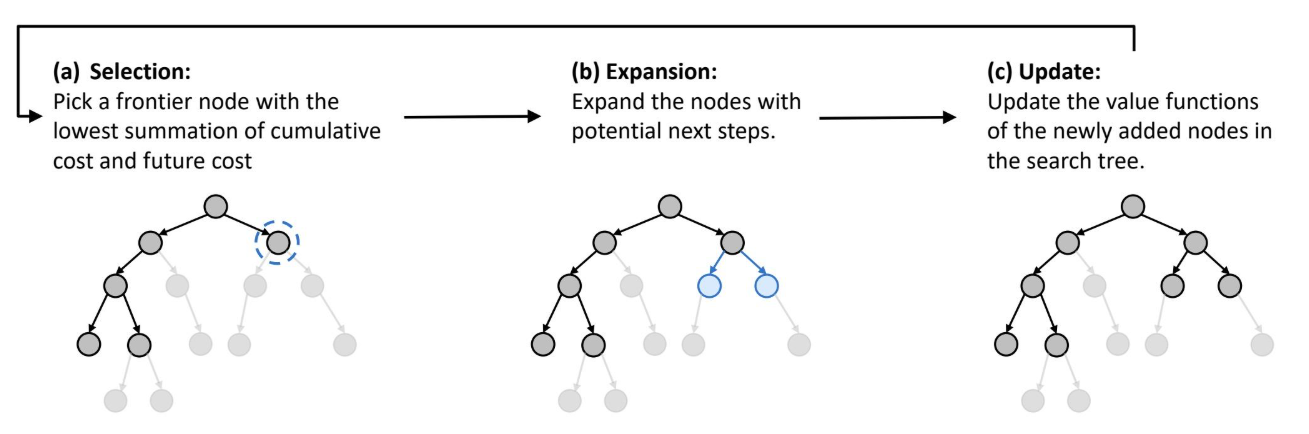

规划 (Planning):

基于工具描述(Tool Descriptions),模型生成有序的执行计划。 -

行动 (Action):

Agent 调用外部工具执行任务,验证结果并返回。

这种架构体现出「语言即逻辑,逻辑即行动」的理念,使 AI 不仅能对话,更能真正解决问题。

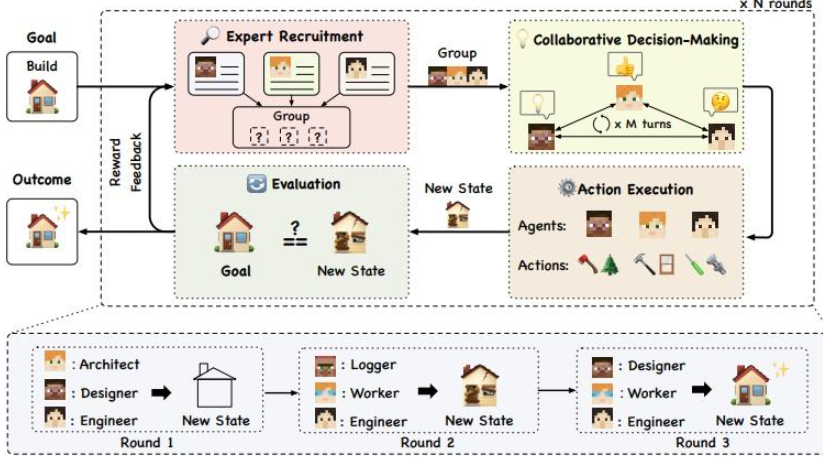

六、进阶:让Agent具备循环自我反思

在复杂任务中,Agent 可能会出错。为了让其具备“自我纠正”能力,可以加入ReAct (Reason + Act) 循环:

from langchain.agents import AgentType

agent = initialize_agent(

tools=tools,

llm=llm,

agent_type=AgentType.REACT_DOCSTORE,

verbose=True

)

这种机制允许 Agent 在每次行动后反思结果是否正确,若失败,则自动调整策略再执行,从而实现更接近人类的「思考—执行—修正」循环。

七、总结与展望

本文展示了从 Prompt 到 Plan 的 AI Agent 推理与规划机制。核心要点包括:

- Prompt理解 → 意图识别 → 任务规划 → 工具调用 → 结果生成

- LangChain 框架让 LLM 具备外部执行与自我决策能力

- 通过 ReAct 机制,Agent 能实现「自我反思」与动态修正

未来,AI Agent 将不仅是语言对话者,更是具备目标导向与世界交互能力的智能执行者。

这意味着,AI 正在从“回答问题”走向“自主行动”,从「Prompt」真正迈向「Plan」。

- 点赞

- 收藏

- 关注作者

评论(0)