AI Agent的智能对话能力-长期记忆与上下文管理的结合

AI Agent的长期记忆机制与上下文管理

随着人工智能技术的不断发展,AI Agent(智能体)在执行任务时越来越依赖于复杂的长期记忆机制与上下文管理系统。长期记忆机制能够让智能体在与用户的互动中“记住”重要信息,从而提升其对话质量和任务完成效率。在此基础上,如何高效管理上下文成为AI Agent成功实现高效交互的关键。本文将深入探讨AI Agent的长期记忆机制、上下文管理方法,并通过代码实例展示如何实现这些技术。

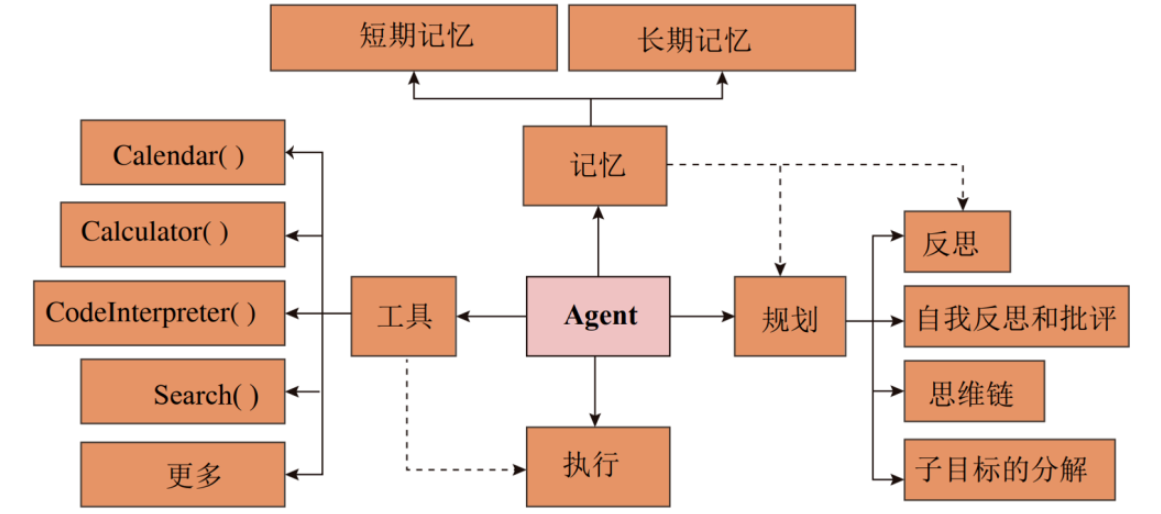

一、长期记忆机制

长期记忆(Long-Term Memory, LTM)是指智能体能够持续存储并访问的信息。在许多应用场景中,AI Agent需要记住过去的对话、用户的偏好、任务进度等,这些信息会帮助智能体做出更为智能和个性化的响应。

1.1 长期记忆的作用

在AI系统中,长期记忆的核心作用在于:

- 提升智能体的对话能力:记住用户的历史行为、偏好或需求,能够让智能体在后续对话中进行个性化响应。

- 知识积累与推理能力:长期记忆允许智能体将新获取的信息持续更新,并结合已有知识进行推理与决策。

- 支持多轮交互:通过记忆管理,AI Agent能够处理跨轮次的对话,确保上下文的连贯性。

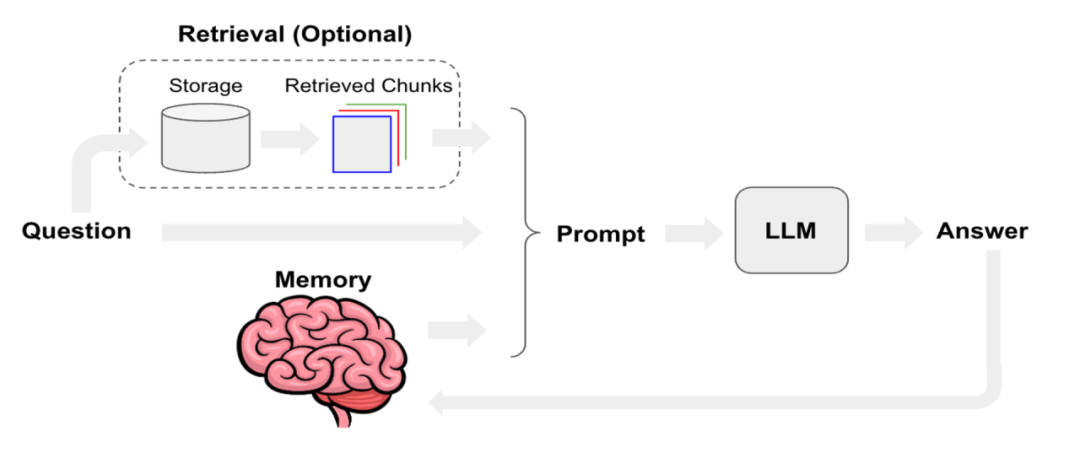

1.2 长期记忆实现的常见方法

长期记忆的实现通常依赖于以下几种方法:

- 数据库存储:将重要信息存储在数据库中,通过查询与更新操作进行管理。

- 向量数据库:通过向量化用户数据,并使用类似FAISS等工具进行高效存储和检索。

- 嵌入技术:通过将信息转化为固定长度的向量,并在需要时进行检索。

1.3 示例:基于SQLite实现AI Agent的长期记忆

下面是一个基于SQLite的简单实现,展示如何存储和查询用户的偏好信息:

import sqlite3

# 创建数据库连接

conn = sqlite3.connect('ai_agent_memory.db')

cursor = conn.cursor()

# 创建记忆表

cursor.execute('''

CREATE TABLE IF NOT EXISTS memory (

id INTEGER PRIMARY KEY AUTOINCREMENT,

user_id TEXT NOT NULL,

key TEXT NOT NULL,

value TEXT NOT NULL

)

''')

# 插入记忆

def store_memory(user_id, key, value):

cursor.execute('''

INSERT INTO memory (user_id, key, value) VALUES (?, ?, ?)

''', (user_id, key, value))

conn.commit()

# 查询记忆

def retrieve_memory(user_id, key):

cursor.execute('''

SELECT value FROM memory WHERE user_id = ? AND key = ?

''', (user_id, key))

result = cursor.fetchone()

return result[0] if result else None

# 示例存储与查询

store_memory('user_123', 'preferred_language', 'Python')

print(retrieve_memory('user_123', 'preferred_language')) # 输出 'Python'

二、上下文管理

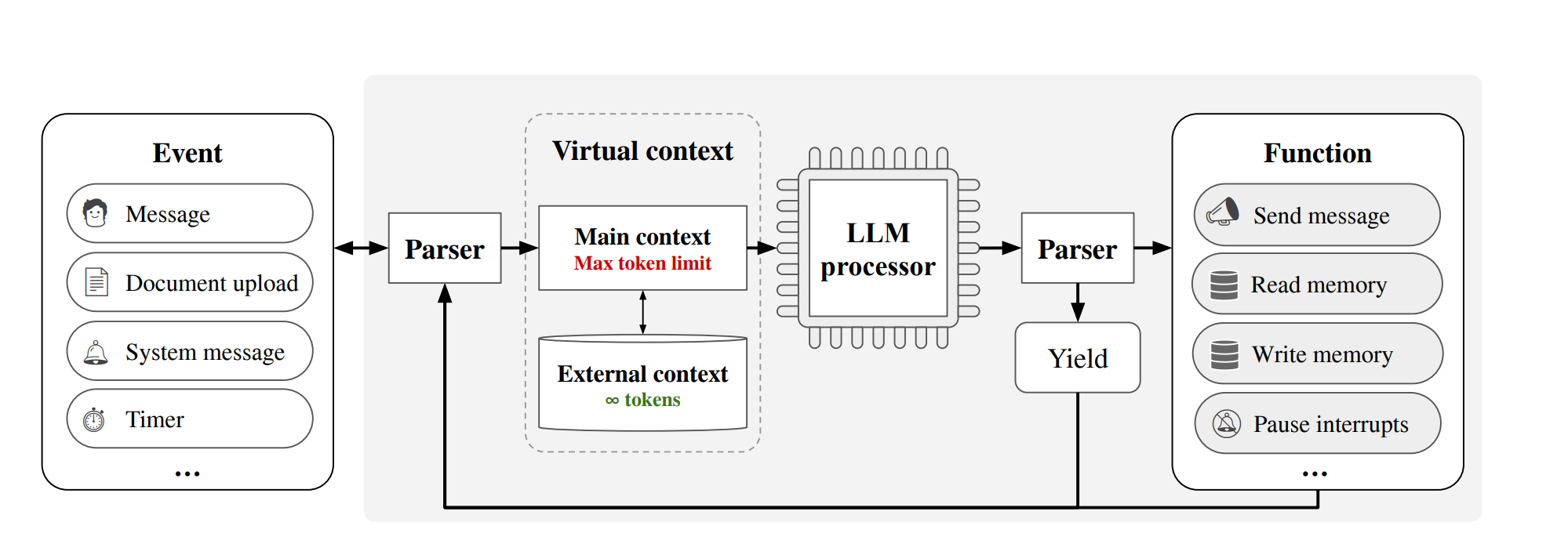

上下文管理(Context Management)是指AI Agent在与用户交互时,能够根据历史对话、环境信息等动态调整和维护当前的上下文状态。有效的上下文管理能够确保对话的连贯性,使得智能体在多个交互轮次中始终保持一致性和相关性。

2.1 上下文管理的重要性

上下文管理的重要性体现在以下几个方面:

- 保证对话的自然流畅:上下文信息能够让AI Agent理解对话的背景,避免重复或不相关的回答。

- 提升智能体的任务完成度:上下文管理能够确保智能体记住任务的进度和当前状态,在任务执行过程中做出合理判断。

- 处理多轮对话:通过维护上下文,AI Agent能够持续跟踪多个对话线程,保证每个线程的独立性和一致性。

2.2 上下文管理的挑战

在实际应用中,AI Agent的上下文管理面临一些挑战:

- 上下文的存储与更新:如何有效地存储历史上下文,并根据用户的输入动态更新。

- 上下文信息的精简:过多的上下文信息会导致存储效率低下,因此需要根据实际需求进行筛选与精简。

- 多用户场景:在多用户系统中,需要独立维护每个用户的上下文信息,避免信息交叉。

2.3 示例:基于字典实现简单的上下文管理

以下代码示例展示了如何使用字典来管理AI Agent的上下文信息:

class AIContextManager:

def __init__(self):

self.context = {}

def update_context(self, user_id, key, value):

if user_id not in self.context:

self.context[user_id] = {}

self.context[user_id][key] = value

def get_context(self, user_id, key):

return self.context.get(user_id, {}).get(key, None)

# 示例

context_manager = AIContextManager()

context_manager.update_context('user_123', 'last_topic', 'AI Agent Memory')

print(context_manager.get_context('user_123', 'last_topic')) # 输出 'AI Agent Memory'

2.4 结合长期记忆与上下文管理的综合应用

在实际应用中,长期记忆和上下文管理通常是紧密结合的。AI Agent不仅需要记住用户的长期偏好,还需要在每次对话中适时调用这些信息来提供更合适的反馈。通过结合上述的长期记忆和上下文管理技术,AI Agent能够提供更为智能和个性化的交互体验。

2.5 示例:综合应用——智能推荐系统

假设我们正在开发一个智能推荐系统,能够根据用户的历史偏好和当前对话上下文进行推荐。以下是一个简化的示例:

class SmartRecommendationSystem:

def __init__(self):

self.memory_manager = AIContextManager()

def update_user_preferences(self, user_id, category, preference):

self.memory_manager.update_context(user_id, category, preference)

def recommend(self, user_id):

preferences = self.memory_manager.context.get(user_id, {})

recommendations = []

if 'music' in preferences:

recommendations.append(f"推荐音乐:{preferences['music']}")

if 'movie' in preferences:

recommendations.append(f"推荐电影:{preferences['movie']}")

return recommendations or ["没有个性化推荐"]

# 示例

recommender = SmartRecommendationSystem()

recommender.update_user_preferences('user_123', 'music', 'Jazz')

recommender.update_user_preferences('user_123', 'movie', 'Inception')

print(recommender.recommend('user_123')) # 输出 ['推荐音乐:Jazz', '推荐电影:Inception']

三、长期记忆与上下文管理的优化策略

虽然AI Agent的长期记忆机制和上下文管理已经能够处理大部分的交互任务,但在复杂的应用场景中,这两者的优化仍然至关重要。为了提升AI Agent的响应速度、准确性和可扩展性,许多策略应运而生,特别是在大规模用户交互和多轮对话的情境下。

3.1 动态记忆更新

长期记忆系统的更新通常是静态的,也就是说,记忆一旦被保存下来,就会维持不变,直到下一次显式更新。对于AI Agent来说,这种方法虽然简单,但在处理复杂任务或快速变化的对话时,可能导致记忆过时或者不匹配。为了应对这一问题,动态记忆更新成为一种常见的优化策略。

动态记忆更新意味着AI Agent会根据上下文的变化自动更新记忆。比如,AI Agent可以根据用户最近的行为或输入动态调整其存储的记忆条目,从而保持与当前对话的相关性。

示例:动态记忆更新

在下面的示例中,我们演示了如何根据用户的反馈动态更新长期记忆。

import time

class DynamicMemory:

def __init__(self):

self.memory = {}

def add_memory(self, user_id, key, value):

if user_id not in self.memory:

self.memory[user_id] = {}

self.memory[user_id][key] = {"value": value, "timestamp": time.time()}

def get_memory(self, user_id, key):

memory_data = self.memory.get(user_id, {}).get(key)

if memory_data:

return memory_data["value"]

return None

def update_memory(self, user_id, key, value):

if user_id in self.memory and key in self.memory[user_id]:

# If memory is too old, update it

if time.time() - self.memory[user_id][key]["timestamp"] > 3600:

self.memory[user_id][key]["value"] = value

self.memory[user_id][key]["timestamp"] = time.time()

# 示例

dynamic_memory = DynamicMemory()

dynamic_memory.add_memory('user_123', 'location', 'New York')

print(dynamic_memory.get_memory('user_123', 'location')) # 输出 'New York'

# 用户位置更新

dynamic_memory.update_memory('user_123', 'location', 'San Francisco')

print(dynamic_memory.get_memory('user_123', 'location')) # 输出 'San Francisco'

3.2 上下文溯源与修复

AI Agent的上下文管理通常需要处理多个对话轮次中的信息,这使得上下文的存储和检索变得复杂。如果上下文信息被丢失或错乱,AI Agent将无法进行有效的对话,甚至可能导致错误响应。因此,如何进行上下文溯源和修复成为优化的一项重要工作。

3.2.1 上下文溯源

上下文溯源技术可以帮助AI Agent回溯对话中的关键信息,从而找出上下文失效的原因。例如,AI Agent可以回溯用户在对话初期的输入,以确定当前对话的主题是否发生变化。如果发生变化,AI Agent将能够主动调整其上下文管理策略。

3.2.2 上下文修复

上下文修复是指AI Agent在检测到上下文丢失或错误后,能够主动修复这一问题。修复通常通过回溯历史对话,或者通过用户提供的反馈进行上下文重建。例如,AI Agent可以在用户提供更详细的信息时,更新当前对话的上下文,保证对话的一致性。

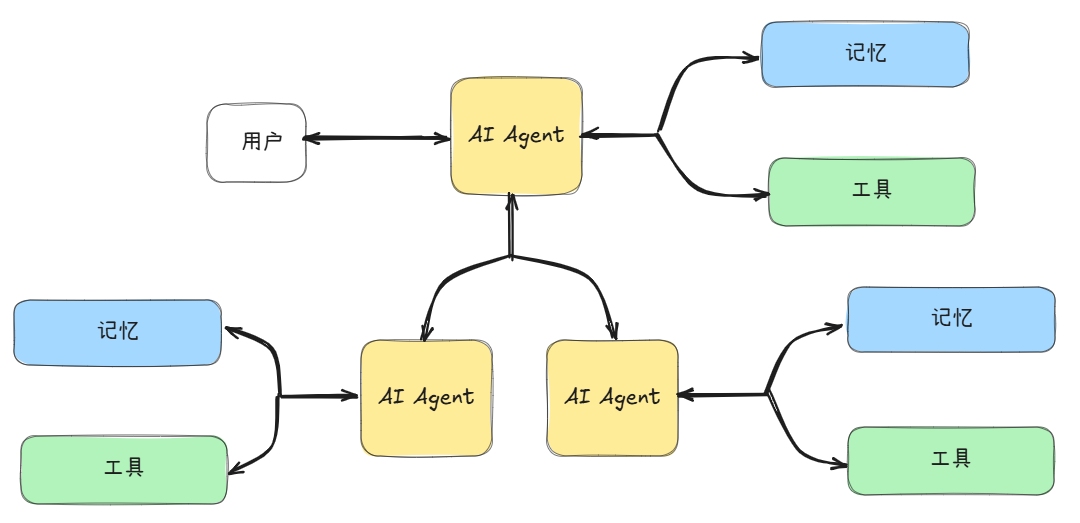

3.3 上下文切换与多任务管理

AI Agent通常需要处理多种任务和多个对话线程。在这种情况下,上下文切换和多任务管理成为一项挑战。尤其是在同一时间内处理多个用户或多个任务时,如何有效地切换上下文并确保不同任务之间的信息不被混淆是关键。

3.3.1 上下文切换

上下文切换是指在多个任务或对话之间快速切换,以确保每个任务都能根据其特定的上下文进行处理。通过高效的上下文切换,AI Agent能够在多个用户交互和任务执行之间保持流畅性。

3.3.2 多任务管理

AI Agent的多任务管理涉及如何在同一时间内处理多个任务的上下文。例如,在一个在线客服系统中,AI Agent可能需要同时处理来自不同用户的请求。为了避免信息混淆,系统需要为每个任务创建独立的上下文,并能够根据任务的重要性和优先级合理分配资源。

3.4 利用强化学习优化长期记忆与上下文管理

近年来,强化学习(Reinforcement Learning, RL)技术逐渐成为优化长期记忆和上下文管理的有力工具。通过强化学习,AI Agent能够根据不同的环境和任务需求自主学习如何存储和更新记忆,以及如何在多个对话和任务中切换上下文。

在强化学习中,AI Agent通过与环境的互动学习最优策略。在长期记忆和上下文管理的优化中,AI Agent可以通过反馈调整记忆的权重和上下文的优先级,从而达到更加个性化和高效的对话管理。

示例:基于强化学习的记忆更新策略

以下是一个简单的强化学习示例,展示了如何根据任务的奖励信号更新长期记忆:

import random

class RLMemoryUpdate:

def __init__(self):

self.memory = {}

self.learning_rate = 0.1

def update_memory(self, user_id, key, value, reward):

if user_id not in self.memory:

self.memory[user_id] = {}

old_value = self.memory[user_id].get(key, 0)

self.memory[user_id][key] = old_value + self.learning_rate * (reward - old_value)

def get_memory(self, user_id, key):

return self.memory.get(user_id, {}).get(key, 0)

# 示例

rl_memory = RLMemoryUpdate()

rl_memory.update_memory('user_123', 'satisfaction', 5, reward=10) # 用户满意度

print(rl_memory.get_memory('user_123', 'satisfaction')) # 输出 1.0

在这个示例中,我们通过一个奖励信号来更新记忆值,随着每次对话的互动,智能体会根据用户反馈逐步优化记忆。

四、跨任务与多模态上下文管理

随着AI技术的进步,许多AI系统需要在多个任务或模态之间进行跨域操作。跨任务和多模态的上下文管理不仅要处理文本、语音等不同数据源,还要根据不同任务的需求来调整记忆和上下文。这要求AI Agent不仅仅具备基本的记忆和上下文管理能力,还需要能处理更多元的信息和任务。

4.1 跨任务上下文管理

跨任务上下文管理意味着AI Agent能够在不同任务之间共享并切换上下文信息。比如,在一个多任务的场景中,AI Agent需要同时处理对话任务、推荐任务和搜索任务。每个任务都有自己独立的上下文,AI Agent需要在每个任务之间切换并保证信息的一致性。

4.2 多模态上下文管理

随着多模态技术的普及,AI Agent需要在不同的模态(例如文本、语音、视觉等)之间进行上下文管理。例如,当用户通过语音与AI Agent互动时,AI Agent不仅需要理解语言的含义,还需要结合图像、视频等信息来生成更准确的回应。

这种多模态上下文管理要求AI Agent能够同步处理来自不同输入源的信息,并能够有效地融合和应用这些信息。

五、总结与展望

长期记忆与上下文管理是AI Agent系统成功的核心技术之一。通过优化长期记忆更新策略、加强上下文的溯源与修复,并结合强化学习等先进方法,AI Agent能够实现更加智能和个性化的交互。随着跨任务与多模态技术的不断发展,AI Agent在复杂场景中的表现将进一步提升。

未来,我们可以期待AI Agent在长期记忆与上下文管理方面的创新,例如通过自适应的上下文切换、跨模态信息融合、以及强化学习驱动的智能更新机制,让AI Agent更好地应对日益复杂的任务与对话场景。

- 点赞

- 收藏

- 关注作者

评论(0)