深度强化学习在动态环境中的实时决策应用

深度强化学习在动态环境中的实时决策应用

深度强化学习(Deep Reinforcement Learning, DRL)作为人工智能领域的一个重要分支,已广泛应用于智能控制系统中。从无人驾驶到机器人控制,DRL通过模拟和训练智能体,能够在复杂环境中做出决策并执行控制任务。本文将探讨DRL在智能控制系统中的应用、所面临的挑战以及如何克服这些挑战。

1. 深度强化学习概述

1.1 强化学习简介

强化学习是一种基于奖励信号引导智能体学习如何在环境中采取行动以最大化累积奖励的机器学习方法。与监督学习不同,强化学习不依赖于标注数据,而是通过与环境的交互来学习最优策略。

1.2 深度强化学习的定义

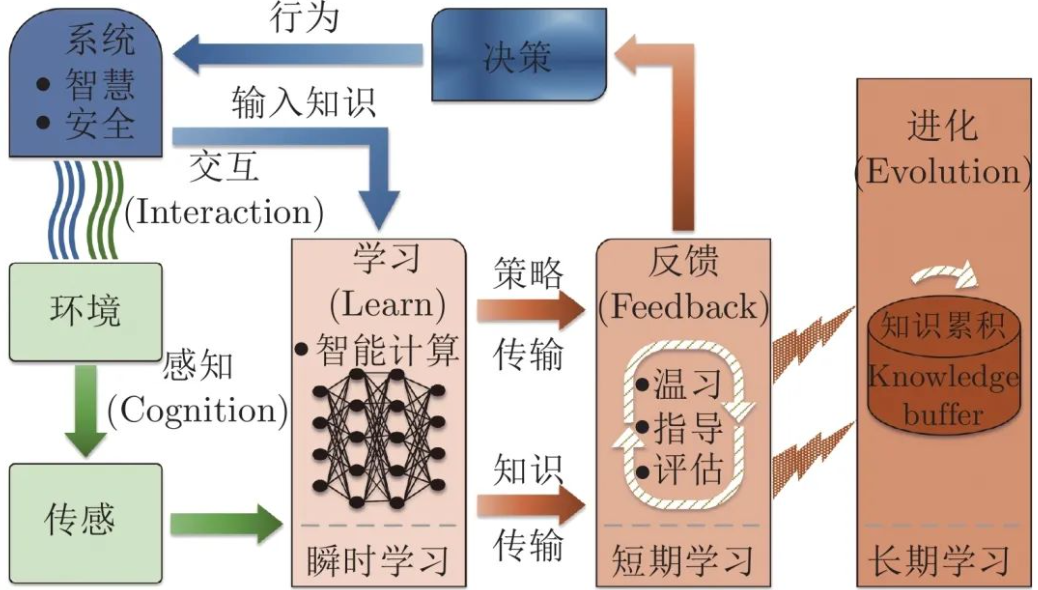

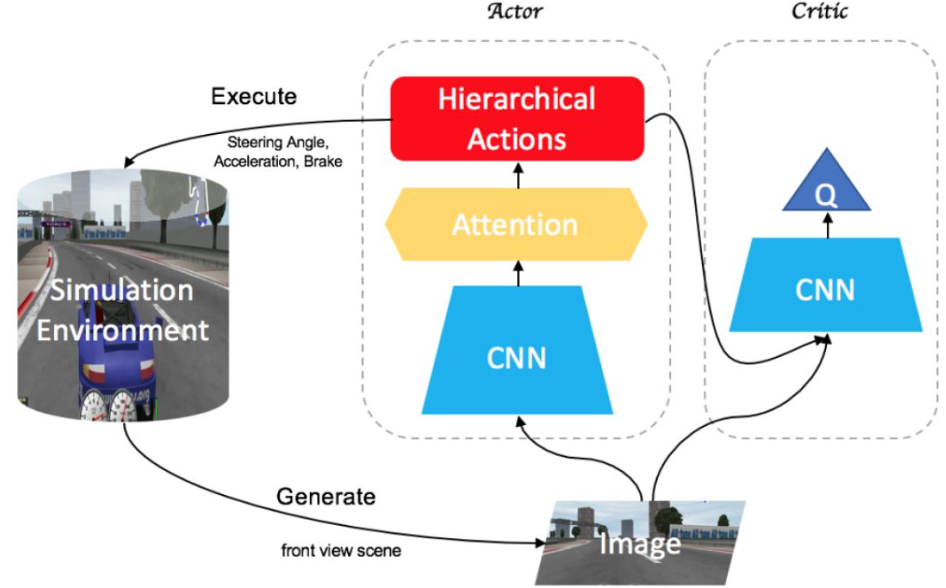

深度强化学习将深度学习与强化学习相结合,通过深度神经网络来近似强化学习中的价值函数或策略函数,从而使智能体能够处理高维、复杂的输入数据(如图像、声音等)。

2. 深度强化学习在智能控制系统中的应用

2.1 无人驾驶系统

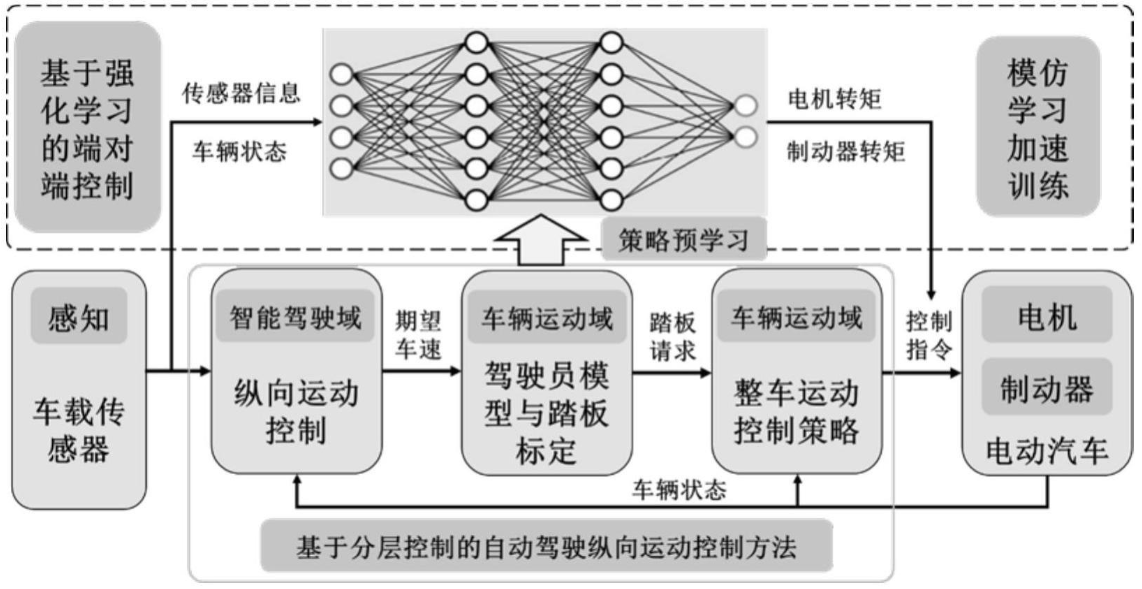

在无人驾驶系统中,DRL被应用于车辆的路径规划和决策制定。智能体通过与环境交互(例如,感知周围道路情况和交通规则),优化车辆的驾驶策略。

import gym

import numpy as np

import tensorflow as tf

from tensorflow.keras import layers

# 创建环境

env = gym.make("CarRacing-v0")

# 定义深度Q网络(DQN)

class DQN(tf.keras.Model):

def __init__(self):

super(DQN, self).__init__()

self.conv1 = layers.Conv2D(32, 8, strides=4, activation='relu')

self.conv2 = layers.Conv2D(64, 4, strides=2, activation='relu')

self.conv3 = layers.Conv2D(64, 3, strides=1, activation='relu')

self.flatten = layers.Flatten()

self.dense1 = layers.Dense(512, activation='relu')

self.dense2 = layers.Dense(env.action_space.n, activation='linear')

def call(self, input):

x = self.conv1(input)

x = self.conv2(x)

x = self.conv3(x)

x = self.flatten(x)

x = self.dense1(x)

return self.dense2(x)

# 初始化网络

dqn = DQN()

# 训练过程(略)

2.2 机器人控制

DRL在机器人控制领域的应用十分广泛,尤其在任务导向的自主导航和物品搬运等方面。机器人通过DRL能够学习如何在复杂的环境中规划路径、避免障碍物和执行多步骤任务。

import gym

from stable_baselines3 import DQN

# 创建环境

env = gym.make('FetchReach-v1')

# 使用DQN算法训练机器人

model = DQN('MlpPolicy', env, verbose=1)

model.learn(total_timesteps=50000)

# 保存模型

model.save("dqn_fetchreach")

# 测试模型

model = DQN.load("dqn_fetchreach")

obs = env.reset()

for _ in range(1000):

action, _states = model.predict(obs)

obs, rewards, done, info = env.step(action)

if done:

obs = env.reset()

2.3 智能电网

在智能电网领域,DRL被用来优化电力流控制、负荷预测及设备调度。通过学习历史数据,DRL可以预测电力需求并自动调整电网配置,从而提高系统的效率与可靠性。

3. 深度强化学习在智能控制中的挑战

3.1 高维状态和动作空间

智能控制系统中常常涉及复杂的状态和动作空间。例如,在无人驾驶或机器人控制中,状态空间可能包含图像或传感器数据,而动作空间则可能包括连续的运动控制参数。DRL算法在高维空间中的训练和推理过程非常复杂,计算资源消耗大,且容易陷入局部最优解。

3.2 样本效率问题

传统的强化学习算法通常需要大量的交互样本来训练模型。然而,在实际的智能控制系统中,尤其是涉及高风险的任务(如无人驾驶),收集大量训练样本可能会非常昂贵或危险。如何提高DRL的样本效率,减少对真实环境的依赖,是一个重要挑战。

3.3 探索与利用的平衡

在强化学习中,智能体需要在探索新的行为与利用已有知识之间找到平衡。过度的探索可能导致效率低下,而过度利用则可能导致智能体陷入局部最优。在智能控制系统中,如何处理这个平衡,尤其是在动态和不确定环境中,仍然是一个开放的研究问题。

4. 深度强化学习在智能控制中的优化方法

4.1 经验回放与目标网络

为了提高样本效率,DRL通常使用经验回放和目标网络技术。经验回放可以有效地利用历史经验,目标网络可以稳定学习过程,避免模型的过度振荡。

from collections import deque

import random

class ReplayBuffer:

def __init__(self, max_size):

self.buffer = deque(maxlen=max_size)

def add(self, experience):

self.buffer.append(experience)

def sample(self, batch_size):

return random.sample(self.buffer, batch_size)

def size(self):

return len(self.buffer)

4.2 模型集成与迁移学习

在深度强化学习中,模型集成与迁移学习方法能够帮助提升算法的性能。通过将多个模型的预测结果进行集成,或通过迁移已有模型的知识到新的任务中,能够有效提高智能控制系统的表现。

4.3 层次强化学习

层次强化学习将复杂任务分解为多个子任务,每个子任务由单独的强化学习智能体进行处理。这种方法能够提高训练效率,并在多任务环境中提供更好的性能。

5. 深度强化学习在智能控制中的未来发展

5.1 自适应控制与实时决策

随着智能控制系统对实时性要求的不断提升,深度强化学习在自适应控制方面的应用将成为重要的发展方向。在许多实际应用中,控制系统需要能够在环境动态变化的情况下快速调整控制策略。通过自适应深度强化学习,系统能够在面对突发变化时,迅速做出调整,保障系统稳定性。

未来的研究将致力于优化DRL算法,以支持更低延迟和更高频率的决策能力。特别是在自动驾驶、无人机控制等高实时性要求的应用场景中,DRL的实时性和高效性将是其能否成功应用的关键因素。

5.2 解释性与安全性

在许多智能控制应用中,尤其是与人类安全相关的系统(如医疗设备、无人驾驶等),模型的可解释性和安全性变得尤为重要。深度强化学习的“黑箱”特性使得它的决策过程缺乏透明性,这使得它在高风险应用中的可接受性受到限制。

未来的研究可能集中在增强DRL模型的可解释性上,采用可解释的强化学习方法,使得系统可以提供可追溯的决策依据,并为开发者提供对控制策略的更好理解。除此之外,结合安全机制的DRL模型也将在实践中得到更多关注,以避免由于决策错误而导致的系统失效或安全问题。

5.3 多智能体系统与协作

在一些复杂的智能控制任务中,单个智能体往往无法高效完成任务。这时,采用多智能体系统(Multi-Agent Systems, MAS)成为一种有效的解决方案。通过DRL,多个智能体可以相互协调、共享信息,并共同优化任务完成的效率。

例如,在智能制造中,多个机器人需要在工厂环境中协作完成装配任务;在无人机群体控制中,不同的无人机通过协同工作完成对大范围区域的监测。这种多智能体协作不仅提高了任务完成的速度和准确性,还使得系统具有更强的鲁棒性和灵活性。

5.4 跨领域迁移与泛化能力

深度强化学习的泛化能力在面对未见过的环境或任务时,常常面临显著挑战。为了提升其在新任务上的表现,研究人员正在致力于跨领域迁移学习技术的研究。通过迁移学习,DRL模型能够将一个任务中学到的知识迁移到另一个相关任务中,从而加速新任务的学习过程。

未来,DRL模型可能会更加关注如何在多个不同领域中高效迁移和共享知识。跨领域的迁移能力不仅可以降低训练成本,还能使得智能控制系统在更广泛的实际场景中得到应用。

5.5 环境建模与仿真

在许多智能控制任务中,实际环境的模拟和建模至关重要。传统的强化学习往往依赖于与环境的交互来获取经验,而这种交互在实际中往往是昂贵或有风险的。因此,如何通过仿真环境快速而高效地训练深度强化学习模型成为一个重要研究方向。

未来,虚拟仿真环境将成为DRL模型训练的重要工具。通过与现实环境的对接,模拟与真实世界的差异,智能体能够在仿真中进行大量的训练,降低对现实环境交互的依赖。此外,随着生成对抗网络(GAN)等技术的进步,虚拟环境的生成和优化也将得到极大的提升,从而增强DRL在复杂环境中的应用。

6. 深度强化学习在智能控制系统中的成功案例

6.1 AlphaGo与AlphaZero

AlphaGo是深度强化学习在智能控制领域的经典案例。它成功地将DRL与蒙特卡罗树搜索(MCTS)相结合,能够在围棋这项复杂游戏中战胜人类世界冠军,标志着深度强化学习在策略优化和决策制定中的巨大潜力。之后,AlphaZero进一步提升了算法性能,突破了围棋、国际象棋和将棋的传统局限,展示了DRL在更加广泛领域中的应用能力。

尽管AlphaGo和AlphaZero的应用主要集中在游戏领域,但其背后的技术方法对于智能控制系统中的决策制定提供了重要参考。这些算法的成功表明,DRL不仅能够处理复杂的、非线性的问题,还能够在面对大规模状态空间时展现出卓越的学习能力。

6.2 无人驾驶汽车

无人驾驶技术是DRL在智能控制领域的重要应用之一。通过深度强化学习,无人驾驶系统能够在复杂的交通环境中进行路径规划、障碍物避免以及交通信号识别等任务。例如,Waymo等公司使用基于DRL的算法来优化自动驾驶决策,帮助车辆在城市道路中进行安全驾驶。

这些系统不仅依赖深度强化学习进行决策,而且通过不断地与环境进行交互来积累经验,从而提高其决策精度与安全性。尽管目前无人驾驶技术仍面临许多挑战,但DRL的应用无疑推动了该领域的发展。

6.3 机器人控制与自动化

在工业自动化领域,机器人控制系统广泛采用深度强化学习来提高生产线的效率。例如,波士顿动力的Spot机器人就使用了强化学习来进行环境适应,能够在复杂、动态的环境中完成如运输、巡逻等任务。

深度强化学习通过使机器人能够自主学习控制策略,大大提高了机器人的适应能力和工作效率。这种方法还在机器人协作和集群控制中得到了应用,使得多个机器人可以协同完成任务。

7. 未来研究方向与技术展望

7.1 强化学习与模仿学习结合

模仿学习(Imitation Learning)和深度强化学习的结合将成为未来智能控制系统中的一个重要发展趋势。模仿学习通过模仿人类专家的行为来加速学习过程,而强化学习则通过自主探索和试错来优化决策策略。两者结合能够提高智能体的学习效率,并在减少对环境交互的需求的同时,增强其表现能力。

7.2 基于知识图谱的强化学习

知识图谱(Knowledge Graph)为强化学习提供了丰富的先验知识,有助于智能体在训练过程中更好地理解环境和任务。通过将知识图谱与深度强化学习结合,智能体能够从历史数据中提取结构化知识,并将其应用于新的决策问题。

这一方法能够在多个任务之间共享知识,减少重复训练,提升多任务学习的效果。

7.3 量子强化学习

量子计算的进步为深度强化学习提供了新的机遇。量子强化学习(Quantum Reinforcement Learning, QRL)结合了量子计算的优势,能够在解决复杂优化问题时提供更高效的算法。尽管这一领域仍处于研究阶段,但它代表了强化学习与量子计算结合的前景,未来可能为智能控制系统带来更多创新。

结论

深度强化学习(DRL)在智能控制系统中展现了广泛的应用潜力,尤其在无人驾驶、机器人控制、智能电网等领域。它通过模拟与环境的交互学习优化策略,为复杂、动态的控制任务提供了有效的解决方案。然而,深度强化学习在实际应用中面临一些挑战,包括高维状态空间、样本效率、探索与利用的平衡等问题。

随着技术的不断发展,深度强化学习在智能控制中的未来发展方向也逐渐显现。包括自适应控制与实时决策、解释性与安全性、多智能体协作、跨领域迁移与泛化能力等方面都将成为重点研究方向。此外,环境建模与仿真技术、DRL的优化方法、模型集成等也将不断改进,以提升算法的实际应用效果。

深度强化学习在智能控制系统中的成功案例,如AlphaGo、无人驾驶、机器人控制等,证明了其强大的学习与决策能力。未来,随着跨领域技术(如模仿学习、量子计算)的结合,DRL将在智能控制系统中发挥更加重要的作用,推动行业创新与进步。

- 点赞

- 收藏

- 关注作者

评论(0)