基于多任务学习的智能代理自适应推理方法研究

基于多任务学习的智能代理自适应推理方法研究

引言

在人工智能研究中,传统的AI系统通常针对单一任务进行优化,缺乏跨任务的知识迁移能力。而**多任务学习(Multi-Task Learning, MTL)**通过在同一模型中同时学习多个相关任务,使AI Agent能够在不同情境下实现自适应推理与决策。这种机制不仅提升了数据利用效率,还增强了系统的泛化能力。

本文将深入探讨多任务学习在AI Agent自适应推理与决策中的应用,并通过Python示例展示一个可训练的多任务Agent。

多任务学习基础

多任务学习的核心思想

多任务学习的核心思想是通过共享模型的底层表示(shared representation)来同时优化多个任务。例如,在自然语言处理领域,情感分析和主题分类可以通过共享文本表示共同训练,从而增强模型在两个任务上的表现。

优点包括:

- 参数共享,提高训练效率

- 降低过拟合风险

- 实现任务间知识迁移

多任务学习的模型架构

常见的多任务学习架构主要有三类:

-

硬参数共享(Hard Parameter Sharing)

- 模型底层共享参数,高层任务特定分支独立。

- 示例:共享编码器 + 多个任务头。

-

软参数共享(Soft Parameter Sharing)

- 每个任务有独立模型,但通过正则化保持参数相似性。

-

动态权重分配(Dynamic Weighting)

- 根据任务重要性动态调整损失函数权重,实现自适应优化。

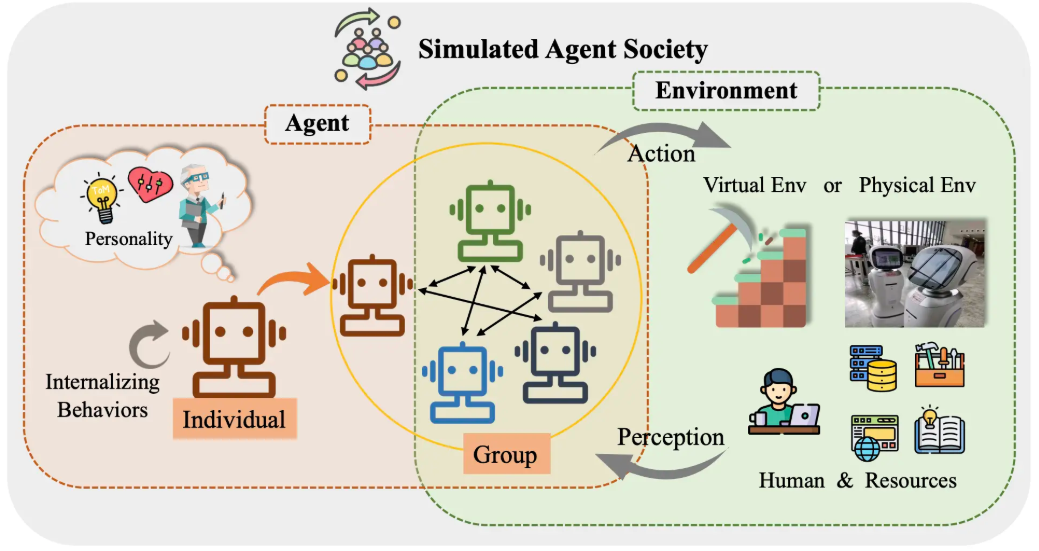

AI Agent自适应推理机制

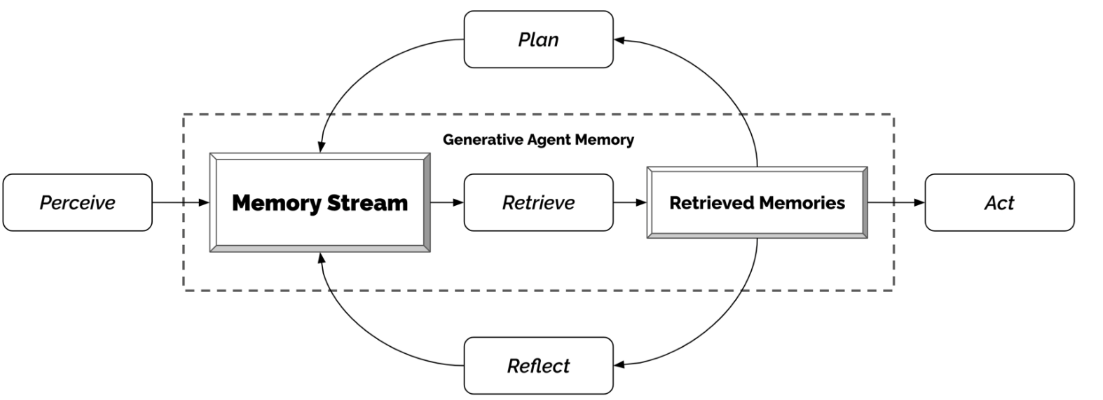

自适应推理的概念

AI Agent在复杂环境中需要根据上下文动态调整推理策略。多任务学习提供了共享知识与任务自适应能力,使Agent能够在不同任务间切换而无需重新训练。

推理机制示例

- 策略选择(Policy Selection):根据当前任务动态选择策略网络输出。

- 注意力调控(Attention Modulation):通过注意力机制聚焦与当前任务相关的特征。

- 任务嵌入(Task Embedding):每个任务由一个向量表示,Agent通过任务向量进行条件推理。

AI Agent决策机制

多任务决策框架

在多任务场景下,AI Agent的决策机制通常包括三个步骤:

- 状态感知(State Perception):使用共享编码器提取环境状态表示。

- 任务推理(Task Reasoning):通过任务嵌入结合共享表示生成任务相关策略。

- 行动选择(Action Selection):根据策略输出选择最优动作,实现决策。

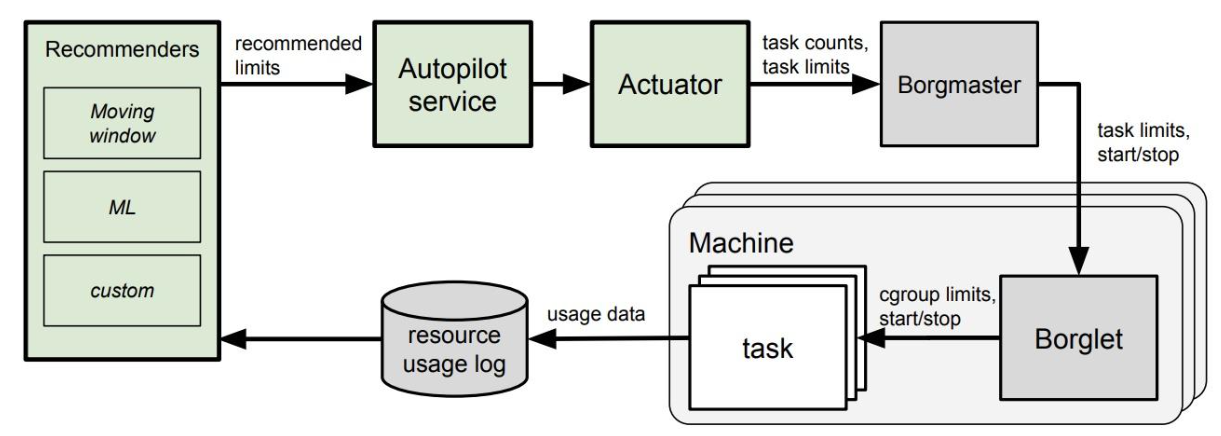

决策优化方法

- 联合损失函数(Joint Loss Function):将多个任务的损失加权求和,实现多任务优化。

- 强化学习结合(RL+MTL):在强化学习中,将奖励函数与多任务目标结合,增强Agent适应性。

实战示例:多任务AI Agent

下面以Python和PyTorch为例,构建一个简单的多任务Agent,同时完成分类和回归任务。

import torch

import torch.nn as nn

import torch.optim as optim

# 定义共享编码器

class SharedEncoder(nn.Module):

def __init__(self, input_dim, hidden_dim):

super().__init__()

self.fc = nn.Sequential(

nn.Linear(input_dim, hidden_dim),

nn.ReLU()

)

def forward(self, x):

return self.fc(x)

# 定义任务特定头

class TaskHead(nn.Module):

def __init__(self, hidden_dim, output_dim):

super().__init__()

self.fc = nn.Linear(hidden_dim, output_dim)

def forward(self, x):

return self.fc(x)

# 定义多任务Agent

class MultiTaskAgent(nn.Module):

def __init__(self, input_dim, hidden_dim, class_num):

super().__init__()

self.encoder = SharedEncoder(input_dim, hidden_dim)

self.class_head = TaskHead(hidden_dim, class_num) # 分类任务

self.reg_head = TaskHead(hidden_dim, 1) # 回归任务

def forward(self, x):

shared = self.encoder(x)

class_out = self.class_head(shared)

reg_out = self.reg_head(shared)

return class_out, reg_out

# 模拟数据

x = torch.randn(32, 10)

y_class = torch.randint(0, 3, (32,))

y_reg = torch.randn(32, 1)

# 初始化模型

agent = MultiTaskAgent(input_dim=10, hidden_dim=64, class_num=3)

criterion_class = nn.CrossEntropyLoss()

criterion_reg = nn.MSELoss()

optimizer = optim.Adam(agent.parameters(), lr=0.001)

# 训练示例

for epoch in range(100):

optimizer.zero_grad()

class_pred, reg_pred = agent(x)

loss_class = criterion_class(class_pred, y_class)

loss_reg = criterion_reg(reg_pred, y_reg)

loss = loss_class + loss_reg # 联合损失

loss.backward()

optimizer.step()

print("训练完成,Agent可同时处理分类与回归任务")

总结

通过多任务学习,AI Agent能够实现自适应推理与决策,在不同任务间共享知识,提高泛化能力和决策效率。本文展示了从理论架构到实战代码的完整流程,说明多任务学习在实际AI Agent设计中的应用价值。

核心亮点:

- 硬参数共享与任务特定头结合

- 联合损失实现多任务优化

- 支持分类与回归等不同类型任务

未来,可以结合强化学习与元学习进一步提升Agent在动态环境下的自适应能力。

- 点赞

- 收藏

- 关注作者

评论(0)