基于Transformer的视觉-语言融合在跨模态推理任务中的应用研究

基于Transformer的视觉-语言融合在跨模态推理任务中的应用研究

引言

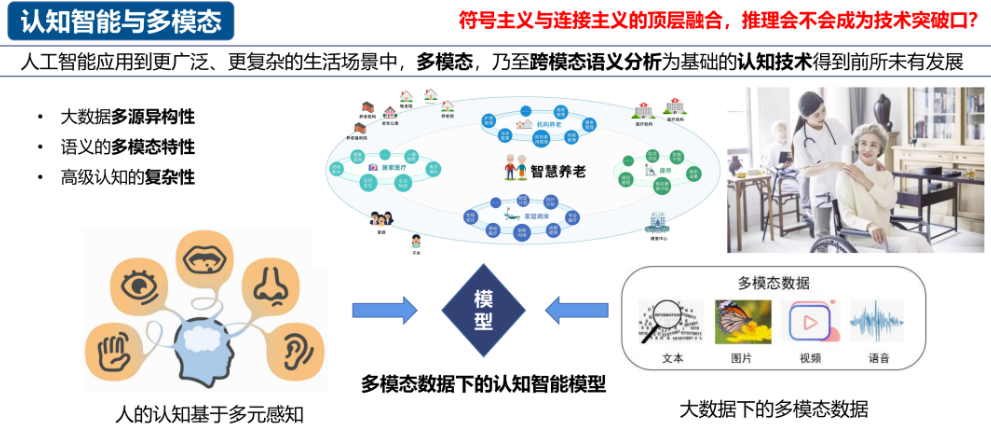

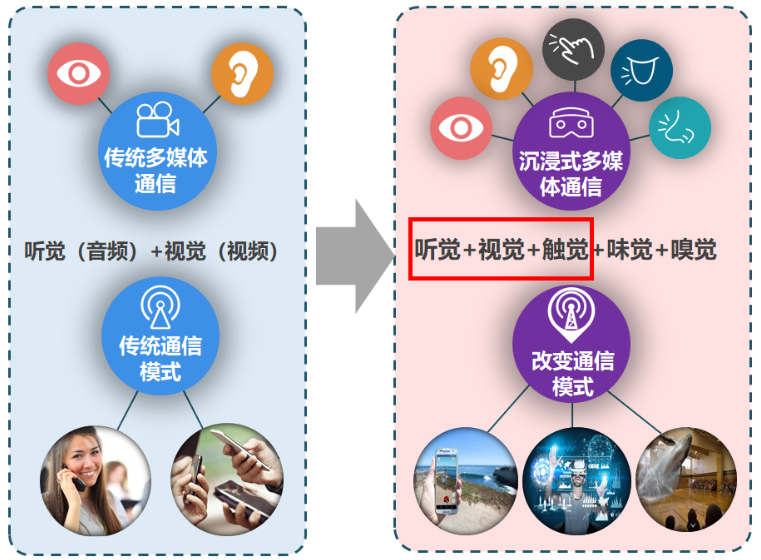

在人工智能的发展中,跨模态推理(Cross-modal Reasoning)成为实现多模态智能体(AI Agent)的核心能力之一。传统的AI往往在单一模态(如图像识别、文本理解)上表现良好,但缺乏跨模态的语义理解能力。视觉-语言融合(Vision-Language Fusion, VLF)技术的兴起,为AI Agent带来了更强的感知与推理能力,使其能够在看图理解文字和用语言推理视觉信息之间自由切换。

本文将系统介绍基于视觉-语言融合的AI Agent跨模态推理机制,包括其理论基础、模型架构、应用场景,并给出一个Python代码实战示例。

一、视觉-语言融合的理论基础

1.1 跨模态推理的概念

跨模态推理是指AI能够综合处理多种模态的数据(如图像与文本),并在两者之间建立语义映射与推理链路。例如,在“图片中有几只猫?”这样的任务中,AI不仅要识别图片中的物体,还要理解语言描述并做出推理。

1.2 视觉-语言融合方法

常见的视觉-语言融合方法包括:

- 早期融合(Early Fusion):在低层特征阶段融合,例如拼接图像和文本的embedding。

- 后期融合(Late Fusion):分别处理视觉和语言特征,最后阶段进行融合。

- 跨模态注意力机制(Cross-modal Attention):通过Transformer或注意力机制,学习图像区域与文本单词的对应关系。

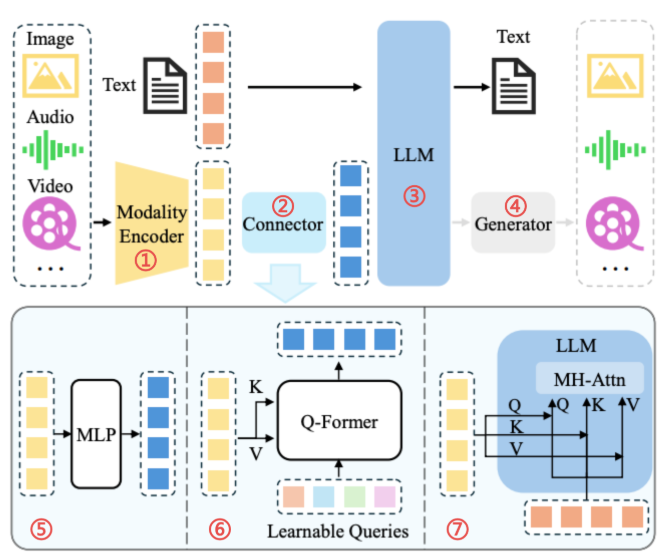

1.3 主流模型

典型的视觉-语言模型包括:

- CLIP (Contrastive Language-Image Pre-training):通过对比学习实现跨模态语义对齐。

- ViLT (Vision-and-Language Transformer):简化视觉编码过程,直接在Transformer中融合图像与文本。

- BLIP / BLIP-2:支持跨模态问答和图文生成。

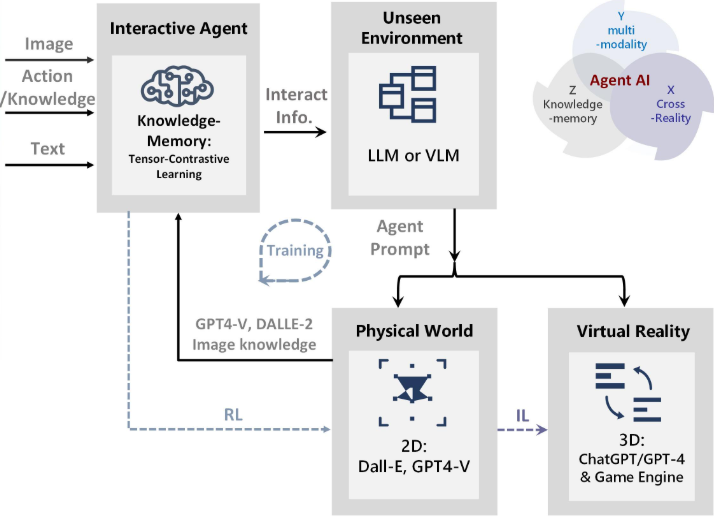

二、AI Agent的跨模态推理机制

2.1 感知层

感知层主要负责从不同模态中提取特征,例如使用CNN或Vision Transformer提取图像特征,使用BERT提取文本特征。

2.2 融合层

在融合层,AI Agent通过注意力机制实现跨模态特征对齐,例如:

- 文本单词对齐图像区域

- 图像对象与问题关键词的对应

2.3 推理层

在推理层,AI Agent通过多层Transformer或图神经网络,建立跨模态的推理链路。例如,在VQA任务中,模型需要基于图像内容回答文本问题。

2.4 行动层

AI Agent不仅要进行回答,还需要基于跨模态推理做出决策,如:

- 回答图文问题(VQA)

- 多模态信息检索

- 生成跨模态描述

三、应用场景

3.1 视觉问答(Visual Question Answering, VQA)

AI Agent可以基于图片和问题进行跨模态推理。例如,输入一张交通场景图和问题“是否有红绿灯?”,模型能判断答案。

3.2 多模态推荐系统

利用图像和文本描述融合推理,AI Agent可更精准地推荐商品。

3.3 智能监控

在安防场景中,AI Agent能通过图像与语义推理完成行为识别和场景理解。

四、代码实战:基于CLIP的跨模态推理

下面我们使用 OpenAI CLIP 模型实现一个简化的跨模态推理示例,任务是输入一张图片与候选文本,推理哪一句话更符合图片。

import torch

import clip

from PIL import Image

# 1. 加载模型

device = "cuda" if torch.cuda.is_available() else "cpu"

model, preprocess = clip.load("ViT-B/32", device=device)

# 2. 加载图片

image = preprocess(Image.open("dog.jpg")).unsqueeze(0).to(device)

# 3. 定义候选文本

text_candidates = [

"a photo of a dog playing in the park",

"a photo of a cat sleeping on the sofa",

"a man riding a bicycle"

]

text = clip.tokenize(text_candidates).to(device)

# 4. 特征提取

with torch.no_grad():

image_features = model.encode_image(image)

text_features = model.encode_text(text)

# 5. 计算相似度

similarity = (image_features @ text_features.T).softmax(dim=-1)

# 6. 输出结果

best_idx = similarity.argmax().item()

print(f"预测结果: {text_candidates[best_idx]}")

运行结果示例(假设图片是狗):

预测结果: a photo of a dog playing in the park

这个实验展示了AI Agent如何通过视觉-语言融合进行跨模态推理。

五、深度分析与优化方向

5.1 当前问题

- 语义对齐不完美:不同模态特征在对齐时可能丢失细节。

- 计算开销大:Transformer结构在大规模跨模态推理中消耗巨大算力。

- 数据依赖强:需要大量配对的图文数据进行预训练。

5.2 优化方向

- 轻量化跨模态模型:结合知识蒸馏和模型剪枝,降低计算成本。

- 大模型+Agent机制:利用LLM与视觉模型结合,让AI Agent具备推理链路。

- 因果推理融入:在跨模态推理中引入因果推理,使模型具备逻辑推断能力。

六、跨模态推理中的关键技术

6.1 视觉特征提取

视觉模态的特征提取常依赖卷积神经网络(CNN)和视觉Transformer(ViT)。

- CNN方法:ResNet、EfficientNet等适合提取局部纹理和目标特征。

- ViT方法:Vision Transformer将图像分割为patch,再输入Transformer,能学习全局依赖关系,更适合跨模态融合。

在跨模态推理中,视觉特征必须保留局部区域语义信息,以便与语言中的实体或描述词对齐。

6.2 语言特征提取

语言模态主要采用预训练语言模型(PLM),如BERT、RoBERTa、GPT系列。

- BERT式模型:通过mask语言建模任务学习上下文特征。

- GPT式模型:通过自回归预测具备生成能力,更适合跨模态生成任务。

对于跨模态推理,语言特征应保留词级别和句子级别的语义表示,确保能与视觉特征对齐。

6.3 融合机制

视觉与语言特征的融合是跨模态推理的核心。主流方式包括:

- 简单拼接 (Concat):直接将视觉和语言embedding拼接,再输入全连接层。

- 双流Transformer (Dual-stream Transformer):视觉与语言各自通过Transformer,最后阶段交互。

- 跨模态注意力 (Cross Attention):让文本token与图像patch相互对齐,建立映射关系。

例如,跨模态注意力机制可表示为:

其中, 来自文本, 来自图像特征,实现了文本与图像的交互。

七、跨模态推理实验设计

7.1 数据集

常用的视觉-语言跨模态推理数据集包括:

- VQA v2:图像 + 问题 → 答案

- COCO Captions:图像 + 描述 → 生成自然语言

- Visual Genome:图像中对象及关系标注,适合复杂推理

- Flickr30k:图像 + 句子对,适合图文检索

7.2 任务设置

我们可以设计三类任务验证AI Agent的跨模态能力:

- 判别类任务:给定图像和候选文本,判断匹配度(如CLIP示例)。

- 生成类任务:输入图像,生成描述或回答问题(图文生成)。

- 推理类任务:输入图像和问题,结合视觉语义做逻辑推断(如“这张图里的人能否在踢足球?”)。

7.3 评价指标

- 准确率 (Accuracy):用于判别类任务。

- BLEU / ROUGE / CIDEr:用于图文生成类任务。

- 人类评估 (Human Evaluation):用于复杂推理任务,考察模型答案的合理性。

八、进阶实战:跨模态问答(VQA)

在这里,我们扩展前文的CLIP实验,构建一个简化版的视觉问答系统。

流程:输入图片 + 文本问题,输出答案。

import torch

from transformers import BlipForQuestionAnswering, BlipProcessor

from PIL import Image

# 1. 加载模型

device = "cuda" if torch.cuda.is_available() else "cpu"

model = BlipForQuestionAnswering.from_pretrained("Salesforce/blip-vqa-base").to(device)

processor = BlipProcessor.from_pretrained("Salesforce/blip-vqa-base")

# 2. 输入图片和问题

image = Image.open("dog.jpg")

question = "What is the animal doing?"

# 3. 数据预处理

inputs = processor(image, question, return_tensors="pt").to(device)

# 4. 推理

with torch.no_grad():

output = model.generate(**inputs)

answer = processor.decode(output[0], skip_special_tokens=True)

print("问题:", question)

print("回答:", answer)

运行结果示例:

问题: What is the animal doing?

回答: playing with a ball

这里我们利用 BLIP模型 实现了跨模态推理,AI Agent能够基于视觉与语言输入完成问答任务。

九、跨模态推理在AI Agent中的扩展应用

9.1 机器人交互

在机器人中,跨模态推理能实现看图执行任务。例如,AI Agent接收到“把红色杯子放到桌子上”的指令,它需要:

- 从视觉模态中找到红色杯子;

- 将语言描述与视觉对象对齐;

- 执行搬运操作。

9.2 智能搜索与推荐

跨模态推理能够实现图文混合搜索,例如:

- 用户上传一张鞋子的照片,并输入“类似的黑色款式”,系统可以检索到相应商品。

- 结合视觉与语言信息,推荐更符合语境的内容。

9.3 医学影像诊断

在医学影像中,AI Agent可结合医生的自然语言描述(如“左肺下叶有结节”)和CT图像进行辅助诊断,提升推理的准确性。

9.4 元宇宙与虚拟人

在虚拟环境中,跨模态推理机制可赋予AI Agent更强的交互能力。例如,虚拟人主播可以基于视觉场景和观众文字提问,做出拟人化的智能回答。

总结

基于视觉-语言融合的AI Agent跨模态推理机制是未来人工智能的重要方向。它不仅能理解图像和文本,还能在两者之间建立语义联系,实现更强的智能推理能力。通过实战代码展示,我们看到AI Agent能够在多模态场景下做出准确判断。未来的研究将聚焦于提升推理能力和降低计算成本,推动AI Agent更好地服务于现实应用。

- 点赞

- 收藏

- 关注作者

评论(0)