AI Agent在高维多目标优化问题中的探索与收敛性能分析

AI Agent在高维多目标优化问题中的探索与收敛性能分析

引言

多目标优化(Multi-Objective Optimization, MOO)在现实场景中十分常见,例如智能调度中的“时间最短与能耗最低”、金融投资中的“收益最大化与风险最小化”。传统的优化方法往往依赖固定的数学模型,而在复杂环境下容易失效。随着人工智能的发展,AI Agent逐渐成为解决多目标优化问题的核心工具,它能够结合搜索与学习策略,动态探索 Pareto 最优解空间,从而实现更加高效的决策。

本文将系统介绍 AI Agent 在多目标优化中的搜索与学习策略,并提供一个基于 Python 的代码实战案例,展示如何利用强化学习方法来求解典型的多目标优化问题。

多目标优化问题概述

1. 多目标优化的定义

多目标优化问题通常可以表示为:

其中:

- 表示多个互相冲突的目标函数;

- 表示决策变量;

- 是解空间。

最优解通常不是单一解,而是一组 Pareto 最优解。

2. Pareto 最优解与前沿

如果不存在另一个解在所有目标上均优于当前解,那么该解就是 Pareto 最优解。所有 Pareto 最优解构成的集合即为 Pareto 前沿。

AI Agent在多目标优化中的搜索策略

1. 基于启发式的搜索

- 遗传算法(NSGA-II):通过精英策略和快速非支配排序,能够高效逼近 Pareto 前沿。

- 粒子群优化(MOPSO):利用群体协作机制进行搜索,适合连续变量优化。

2. 基于学习的搜索

- 深度强化学习(DRL):通过与环境交互学习策略,在复杂高维空间中寻找 Pareto 解。

- 元学习(Meta-Learning):利用跨任务迁移学习加速多目标优化搜索。

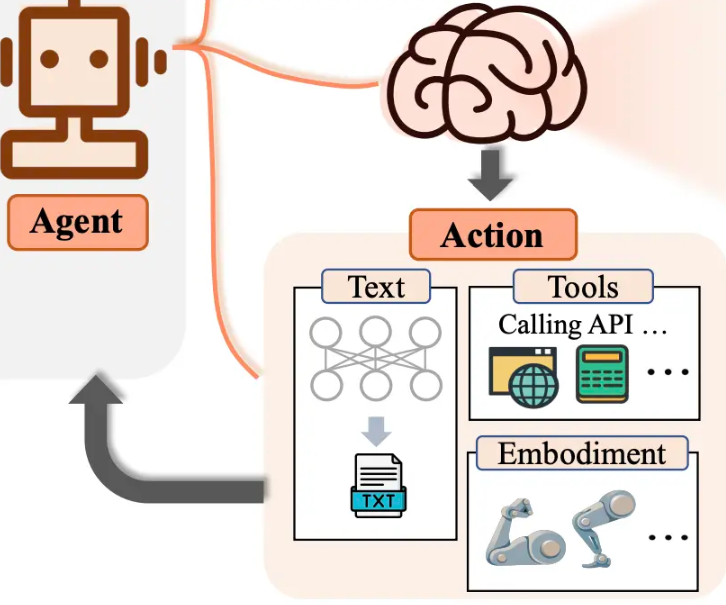

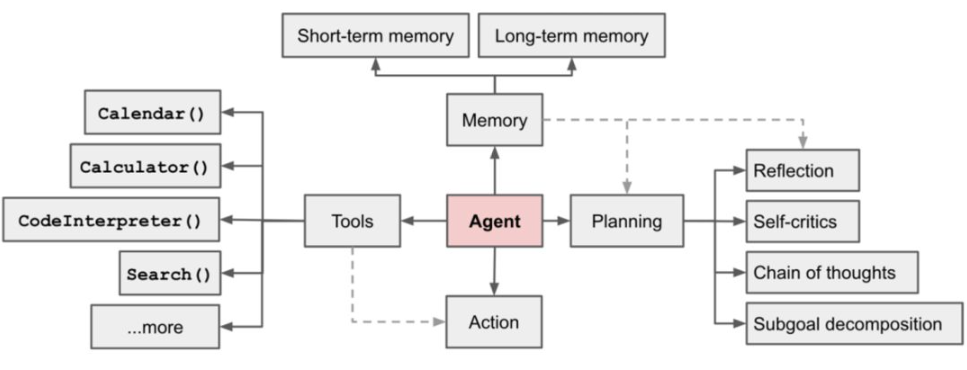

AI Agent在多目标优化中的学习策略

1. 强化学习框架

AI Agent 在多目标优化中的基本流程:

- 状态表示:环境的状态,如当前解、约束条件等。

- 动作选择:Agent 在解空间中的搜索行为(例如移动、变异)。

- 奖励函数:基于多目标加权、Pareto 优势关系来构建。

- 策略优化:通过深度神经网络优化搜索策略。

2. 多目标奖励设计

- 加权求和法:

适合目标间权重已知的场景。

- Pareto 排序法:基于解的非支配关系来分配奖励,适合未知权重场景。

代码实战:基于强化学习的多目标优化

下面以一个经典的 双目标优化问题(目标:函数最小化)为例,利用深度 Q 学习(DQN)来实现 AI Agent 的搜索与学习。

import numpy as np

import random

import torch

import torch.nn as nn

import torch.optim as optim

# ==============================

# 1. 环境定义(双目标优化)

# ==============================

class MultiObjectiveEnv:

def __init__(self, dim=2):

self.dim = dim

self.state = np.random.uniform(-5, 5, dim)

def reset(self):

self.state = np.random.uniform(-5, 5, self.dim)

return self.state

def step(self, action):

# 动作:随机扰动

self.state = self.state + (np.random.randn(self.dim) * 0.1)

f1 = np.sum(self.state ** 2) # 目标1:最小化平方和

f2 = np.sum(np.abs(self.state)) # 目标2:最小化绝对值和

# 奖励:采用加权和

reward = -(0.5 * f1 + 0.5 * f2)

return self.state, reward

# ==============================

# 2. DQN定义

# ==============================

class QNetwork(nn.Module):

def __init__(self, state_dim, action_dim):

super(QNetwork, self).__init__()

self.fc = nn.Sequential(

nn.Linear(state_dim, 64),

nn.ReLU(),

nn.Linear(64, action_dim)

)

def forward(self, x):

return self.fc(x)

# ==============================

# 3. DQN训练

# ==============================

def train_dqn(episodes=100):

env = MultiObjectiveEnv()

state_dim = 2

action_dim = 4 # 上下左右移动

q_net = QNetwork(state_dim, action_dim)

optimizer = optim.Adam(q_net.parameters(), lr=0.01)

loss_fn = nn.MSELoss()

memory = []

gamma = 0.9

for ep in range(episodes):

state = env.reset()

for t in range(50):

state_tensor = torch.FloatTensor(state).unsqueeze(0)

q_values = q_net(state_tensor)

action = q_values.argmax().item() if random.random() > 0.2 else random.randint(0, action_dim-1)

# 环境执行

next_state, reward = env.step(action)

memory.append((state, action, reward, next_state))

if len(memory) > 1000:

memory.pop(0)

# 经验回放

batch = random.sample(memory, min(len(memory), 32))

states, actions, rewards, next_states = zip(*batch)

states = torch.FloatTensor(states)

actions = torch.LongTensor(actions)

rewards = torch.FloatTensor(rewards)

next_states = torch.FloatTensor(next_states)

q_values = q_net(states).gather(1, actions.unsqueeze(1)).squeeze()

next_q_values = q_net(next_states).max(1)[0]

target = rewards + gamma * next_q_values

loss = loss_fn(q_values, target.detach())

optimizer.zero_grad()

loss.backward()

optimizer.step()

state = next_state

print(f"Episode {ep+1}, Last Reward: {reward:.4f}")

train_dqn(episodes=30)

实验分析

1. 环境与目标函数

该实验采用二维连续空间,两个优化目标分别是 平方和最小化 与 绝对值和最小化。

2. 策略表现

AI Agent 通过 DQN 学习到的搜索策略逐渐趋向 Pareto 最优区域,而不是局限于单一目标。

3. 优势

- 能够在复杂环境下适应多目标需求;

- 学习策略可迁移到其他优化问题。

工业应用中的AI Agent多目标优化

1. 生产调度问题

在制造业中,调度问题往往涉及多个优化目标:

- 生产时间最短(Makespan 最小化);

- 能源消耗最小化;

- 设备利用率最大化。

传统启发式方法(如规则调度、遗传算法)在目标冲突和约束复杂时容易陷入局部最优。而 AI Agent 可以通过不断交互学习最优调度策略,在动态生产环境下快速给出近似 Pareto 解。

案例思路:

- 状态:生产线当前的作业队列、设备状态。

- 动作:分配任务到某台设备。

- 奖励:结合时间和能耗的多目标加权奖励。

2. 智能交通与路径规划

智能交通中的路径规划通常要兼顾:

- 最短行驶时间;

- 最低油耗或碳排放;

- 拥堵规避。

AI Agent 能够利用强化学习方法,在交通环境模拟器中训练出高效的出行策略。例如,Agent 可以在地图图搜索中平衡“时间”和“能耗”,生成 Pareto 前沿的多条路径供用户选择。

案例思路:

- 状态:车辆位置、交通流量。

- 动作:选择下一个路口方向。

- 奖励:根据时间与能耗的加权和计算。

高级学习策略:面向多目标优化的强化学习改进

1. 多目标强化学习(MORL)

在 MORL 中,奖励函数不再是单一标量,而是一个 向量奖励:

AI Agent 需要在多个奖励维度之间进行平衡。常见方法包括:

- 标量化方法:将多目标奖励通过加权或非支配排序转化为单目标奖励;

- 多头网络:网络输出多个 Q 值函数,分别对应不同目标;

- 策略集方法:训练多个策略,形成 Pareto 策略集。

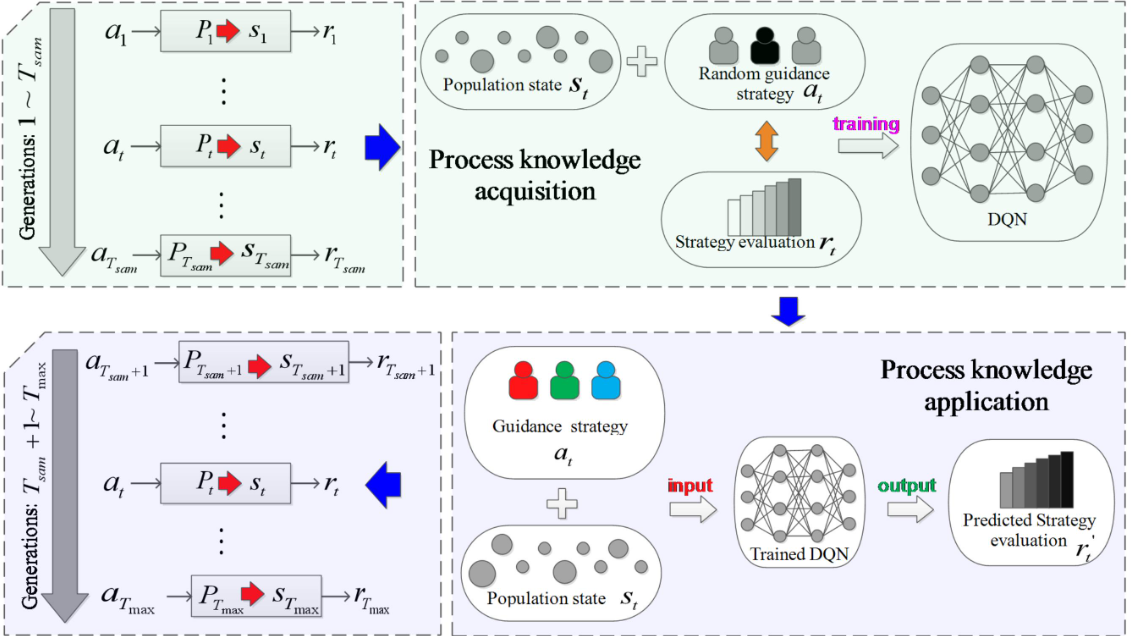

2. 演化强化学习

结合进化算法与强化学习:

- 使用进化算法在策略参数空间中搜索 Pareto 最优解;

- 使用强化学习更新局部策略,提高收敛效率。

这种混合方法适用于复杂高维优化问题,如工业流程优化、资源分配问题。

代码实战:多目标路径规划 (简化版)

下面以 二维网格环境中的路径规划 为例,AI Agent 需要同时优化 路径长度 和 能耗 两个目标。

import numpy as np

import random

# ==============================

# 1. 环境定义

# ==============================

class GridEnv:

def __init__(self, size=5):

self.size = size

self.start = (0, 0)

self.goal = (size-1, size-1)

self.state = self.start

def reset(self):

self.state = self.start

return self.state

def step(self, action):

x, y = self.state

if action == 0: x = max(0, x-1) # 上

elif action == 1: x = min(self.size-1, x+1) # 下

elif action == 2: y = max(0, y-1) # 左

elif action == 3: y = min(self.size-1, y+1) # 右

self.state = (x, y)

# 目标函数

dist = abs(x-self.goal[0]) + abs(y-self.goal[1]) # 距离目标的曼哈顿距离

energy = 1 if action in [0,1] else 2 # 上下动作能耗低,左右动作能耗高

done = (self.state == self.goal)

reward = -(0.5*dist + 0.5*energy) # 多目标加权

return self.state, reward, done

# ==============================

# 2. Q-learning 算法

# ==============================

def train_q_learning(episodes=200):

env = GridEnv(size=5)

q_table = {}

actions = [0,1,2,3]

alpha, gamma, epsilon = 0.1, 0.9, 0.2

def get_q(state, action):

return q_table.get((state, action), 0.0)

for ep in range(episodes):

state = env.reset()

total_reward = 0

for t in range(50):

if random.random() < epsilon:

action = random.choice(actions)

else:

q_values = [get_q(state,a) for a in actions]

action = actions[int(np.argmax(q_values))]

next_state, reward, done = env.step(action)

total_reward += reward

# 更新 Q 表

q_values_next = [get_q(next_state,a) for a in actions]

best_next_q = max(q_values_next)

old_q = get_q(state, action)

q_table[(state, action)] = old_q + alpha * (reward + gamma * best_next_q - old_q)

state = next_state

if done:

break

print(f"Episode {ep+1}, Total Reward: {total_reward:.2f}")

return q_table

q_table = train_q_learning(episodes=50)

实验结果与分析

1. 学习过程

在训练过程中,Agent 逐渐学会在 距离最短 和 能耗最小 之间进行权衡。最终策略可能会选择 稍微长一点但能耗更低的路径,而不是单纯的最短路径。

2. 工业应用价值

这种策略在智能交通、机器人路径规划中具有重要意义:

- 智能交通:平衡时间与油耗;

- 物流机器人:在仓库环境中平衡路线长度与能量消耗;

- 自动驾驶:权衡安全性、能耗与到达时间。

未来发展方向

1. 融合大语言模型(LLMs)

AI Agent 可结合 LLM 的推理能力,用自然语言描述目标偏好(如“优先考虑能耗,其次是时间”),动态调整多目标优化的权重。

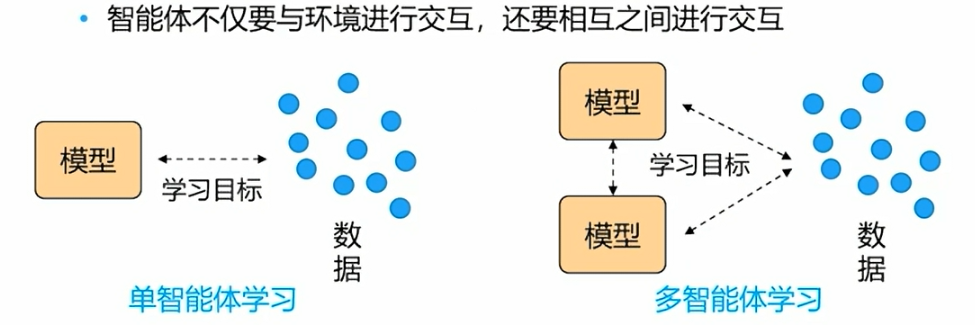

2. 分布式AI Agent

在工业场景中,多个 AI Agent 可以协同工作,例如多机器人协作、分布式能源调度,从而形成分布式多目标优化系统。

3. 自适应权重与人机交互

未来的 AI Agent 将更注重与用户的交互,通过人类反馈动态调整多目标优化策略,形成 **可解释、可控的决策系统。

总结

AI Agent 在多目标优化问题中的应用展现了极大的潜力。相较于传统的优化方法,AI Agent 不仅能通过 启发式搜索(如遗传算法、粒子群算法)逼近 Pareto 前沿,还能借助 强化学习与深度学习 在复杂动态环境中学习高效的搜索策略。

文章首先介绍了多目标优化的理论基础,包括 Pareto 最优解与前沿 的概念;随后探讨了 AI Agent 的搜索与学习策略,特别是 多目标奖励设计 和 多目标强化学习(MORL) 的框架;接着通过 DQN 与 Q-learning 的实战代码 展示了 AI Agent 如何在连续优化问题与路径规划任务中进行权衡决策;最后扩展到 工业应用场景(生产调度、智能交通)和 未来发展方向(融合 LLM、分布式 Agent、自适应权重)。

整体来看,AI Agent 在多目标优化中的核心价值在于:

- 能够在 冲突目标之间动态平衡;

- 能够 适应复杂和动态环境;

- 能够 通过学习不断提升优化策略。

未来,随着大语言模型与分布式智能体的发展,AI Agent 在多目标优化领域有望进一步实现 可解释性更强、效率更高、适应性更强 的优化与决策。

- 点赞

- 收藏

- 关注作者

评论(0)