YOLOv8手势识别项目实战-石头剪刀布实时检测系统

YOLOv8手势识别项目实战-石头剪刀布实时检测系统

项目摘要

本项目结合了 YOLOv8 检测模型 和 PyQt5 图形界面工具,成功实现了石头剪刀布手势的实时识别。支持摄像头、图片、视频等多种输入方式,能够快速识别并显示实时结果。配套完整的源码和训练流程说明,帮助你快速部署并定制自己的手势识别系统,源码与详细教程链接将在文末提供。

前言

在人工智能的快速发展中,图像识别技术的应用逐渐深入到各个领域。手势识别作为人机交互的一种重要方式,广泛应用于游戏、智能家居、医疗等场景。YOLOv8作为一种高效、快速的目标检测框架,因其出色的实时处理能力被广泛应用于图像识别任务。本项目结合YOLOv8与PyQt5,搭建了一套石头剪刀布手势识别系统,旨在为开发者提供一个高效且易于扩展的方案。

一、软件核心功能介绍及效果演示

1.1 YOLOv8模型训练

本节介绍YOLOv8模型的训练过程:

- 数据集准备:我们使用了标注好的石头剪刀布手势数据集,确保数据的多样性和训练的效果。

- 训练流程:详细讲解如何使用YOLOv8进行训练,包括超参数设置、训练数据预处理及模型评估。

- 模型优化:包括使用不同的技巧(如数据增强、学习率调整等)来提高模型性能。

1.2 实时手势识别

- 视频输入:使用摄像头或视频文件输入,YOLOv8实时识别手势。

- 图形界面:结合PyQt5搭建的图形界面,展示实时识别结果及对应的概率。

- 精度展示:实时显示每一帧图像的识别结果和置信度,用户可以清晰看到识别过程。

1.3 多输入方式支持

- 图片识别:用户可以直接加载本地图片进行手势识别,支持多种格式(如JPG、PNG)。

- 视频识别:用户可选择视频文件作为输入,系统会自动识别视频中的手势。

- 摄像头实时识别:通过电脑的摄像头进行实时手势识别,并将结果实时展示在界面上。

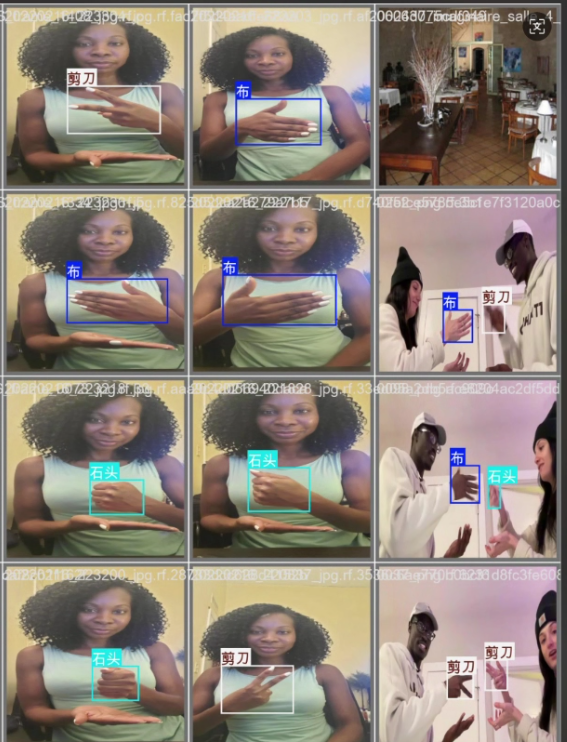

二、软件效果演示

为了直观展示本系统基于 YOLOv8 模型的检测能力,我们设计了多种操作场景,涵盖静态图片、批量图片、视频以及实时摄像头流的检测演示。

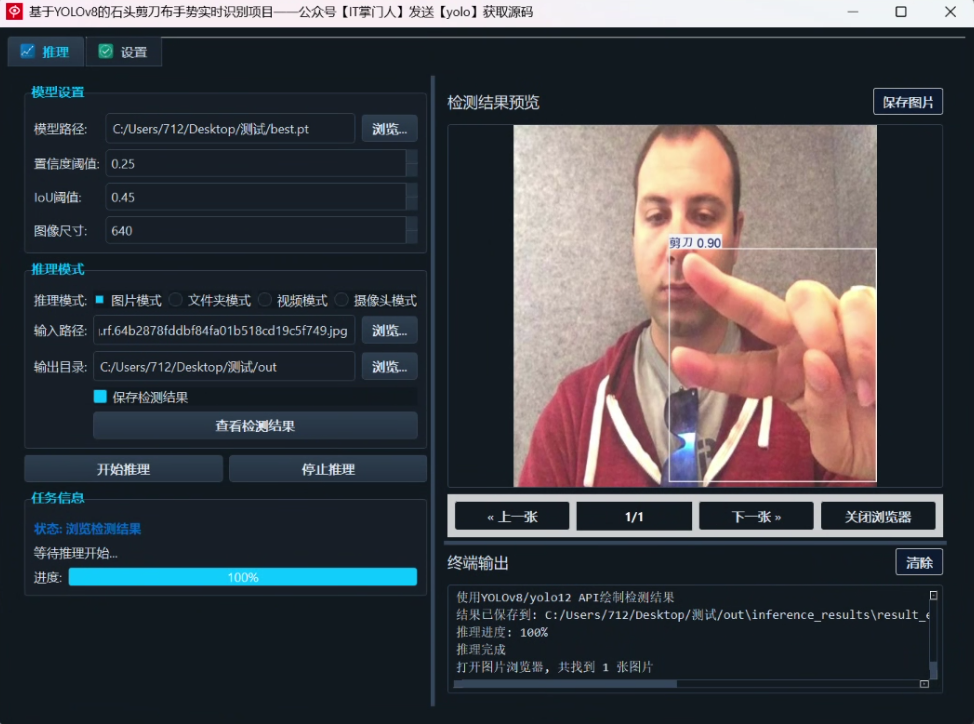

(1)单图片检测演示

用户点击“选择图片”,即可加载本地图像并执行检测:

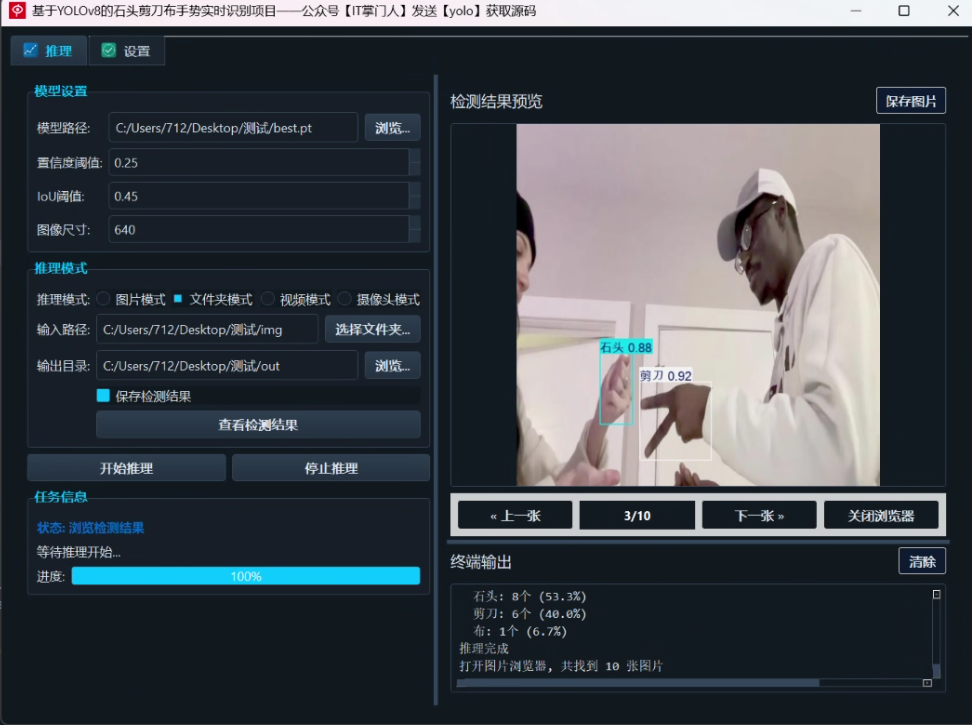

(2)多文件夹图片检测演示

用户可选择包含多张图像的文件夹,系统会批量检测并生成结果图。

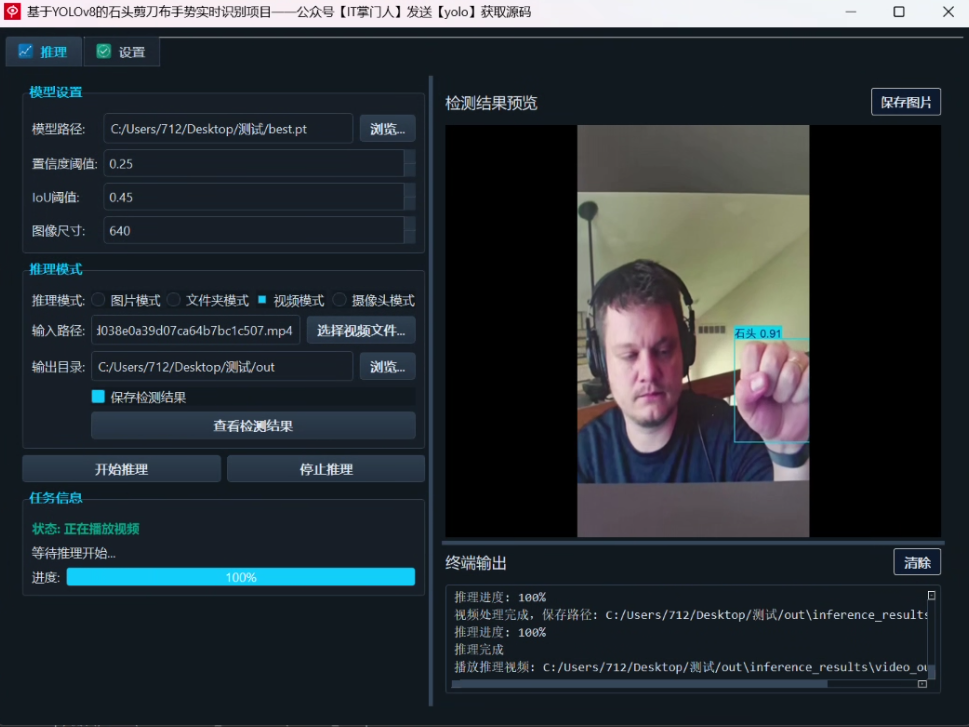

(3)视频检测演示

支持上传视频文件,系统会逐帧处理并生成目标检测结果,可选保存输出视频:

(4)摄像头检测演示

实时检测是系统中的核心应用之一,系统可直接调用摄像头进行检测。由于原理和视频检测相同,就不重复演示了。

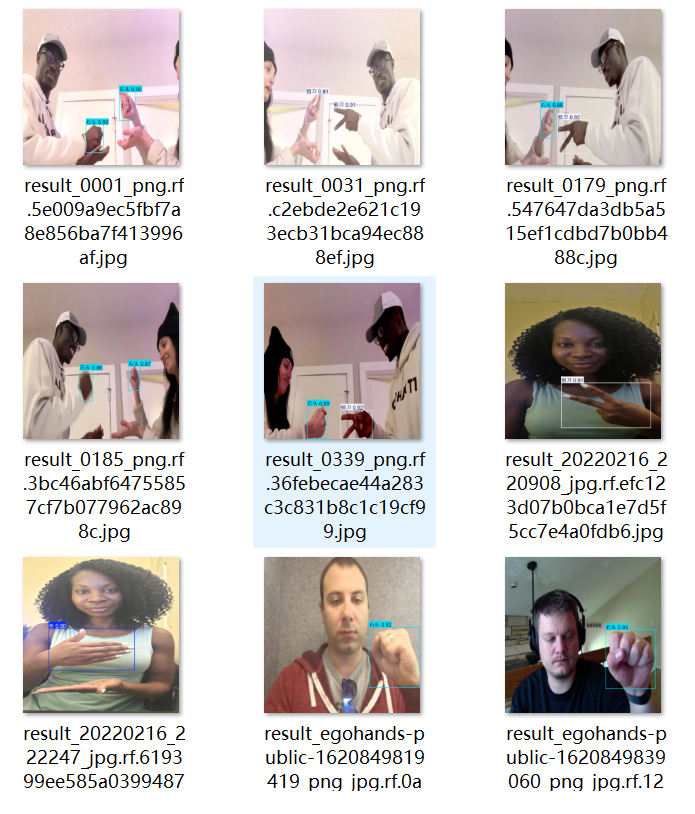

(5)保存图片与视频检测结果

用户可通过按钮勾选是否保存检测结果,所有检测图像自动加框标注并保存至指定文件夹,支持后续数据分析与复审。

三、模型的训练、评估与推理

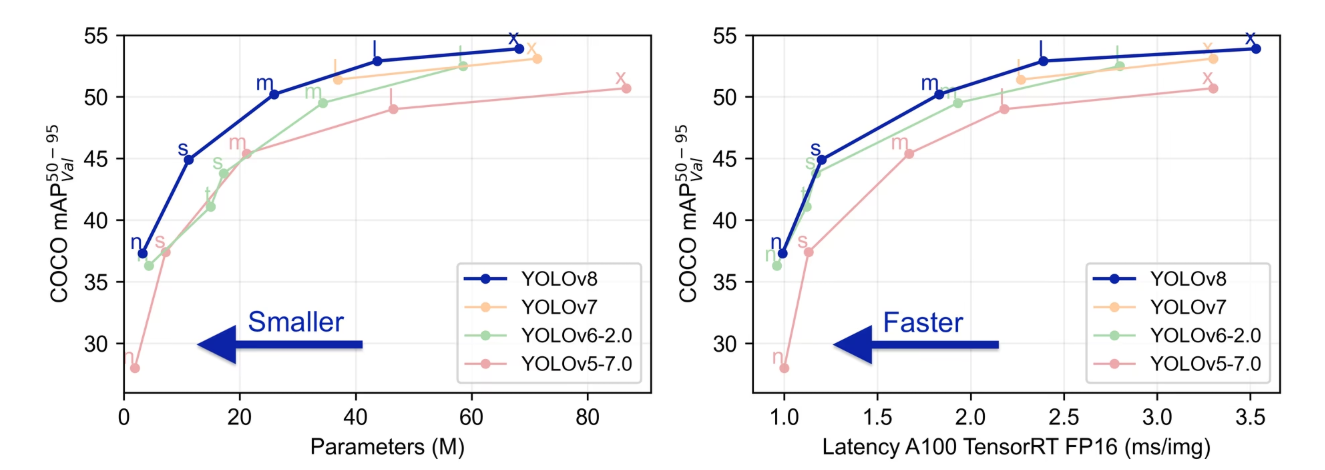

YOLOv8是Ultralytics公司发布的新一代目标检测模型,采用更轻量的架构、更先进的损失函数(如CIoU、TaskAlignedAssigner)与Anchor-Free策略,在COCO等数据集上表现优异。

其核心优势如下:

- 高速推理,适合实时检测任务

- 支持Anchor-Free检测

- 支持可扩展的Backbone和Neck结构

- 原生支持ONNX导出与部署

3.1 YOLOv8的基本原理

YOLOv8 是 Ultralytics 发布的新一代实时目标检测模型,具备如下优势:

- 速度快:推理速度提升明显;

- 准确率高:支持 Anchor-Free 架构;

- 支持分类/检测/分割/姿态多任务;

- 本项目使用 YOLOv8 的 Detection 分支,训练时每类表情均标注为独立目标。

YOLOv8 由Ultralytics 于 2023 年 1 月 10 日发布,在准确性和速度方面具有尖端性能。在以往YOLO 版本的基础上,YOLOv8 引入了新的功能和优化,使其成为广泛应用中各种物体检测任务的理想选择。

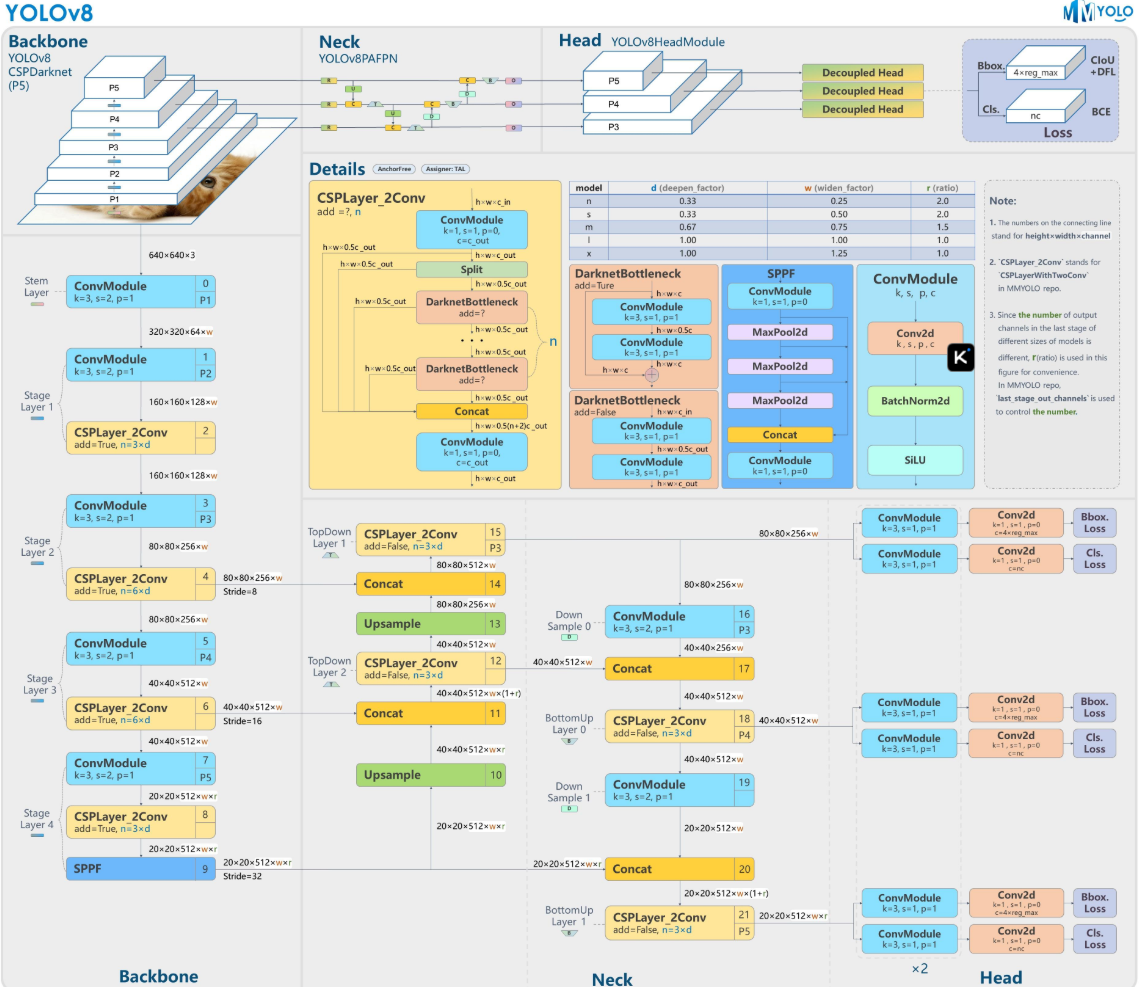

YOLOv8原理图如下:

3.2 数据集准备与训练

采用 YOLO 格式的数据集结构如下:

dataset/

├── images/

│ ├── train/

│ └── val/

├── labels/

│ ├── train/

│ └── val/

每张图像有对应的 .txt 文件,内容格式为:

4 0.5096721233576642 0.352838390077821 0.3947600423357664 0.31825755058365757

分类包括(可自定义):

3.3. 训练结果评估

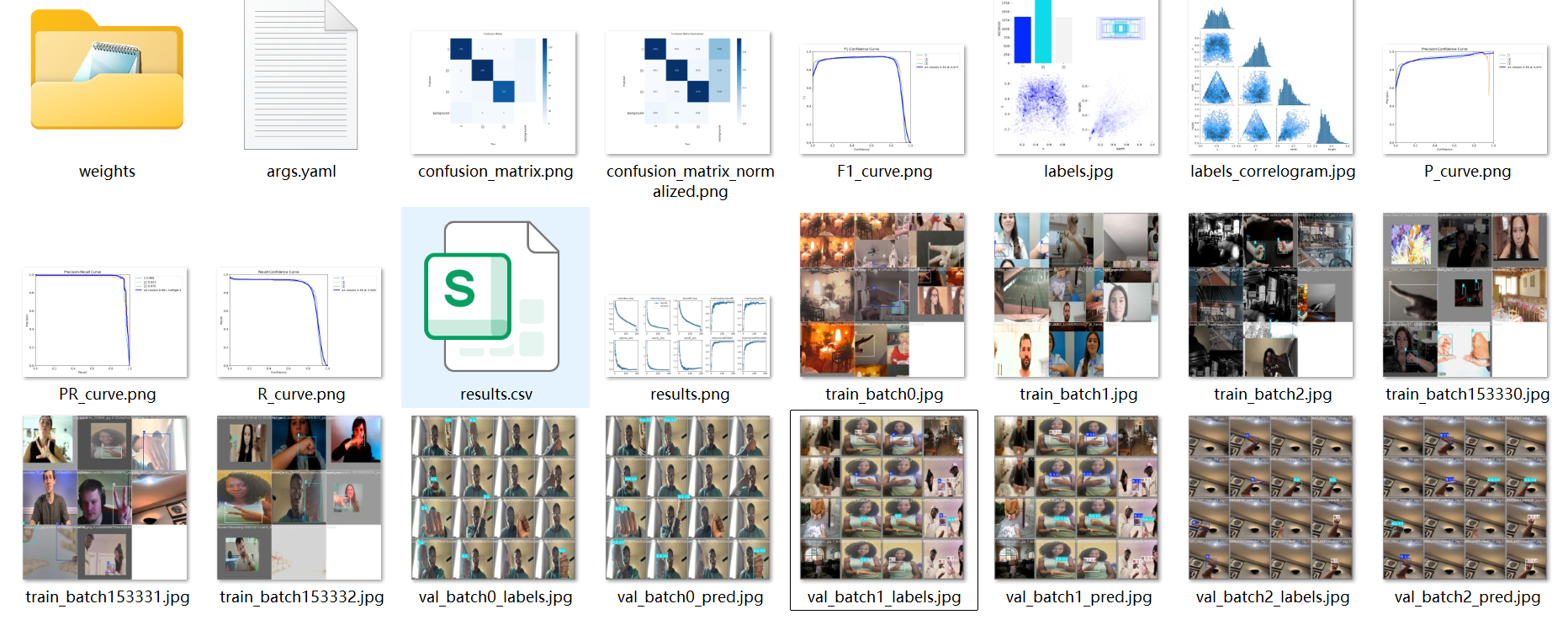

训练完成后,将在 runs/detect/train 目录生成结果文件,包括:

results.png:损失曲线和 mAP 曲线;weights/best.pt:最佳模型权重;confusion_matrix.png:混淆矩阵分析图。

若 mAP@0.5 达到 90% 以上,即可用于部署。

在深度学习领域,我们通常通过观察损失函数下降的曲线来评估模型的训练状态。YOLOv8训练过程中,主要包含三种损失:定位损失(box_loss)、分类损失(cls_loss)和动态特征损失(dfl_loss)。训练完成后,相关的训练记录和结果文件会保存在runs/目录下,具体内容如下:

3.4检测结果识别

使用 PyTorch 推理接口加载模型:

import cv2

from ultralytics import YOLO

import torch

from torch.serialization import safe_globals

from ultralytics.nn.tasks import DetectionModel

# 加入可信模型结构

safe_globals().add(DetectionModel)

# 加载模型并推理

model = YOLO('runs/detect/train/weights/best.pt')

results = model('test.jpg', save=True, conf=0.25)

# 获取保存后的图像路径

# 默认保存到 runs/detect/predict/ 目录

save_path = results[0].save_dir / results[0].path.name

# 使用 OpenCV 加载并显示图像

img = cv2.imread(str(save_path))

cv2.imshow('Detection Result', img)

cv2.waitKey(0)

cv2.destroyAllWindows()

预测结果包含类别、置信度、边框坐标等信息。

四.YOLOV8+YOLOUI完整源码打包

本文涉及到的完整全部程序文件:包括python源码、数据集、训练代码、UI文件、测试图片视频等(见下图),获取方式见【4.2 完整源码下载】:

4.1 项目开箱即用

作者已将整个工程打包。包含已训练完成的权重,读者可不用自行训练直接运行检测。

运行项目只需输入下面命令。

python main.py

读者也可自行配置训练集,或使用打包好的数据集直接训练。

自行训练项目只需输入下面命令。

yolo detect train data=datasets/expression/loopy.yaml model=yolov8n.yaml pretrained=yolov8n.pt epochs=100 batch=16 lr0=0.001

4.2 完整源码下载

可至项目实录视频下方获取:https://www.bilibili.com/video/BV1fn8tzqEm6/

包含:

📦完整项目源码

📦 预训练模型权重

🗂️ 数据集地址(含标注脚本)

总结

本项目通过结合 YOLOv8 高效目标检测算法 与 PyQt5 图形界面开发工具,实现了一个实用且具备扩展性的 石头剪刀布手势实时识别系统。从数据准备、模型训练到界面交互与实时识别,项目构建了一条完整的深度学习应用链路,具有以下几个突出亮点:

- 模型性能优秀:依托YOLOv8强大的检测能力,实现了对石头、剪刀、布三类手势的快速、准确识别;

- 输入方式灵活:支持图像、视频与实时摄像头输入,满足多种使用场景;

- 界面交互友好:基于PyQt5开发的图形化界面降低了操作门槛,用户无需了解代码即可使用;

- 训练流程完整:提供完整数据集与训练脚本,适合学习和二次开发;

- 部署开箱即用:从模型训练到界面交互,打通了从研究到应用的最后一步。

本项目不仅适用于AI学习者进行实战训练,也可作为教学、娱乐或智能交互系统的基础模块。在未来,可以扩展更多手势类型,结合手势动作序列进行多模态识别,或与游戏/机器人系统结合,提升交互智能性。

- 点赞

- 收藏

- 关注作者

评论(0)