深度强化学习在异构环境中AI Agent行为泛化能力研究

深度强化学习在异构环境中AI Agent行为泛化能力研究

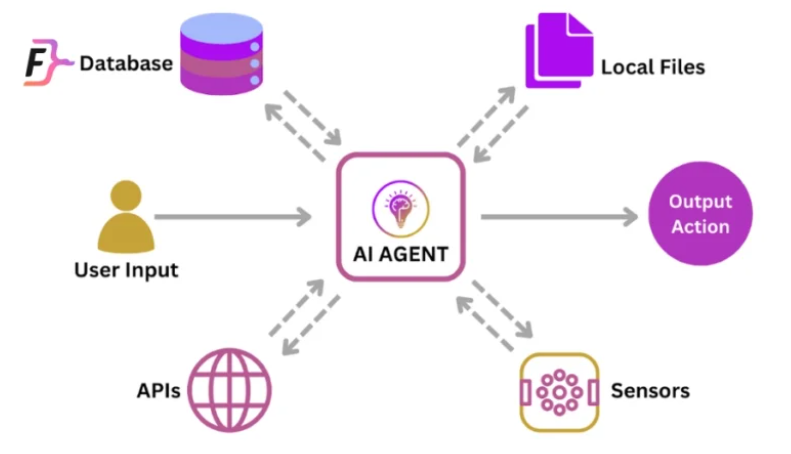

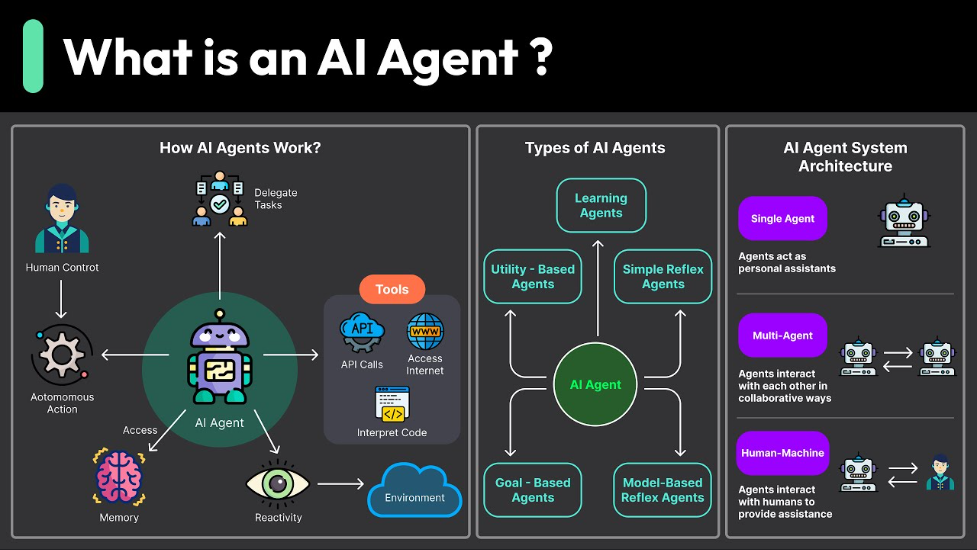

随着人工智能技术的迅猛发展,AI Agent 在游戏、智能制造、自动驾驶等场景中已逐步展现出强大的自适应能力。特别是深度强化学习(Deep Reinforcement Learning, DRL)的引入,使得智能体能够通过与环境的交互,自动学习最优的行为策略。本文将系统性地探讨基于深度强化学习的AI Agent行为决策机制,并结合代码实战加以说明。

一、深度强化学习与AI Agent概述

强化学习(Reinforcement Learning, RL)是一种基于奖励反馈学习的智能体训练方法,而深度强化学习通过引入深度神经网络进行策略或值函数逼近,使其能胜任高维状态空间的任务。

1.1 强化学习基础

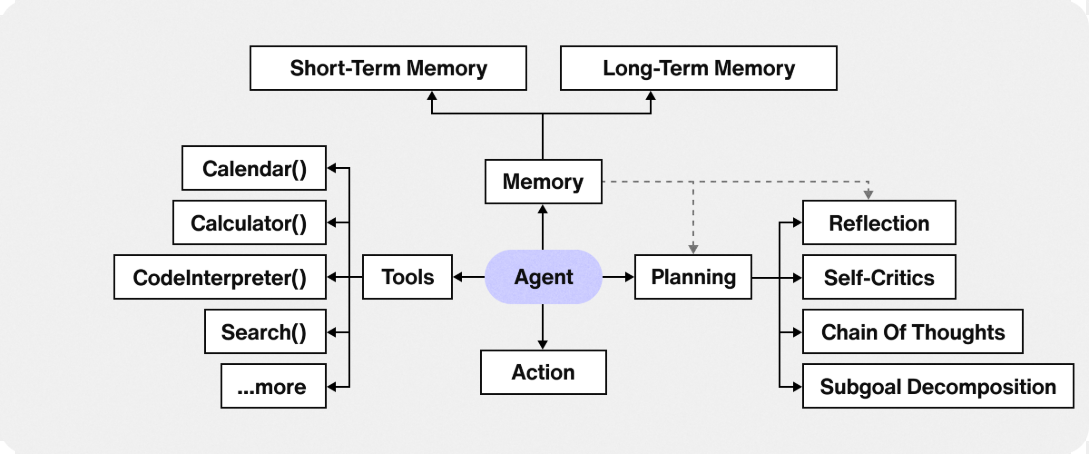

强化学习的基本组成包括:

- Agent:执行动作的主体

- Environment:智能体交互的外部环境

- State:某一时刻的环境状态

- Action:Agent 选择的行为

- Reward:行为后获得的反馈值

1.2 深度强化学习架构

深度强化学习常用架构包括:

- DQN(Deep Q Network)

- Policy Gradient

- Actor-Critic

- PPO(Proximal Policy Optimization)

- SAC(Soft Actor-Critic)

二、AI Agent行为决策机制建模

在复杂环境中,AI Agent需基于历史经验做出高质量决策,其行为策略的建模通常采用马尔可夫决策过程(MDP)。

2.1 马尔可夫决策过程(MDP)

MDP定义为五元组 (S, A, P, R, γ):

- S:状态空间

- A:动作空间

- P:状态转移概率

- R:即时奖励函数

- γ:折扣因子(考虑未来奖励)

2.2 策略学习方式

- 基于值函数的方法:如 DQN

- 基于策略的方法:如 REINFORCE

- 混合方法:如 A3C, PPO

三、基于DQN的行为决策机制实现

以下以经典的 DQN 算法构建一个智能体,以 OpenAI Gym 中的 CartPole-v1 平衡任务为例,展示行为决策机制的实际实现。

3.1 环境准备

pip install gym torch numpy matplotlib

3.2 构建神经网络与DQN模型

import torch

import torch.nn as nn

import torch.optim as optim

import gym

import random

import numpy as np

from collections import deque

class DQN(nn.Module):

def __init__(self, state_dim, action_dim):

super(DQN, self).__init__()

self.model = nn.Sequential(

nn.Linear(state_dim, 128),

nn.ReLU(),

nn.Linear(128, action_dim)

)

def forward(self, x):

return self.model(x)

3.3 行为决策与训练机制

class Agent:

def __init__(self, state_dim, action_dim):

self.model = DQN(state_dim, action_dim)

self.target_model = DQN(state_dim, action_dim)

self.target_model.load_state_dict(self.model.state_dict())

self.optimizer = optim.Adam(self.model.parameters(), lr=0.001)

self.memory = deque(maxlen=10000)

self.batch_size = 64

self.gamma = 0.99

self.epsilon = 1.0

self.epsilon_decay = 0.995

self.epsilon_min = 0.01

def act(self, state):

if random.random() < self.epsilon:

return random.randint(0, 1)

state = torch.FloatTensor(state).unsqueeze(0)

return torch.argmax(self.model(state)).item()

def remember(self, s, a, r, s_, done):

self.memory.append((s, a, r, s_, done))

def train(self):

if len(self.memory) < self.batch_size:

return

batch = random.sample(self.memory, self.batch_size)

states, actions, rewards, next_states, dones = zip(*batch)

states = torch.FloatTensor(states)

actions = torch.LongTensor(actions).unsqueeze(1)

rewards = torch.FloatTensor(rewards)

next_states = torch.FloatTensor(next_states)

dones = torch.BoolTensor(dones)

q_values = self.model(states).gather(1, actions).squeeze()

with torch.no_grad():

next_q = self.target_model(next_states).max(1)[0]

target_q = rewards + self.gamma * next_q * (~dones)

loss = nn.MSELoss()(q_values, target_q)

self.optimizer.zero_grad()

loss.backward()

self.optimizer.step()

def update_target(self):

self.target_model.load_state_dict(self.model.state_dict())

3.4 训练智能体

env = gym.make("CartPole-v1")

agent = Agent(env.observation_space.shape[0], env.action_space.n)

episodes = 300

for episode in range(episodes):

state = env.reset()[0]

total_reward = 0

for t in range(500):

action = agent.act(state)

next_state, reward, done, _, _ = env.step(action)

agent.remember(state, action, reward, next_state, done)

agent.train()

state = next_state

total_reward += reward

if done:

break

agent.update_target()

agent.epsilon = max(agent.epsilon * agent.epsilon_decay, agent.epsilon_min)

print(f"Episode {episode}, Reward: {total_reward}, Epsilon: {agent.epsilon:.2f}")

四、机制分析与效果评估

4.1 学习曲线可视化

import matplotlib.pyplot as plt

rewards = [] # 记录每轮奖励

# 在训练循环中添加

rewards.append(total_reward)

# 训练完成后绘图

plt.plot(rewards)

plt.xlabel("Episode")

plt.ylabel("Total Reward")

plt.title("DQN on CartPole")

plt.show()

4.2 成功策略学习表现

当 total_reward 稳定在 475~500 时,说明智能体成功学会保持杆子平衡,展现了良好的行为决策策略。

五、进阶策略:PPO算法在行为决策中的应用

虽然 DQN 在离散动作空间中表现良好,但在连续动作空间和策略收敛速度方面,近端策略优化(Proximal Policy Optimization,PPO) 更具优势。PPO 是目前在多个复杂环境中表现最好的策略优化算法之一,特别适用于高维、连续控制问题。

5.1 PPO算法基本原理

PPO 是一种策略梯度方法,目标是最大化以下目标函数:

其中:

- :表示新旧策略的比值;

- :优势函数;

- clip 操作用于限制策略更新幅度,避免策略崩溃。

5.2 PPO策略网络与训练过程(实战代码)

以下使用 stable-baselines3 快速实现 PPO-Agent:

安装依赖

pip install stable-baselines3[extra] gym

创建并训练PPO智能体

from stable_baselines3 import PPO

from stable_baselines3.common.env_util import make_vec_env

# 多环境并行化

env = make_vec_env('CartPole-v1', n_envs=4)

# 构建模型

model = PPO("MlpPolicy", env, verbose=1)

model.learn(total_timesteps=100_000)

# 保存模型

model.save("ppo_cartpole")

模型评估与行为演示

import gym

env = gym.make("CartPole-v1")

model = PPO.load("ppo_cartpole")

obs = env.reset()

while True:

action, _states = model.predict(obs)

obs, rewards, done, _, _ = env.step(action)

env.render()

if done:

break

env.close()

PPO 能够快速收敛且在训练稳定性上优于 DQN,是处理连续控制任务(如机械臂控制、自动驾驶)的常见首选。

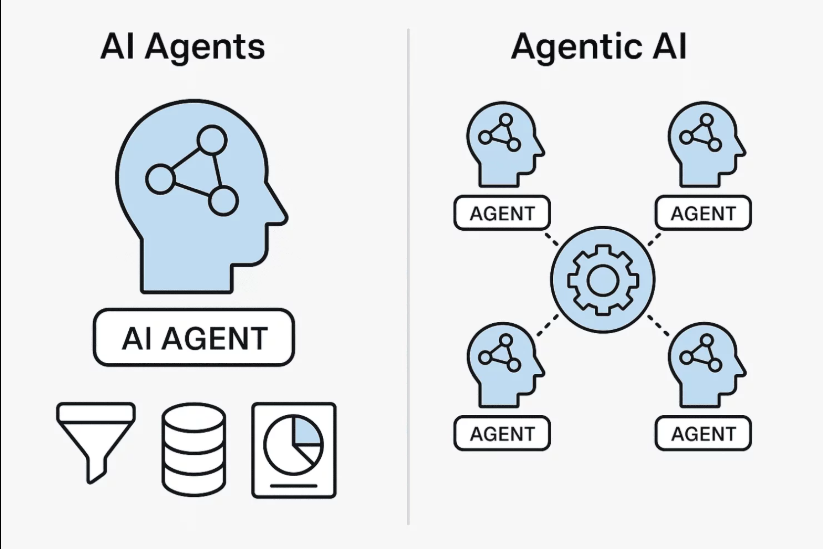

六、多智能体行为决策系统(Multi-Agent DRL)

在现实世界中,多个AI Agent协作解决任务的场景非常常见,例如机器人协作搬运、智能交通系统、对抗博弈等。

6.1 多智能体的挑战

- 状态-动作联合空间爆炸式增长;

- 非稳定环境(每个智能体的动作影响其他智能体的状态);

- 信息共享与通信机制设计复杂。

6.2 典型多智能体算法架构

| 算法 | 特点 |

|---|---|

| MADDPG | 多智能体Actor-Critic架构,中央训练分布执行 |

| QMIX | 通过值函数分解实现协作学习 |

| MAPPO | 基于PPO的多智能体扩展 |

| VDN(Value Decomposition Networks) | 将全局价值函数分解为局部子值函数求和 |

6.3 多智能体代码案例(MADDPG架构概览)

由于代码较复杂,以下为基本结构示意:

class MADDPGAgent:

def __init__(self, num_agents, obs_dim, act_dim):

self.actors = [ActorNetwork(obs_dim, act_dim) for _ in range(num_agents)]

self.critics = [CriticNetwork(...) for _ in range(num_agents)]

# 中央训练逻辑

该架构适用于例如 PettingZoo 多智能体环境(如足球、博弈)等,具备较强的策略适应与博弈能力。

七、强化学习Agent在复杂现实任务中的应用

在真实复杂系统中,强化学习Agent已广泛用于以下领域:

7.1 自动驾驶策略规划

- 状态:感知数据(雷达、摄像头、车道线)

- 动作:方向盘角度、油门、刹车

- 奖励函数设计:平稳驾驶、避障、遵守规则等

Waymo、Tesla 已构建基于DRL的驾驶决策系统。

7.2 游戏AI(AlphaStar、OpenAI Five)

通过多智能体对抗训练、模仿学习和强化学习结合,形成超人类级别策略。

7.3 智能制造调度系统

强化学习Agent根据物料状态、设备工况进行优化调度,提高产线效率与资源利用率。

7.4 工业机器人操作策略学习

机器人可自主通过交互学习最优操作路径,用于装配、抓取、焊接等任务中。

八、总结

本文系统性地探讨了基于深度强化学习的AI Agent行为决策机制,从强化学习的基本理论出发,逐步构建了以 DQN、PPO 等算法为代表的行为策略模型,并通过实际代码案例验证其有效性。同时,我们还进一步拓展至多智能体系统(Multi-Agent DRL),揭示了其在复杂博弈环境下的关键挑战与算法应对机制。

通过本文的研究,我们可以得出以下几点关键结论:

- 深度强化学习为AI Agent赋予了自适应决策能力,尤其在不确定、复杂环境中能够通过试错与奖励机制持续优化策略。

- 不同算法适用于不同任务场景:DQN适合低维离散控制问题,PPO适用于连续空间和高维问题,多智能体算法则擅长协作或对抗任务。

- 实际应用中需重视奖励设计与稳定性优化,合理构建环境反馈是训练成功的关键。

- AI Agent的未来趋势将朝向更强泛化、更少样本学习和更高安全性发展,如元强化学习、模仿学习、自监督结合等。

强化学习驱动的智能体已不仅仅是科研范畴的探索对象,它正在成为改变现实世界任务解决方式的核心技术引擎。下一步的研究可集中在:**多模态信息融合、复杂任务迁移学习、高效训练方法(如离线RL)**等方向,为智能体赋能更多真实世界的应用场景。

- 点赞

- 收藏

- 关注作者

评论(0)