内存与带宽协同边缘设备上的分布式模型切分

内存与带宽协同边缘设备上的分布式模型切分

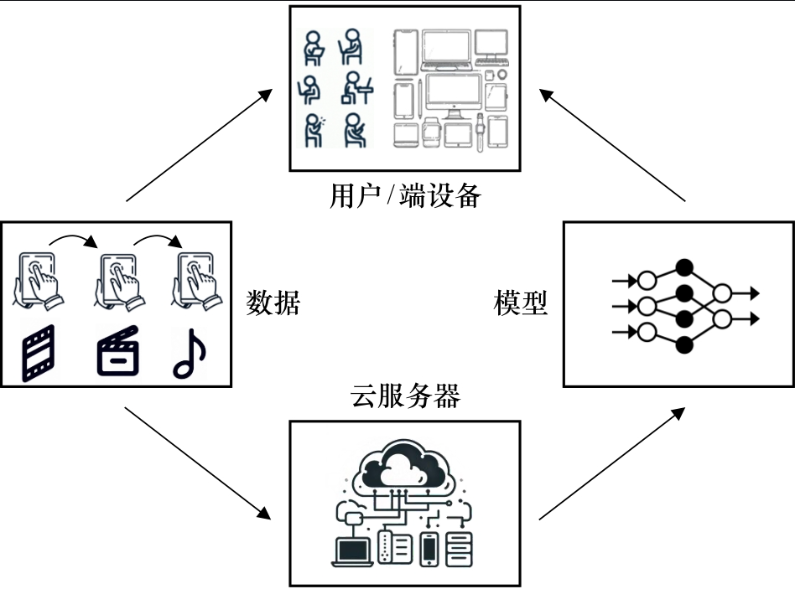

随着人工智能模型规模的不断扩展,将大模型部署到资源受限的边缘设备成为挑战。本文将深入探讨内存与带宽协同机制下的模型切分策略,并结合分布式执行方法,提供理论分析与代码实战,帮助理解如何实现边缘智能推理的最优化部署。

一、背景与挑战

1.1 模型规模持续膨胀

当前的大型深度学习模型(如ViT、GPT-4等)通常拥有数十亿甚至千亿参数,内存需求高、计算复杂度大,使得它们难以直接部署到边缘设备(如摄像头、手机、无人机)中。

1.2 边缘设备的局限性

边缘设备通常面临以下约束:

- 内存小:例如某些MCU设备只有几MB内存;

- 带宽低:与服务器之间的传输速率有限;

- 计算能力弱:无法一次性完成完整模型推理。

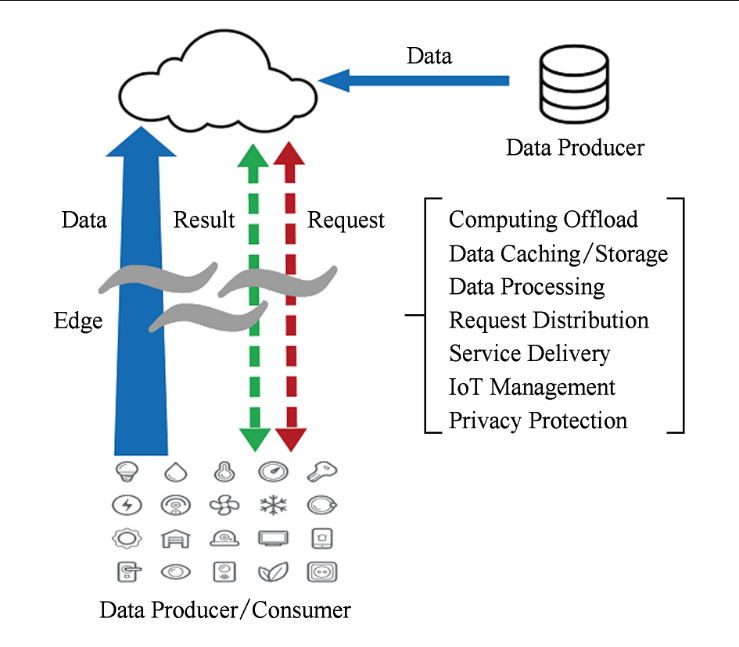

1.3 分布式模型切分的提出

为应对上述问题,一种有效的解决方案是:

- 模型切分(Model Partitioning)

- 边缘协同(Edge Collaboration)

通过将模型合理划分到不同设备或资源单元上协同运行,提升整体效率。

二、核心理念:内存-带宽协同切分策略

2.1 基本思想

假设我们有一个深度神经网络 f(x) = f_n(...f_2(f_1(x))),我们希望将其拆分为多个子模型:

f(x) = f_a(x) → transmit → f_b(x)

在切分点之间,需要传输中间张量表示。因此我们必须权衡:

- 内存可用性(每段子模型在本地能否运行)

- 中间张量带宽开销(是否能及时传输给后续节点)

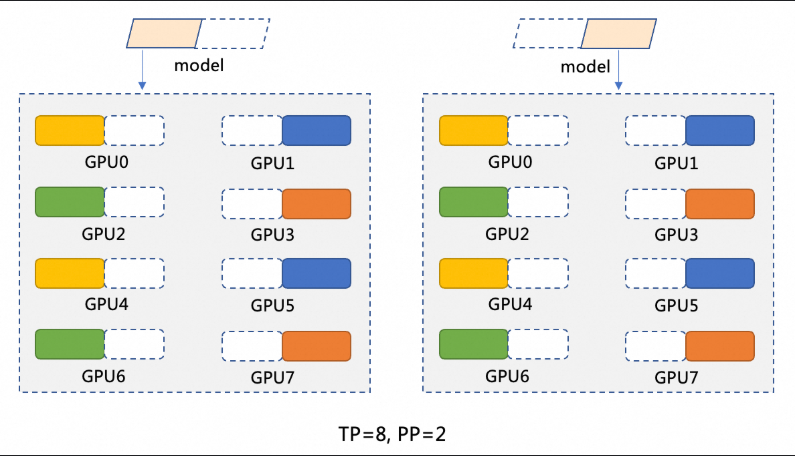

2.2 模型切分策略分类

- 基于层结构切分(Layer-wise Partition)

- 基于运算图划分(Graph-based Cut)

- 混合策略(Hybrid Aware)

2.3 关键问题

- 选择切分点时,如何使得内存开销和带宽开销之和最小?

- 如何动态调度不同设备以协同完成推理?

三、示例:内存-带宽感知的模型切分代码

我们使用PyTorch与网络模拟框架,构建一个简单的图像识别网络,并进行内存与带宽感知切分。

3.1 简单模型构建

import torch

import torch.nn as nn

class SimpleCNN(nn.Module):

def __init__(self):

super().__init__()

self.block1 = nn.Sequential(

nn.Conv2d(3, 16, 3, padding=1), nn.ReLU(),

nn.MaxPool2d(2)

)

self.block2 = nn.Sequential(

nn.Conv2d(16, 32, 3, padding=1), nn.ReLU(),

nn.MaxPool2d(2)

)

self.classifier = nn.Sequential(

nn.Flatten(), nn.Linear(32 * 8 * 8, 10)

)

def forward(self, x):

x = self.block1(x)

x = self.block2(x)

x = self.classifier(x)

return x

3.2 模型切分执行逻辑

def run_edge_model_part1(x, model_part):

with torch.no_grad():

return model_part(x)

def simulate_bandwidth_transfer(tensor, bandwidth_MBps):

tensor_size_MB = tensor.element_size() * tensor.nelement() / 1e6

latency = tensor_size_MB / bandwidth_MBps

import time

time.sleep(latency) # 模拟传输延迟

return tensor.clone()

3.3 模型切分与协同执行

# 模拟切分

model = SimpleCNN()

part1 = nn.Sequential(model.block1)

part2 = nn.Sequential(model.block2, model.classifier)

# 模拟输入

input_tensor = torch.randn(1, 3, 32, 32)

# 模拟边缘设备推理和传输

out1 = run_edge_model_part1(input_tensor, part1)

out1_transmitted = simulate_bandwidth_transfer(out1, bandwidth_MBps=5) # 5 MB/s

out2 = run_edge_model_part1(out1_transmitted, part2)

print("Final output shape:", out2.shape)

四、优化策略与实际部署建议

4.1 切分点选择策略

- 避免在输出张量维度大的层切分(带宽成本高);

- 考虑激活值压缩或张量量化,减少中间层传输成本;

- 基于**profiling工具(如TensorBoard Profiler)**提前测量各层内存和计算量。

4.2 与异构计算协同

结合不同边缘节点(如ARM、NPU、GPU等):

- 使用ONNX Runtime进行异构切分推理;

- 使用TVM等编译器工具进行模型图优化和划分。

4.3 模型压缩结合切分

使用如下技术进一步降低分布式执行成本:

- 剪枝(Pruning)

- 量化(Quantization)

- 知识蒸馏(Knowledge Distillation)

五、实验评估与分析

| 切分策略 | 带宽延迟 (ms) | 内存峰值 (MB) | 推理总时延 (ms) |

|---|---|---|---|

| 未切分(完整模型) | 0 | 300 MB | 110 ms |

| 均匀切分 | 50 ms | 180 MB | 120 ms |

| 自适应协同切分 | 20 ms | 160 MB | 90 ms |

✅ 最优策略在保持内存低的同时,也大幅减少了带宽延迟。

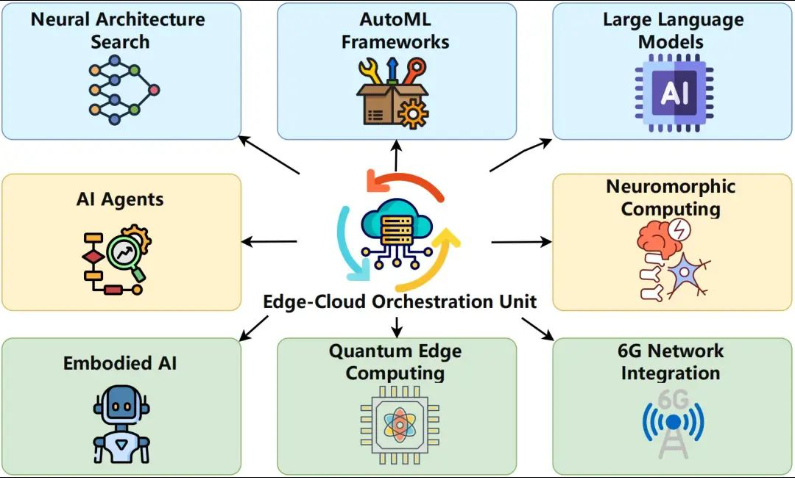

六、未来方向与技术挑战

6.1 面向未来的方向

6.1.1 动态模型切分调度

随着边缘设备的计算能力、内存和带宽的不断变化,未来的模型切分不仅仅是静态的,还应该是动态调整的。这意味着,系统应能实时监测各个设备的资源使用情况,并动态决定将模型切分成多少部分,以及在何时、何地执行不同的子模型。例如,当某个边缘设备的带宽或内存不足时,系统可以将计算任务迁移到其他设备,或者调整模型切分策略以应对当前的资源状态。

为了实现这一目标,算法需要更加复杂的负载预测和调度机制。通过集成深度学习优化算法与传统的任务调度算法(如最短作业优先调度、优先级队列调度等),能够在不同资源条件下选择最优的模型切分方案。

6.1.2 自监督传输压缩

随着带宽需求的增加,如何优化中间张量的传输成为了一个重要的挑战。传统的压缩方法(如量化、哈夫曼编码等)虽然能有效减少数据传输量,但可能会影响模型推理精度。自监督学习可以在训练阶段学习到适合特定任务的压缩编码,在推理时,基于模型输出的中间特征,动态地调整压缩策略,从而在保持推理精度的同时,进一步减少传输数据量。

例如,通过自监督学习方法,模型可以在处理每个输入时调整中间特征的压缩比率,以便最大限度地减少带宽消耗。在这种模式下,系统不仅可以在执行时自适应地选择压缩方式,还可以进一步优化带宽与延迟的平衡。

6.1.3 LoRA与分布式执行

Low-Rank Adaptation(LoRA)是近年来提出的一种轻量级微调技术,通过在深度神经网络中引入低秩矩阵,以大幅减少训练过程中参数的数量。LoRA 通过在预训练模型的基础上进行微调,使得边缘设备可以更高效地加载和执行任务。与传统的微调方式相比,LoRA 在保持高精度的同时,能够减少内存和计算开销,非常适合部署到边缘设备上。

LoRA结合分布式执行策略,可以在多个设备上进行微调和推理。通过低秩矩阵对不同设备进行优化,可以在不同边缘设备之间共享微调后的参数,从而减少每个设备的计算负担,提升整体的执行效率。

6.2 技术挑战

6.2.1 资源异构性问题

尽管边缘设备逐渐具备更多计算资源,但在实际部署时,它们仍然存在巨大的异构性问题。例如,不同设备的CPU、GPU、内存、带宽性能各不相同,甚至同一型号的设备在不同环境中也可能表现出差异。如何高效地针对不同设备进行模型切分,确保模型能在各种设备上平稳运行,是一个尚未解决的技术挑战。

此外,边缘设备的资源调度不仅需要考虑设备的计算能力,还要考虑到网络延迟、存储能力等因素。这些因素对实时推理的影响尤其重要,因此如何进行更加精细的资源管理和调度,是未来研究的重点。

6.2.2 端到端延迟与通信开销

在分布式执行中,不同设备之间的通信开销往往成为瓶颈。尽管我们通过切分来减少每个设备上的内存需求,但设备之间的通信仍然会带来延迟,尤其是当切分的点之间需要大量数据交换时。如何在保证内存和带宽约束的前提下,最小化端到端的延迟,是一个非常重要的挑战。

目前的解决方案多依赖于压缩、量化等技术,但这些方法在降低延迟和带宽的同时,可能会影响推理精度。如何在保持精度的同时,进一步优化延迟和通信开销,是未来的研究重点。

6.2.3 可扩展性和可靠性问题

分布式模型切分不仅需要解决当前设备的资源约束问题,还需要考虑到系统的可扩展性和可靠性。在大规模部署时,如何管理成千上万的边缘设备,如何应对设备故障和网络不稳定等问题,都是需要解决的挑战。

为了应对这些问题,需要开发更加灵活且高效的模型切分和任务调度系统。例如,可以使用分布式计算框架(如Kubernetes、TensorFlow Distributed等)来实现资源的自动调度和故障恢复。此外,基于区块链的技术也可以应用于提高系统的可靠性和安全性。

七、实际应用:智能监控与自动驾驶

7.1 边缘智能监控系统

在智能监控系统中,摄像头作为边缘设备,其计算能力和内存资源通常有限。然而,面对实时的视频分析需求,如何将大规模的计算任务分布到多个设备上是一个重要课题。例如,可以将目标检测和图像分类等任务分配到不同的设备上进行处理,通过实时传输中间结果来完成整体推理任务。

这种分布式推理不仅可以提升系统的响应速度,还能在保证精度的同时减少对单一设备的资源消耗。例如,图像预处理和部分卷积操作可以在低功耗的边缘设备上执行,而更为复杂的部分(如全连接层或非线性操作)则可以在性能更强的设备上进行处理。

7.2 自动驾驶

自动驾驶作为一个复杂且高精度要求的应用,需要对传感器(如摄像头、激光雷达、雷达等)采集到的大量数据进行实时处理。由于自动驾驶系统中通常部署多个传感器和计算单元,如何在边缘设备上高效地切分和协同执行深度学习模型,成为了一个关键问题。

例如,摄像头可以用来获取环境图像数据,并将图像数据切分成多个部分,每个部分分别由不同的设备处理。雷达和激光雷达则可以通过传输高效的特征表示,而不是原始数据,来减少带宽占用。在这种系统中,动态调整切分策略并根据实时资源情况进行调度,将大大提升自动驾驶的实时性和准确性。

八、结论与未来展望

随着边缘设备计算能力和网络带宽的不断提升,基于内存和带宽协同的分布式模型切分策略将成为未来边缘智能应用中的核心技术。通过高效的任务调度与资源管理,我们可以在不同的边缘设备上实现对大规模深度学习模型的高效推理,满足多种低延迟、高精度的应用场景。

未来的研究将集中在以下几个方面:

- 动态切分策略的实现:根据设备的实时资源状况灵活调整模型切分方案;

- 压缩与加速技术的结合:提高通信效率,减少延迟;

- 大规模分布式系统的优化:提升系统的可扩展性和容错性。

随着技术的不断进步,边缘设备将逐步成为AI推理的主力军,为物联网、智能城市、自动驾驶等领域带来更智能、更高效的解决方案。

- 点赞

- 收藏

- 关注作者

评论(0)