跨生态AI系统中的安全认证与隐私保护技术:以MCP为例

跨生态AI系统中的安全认证与隐私保护技术:以MCP为例

引言

随着人工智能技术的迅猛发展,AI模型与服务的生态逐渐多样化,OpenAI 和 Google Gemini 等领先平台引领着智能技术的前沿。然而,不同生态之间的互通性与协同问题日益突出,如何在多元生态中实现标准融合,提升AI系统的兼容性和协作能力,成为当前产业的关键挑战。

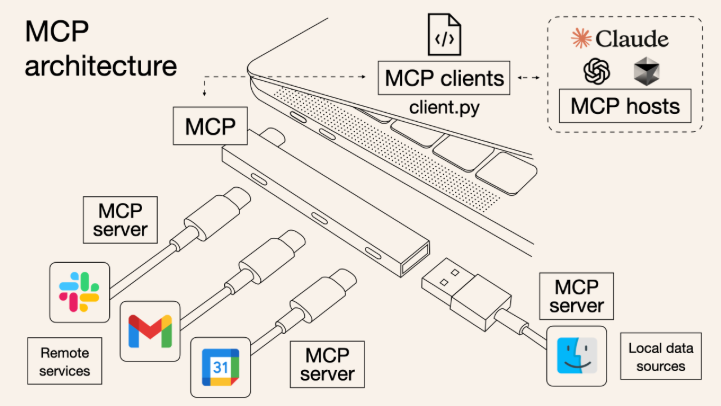

MCP(Model Communication Protocol,模型通信协议)作为一种促进多模型、多平台之间互操作的标准协议,旨在打破壁垒,实现不同AI平台之间的数据、模型和推理结果的无缝流转。本文将深入探讨MCP与OpenAI、Gemini生态的互通现状,解析标准融合的技术路径与面临的挑战,并展望未来的发展方向。

1. MCP协议概述

1.1 MCP的定义与目标

MCP是为解决多模型、多平台异构环境下通信和协作问题而设计的协议。其核心目标是:

- 定义统一的数据结构和交换格式

- 支持跨模型调用与推理任务调度

- 保障安全性和隐私保护

- 提供可扩展的接口和版本控制机制

1.2 MCP的核心组件

- 消息格式:基于JSON或Protobuf,定义请求、响应、事件通知等消息结构。

- 调用规范:支持同步和异步调用,定义模型输入输出接口规范。

- 认证与安全:基于OAuth 2.0等机制,确保访问安全。

- 版本管理:支持协议版本的渐进升级,保证兼容性。

2. OpenAI与Gemini生态特点对比

2.1 OpenAI生态

- 基于GPT系列模型,强调通用自然语言理解与生成能力。

- 提供统一API接口,支持多任务、多语言。

- 强调模型能力的模块化调用(如Embedding、Completion、Chat等)。

2.2 Gemini生态

- Google打造的多模态大模型生态,强调多源异构数据融合。

- 集成视觉、语言、知识图谱等多种能力。

- 支持多模态任务与联合推理。

3. MCP与OpenAI / Gemini的互通现状

3.1 标准融合的技术实践

- 接口适配:通过MCP定义的统一调用格式,OpenAI和Gemini模型可以通过适配器层实现接口转换。

- 数据格式统一:采用Protobuf统一描述输入输出数据,保证跨生态传输的一致性。

- 身份认证集成:结合OpenAI的API Key机制和Google的OAuth 2.0认证,实现安全互访。

3.2 已有案例分析

-

跨平台多模型联合推理

通过MCP框架,将OpenAI GPT模型的文本生成能力与Gemini的多模态理解能力结合,实现文本+图像的联合问答系统。 -

混合任务调度系统

利用MCP管理多模型任务队列,根据请求动态调用不同生态模型,提高推理效率和准确率。

4. 技术实现示例:基于Python的简单MCP跨生态调用示范

import requests

import json

# MCP消息格式示例

mcp_request = {

"version": "1.0",

"model": "openai:gpt-4",

"input": {

"prompt": "请解释人工智能中的MCP协议。",

"max_tokens": 100

},

"auth": {

"api_key": "OPENAI_API_KEY"

}

}

def call_openai_mcp(request_data):

url = "https://api.openai.com/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {request_data['auth']['api_key']}"

}

# 转换MCP请求为OpenAI兼容请求

payload = {

"model": request_data["model"].split(":")[1], # "gpt-4"

"messages": [{"role": "user", "content": request_data["input"]["prompt"]}],

"max_tokens": request_data["input"]["max_tokens"]

}

response = requests.post(url, headers=headers, json=payload)

return response.json()

def call_gemini_mcp(request_data):

# 假设Gemini提供的API接口示范

url = "https://gemini.googleapis.com/v1/models/gemini/chat"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {request_data['auth']['api_key']}"

}

payload = {

"prompt": request_data["input"]["prompt"],

"maxTokens": request_data["input"]["max_tokens"]

}

response = requests.post(url, headers=headers, json=payload)

return response.json()

# 示例调用

if __name__ == "__main__":

openai_result = call_openai_mcp(mcp_request)

print("OpenAI Response:", openai_result)

# 修改请求以调用Gemini

mcp_request["model"] = "gemini:chat"

mcp_request["auth"]["api_key"] = "GEMINI_API_KEY"

gemini_result = call_gemini_mcp(mcp_request)

print("Gemini Response:", gemini_result)

5. 跨生态标准融合面临的挑战

5.1 协议兼容性

不同平台的API设计、数据格式和调用逻辑存在差异,如何定义一个灵活而统一的MCP协议是一大难题。

5.2 安全与隐私

多生态交互涉及敏感数据交换,必须设计完善的认证和加密机制,防止数据泄露和滥用。

5.3 性能与稳定性

跨平台调用可能带来网络延迟和故障风险,需建立健壮的容错机制和负载均衡策略。

5.4 生态协同与利益

不同企业生态之间存在竞争,如何建立开放共享的合作机制,推动标准的行业共识,是制度层面的挑战。

6. 未来展望与发展方向

6.1 标准组织推动协议统一

推动国际标准组织(如IEEE、W3C等)介入,制定跨AI生态的通信协议标准,实现行业共通规范。

6.2 自动化适配与智能路由

借助AI自身的能力,实现MCP协议的自动适配和智能路由,动态选择最优模型和平台,提高系统智能化水平。

6.3 多模态多任务深度融合

跨生态融合不仅限于文本,还将涵盖图像、语音、视频等多模态,支持更复杂的联合推理与任务分配。

6.4 开放生态与社区协作

构建开放社区,鼓励开发者共同维护和优化MCP协议及工具,实现生态共享共赢。

结语

MCP作为连接不同AI生态的桥梁,推动了OpenAI与Gemini等先进平台之间的标准融合与跨界协作。尽管目前仍面临多重技术和生态挑战,但随着标准的不断完善与行业共识的达成,MCP将在未来成为人工智能多模型、多平台协同的核心基础,助力构建更加开放、高效、智能的AI生态体系。

- 点赞

- 收藏

- 关注作者

评论(0)