基于PyTorch的YOLOv11全流程训练与部署研究

基于PyTorch的YOLOv11全流程训练与部署研究

本文将带你深入了解在Windows 11系统上从零搭建并训练YOLOv11模型的全过程。内容包括:硬件与依赖环境准备、CUDA与cuDNN安装、PyTorch与相关库配置、PyCharm集成、系统环境变量配置,以及YOLOv11源码获取与训练示例。

环境与硬件准备

硬件要求

- GPU:NVIDIA GTX 1060及以上,支持CUDA 11.x

- CPU:四核及以上

- 内存:16 GB及以上

- 磁盘:至少50 GB可用空间

软件要求

- 操作系统:Windows 11 64位

- Python 版本:3.8–3.10

- Anaconda(推荐用于环境管理)

- Git(用于克隆源码)

安装CUDA与cuDNN

要发挥GPU加速性能,需安装CUDA Toolkit与cuDNN库。

1. 安装CUDA Toolkit

-

访问[NVIDIA CUDA Toolkit下载页面]。

-

选择:

- 操作系统:Windows → Windows 11

- 架构:x86_64

- 安装类型:exe (local)

-

下载并运行安装包,默认选项即可,完成后重启电脑。

2. 安装cuDNN

-

访问[NVIDIA cuDNN下载页面]。

-

登录后,选择与你的CUDA版本对应的cuDNN版本。

-

下载“Windows 10” ZIP包(与Win11兼容)。

-

解压,将以下文件复制到CUDA安装目录(默认:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.x):bin\cudnn*.dll→...\CUDA\v11.x\bin\include\cudnn*.h→...\CUDA\v11.x\include\lib\x64\cudnn*.lib→...\CUDA\v11.x\lib\x64\

创建Python虚拟环境并安装PyTorch

1. 安装Anaconda(可选)

如果已安装可跳过此步骤。

- 访问[Anaconda官网],下载Windows 11 64位安装包。

- 完成安装,勾选“Add Anaconda to my PATH environment variable”(可选)。

2. 创建虚拟环境

# 打开 Anaconda Prompt 或 PowerShell

conda create -n yolov11 python=3.9 -y

conda activate yolov11

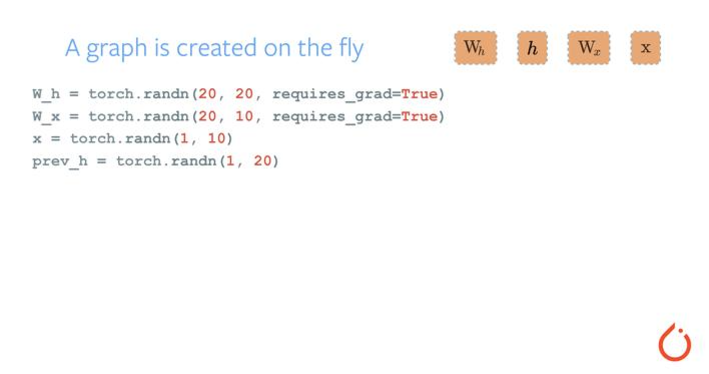

3. 安装PyTorch及依赖

根据CUDA版本执行命令(以CUDA 11.7为例):

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu117

验证安装:

import torch

print(torch.cuda.is_available(), torch.version.cuda)

若输出 True 且版本对应,即安装成功。

安装并配置PyCharm IDE

PyCharm 提供一流的Python开发体验,便于调试与管理项目。

1. 下载与安装

-

访问[JetBrains 官网]。

-

选择 Professional 或 Community 版(免费)。

-

安装过程中勾选:

- “Add ‘Open Folder as Project’ to Explorer context menu”

- “Update PATH variable”(添加

pycharm命令到PATH)

2. 配置虚拟环境解释器

- 打开PyCharm,选择 File → Settings → Project: xxx → Python Interpreter。

- 点击右上角齿轮图标,选择 Add… → Conda Environment → Existing environment。

- 浏览至

Anaconda3\envs\yolov11\python.exe,点击 OK。

添加系统环境变量

为CUDA和cuDNN配置环境变量,确保命令行与IDE可识别。

1. 打开系统环境变量

- Win + S 输入“环境变量”,选择 编辑系统环境变量。

- 点击 环境变量(N)…。

2. 编辑Path变量

在 系统变量 → Path → 编辑:

- 新增:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.x\bin - 新增:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.x\libnvvp - (可选)新增:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.x\include

3. 验证配置

打开新命令行窗口,执行:

nvcc --version

显示CUDA版本号即配置成功。

获取YOLOv11源码与依赖

1. 克隆仓库

git clone https://github.com/YourOrg/YOLOv11.git

cd YOLOv11

2. 安装Python依赖

在项目根目录下:

pip install -r requirements.txt

requirements.txt 通常包含:

torch、torchvisionopencv-pythonnumpymatplotlib- 其他:

pyyaml、tqdm、tensorboard等

配置数据集与运行训练

1. 准备数据集

假设使用COCO格式数据集:

YOLOv11/

├── data/

│ ├── coco/

│ │ ├── images/

│ │ │ ├── train/

│ │ │ └── val/

│ │ └── labels/

│ │ ├── train/

│ │ └── val/

│ └── coco.yaml

在 coco.yaml 指定路径:

train: data/coco/images/train

val: data/coco/images/val

nc: 80

names: ['person','bicycle',...]

2. 启动训练

python train.py \

--img 640 \

--batch 16 \

--epochs 50 \

--data data/coco.yaml \

--cfg models/yolov11.yaml \

--weights '' \

--device 0

--img:输入图像尺寸--batch:批次大小,受显存限制--cfg:模型配置文件--weights:预训练权重路径,空字符串表示从头训练--device:GPU编号

训练过程中,结果保存在 runs/train/exp*/,包含 weights/、results.png、events.out.tfevents.* 等。

常见问题与优化技巧

1. 显存不足

- 降低

--batch或--img大小 - 使用

--sync-bn或--amp半精度训练

2. 数据读取瓶颈

- 将数据集放到SSD

- 增加

--workers数量提高数据加载并行度

3. 模型调优

- 修改

models/yolov11.yaml中的锚框、深度与宽度系数 - 调整学习率策略(如余弦退火或Warmup)

模型评估与可视化

使用官方验证脚本

在训练完成后,可使用 val.py 脚本对模型在验证集上的性能进行量化评估:

python val.py \

--weights runs/train/exp/weights/best.pt \

--data data/coco.yaml \

--img 640 \

--batch 16 \

--device 0 \

--metrics mAP50-95

--metrics可指定多种评估指标,如precision、recall、mAP50、mAP50-95等。- 评估结果会输出到控制台,并保存在

runs/val/exp/下的results.txt。

可视化检测结果

可通过以下方式查看模型在验证集上的检测效果:

-

修改

val.py中save_img=True:将检测结果图片保存到runs/val/exp/。 -

调用脚本:

python val.py --weights runs/train/exp/weights/best.pt --data data/coco.yaml --img 640 --save-img -

打开

runs/val/exp/imgs/,查看标注框、类别置信度等可视化结果。

TensorBoard 监控

如启用 TensorBoard,可在训练时使用 --tensorboard:

python train.py --tensorboard --img 640 --batch 16 --epochs 50 ...

启动 TensorBoard:

tensorboard --logdir runs/train/exp

在浏览器中查看训练 & 验证损失曲线、学习率变化、mAP 等指标。

推理与部署

导出为 ONNX/ TorchScript

将训练好的 PyTorch 模型导出,便于跨平台部署:

# ONNX

python export.py --weights runs/train/exp/weights/best.pt --img 640 --batch 1 --include onnx

# TorchScript

python export.py --weights runs/train/exp/weights/best.pt --img 640 --batch 1 --include torchscript

生成文件位于 runs/export/,可在 C++、TensorRT、OpenCV DNN 或 Python 环境中加载。

Python 推理示例

import torch

from models.common import DetectMultiBackend

from utils.general import non_max_suppression, scale_coords

import cv2

# 加载模型

model = DetectMultiBackend('runs/export/best.onnx', device='cpu')

img = cv2.imread('data/coco/images/val/000000000139.jpg')

# 预处理

img_in = cv2.resize(img, (640, 640))

img_in = img_in[..., ::-1].transpose(2,0,1)[None] / 255.0 # BGR→RGB, HWC→CHW

# 推理

pred = model(img_in)[0]

pred = non_max_suppression(pred, conf_thres=0.25, iou_thres=0.45)

# 后处理 & 可视化

for det in pred:

if len(det):

det[:, :4] = scale_coords(img_in.shape[2:], det[:, :4], img.shape).round()

for *xyxy, conf, cls in det:

label = f'{model.names[int(cls)]} {conf:.2f}'

cv2.rectangle(img, (int(xyxy[0]), int(xyxy[1])), (int(xyxy[2]), int(xyxy[3])), (0,255,0), 2)

cv2.putText(img, label, (int(xyxy[0]), int(xyxy[1]-5)), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0,255,0), 2)

cv2.imshow('YOLOv11 Inference', img)

cv2.waitKey(0)

集成到 Web 服务

- Flask / FastAPI:将上述推理代码封装为 API,接收图像并返回检测结果。

- Docker:编写

Dockerfile,基于含 CUDA 或 CPU 的基础镜像,复制模型与代码,暴露端口启动服务。 - TensorRT 加速:将 ONNX 模型优化为 TensorRT 引擎,显著提升推理吞吐量。

总结

- 环境与硬件准备:确认 Windows 11、NVIDIA GPU、Python 3.8–3.10、Anaconda 和 Git;

- CUDA 与 cuDNN 安装:下载对应版本,解压并将

bin/include/lib文件复制到 CUDA 安装目录; - 虚拟环境与 PyTorch:使用 Conda 创建

yolov11环境,安装与 CUDA 版本匹配的torch、torchvision、torchaudio并验证 GPU 可用; - PyCharm 配置:安装 Community/Professional 版,添加项目解释器为

yolov11环境; - 系统环境变量:将 CUDA 的

bin与libnvvp路径加入系统 Path,重启并用nvcc --version验证; - 源码与依赖:

git cloneYOLOv11 仓库,pip install -r requirements.txt安装依赖; - 数据集与训练:准备 COCO 格式数据并编辑

*.yaml,执行train.py进行训练,输出保存在runs/train/; - 评估与可视化:用

val.py评估 mAP,保存可视化结果,或通过 TensorBoard 查看损失与 mAP 曲线; - 推理与部署:导出 ONNX/TorchScript,提供 Python 推理脚本示例,并可封装为 Flask/FastAPI 服务或 Docker 容器;

- 优化与扩展:可采用半精度训练、增加数据加载并行、模型剪枝/量化,以及自定义数据集微调、蒸馏或多任务扩展。

YOLOv11 在准确率和速度上均有显著提升,适合各类实时检测场景。未来可尝试的方向包括:

- 自定义数据集微调:对特定场景进行再训练,以适应行业需求。

- 轻量化与蒸馏:通过模型蒸馏、剪枝、量化等手段部署到边缘设备。

- 多任务扩展:结合语义分割、关键点检测等,实现更丰富的视觉理解。

至此,本文详尽介绍了在 Windows 11 上从环境搭建、源码获取到训练、评估、部署 YOLOv11 的完整流程。希望对你的目标检测项目有所帮助,欢迎探索与实践!

- 点赞

- 收藏

- 关注作者

评论(0)