量子计算在智能优化与模式识别中的潜在应用研究

量子计算在智能优化与模式识别中的潜在应用研究

随着人工智能(AI)的发展逐渐逼近经典计算的极限,量子计算被认为是突破当前算力瓶颈、实现下一代AI技术的关键。本文将系统探讨量子计算如何与AI深度融合,介绍主流的量子AI编程工具,并以实际代码案例展示量子增强机器学习的基本原理。

一、引言:为什么需要量子AI?

当前,人工智能模型——尤其是深度学习和强化学习——对算力的依赖日益增强。从ChatGPT这样的LLMs到自动驾驶系统,这些模型训练常常需要耗费数周的GPU资源。而量子计算凭借其天然的并行计算优势,可能带来:

- 指数级加速:处理维度极高的数据空间

- 天然支持量子概率建模:更符合某些AI算法的计算结构

- 在小样本学习和优化问题中展现潜力

这使得“量子人工智能”(Quantum AI)不仅是理论前沿,更逐步成为工程实现的可能方向。

二、量子计算基础概念简述

虽然不涉及复杂数学,但了解量子计算的核心概念对于理解其与AI的结合至关重要:

- Qubit(量子比特):既可表示0,也可表示1,同时叠加多个状态

- 叠加态与纠缠态:量子信息可同时探索多个路径

- 量子门(Quantum Gate):与经典逻辑门相似,是操作qubit的基本工具

目前主流量子计算框架包括 IBM Qiskit、Google Cirq、Amazon Braket 等。

三、融合方式:AI 与量子计算的典型结合路径

1. 量子加速的机器学习(Quantum-Enhanced ML)

在经典AI流程中,用量子线路替代部分模型模块(如核函数、优化器等),可在特定任务中实现超越经典算法的性能。例如:

- 量子支持向量机(QSVM)

- 量子神经网络(QNN)

- 量子卷积网络(QConvNet)

2. 量子生成模型(Quantum GAN)

利用量子线路来增强生成对抗网络中的生成器与判别器,提升复杂分布的建模能力。

3. AI 反向驱动量子系统控制

通过深度强化学习自动控制量子门序列,实现量子算法最优部署(如量子编译、误差纠正等)。

四、实战示例:使用 Qiskit 实现量子增强分类器

我们以 Qiskit + Scikit-learn 结合,构建一个量子支持向量机模型,用于二分类任务。

1. 安装所需依赖

pip install qiskit qiskit-machine-learning scikit-learn matplotlib

2. 导入必要模块

from qiskit.utils import algorithm_globals

from qiskit_machine_learning.algorithms import QSVC

from qiskit_machine_learning.kernels import QuantumKernel

from qiskit.circuit.library import ZZFeatureMap

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

import matplotlib.pyplot as plt

3. 数据准备与特征映射

# 设置随机种子

algorithm_globals.random_seed = 42

# 生成模拟数据集

X, y = make_classification(n_samples=100, n_features=2, n_informative=2,

n_redundant=0, random_state=42)

# 数据标准化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 划分训练测试集

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y, test_size=0.3, random_state=42)

# 使用量子特征映射

feature_map = ZZFeatureMap(feature_dimension=2, reps=2, entanglement='linear')

4. 构建量子核函数与量子SVM分类器

# 创建量子核

quantum_kernel = QuantumKernel(feature_map=feature_map)

# 初始化QSVC分类器

qsvc = QSVC(quantum_kernel=quantum_kernel)

# 拟合训练数据

qsvc.fit(X_train, y_train)

# 输出测试集精度

accuracy = qsvc.score(X_test, y_test)

print(f"Quantum SVM Test Accuracy: {accuracy:.2f}")

5. 可视化决策边界(选做)

import numpy as np

def plot_decision_boundary(clf, X, y):

x_min, x_max = X[:, 0].min() - .5, X[:, 0].max() + .5

y_min, y_max = X[:, 1].min() - .5, X[:, 1].max() + .5

xx, yy = np.meshgrid(np.arange(x_min, x_max, 0.02),

np.arange(y_min, y_max, 0.02))

Z = clf.predict(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

plt.contourf(xx, yy, Z, cmap=plt.cm.coolwarm, alpha=0.8)

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.coolwarm)

plt.title("QSVM Decision Boundary")

plt.show()

plot_decision_boundary(qsvc, X_test, y_test)

五、优势与挑战并存

量子AI的潜在优势

- 维数诅咒缓解:量子状态天然适应高维特征

- 搜索/优化问题中潜在指数加速

- 可以模拟经典模型难以拟合的分布

现实挑战

- 硬件受限:当前量子芯片噪声较大,qubit 数量有限

- 算法成熟度不足:量子AI模型仍处于早期实验阶段

- 调试困难:调试量子电路远复杂于经典代码

六、未来趋势与延展路径

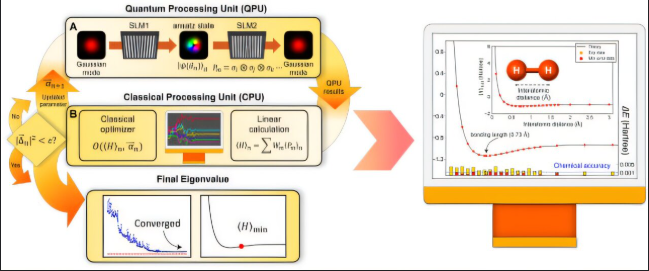

1. 混合量子-经典模型:现实可行的路径

由于当前量子计算仍受限于嘈杂和qubit数量,**Hybrid Quantum-Classical Models(混合量子-经典模型)**成为落地AI任务的首选方案。其基本思想是:

- 经典部分:负责数据预处理、特征缩放、初始表示学习;

- 量子部分:处理复杂模式识别或嵌入计算,通过量子电路学习非线性映射;

- 参数训练:量子线路中包含可调节参数(可训练的量子门),使用经典优化算法(如Adam或COBYLA)进行训练。

示例:使用Qiskit构建混合分类器

from qiskit_machine_learning.algorithms import VQC

from qiskit_machine_learning.neural_networks import EstimatorQNN

from qiskit.circuit.library import RealAmplitudes

from qiskit.opflow import Z, I

from qiskit.utils import algorithm_globals

# 构建量子神经网络

ansatz = RealAmplitudes(num_qubits=2, reps=1)

observable = Z ^ I

qnn = EstimatorQNN(ansatz=ansatz, observables=observable)

# 构建变分量子分类器

vqc = VQC(neural_network=qnn,

optimizer='COBYLA',

initial_point=[0.1] * ansatz.num_parameters)

# 拟合训练数据

vqc.fit(X_train, y_train)

score = vqc.score(X_test, y_test)

print(f"VQC accuracy: {score:.2f}")

这种方式兼顾了量子非经典能力与经典优化稳定性,成为当下探索量子AI的主流方案。

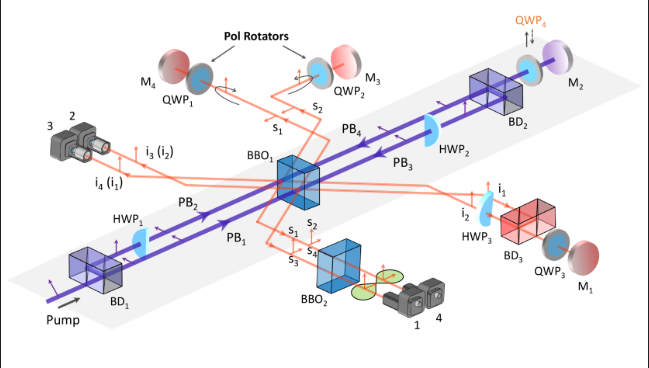

2. 量子自然语言处理(QNLP)的探索方向

量子计算正在对自然语言处理(NLP)领域带来启发性的突破。研究者提出了一种新的语义建模思路:量子态表示单词与句子结构,其基本原则如下:

- 每个词语可以用一个多维 Hilbert 空间向量表示;

- 语法组合通过张量积构造整体语义;

- 使用量子态内积计算句子相似度。

例如,Cambridge Quantum Computing 推出了 lambeq框架,用于构建量子语义解析器,并部署在 PennyLane 或 Qiskit 后端上执行。量子计算在此处起到了构建“可学习语义空间”的角色,有望突破当前NLP中语义不完整建模的问题。

3. 量子强化学习(QRL):突破搜索与策略空间限制

强化学习中存在大规模策略空间搜索、信用分配困难等挑战,研究者尝试将量子机制引入以下模块:

- 状态表示:用qubit对状态进行编码,天然支持多路径并行探索;

- 策略优化:利用量子叠加态进行策略搜索;

- Q值更新:使用量子变分电路进行函数逼近。

目前,Pennylane + OpenAI Gym 可用于构建量子强化学习实验平台。例如,构建量子策略网络:

import pennylane as qml

dev = qml.device("default.qubit", wires=2)

@qml.qnode(dev)

def quantum_policy(obs, weights):

qml.templates.AngleEmbedding(obs, wires=[0, 1])

qml.templates.StronglyEntanglingLayers(weights, wires=[0, 1])

return qml.probs(wires=[0, 1])

该结构已被用于玩具环境(如CartPole)策略学习实验中,表现出收敛更快与策略更鲁棒的趋势。

4. 量子生成模型(QGAN)的突破前沿

生成对抗网络(GAN)在图像生成、语音合成中广泛应用,而量子生成模型(QGAN)正在尝试以更高的数据表达能力取代经典结构:

- 生成器(Generator):由参数化量子电路构成,用于生成概率分布;

- 判别器(Discriminator):可以是经典神经网络或量子电路;

- 损失优化:通过经典或量子梯度优化器更新参数。

Qiskit 中已有 QGAN 模块支持构建混合生成模型,具有以下优势:

- 在小样本学习中依旧能保持较强泛化能力;

- 可生成更丰富的概率分布,不受高维空间稀疏性限制。

5. 工程落地方向:量子AI的现实应用前景

当前量子AI尚处于科研实验阶段,但已有多个工程方向正在探索现实落地:

| 领域 | 应用方向 | 代表组织/研究 |

|---|---|---|

| 金融 | 风险建模、资产组合优化 | JP Morgan × IBM Q |

| 药物设计 | 蛋白质折叠、分子相互作用预测 | Boehringer Ingelheim × Google Quantum AI |

| 材料科学 | 新材料发现、原子结构模拟 | Microsoft Q# Chemistry |

| 交通与物流 | 路径最优化、调度问题建模 | Volkswagen × D-Wave |

这些项目表明,量子AI并非纸上谈兵,而是逐步向特定垂直领域渗透,未来将成为AI应用中的高价值补充。

总结:走向下一代AI的量子引擎

量子计算与人工智能的融合,正引领我们迈向一个全新的计算时代。在这一旅程中,我们看到了:

量子计算的独特优势,如并行性、叠加态和纠缠态,使其能够高效处理经典计算难以胜任的任务;

人工智能对计算资源的极高需求,尤其在训练大型模型时,对高维优化和复杂函数逼近能力的依赖,正好与量子计算的能力高度契合;

混合量子-经典模型的实践路径,成为当前最具潜力的落地方案,广泛应用于分类、回归、生成、强化学习等多种任务中;

代码工具链的快速发展,如 Qiskit、PennyLane、Cirq 等,使得研究者可以以最小门槛上手量子AI模型构建与实验;

实际行业的积极探索,从金融到制药,从交通到材料科学,量子AI的应用场景正不断拓展。

尽管当前仍存在量子硬件受限、算法稳定性不强、调试环境稀缺等挑战,但技术正在快速进化。未来的AI系统,很可能不仅仅运行在GPU和TPU之上,而是混合运行在量子芯片与经典架构的协同平台上,真正实现智能计算范式的跃迁。

量子计算不是替代AI,而是重新定义AI。

下一代的人工智能,将不再是更深的网络或更大的模型,而是更“深层次”的计算本质。而这条路径的起点,正是“量子计算”。

- 点赞

- 收藏

- 关注作者

评论(0)