深度解析:前向传播、反向传播与梯度

一、前向传播(Forward Propagation)

1. 定义与过程

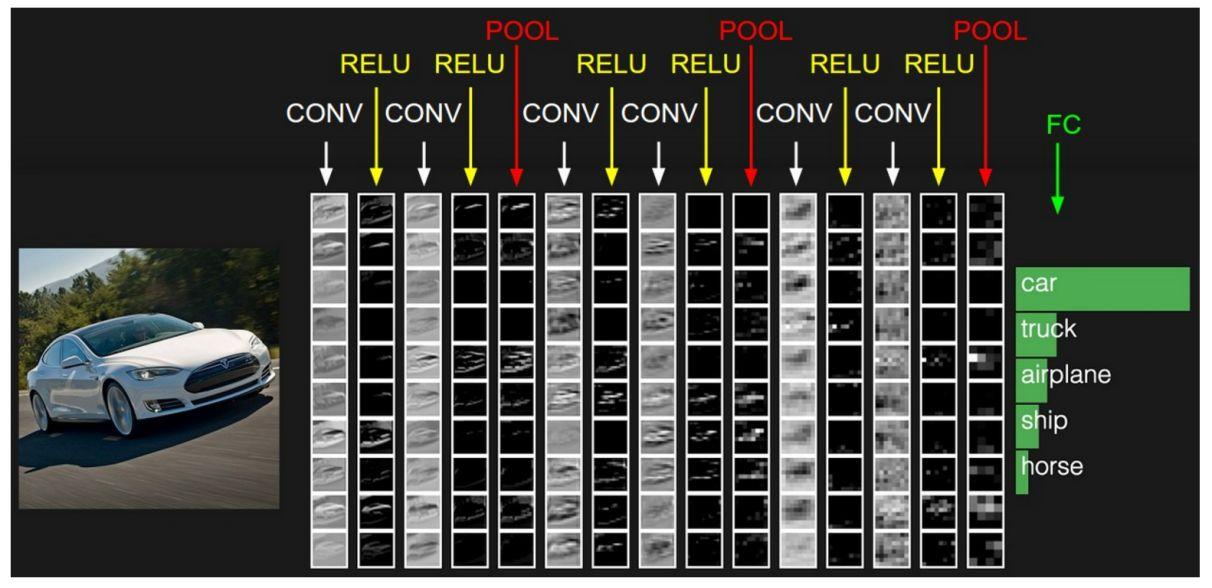

前向传播是神经网络进行预测或分类的基础过程。它从输入层开始,通过网络的每一层逐层计算每个神经元的输出,直到到达输出层并生成最终的预测结果。这个过程中,每一层的输入是上一层的输出,每一层的输出则是下一层的输入,如此逐层传递,直到输出层。如下图:

2. 重要性

- 预测与分类:在推理阶段,神经网络仅使用前向传播过程来生成预测结果。输入数据通过网络进行前向传播,直到输出层生成最终的预测结果。

- 损失计算:在训练阶段,前向传播用于生成预测结果,这些预测结果与真实标签进行比较,从而计算出损失函数的值。这个损失值反映了模型当前的表现,是后续反向传播和参数更新的基础。

3. 计算细节

在前向传播过程中,每个神经元的输出通常是通过加权求和(即输入值与权重的乘积之和)后,再经过一个非线性激活函数得到的。这个非线性激活函数(如ReLU、sigmoid等)为神经网络引入了非线性特性,使得神经网络能够拟合复杂的函数关系。

二、反向传播(Back Propagation)

1. 定义与背景

反向传播算法是深度学习中最为核心和常用的优化算法之一,由Rumelhart、Hinton和Williams等人在1986年提出。在BP算法出现之前,多层神经网络的训练一直是一个难题,因为无法有效地计算每个参数对于损失函数的梯度。BP算法通过反向传播梯度,利用链式法则逐层计算每个参数的梯度,从而实现了多层神经网络的训练。

2. 工作原理

反向传播算法通过链式法则从输出层到输入层逐层计算误差梯度,并利用这些梯度更新网络参数以最小化损失函数。具体过程如下:

- 误差计算:从输出层开始,根据损失函数计算输出层的误差(即预测值与真实值之间的差异)。

- 误差传播:将误差信息反向传播到隐藏层,逐层计算每个神经元的误差梯度。这个过程中,每个神经元的误差梯度是通过链式法则与前面神经元的误差梯度相联系的。

- 参数更新:利用计算得到的误差梯度,可以进一步计算每个权重和偏置参数对于损失函数的梯度。然后,根据这些梯度信息,使用梯度下降或其他优化算法来更新网络中的权重和偏置参数,以最小化损失函数。

3. 重要性

反向传播算法是神经网络训练的核心,它使得神经网络能够通过不断学习和调整参数来拟合复杂的函数关系,从而提高模型的预测准确性。

三、梯度(Gradient)

1. 定义

梯度是一个向量,它表示函数在某一点上沿各个方向的变化率。在深度学习中,梯度通常用于表示损失函数相对于网络参数的导数(或偏导数),即损失函数值随参数变化而变化的快慢和方向。

2. 计算方法

梯度的计算通常通过自动微分技术实现。自动微分利用计算图(Computational Graph)和链式法则自动计算梯度。计算图是一种表示函数计算过程的有向图,其中每个节点表示一个操作(如加法、乘法、激活函数等),每个边表示操作之间的依赖关系。在前向传播过程中,计算图记录了每个节点的输出和中间结果;在反向传播过程中,利用链式法则逐层计算每个节点的梯度,并将梯度传播到前面的节点。

3. 重要性

梯度是优化算法(如梯度下降)的基础。通过计算梯度,我们可以确定参数更新的方向(即应该增加还是减少参数值)和步长(即参数更新的幅度),从而最小化损失函数并提高模型的预测准确性。

4. 梯度消失与梯度爆炸

在深度学习中,梯度消失和梯度爆炸是两个常见的问题。梯度消失是指随着网络层数的增加,梯度值逐渐减小到接近于零,导致参数更新变得非常缓慢或停止更新。梯度爆炸则是指梯度值变得非常大,导致参数更新时出现大幅度波动或不稳定。这两个问题都会影响神经网络的训练效果和性能。

- 点赞

- 收藏

- 关注作者

评论(0)