基于zookeeper实现分布式锁

zookeeper知识点复习

Zookeeper(业界简称zk)是一种提供配置管理、分布式协同以及命名的中心化服务,这些提供的

功能都是分布式系统中非常底层且必不可少的基本功能,但是如果自己实现这些功能而且要达到高吞吐、低延迟同时还要保持一致性和可用性,实际上非常困难。因此zookeeper提供了这些功能,开发者在zookeeper之上构建自己的各种分布式系统。

相关概念

Zookeeper提供一个多层级的节点命名空间(节点称为znode),每个节点都用一个以斜杠(/)分隔的路径表示,而且每个节点都有父节点(根节点除外),非常类似于文件系统。并且每个节点都是唯一的。

znode节点有四种类型:

- PERSISTENT:永久节点。客户端与zookeeper断开连接后,该节点依旧存在

- EPHEMERAL:临时节点。客户端与zookeeper断开连接后,该节点被删除

- PERSISTENT_SEQUENTIAL:永久节点、序列化。客户端与zookeeper断开连接后,该节点依旧存在,只是Zookeeper给该节点名称进行顺序编号

- EPHEMERAL_SEQUENTIAL:临时节点、序列化。客户端与zookeeper断开连接后,该节点被删除,只是Zookeeper给该节点名称进行顺序编号

创建这四种节点:

事件监听:在读取数据时,我们可以同时对节点设置事件监听,当节点数据或结构变化时,zookeeper会通知客户端。当前zookeeper有如下四种事件:

1. 节点创建

2. 节点删除

3. 节点数据修改

4. 子节点变更

java客户端操作

1. 引入依赖

2. 常用api及其方法

初始化zookeeper客户端类,负责建立与zkServer的会话

创建一个节点,1-节点路径 2-节点内容 3-访问控制控制 4-节点类型

判断一个节点是否存在

查询一个节点的内容

更新一个节点

删除一个节点

查询一个节点的子节点列表

关闭链接

实现思路分析

分布式锁的步骤:

1. 获取锁:create一个节点

2. 删除锁:delete一个节点

3. 重试:没有获取到锁的请求重试

参照redis分布式锁的特点:

1. 互斥 排他

2. 防死锁:

1. 可自动释放锁(临时节点) :获得锁之后客户端所在机器宕机了,客户端没有主动删除子节点;如果创建的是永久的节点,那么这个锁永远不会释放,导致死锁;由于创建的是临时节点,客户端宕机后,过了一定时间zookeeper没有收到客户端的心跳包判断会话失效,将临时节点删除从而释放锁。

2. 可重入锁:借助于ThreadLocal

3. 防误删:宕机自动释放临时节点,不需要设置过期时间,也就不存在误删问题。

4. 加锁/解锁要具备原子性

5. 单点问题:使用Zookeeper可以有效的解决单点问题,ZK一般是集群部署的。

6. 集群问题:zookeeper集群是强一致性的,只要集群中有半数以上的机器存活,就可以对外提供服务。

基本实现

实现思路:

1. 多个请求同时添加一个相同的临时节点,只有一个可以添加成功。添加成功的获取到锁

2. 执行业务逻辑

3. 完成业务流程后,删除节点释放锁。

初始化链接

由于zookeeper获取链接是一个耗时过程,这里可以在项目启动时,初始化链接,并且只初始化一次。借助于spring特性,代码实现如下:

代码落地

改造StockService的checkAndLock方法:

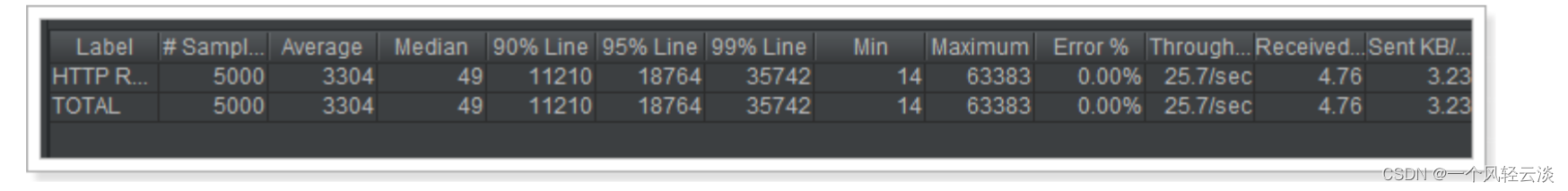

Jmeter压力测试:

性能一般,mysql数据库的库存余量为0(注意:所有测试之前都要先修改库存量为5000)

基本实现存在的问题:

1. 性能一般(比mysql略好)

2. 不可重入

接下来首先来提高性能

优化:性能优化

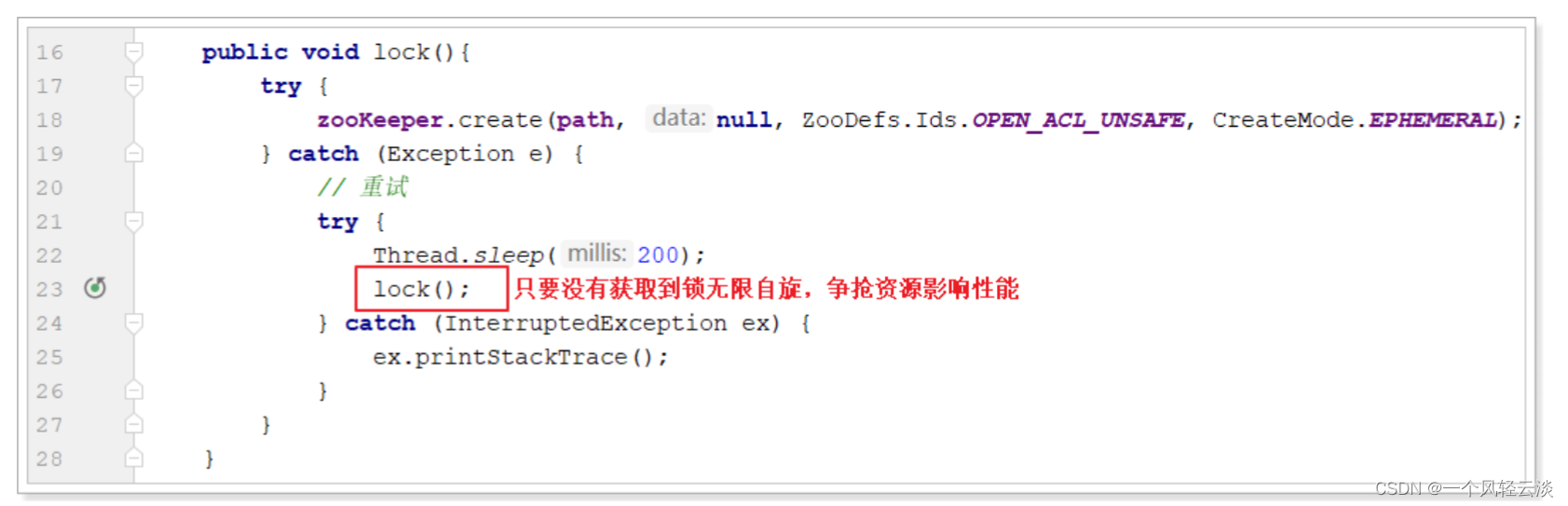

基本实现中由于无限自旋影响性能:

试想:每个请求要想正常的执行完成,最终都是要创建节点,如果能够避免争抢必然可以提高性能。这里借助于zk的临时序列化节点,实现分布式锁:

实现阻塞锁

代码实现:

主要修改了构造方法和lock方法:

并添加了getPreNode获取前置节点的方法。

测试结果如下:

性能反而更弱了。

原因:虽然不用反复争抢创建节点了,但是会自选判断自己是最小的节点,这个判断逻辑反而更复杂更 耗时。

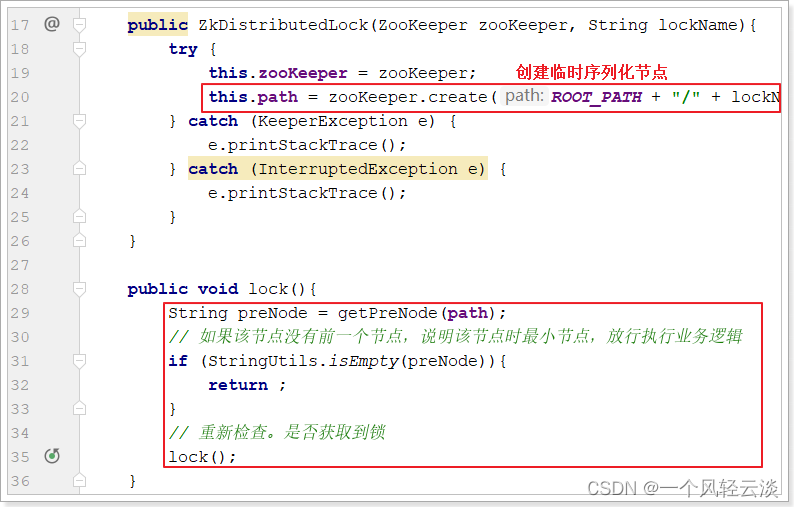

解决方案:监听实现阻塞锁

监听实现阻塞锁

对于这个算法有个极大的优化点:假如当前有1000个节点在等待锁,如果获得锁的客户端释放锁时,这1000个客户端都会被唤醒,这种情况称为“羊群效应”;在这种羊群效应中,zookeeper需要通知1000个 客户端,这会阻塞其他的操作,最好的情况应该只唤醒新的最小节点对应的客户端。应该怎么做呢?在 设置事件监听时,每个客户端应该对刚好在它之前的子节点设置事件监听,例如子节点列表 为/lock/lock-0000000000、/lock/lock-0000000001、/lock/lock-0000000002,序号为1的客户端监听 序号为0的子节点删除消息,序号为2的监听序号为1的子节点删除消息。

所以调整后的分布式锁算法流程如下:

- 客户端连接zookeeper,并在/lock下创建临时的且有序的子节点,第一个客户端对应的子节点 为/lock/lock-0000000000,第二个为/lock/lock-0000000001,以此类推;

- 客户端获取/lock下的子节点列表,判断自己创建的子节点是否为当前子节点列表中序号最小的子 节点,如果是则认为获得锁,否则监听刚好在自己之前一位的子节点删除消息,获得子节点变更通 知后重复此步骤直至获得锁;

- 执行业务代码;

- 完成业务流程后,删除对应的子节点释放锁。

改造ZkDistributedLock的lock方法:

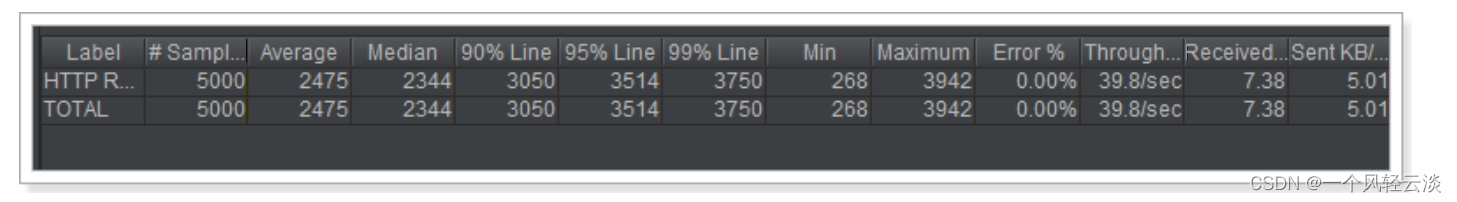

压力测试效果如下:

由此可见性能提高不少仅次于redis的分布式锁

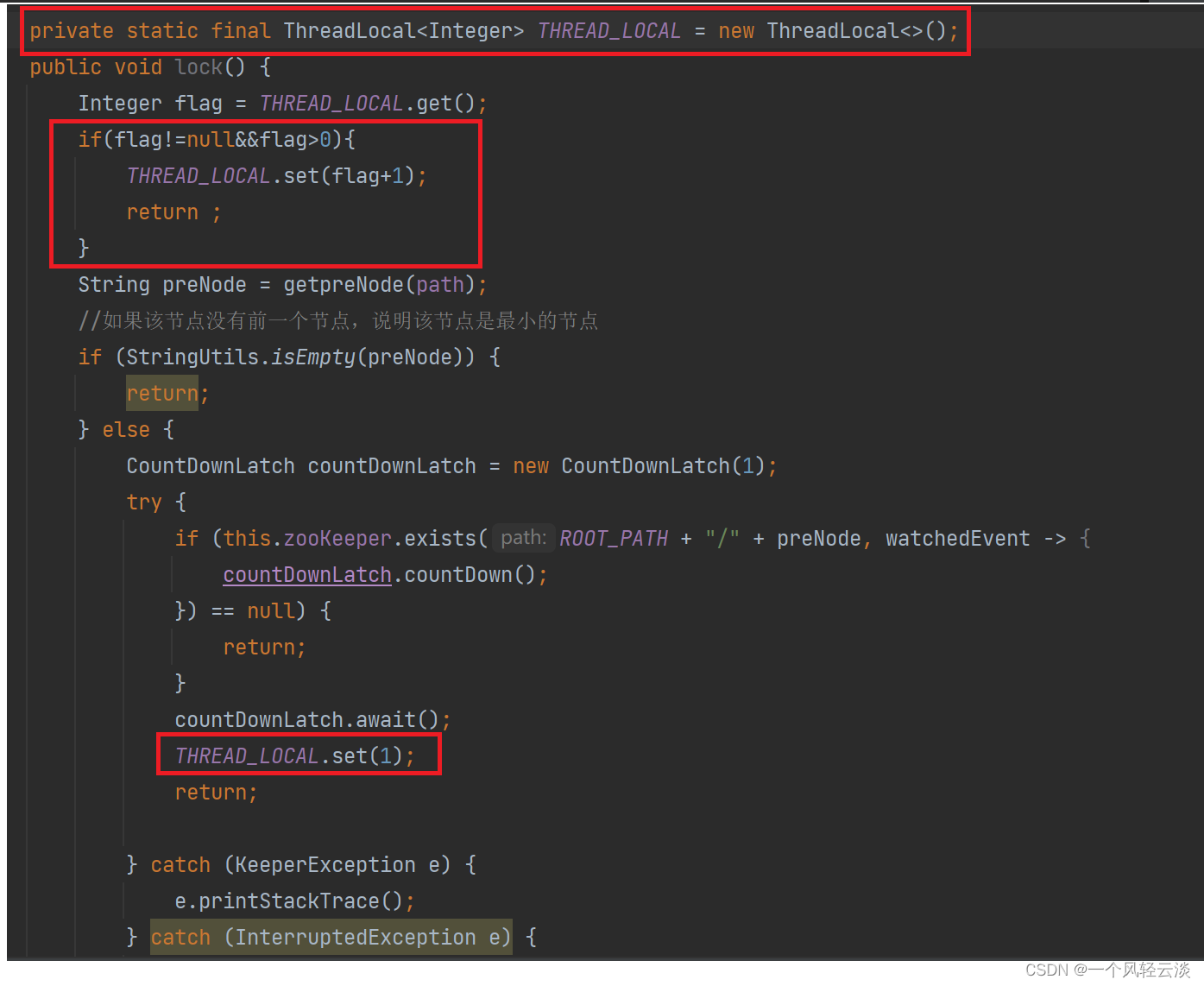

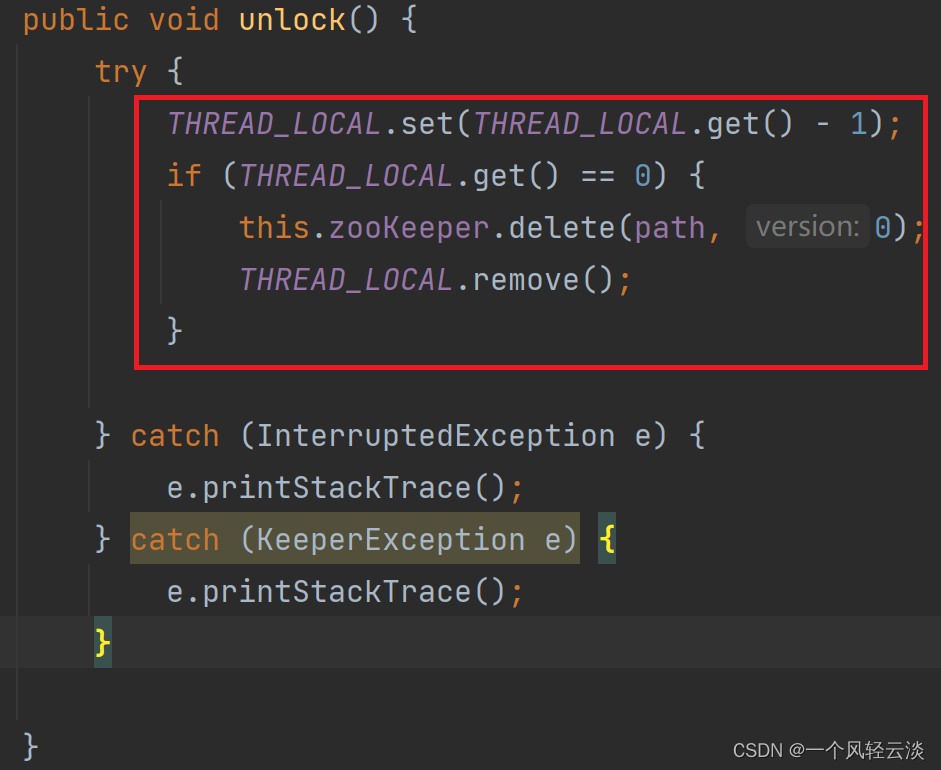

优化:可重入锁

引入ThreadLocal线程局部变量保证zk分布式锁的可重入性。

在对应的线程的存储数据

zk分布式锁小结

参照redis分布式锁的特点:

1. 互斥 排他:zk节点的不可重复性,以及序列化节点的有序性

2. 防死锁:

1. 可自动释放锁:临时节点

2. 可重入锁:借助于ThreadLocal

3. 防误删:临时节点

4. 加锁/解锁要具备原子性

5. 单点问题:使用Zookeeper可以有效的解决单点问题,ZK一般是集群部署的。

6. 集群问题:zookeeper集群是强一致性的,只要集群中有半数以上的机器存活,就可以对外提供服务。

7. 公平锁:有序性节点

- 点赞

- 收藏

- 关注作者

评论(0)