联合熵和条件熵

联合熵

联合集 X Y 上, 对联合自信息

I(xy) 的平均值称为联合熵:

H(XY)=p(xy)E[I(x⇌y)]=−∑x∑yp(xy)logp(xy)

当有 n 个随机变量

X=(X1,X2,…,Xn) , 有

H(X)=−∑X1,X2,…,Xnp(x1,x2,…,xn)logp(x1,x2,…,xn)

信息熵与热熵的关系

信息熵的概念是借助于热熵的概念而产生的。

1.信息熵与热熵含义相似

2.信息熵与热熵的区别:

1)信息熵的不增原理;2)热熵不减原理。

3.热熵的减少等于信息熵的增加。

条件熵

联合集

XY 上, 条件自信息

I(y/x)的平均值定义为条件 熵:

H(Y/X)=p(xy)E[I(y/x)]=−∑x∑yp(xy)logp(y/x)=∑xp(x)[−∑yp(y/x)logp(y/x)]=∑xp(x)H(Y/x)

推广:

H(Xn∣X1,…,Xn−1)=−∑X1,X2,…,Xnp(x1,x2,…,xn)logp(xn∣x1,…,xn−1)

注意:

H(X,Y)=H(Y)+H(X∣Y)=H(X)+H(Y∣X)H(X)=H(X1)+H(X2∣X1)+…+H(Xn∣X1,X2,…,Xn−1)

注意:

H(X∣Y) 表示已知变量

Y 后, 对变量

X 尚存在的平均不确定性(存在疑义)。

定义:一个平稳的时域离散随机过程的熵速率 (entropy rate) 定义为

H=limn→∞H(Xn∣X1,X2,…,Xn−1)

具有记忆性的信源的熵速率定义为

H=limn→∞n1H(X1,X2,…,Xn)

Example 6. 两个二进制随机变量

X 和

Y , 其联合分布为 p(X=Y=0)=p(X= 0, Y=1)=p(X=Y=1)=1 / 3 . 计算 H(X), H(Y),

H(X∣Y),

H(Y∣X) , and H(X, Y) .

Solution:

p(X=0)=p(X=0,Y=0)+p(X=0,Y=1)=32p(X=1)=p(X=1,Y=0)+p(X=1,Y=1)=31p(Y=0)=p(X=0,Y=0)+p(X=1,Y=0)=31p(Y=1)=p(X=0,Y=1)+p(X=1,Y=1)=32H(X)=31log3+32log23=0.9183H(Y)=31log3+32log23=0.9183H(X,Y)=∑i=1np(X,Y)log(X,Y)=log3=1.585H(X∣Y)=H(X,Y)−H(Y)=0.6667H(Y∣X)=H(X,Y)−H(X)=0.6667

各类熵的关系

- 条件熵不大于信息熵

熵的不增原理:

H(Y/X)≤H(Y)

-

联合熵不大于个信息熵的和,即

H(X1X2…XN)≤∑i=1NH(Xi)

仅当各

Xi 相互独立时, 等号成立。

-

H(XY)=H(X)+H(Y∣X)=H(Y)+H(X∣Y)

-

H(X)≥H(X∣Y);H(Y)≥H(Y∣X)

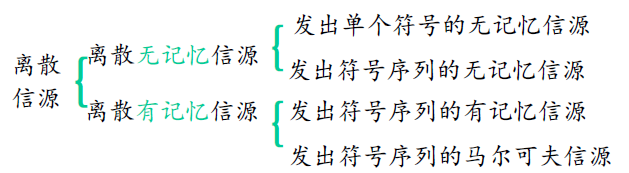

四、离散无记忆信源的序列熵

马尔可夫信源的特点:无后效性。

发出单个符号的信源

发出符号序列的信源

p(Xˉ=xi)=p(xi1,xi2,⋯,xiL)=p(xi1)p(xi2)p(xi3)⋯p(xiL)=l=1∏Lp(xil)

信源的序列熵

H(Xˉ)=−i=1∑nLp(xi)logp(xi)=−i∑l=1∏Lp(xii)logp(xii)=l=1∑LH(Xl)

-

若又满足平稳特性, 即与序号 l 无关时:

p(X)=∏l=1Lp(xii)=pL

-

信源的序列熵

H(X)=LH(X)

-

平均每个符号(消息)熵(符号熵) 为

HL(Xˉ)=L1H(Xˉ)=H(X)

例: 有一个无记忆信源随机变量

X∈(0,1) , 等概率分布,若以 单个符号出现为一事件, 则此时的信源熵:

H(X)=log22=1bit/ 符号

即用 1 比特就可表示该事件。

-

如果以两个符号出现 (

L=2 的序列)为一事件, 则随机序 列

X∈(00,01,10,11) , 信源的序列熵

H(Xˉ)=log24=2bit/ 序列

即用2比特才能表示该事件。

离散有记忆信源的序列熵

- 对于有记忆信源,就不像无记忆信源那样简单, 它必须 引入条件熵的概念, 而且只能在某些特殊情况下才能 得到一些有价值的结论。

- 对于由两个符号组成的联合信源, 有下列结论:

H(X1X2)=H(X1)+H(X2∣X1)=H(X2)+H(X1∣X2)

H(X1)≥H(X1∣X2),H(X2)≥H(X2∣X1)

H(X1X2)=H(X1)+H(X2)H(X1∣X2)=H(X1),H(X2∣X1)=H(X2)

-

若信源输出一个L长序列,则信源的序列熵为

H(X)=H(X1X2⋯XL)=H(X1)+H(X2∣X1)+⋯+H(XL∣XL−1⋯X1)=l∑LH(Xl∣Xl−1)=H(XL)

-

平均每个符号的熵为:

HL(Xˉ)=L1H(XL)

-

若当信源退化为无记忆时:若进一步又满足平稳性时

H(Xˉ)=∑lLH(Xl)H(Xˉ)=LH(X)

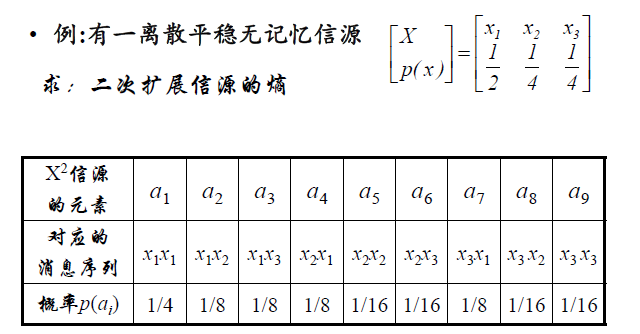

平稳有记忆N次扩展源的熵

设

X 为离散平稳有记忆信源,

X 的

N 次扩展源记为

XN ,

XN=[X1X2⋯XN]

根据熵的可加性,得

H(XN)=H(X1X2⋯XN)=H(X1)+H(X2/X1)+⋯H(XN/X1⋯XN−1)

根据平稳性和熵的不增原理,得

H(XN)≤NH(X1),

仅当无记忆信源时等式成立。

对于

X 的

N 次扩展源, 定义平均符号熵为:

HN(X)=N1H(XN)=N1H(X1⋯XN)

信源

X 的极限符号熵定义为:

H∞(X)=limN→∞N1H(XN)=limN→∞N1H(X1⋯XN)

极限符号熵简称符号熵, 也称熵率。

定理: 对任意离散平稳信源, 若

H1(X)<∞ , 有:

(1)

H(XN/X1⋯XN−1) 不随

N而增加;

(2)

HN(X)≥H(XN/X1⋯XN−1);

(3)

HN(X) 不随 N 而增加;

(4)

H∞(X) 存在,且

H∞(X)=limN→∞H(XN/X1⋯XN−1)

该式表明, 有记忆信源的符号熵也可通过计算极限条件熵得到。

评论(0)