Rplidar A1雷达投影到相机平面

0. 前言

在使用深度学习时候,我们可以有效地提取出我们想要的结果,但是常常会缺少深度信息(双目测景深会耗费大量的计算资源)。因此将激光雷达和单目摄像头相结合,可以有效的补充室内环境的深度信息,而目前3D的激光雷达成本高昂,这里提供一个2D激光雷达的解决方案。

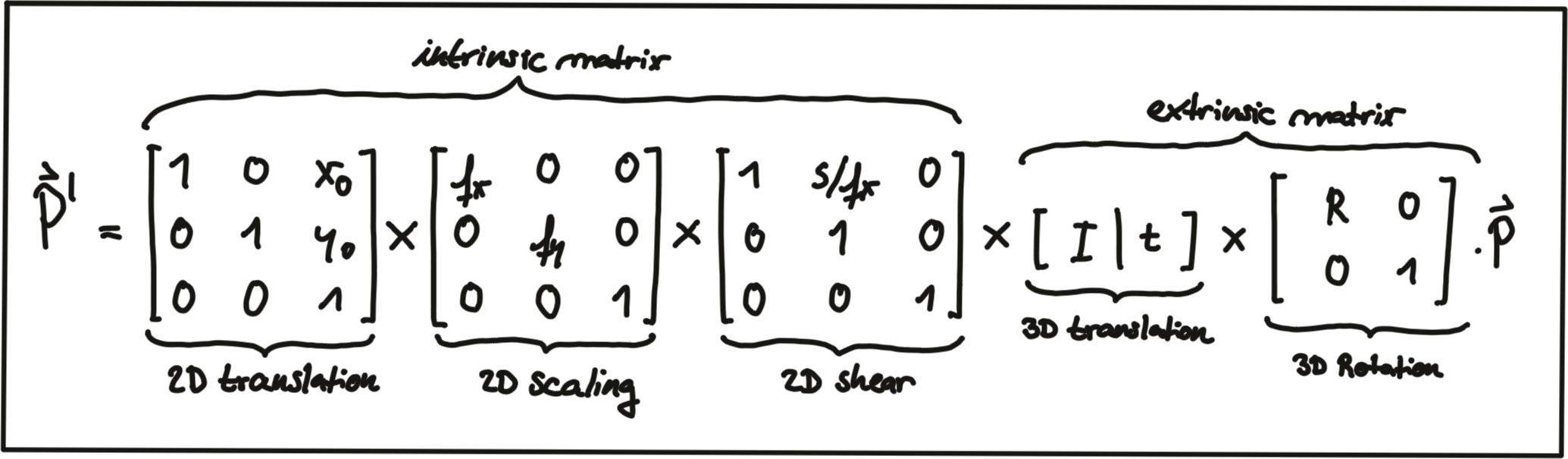

1. 相机坐标系变换

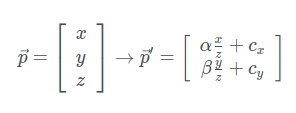

上文提过, 在相机世界中, 3D外界点转换到2D图像像素点转换方程是

我们可以通过相机的内在参数 intrinsic camera parameters实现这一转换. 但是我们不是通过视觉建立的地图,所以地图外部坐标系和相机的外部坐标系位置很有可能是不一样的。

而外参的坐标变化涉及平移和旋转操作, 我们需要将其应用于每个3D点。 问题在于我们得到的投影方程的问题是涉及到 z 的除法, 这使得它们是非线性的(3维), 从而使我们无法将它们转化为更方便的矩阵向量形式.

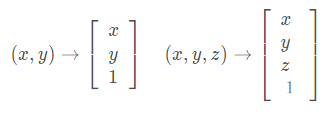

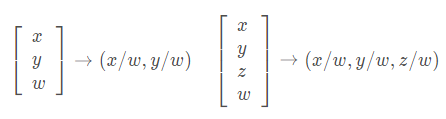

避免此问题的一种方法是同时更改激光雷达和相机的坐标系, 从原始的欧几里得坐标系转换为齐次坐标系的形式. 在两个欧几里得坐标系之间来回移动是一种非线性操作, 但是一旦我们处于齐次坐标系中, 投影变换将变为线性, 因此可以表示为简单的矩阵向量乘法. 两个坐标系之间的转换如下图所示。

欧几里得坐标->齐次坐标

齐次坐标->欧几里得坐标

2. 变换矩阵

内参矩阵

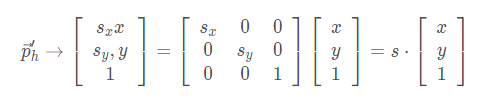

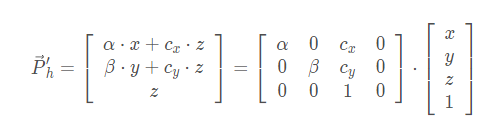

缩放(scale):

通过成分乘以尺度向量S实现缩放.缩放分量S已集成到内矩阵中K,所以在外参中不考虑。

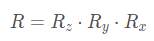

下述方程从左到右依次是齐次坐标系的相机投影几何转换矩阵/ 相机内参数矩阵K/ 齐次坐标点

相机内参数以矩阵形式排列, 可以方便地以紧凑的方式表示针孔相机模型的属性.

内参矩阵告诉你在外部世界的点在经过外参矩阵变换之后, 是如何继续经过摄像机的镜头、并通过针孔成像和电子转化而成为像素点的.

外参矩阵

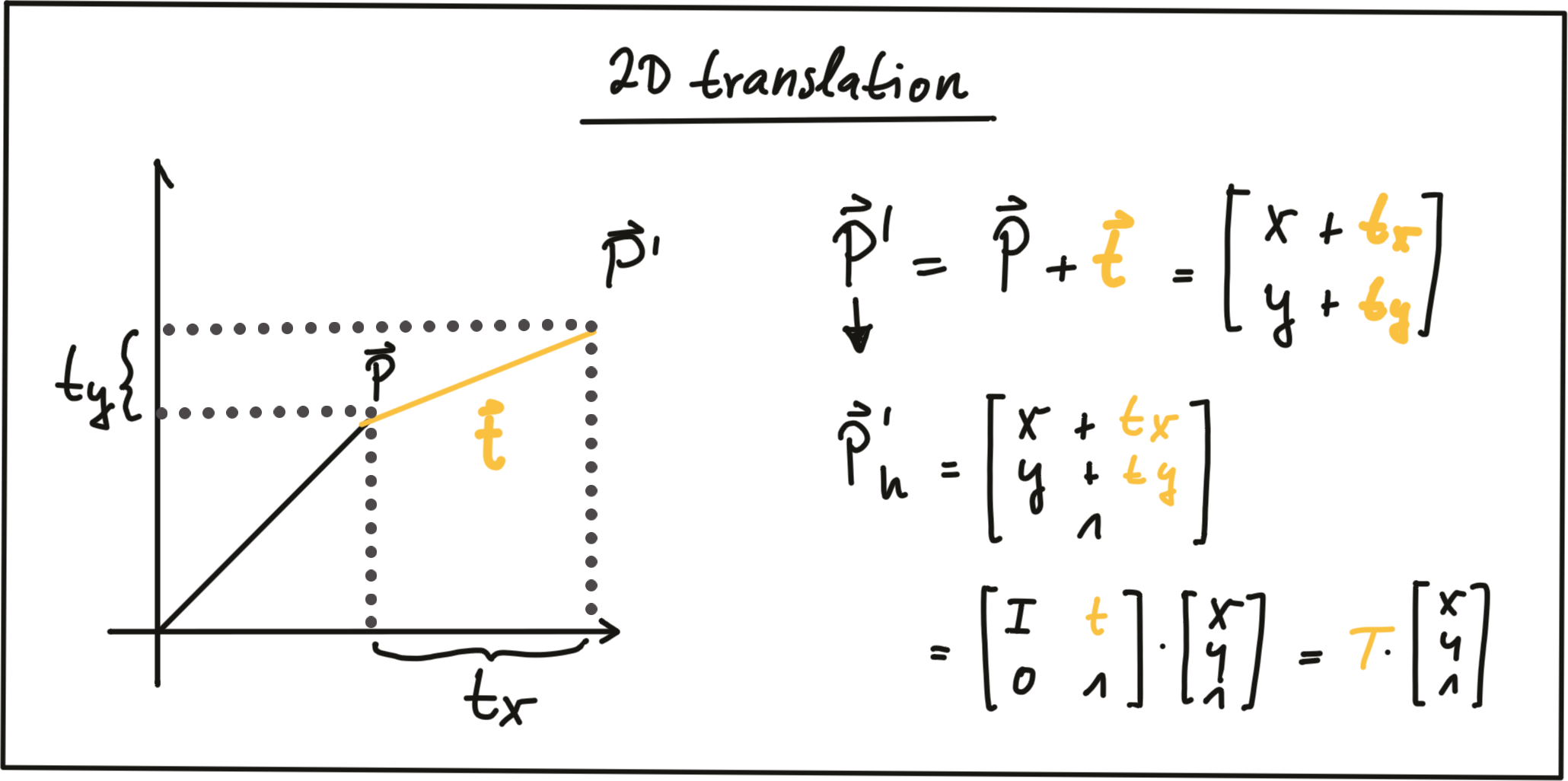

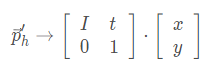

平移(translation):

通过添加平移向量t到P, 使得P点线性平移到新位置P’.

在齐次坐标中, 我们可以使用大小为N的单位矩阵I连接平移向量t表示.

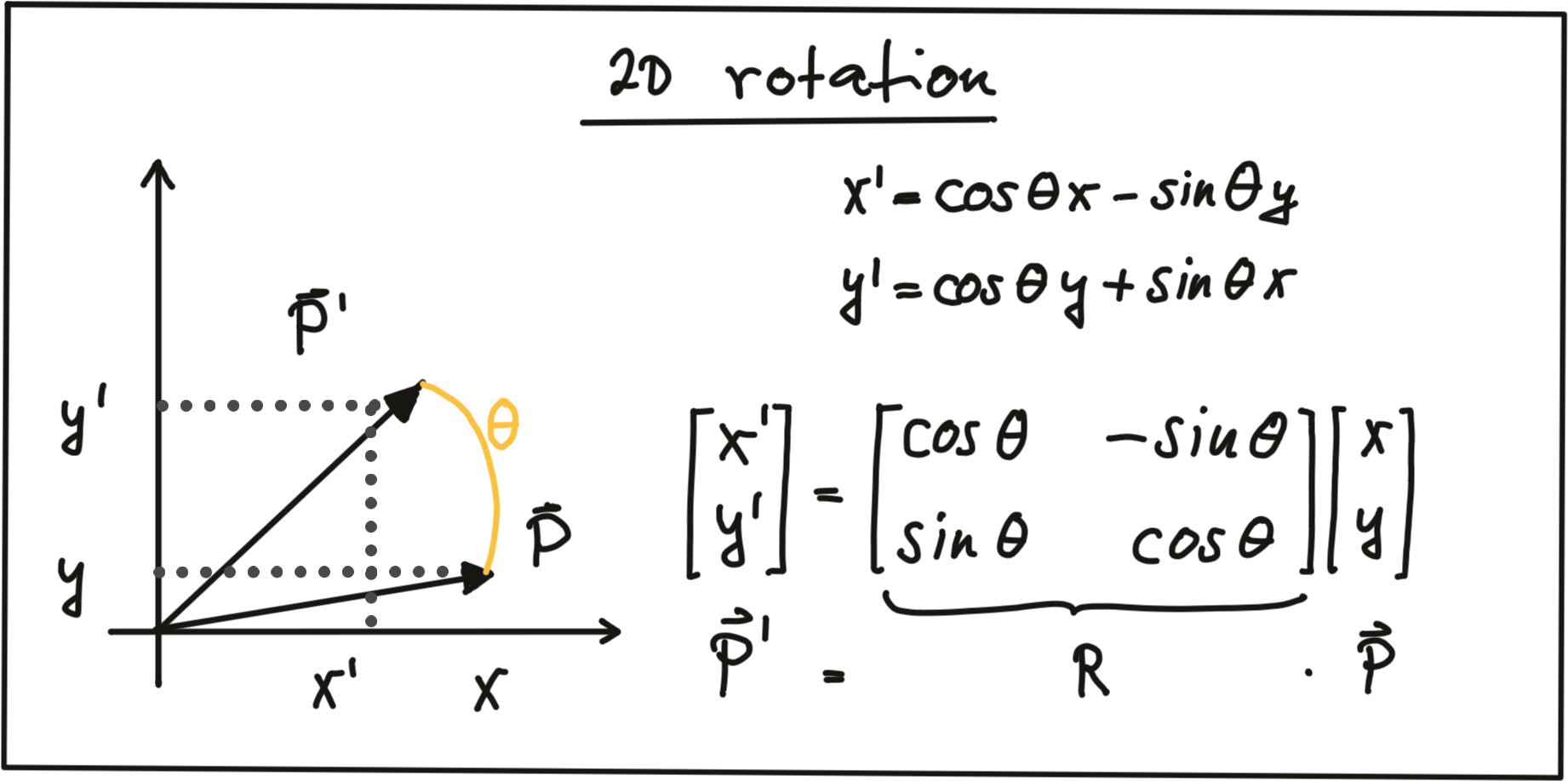

旋转

下图为点P在顺时针方向上的旋转的实现:

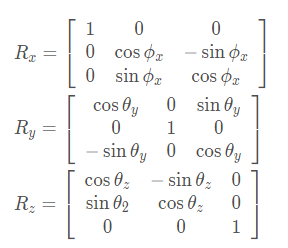

其中R被称为旋转矩阵. 在3D空间中, 点P的旋转是围绕x,y,z三个轴实现的, 因此可以表述为下面的旋转公式.

合在一起就是3D旋转公式:

3. 投影方程

通过将各个外参矩阵和内参矩阵进行级联, 实现了3D激光雷达到2D图像平面上的投影.

实现3D投影需要从完成这些坐标系的变换:

激光雷达世界坐标系->相机坐标系(激光雷达和相机都在车辆坐标系中进行位置校准, 从而互相关联)->像平面坐标系->像素坐标系.

坐标系转换:

欧几里得坐标系->齐次坐标系->欧几里得坐标系.

在完成欧几里得坐标转齐次坐标, 转换函数, 齐次坐标转欧几里得坐标这三步之后我们完成了激光雷达到相机的点投影, 从而获得了激光雷达与图像平面相交的区域.。同样3D激光雷达同理。

rp_segment.h

#include <iostream>

#include <fstream>

#include <vector>

#include <stdio.h>

#include <string>

#include <opencv2/opencv.hpp>

#include <ros/ros.h>

#include <math.h>

#include <Eigen/Dense>

#include <sensor_msgs/LaserScan.h>

#include <sensor_msgs/Image.h>

#include <cv_bridge/cv_bridge.h>

#include <geometry_msgs/Point.h>

#include <laser_segment/Insight_lidar_segments.h>

#include <laser_segment/Insight_lidar_segments.h>

#include <message_filters/subscriber.h>

#include <message_filters/time_synchronizer.h>

#include <message_filters/sync_policies/approximate_time.h>

using namespace std;

using namespace cv;

using namespace Eigen;

using namespace message_filters;

/* 雷达-相机外参,相机内参 */

cv::Mat tcl = (Mat_<double>(3,1) << 0.0259365,-0.0200982,-0.0914582);

cv::Mat Rcl = (Mat_<double>(3,3) << -0.0580782,-0.99819,-0.0155896,-0.0126269,

0.0163492,-0.999787,0.998232,-0.0578689,-0.0135535);

cv::Mat K = (Mat_<double>(3, 3) << 1398.526435675626, 0, 974.6271798798929,0, \

1399.471439435285, 533.3491663893035,0, 0, 1);

cv::Mat D = (Mat_<double>(4,1) << -0.101938, -0.0501564, 0.0323029, 0.0226299);

/*

//640x480

cv::Mat K_1 = (Mat_<double>(3, 3) <<601.1819494061277, 0, 329.1305015302001, 0.000000, \

600.0406404279748, 238.3837396948256, 0.000000, 0.000000, 1.000000);

cv::Mat D_1 = (Mat_<double>(4,1) << -0.0541737, -0.761986, 3.11624, -3.69709);

//1280x720

cv::Mat K_2 = (Mat_<double>(3, 3) <<907.3179347878757, 0, 622.1428470715612, 0.000000, \

910.7995408784911, 330.5347846342667, 0.000000, 0.000000, 1.000000);

cv::Mat D_2 = (Mat_<double>(4,1) << -0.120183, 0.0311701, -0.0129947, -0.00799496);

//1920x1080

cv::Mat K_3 = (Mat_<double>(3, 3) <<1398.526435675626, 0, 974.6271798798929,0, \

1399.471439435285, 533.3491663893035,0, 0, 1);

cv::Mat D_3 = (Mat_<double>(4,1) << -0.101938, -0.0501564, 0.0323029, 0.0226299);

*/

cv::Mat global_img_;

int begin_ray_id_;

int min_seg_points_;

string topic_detect_img_ = "cropped_detection_Image";

string topic_laser_seg_ = "insight_laser_seg";

std_msgs::Header global_header_;

typedef Eigen::Matrix < double, 3, 1> Vector3f;

typedef Eigen::Matrix < double, 4, 1> Vector4f;

typedef message_filters::sync_policies::ApproximateTime<laser_segment::Insight_lidar_segments,sensor_msgs::Image> sync_policy_classification;

//Rplidar A1 配置参数

double p_min_scanner_range_ = 0.15000000596;

double p_max_scanner_range_ = 6.0;

double p_scanner_angle_min_ = -3.12413907051;

double p_scanner_angle_max_ = 3.14159274101;

double p_scanner_angle_increment_ = 0.0174532923847;

int p_ranges_num_ = 360;

void reprojectTo_show(cv::Mat* img,std::vector<Eigen::Vector3f>* laser_points,std::vector<int>* laser_idx,const int& i);

void callback(const laser_segment::Insight_lidar_segmentsConstPtr& msg_segments,

const sensor_msgs::ImageConstPtr& msg_Img);

…详情请参照古月居

- 点赞

- 收藏

- 关注作者

评论(0)