ECCV 2022 | AirDet:无需微调的小样本目标检测方法

本文提出无需微调的小样本目标检测方法AirDet,针对机器人自主探索任务设计。基训练后,未经微调的AirDet表现甚至优于部分微调后的方法。论文、项目代码、ROS部署接口均已开源。

AirDet

网站:https://jaraxxus-me.github.io/ECCV2022_AirDet/

论文:https://arxiv.org/abs/2112.01740

代码:https://github.com/Jaraxxus-Me/AirDet

ROS部署:https://github.com/Jaraxxus-Me/AirDet_ROS

引言

小样本目标检测(FSOD)是近年兴起的一项计算机视觉任务,其基本设定是,仅提供少量(通常少于等于10个)新类样本情况下,方法即需检测基训练集之外类别的目标。

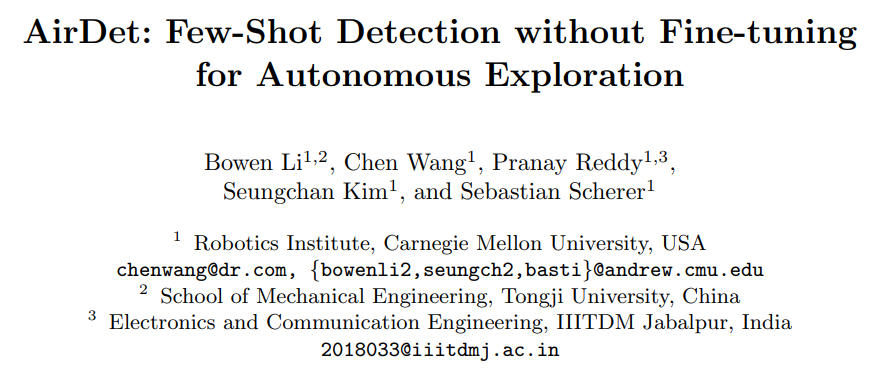

由于其在自主探索中的重要作用,FSOD受到了机器人界越来越多的关注。这是因为我们通常期望机器人在未知环境中检测到(模型训练过程中未见过的)新物体,然而在线探索的过程中,用户只能在线标注提供少量的新类样本。譬如图一(a)中,用户提供少量标注后,方法需要检测钻孔机、头盔等未见过的新颖类别目标。

尽管FSOD最近有了很显著的发展,但是大多数现有的方法在应用前都遵循基训练、小样本微调两阶段范式。然而微调阶段并不适用于机器人在线探索的应用场合,因为:

-

探索过程中待检测的新类别是可以动态变化的(如不断增加的)。如果每次改变类别都重新微调模型,一方面对于时间紧迫的探索任务而言效率极低,另一方面也会为有限的机器人机载算力带来过高负荷。

-

微调阶段的许多超参数都需要验证集进行调节,如微调学习率、模型收敛epoch等。然而对于在线探索任务而言,验证集是不存在的,超参调节自然也就难以进行。

为此,我们提出了一种无需微调的小样本目标检测方法AirDet。如图一(b)所示,未经微调的AirDet甚至能取得比一些微调后的方法更好的结果。

图一. 来自机器人探索(DARPA Subt 挑战赛)的代表性图像和性能比较。实线表示没有微调的结果,虚线表示在少样本数据上微调后的结果。

贡献

-

本文提出在机器人自主探索任务中可行的,无需微调的小样本检测模型,AirDet。

-

本文提出“与类别无关的关联性(class-agnostic relation)”,包含空间关联性与通道关联性,这是AirDet的模型设计核心。

-

在COCO,VOC,LVIS数据集与DARPA Subt挑战赛真实数据中的详尽实验评估证明了AirDet的优越性与可行性。

-

我们也提供了AirDet的ROS接口与AGX上的部署指南。

方法介绍

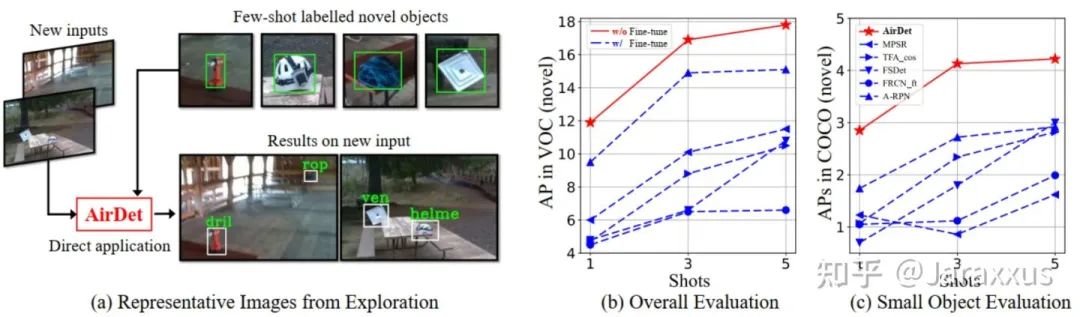

图二. 自主探索任务的流程和 AirDet 的算法框架。

图二展示了机器人自主探索任务的流程和AirDet的宏观模型结构。

任务流程

在探索未知环境过程中,机器人首先将可能包含重要物体(如头盔)的原始图片发送给用户。用户会在线给出标注并提供少量样本。此后,机器人便可立即 通过对后续环境的感知检测这些新类样本。

宏观结构

AirDet宏观上包含四个模块

-

共享的骨干网络,用于特征提取

-

由支持样本引导的多层特征融合的区域建议网络,用于在测试图片上生成候选框

-

基于全局-局部联系的样本融合网络,用于生成更具表征能力,更可靠的类原型特征

-

基于关联性的检测头,分为分类分支和检测框回归分支

核心理念

AirDet的模块设计理念均基于“与类别无关的关联性(class-agnostic relation)”。

与类别无关的关联性贯穿AirDet每个子模块的设计,这使得AirDet无需微调即可工作。每个子模块的设计细节请有兴趣的读者参阅我们的原文或代码。

实验

条件设定

基训练集:

COCO2017 train数据集中非VOC的60类数据(等价于COCO2014 trainval中剔除5k测试图片)

测试集:

-

COCO2017 val数据集中属于VOC的20个新类数据(提供1,2,3,5shot 支持样本)

-

Pascal VOC2012 val数据集

-

LVIS 数据集中四组非常规类别

-

DARPA Subt 挑战赛中的真实数据

值得一提的是,由于AirDet无需微调,在所有测试数据,不同shot的设定中,我们都可采用同一个基训练出来的模型(而不需要针对不同的场景调整不同的微调超参数)。

COCO

![]()

COCO数据集上的结果比较。

COCO上的结果显示,无需微调的AirDet已经比肩,甚至优于许多微调后的方案,微调后,AirDet的性能更加可观。无需微调的条件下,方法的结果对支持样本较敏感,故而我们随机采样了3-5组样本,展示了其平均结果和标准差,表中由 † 表示。

![]()

COCO数据集上不同尺度的目标检测结果比较

得益于AirDet中由支持样本引导,可学习多层特征联系的SCS模块(详见原文),AirDet在多尺度目标检测中也比已有的方案更优(优于采纳FPN的方案)。

值得一提的是,对于多尺度目标的检测,微调后的模型表现不一定更好。

![]()

COCO 10-shot 结果比较

大多现有方案对于COCO数据集采纳10-shot场景,我们也给出AirDet 10-shot的结果如上表。(不过最新的CVPR2022中,COCO 10-shot已经能达到17-18 AP,不得不感慨CV发展的迅猛)

VOC

![]()

VOC 跨领域结果比较

通常机器人的工作环境与训练集有较大差别,我们展示的跨领域性能(COCO训练,VOC测试)如上表。

Subt 挑战赛

图三. DARPA SubT挑战赛中的定性结果

感觉放了好多表,SUBT就放一些定性图。左侧是提供给AirDet的新类样本,右侧是AirDet的检测结果,可见AirDet对真实探索环境中的尺度变化、照度变化等挑战因素较为鲁棒。

局限性

无需微调的小样本目标检测研究甚少,目前可以不微调直接工作的仅有A-RPN和AirDet两个方法,而这个任务对机器人在位置环境中的探索感知又比较重要。为了这个领域未来能得到关注并发展的更好,我们也真诚摆出AirDet的局限性:

-

AirDet目前模型参数较多,运行速度不快,我们在AGX Xavier上如果不做TensorRT加速,运行速度仅有1~2FPS。更轻量化的模型是可优化的方向。

-

我们观察到AirDet的failure case主要是由分类导致的,具体问题有两个。第一,类间variance大,有些类AP高达30,有些类低至0.5。第二,AirDet对正样本分类不够好。举例来说,如果给猫(新类)的支持样本,AirDet在测试图片上:在猫的区域生成候选框,和将含有猫的候选框分类为猫,这两个任务表现不佳(体现为loss大)。所以设计更有效地分类策略是提升AirDet性能的可观方向。

-

AirDet对于多类检测的效率较低。AirDet的SCS和检测头内部会对支持类跑循环,最后在所有类下找到得分最高的,这种跑法会导致类别过多时推理速度变慢。(这应该也是大多数基于元学习(meta-learning)的FSOD的局限性)

-

最后坦白的说,未经微调的AirDet与微调的方法在某些情况下仍有一些差距,这也说明AirDet的性能仍有较大提升空间。

文章来源: blog.csdn.net,作者:AI视觉网奇,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/jacke121/article/details/126047273

- 点赞

- 收藏

- 关注作者

评论(0)