李宏毅《机器学习》丨5. Tips for neural network design(神经网络设计技巧)

【摘要】 一、局部最小值与鞍点Optimization Fails because …local minima(局部最小值)saddle point(鞍点)▲ 优化失败原因 二、批次与动量Optimization with Batch▲ 批次优化 Gradient Descent + Momentum▲ 带动量的梯度下降 三、自动调整学习速率RMSProp(root mean square pr...

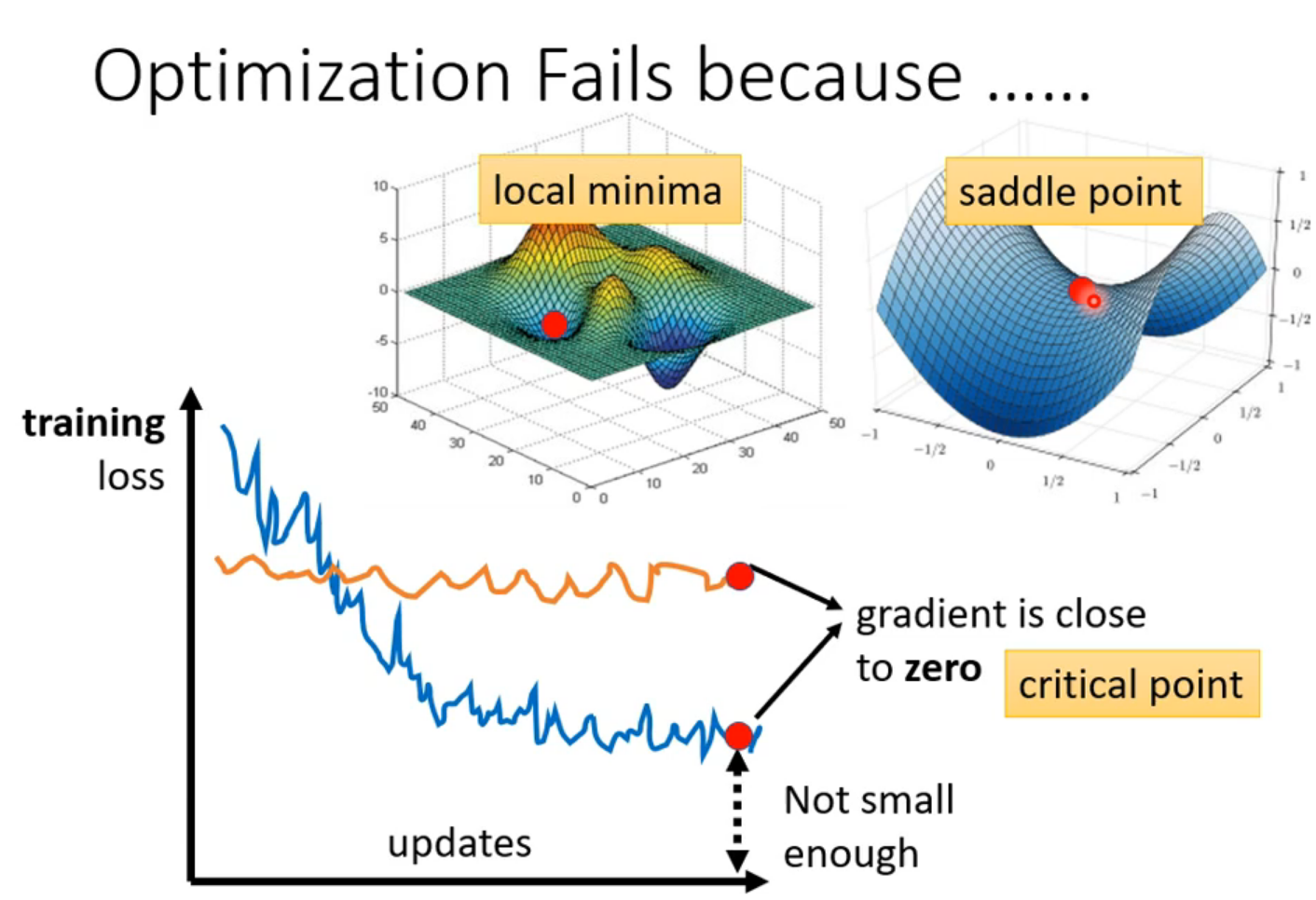

一、局部最小值与鞍点

Optimization Fails because …

- local minima(局部最小值)

- saddle point(鞍点)

▲ 优化失败原因

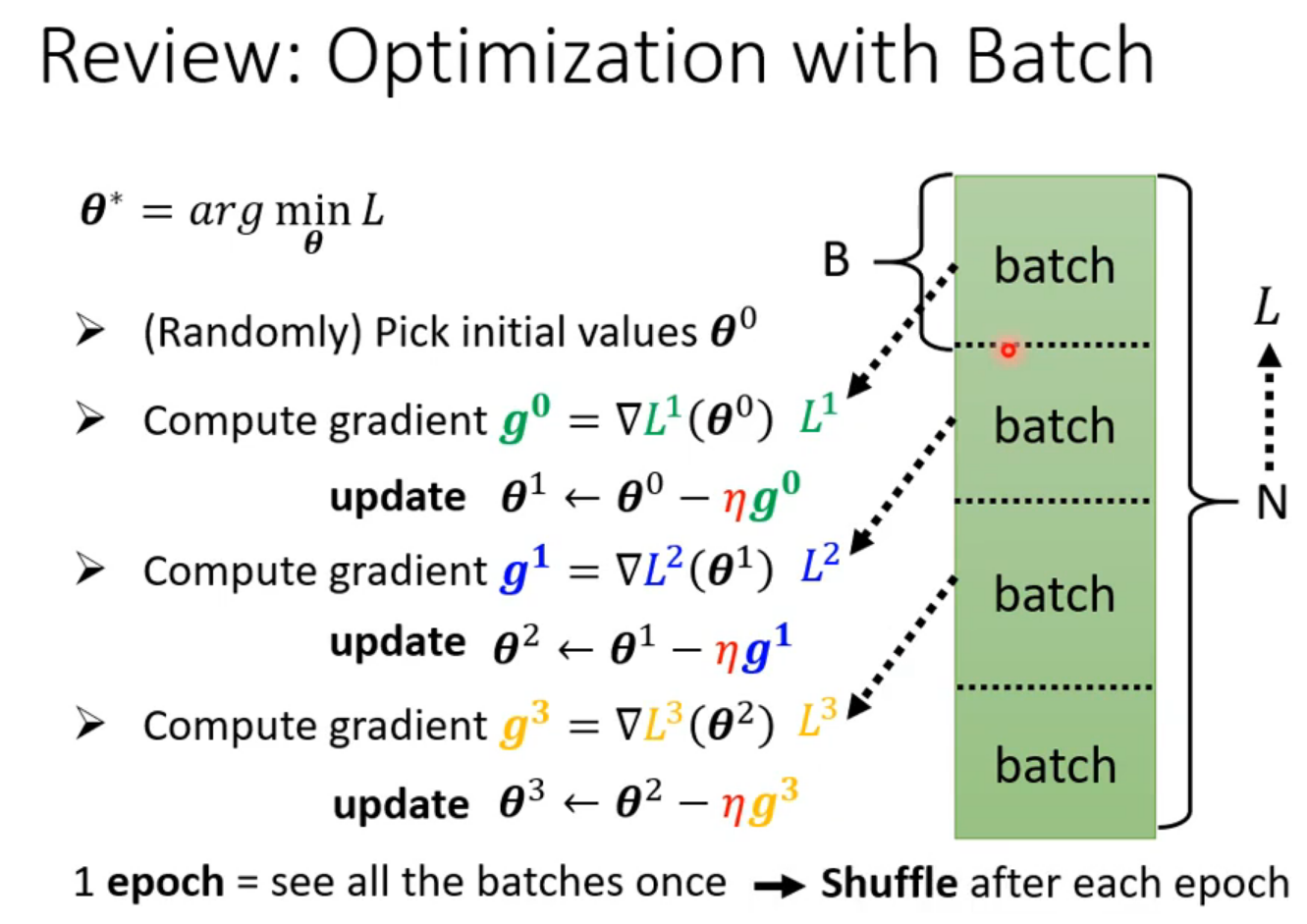

二、批次与动量

- Optimization with Batch

▲ 批次优化

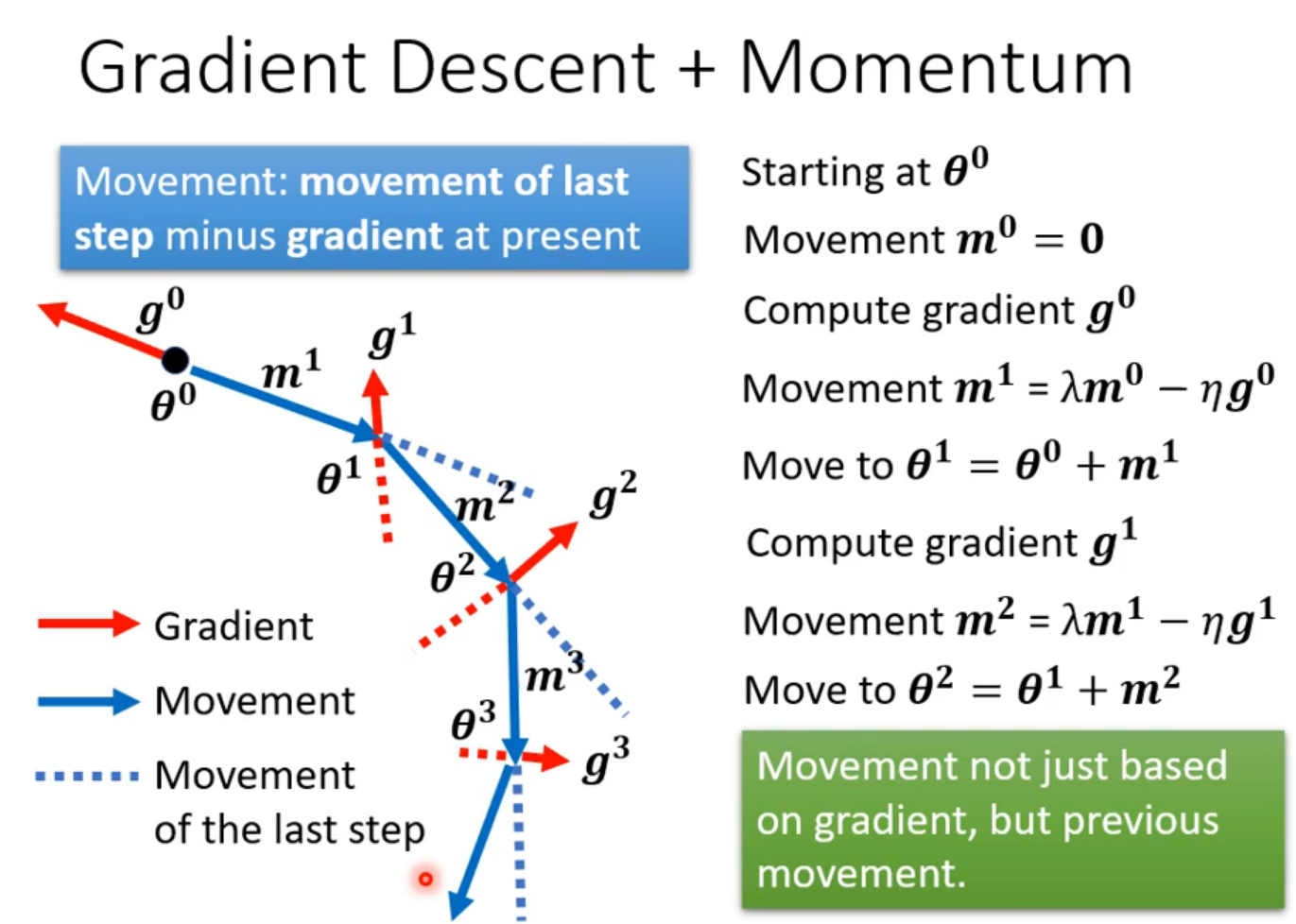

- Gradient Descent + Momentum

▲ 带动量的梯度下降

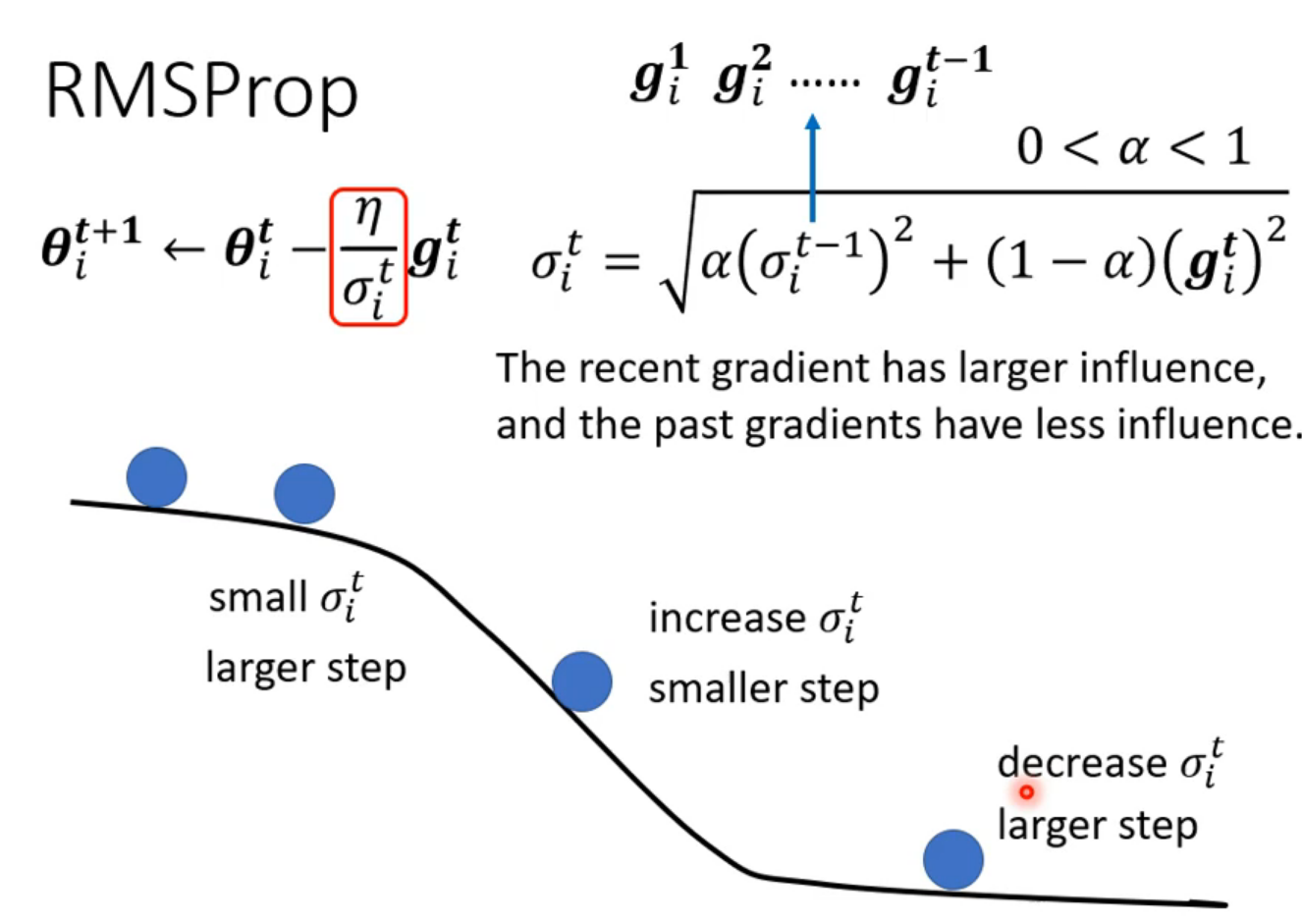

三、自动调整学习速率

RMSProp(root mean square prop,均方根)

学习原理∶在自适应梯度基础上引入了衰减因子,在梯度累积的时候,会对“过去”与“现在”做一个平衡,通过超参数进行调节衰减量。

适合处理非平稳目标(也就是与时间有关的),对于RNN效果很好。

▲ RMSProp

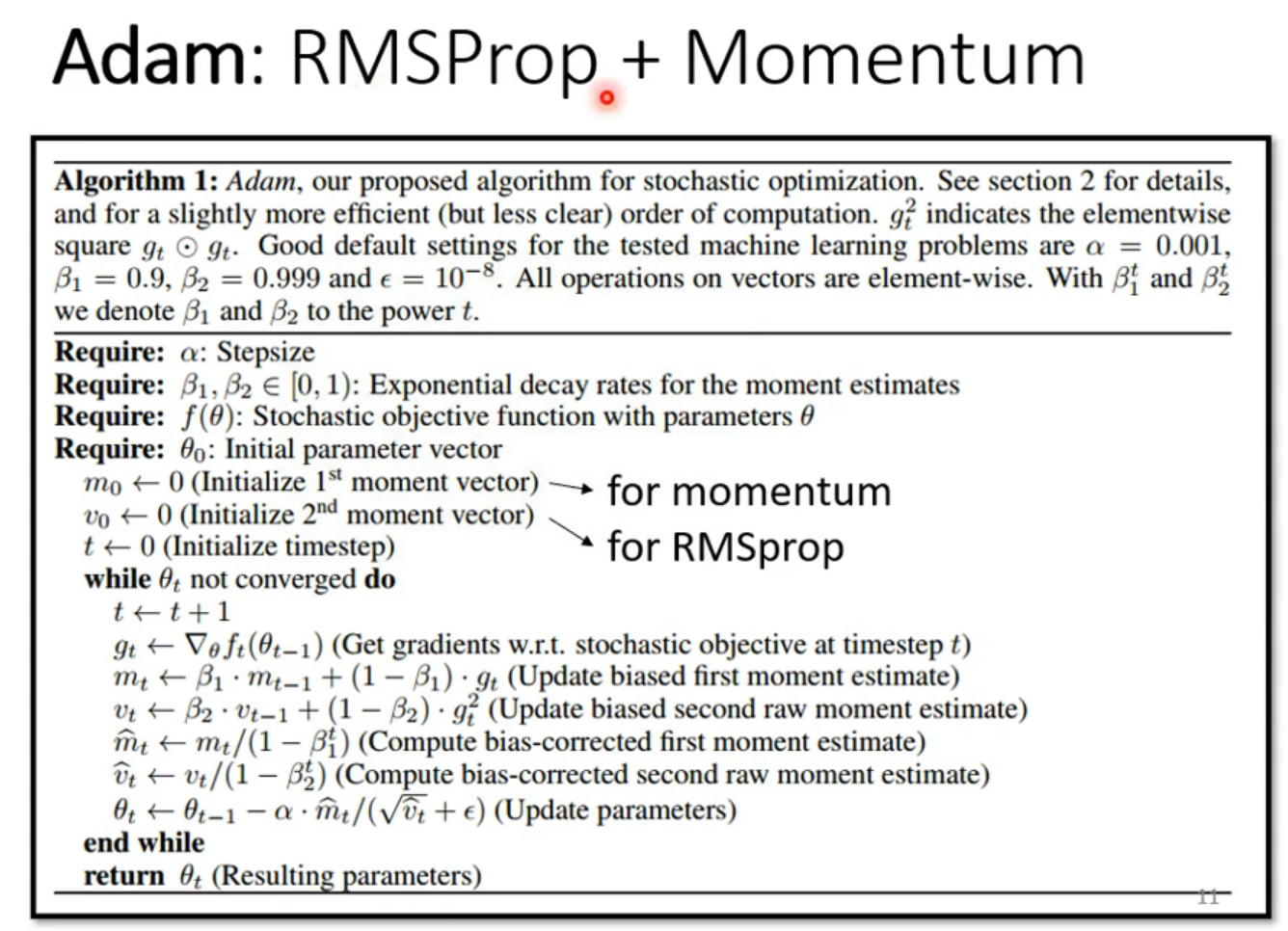

Adam(Adaptive momentum optimization,自适应动量优化)

是目前深度学习中最流行的优化方法,它结合了自适应梯度善于处理稀疏梯度和均方根善于处理非平稳目标的优点,适用于大数据集和高维空间。

▲ Adam

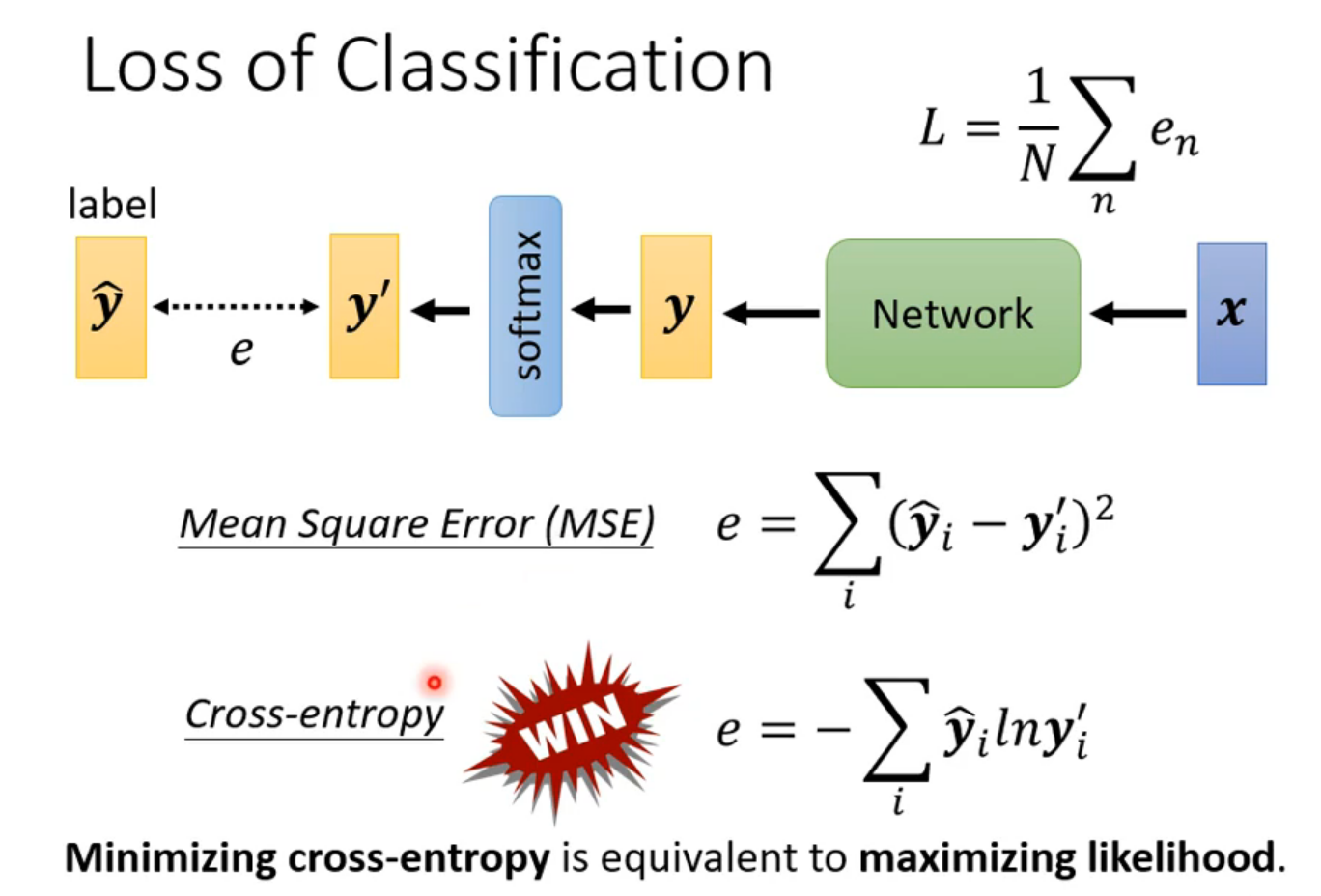

四、损失函数的影响

主要是对分类任务的影响。

▲ Loss of Classification

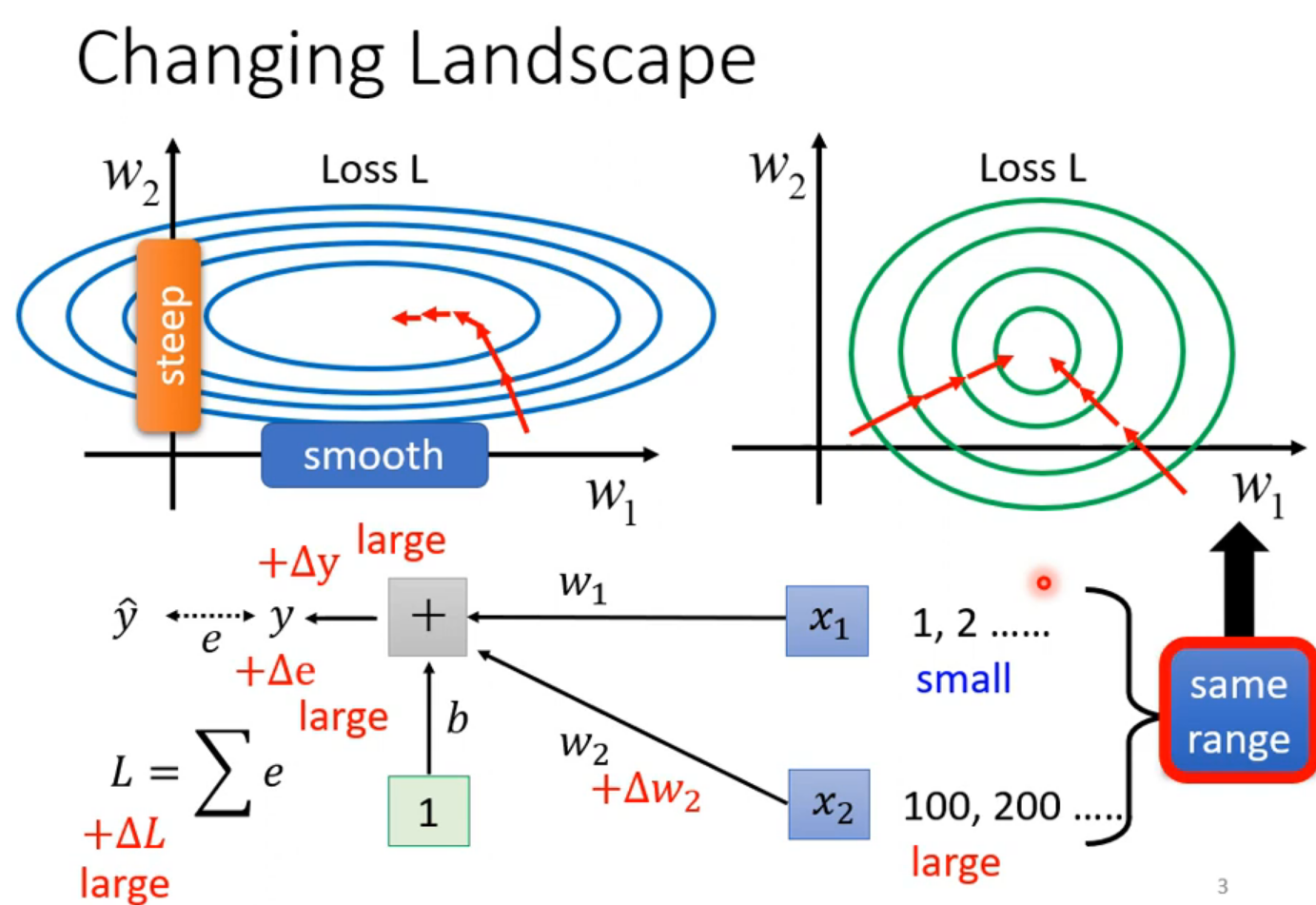

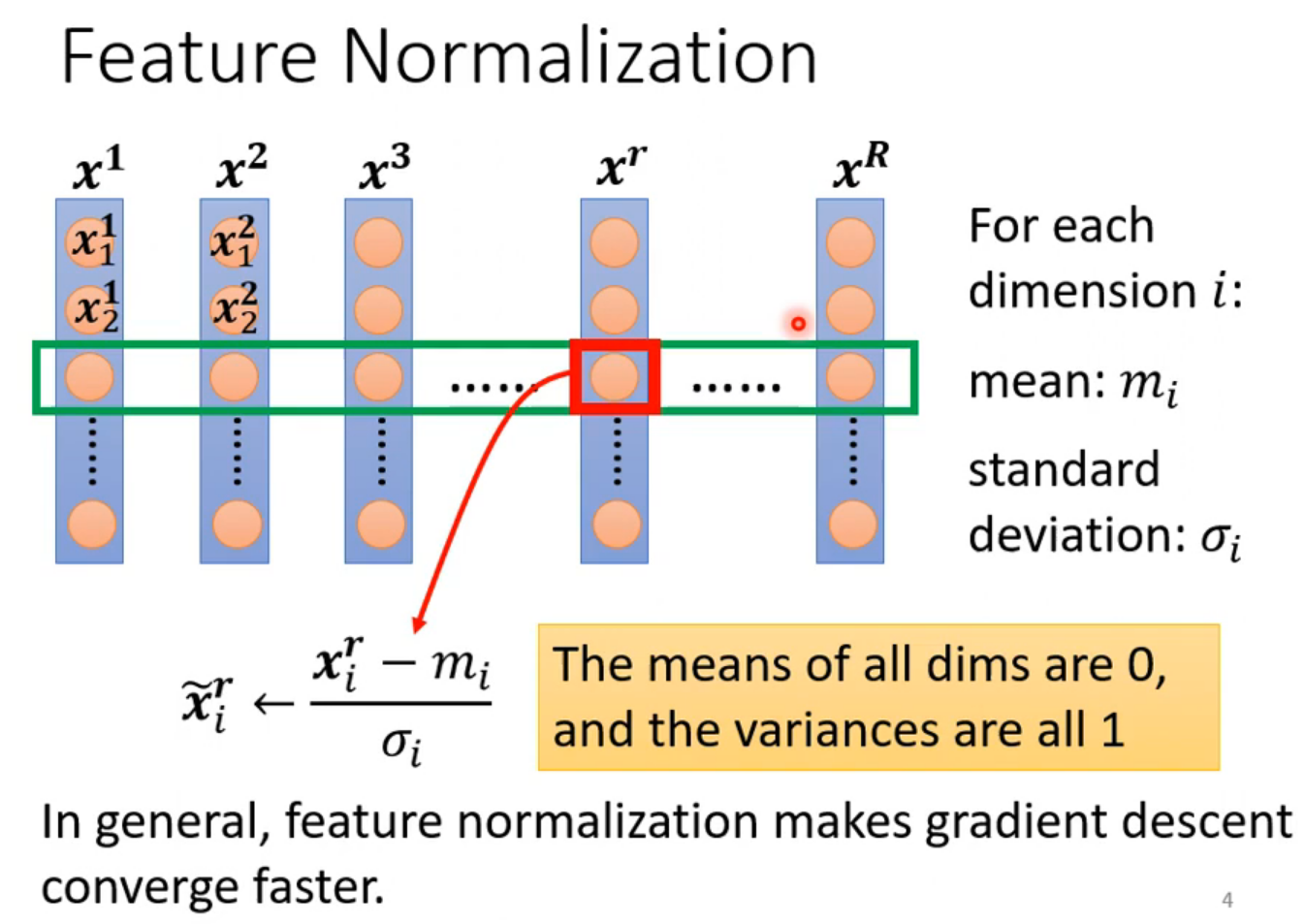

五、批次标准化

批次标准化(Batch Normalization),改变不同特征的范围(changing landscape)。

▲ Changing Landscape

▲ Feature Normalization

六、总结

Datawhale组队学习,李宏毅《机器学习》Task5. Tips for neural network design(神经网络设计技巧)。包括局部最小值与鞍点、批次与动量、自动调整学习速率、损失函数的影响和批次标准化。李老师课程中对数学的原理讲得很清楚,不过对于侧重应用可以不求甚解,知道设计的技巧即可。

——END——

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)