“目标检测“+“视觉理解“实现对输入图像的理解

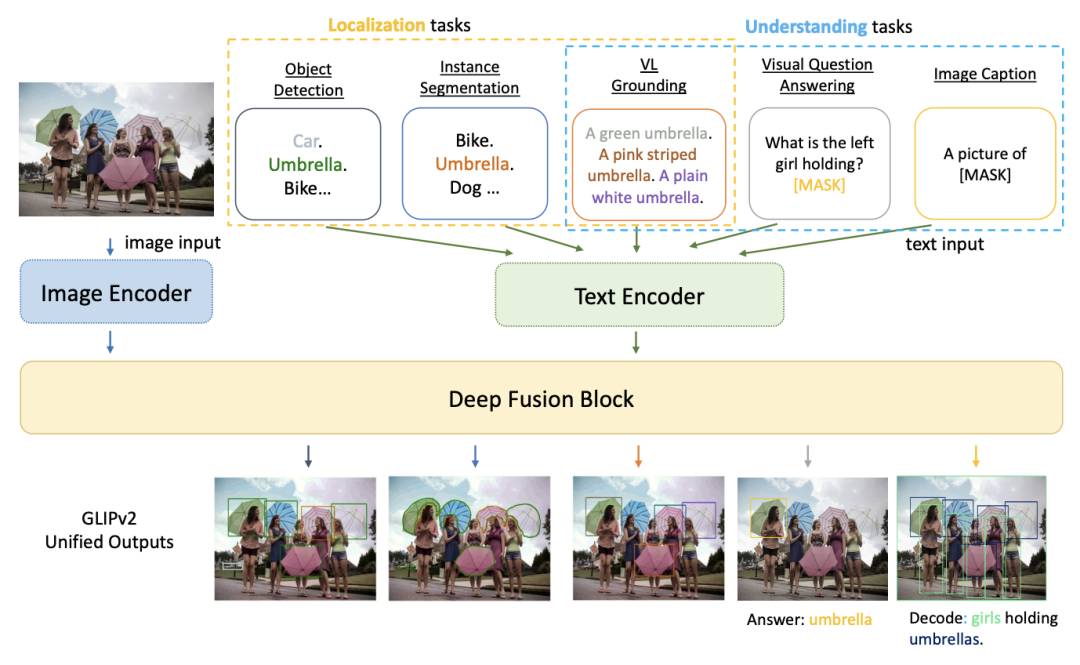

提出了GLIPv2,一种基于VL的理解模型,它服务于localization任务(例如,目标检测、实例分割)和视觉语言(VL)理解任务(例如,VQA、图像字幕)。

论文地址:https://arxiv.org/pdf/2206.05836.pdf

代码地址:https://github.com/microsoft/GLIP

预训练模型最小的2.5G,

01概述

GLIPv2优雅地将localization预训练和视觉语言预训练 (VLP) 与三个预训练任务相结合:phrase grounding作为检测任务的VL重构,区域-词对比学习作为新的区域-词级对比学习任务和掩码语言建模。这种统一不仅简化了之前的多阶段VLP程序,而且实现了定位和理解任务之间的互惠互利。实验结果表明,单个GLIPv2模型(所有模型权重共享)在各种定位和理解任务上实现了接近SoTA的性能。该模型还展示了:

-

在开放词汇目标检测任务上的强大的零样本和少样本自适应性能;

-

在 VL 理解任务上的出色grounding能力

02背景

最近,人们普遍关注构建通用视觉系统,也称为视觉基础模型,它可以同时解决各种视觉任务,例如图像分类、物体检测,以及视觉语言 (VL) 理解。特别感兴趣的是定位任务(例如,目标检测和分割)和VL理解任务(例如,VQA和图像字幕)之间的统一。

localization预训练有利于VL任务,“localization->VLP”两阶段预训练过程是VL社区。一个长期存在的挑战是localization和理解的统一,旨在这两种任务之间互惠互利,简化预训练程序并降低预训练成本。

然而,这两种任务似乎有很大的不同:定位任务仅是视觉任务,需要细粒度的输出(例如,边界框或像素掩码),而VL理解任务强调两种模式之间的融合,需要高级语义输出。例如,答案或标题)。

03新框架

Left: GLIPv2, a pre-trained grounded VL understanding model, unifies various localization and VL understanding tasks. These two kinds of tasks mutually benefit each other, and enables new capabilities such as language-guided detection/segmentation and grounded VQA/captioning. Right: Additional examples from ODinW (detection), LVIS (segmentation), VQA, and COCO Captioning.

A Unified VL Formulation and Architecture

GLIPv2统一公式的核心是分类匹配技巧,它将任何特定于任务的固定词汇分类问题重新表述为与任务无关的开放词汇视觉语言匹配问题。最好的例子是在CLIP中将图像分类重新表述为图像-文本匹配,这使模型能够直接从原始图像-文本数据中学习,并在开放词汇分类任务上实现强大的零样本结果。在GLIPv2 中,我们用视觉语言匹配点积层替换了传统单模态视觉模型中的每个语义分类线性层。

GLIPv2 Pre-training

GLIPv2使用三个预训练损失进行预训练:来自目标检测任务的视觉语言重构的phrase grounding损失Lground、来自新的区域单词级别对比学习任务的区域单词对比损失 Linter,以及标准掩码BERT中提出的语言建模损失Lmlm。

Transfer GLIPv2 to Localization and VL Tasks

我们引入了两种轻松将GLIPv2传输到各种下游任务的方法。此外,GLIPv2可以在本地化的同时执行传统的VL任务(例如VQA),有效地使我们认为的每项任务都成为“基础的VL理解”任务。

GLIPv2 pre-training losses: the intra-image alignment loss Lintra (right) takes features after VL fusion and compute loss over region-word pairs within each image-text pair; the inter-image contrastive loss (left) Linter takes features before VL fusion and compute loss over all region-word pairs across a batch of image-text pairs. Label propagation is used to determine the off-diagonal blocks of the Linter target matrix.

04

实验及可视化

文章来源: blog.csdn.net,作者:AI视觉网奇,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/jacke121/article/details/125549739

- 点赞

- 收藏

- 关注作者

评论(0)