清华加强版「蚂蚁呀嘿」来袭 鬼畜区up主再也不用手动抠素材了

开源地址:

https://github.com/yoyo-nb/Thin-Plate-Spline-Motion-Model

预训练300多m

2021年初,一股「蚂蚁呀嘿」的妖风吹遍各大社交平台,相信你也曾经刷到过互联网大佬、政要名人、体育明星甚至是动漫人物穿越时空,共同做着夸张的表情,唱着魔性的「蚂蚁呀嘿」的视频。

这是图像驱动(image animation)任务第一次进入大众视野,大家对它的一致印象是「十分有趣」。

时隔一年,清华团队再次发布静图成画新模型demo。

「蚂蚁呀嘿」背后的AI模型简称MRAA(Motion Representations for Articulated Animation),而今天文章的主角,是由清华软院团队提出的简称为TPSM的模型(Thin-Plate Spline Motion Model for Image Animation)。

TPSM到底与MRAA相比,到底有哪些方面的提升呢?

小编总结为以下三点:跟得上,猜得好,想得细。

想要对比同一任务下两项不同的研究工作,理论上应该先找到一个/套客观的评估指标(metrics),但图像驱动任务与CV领域的大部分其他下游任务不同,其并没有直白明确的评估指标,目前该任务中的论文会选择对比两类参数:

一类参数度量了生成视频与ground-truth之间的客观差距,如L1差距(像素级平均L1距离)、MKR(关键点丢失率)、AKD(关键点平均距离)及AED(平均欧式距离)等。

另一类为人类观察员的主观赞同比。

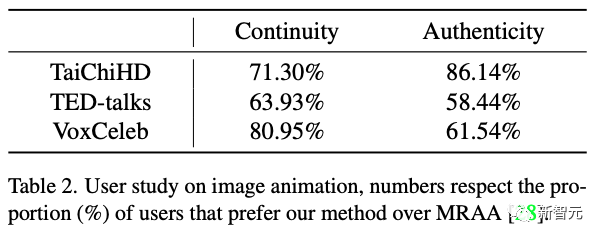

在TPSM论文中给出的这两项参数的对比如下(表1-客观差距对比,表2-主观赞成率对比):

表 1中对比了主流的图像驱动模型之间的客观表现,如果我们盯着L1距离看(表中

),TPSM并没有跟MRAA拉开差距,在TED演讲数据集上甚至要比MRAA差。真正拉开差距的指标是人类观察员的主观赞同率。

表 2体现了全身太极拳(TaiChiHD)、半身TED演讲(TED-talks)及明星访谈特写(VoxCeleb)三个不同的数据集上,人类观察员在连贯性(Continuity)及真实性(Authenticity)两个指标中对于TPSM的赞同程度。

从表 2中可以看到,从人类主观上看,在太极打拳视频的真实性以及明星演讲视频的连贯性上,TPSM均大幅度好于MRAA。接下来让我们进入算法层面看看TPSM在主观效果上优于MRAA的原因。

全身太极拳(TaiChiHD):「跟得上」

太极拳视频中人物的动作幅度相对较大,这导致了驱动视频(Driving)和源图像(Source)之间可能存在着较大的姿态差异(a large pose gap),如果不能良好的建立驱动视频与源图像任务动作姿态之间的关系,则会导致生成的视频「跟不上」驱动视频,在效果上体现为生成视频中人物关键点的不匹配。

例如下图MRAA生成的视频中,人物的一只手掌未能与手臂相连,显然此时MRAA模型未能将源图像中该只手掌的关键点位置与驱动视频中相应关键点成功匹配,但TPSM却较好的做好了这一点。

如果不能很好的完成源图像与驱动视频之间匹配的关键点,会导致人物手、足与躯干分离等状况出现进而带来不真实感,这是MRAA在太极拳数据集中的「真实感」指标中大幅落后于TPSM的原因。

TPSM模型之所有能够「跟得上」(良好的匹配源图像与驱动视频之间的关键点),得益于其最大的创新点,即提出了一个名为TPSM( thin-plate spline motion)的动作估计方法,该方法可以产生更加灵活的光流,将源图像的feature-map和驱动视频的feature-domain关联起来(使用warp操作)。

明星访谈特写(VoxCeleb):「猜得好」

源图像(Source)是静态的,往往只展示了人物某一个角度的形象(例如人物的一个侧脸),如果驱动视频(Driving)中人物出现了转动,迫使源图像必须展示出原图中没有的角度时,就要考验模型「猜」的本领了。如果「猜」得不好,可能会出现画面空白。

例如下图中MRAA与TPSM在明星访谈特写数据集中的对比可以看出,当源图像和驱动视频中人物面部角度相同时,两个模型的效果是不相上下的。

但当人物头部转动到原图中没有展示出的角度时,MRAA虽然「猜」出了该角度下人物的脸颊,却「猜」不出人物的头发,导致头发部分缺失。但TPSM却能够较好地「猜」出这个全新角度下人物的样子。

之所以能够「猜」的更好得益于TPSM的第二大创新点,TPSM使用了多分辨率闭合遮罩(multi-resolution occlusion masks)取得了更有效的特征融合结果。

使用沙漏网络结构融合不同尺度下的特征本是常规操作,但常规做法中往往只使用一个闭合遮罩(single occlusion masks)来mask out不同尺度下的feature-map,TPSM却为不同分辨率的feature-map设置了多个闭合遮罩。

半身TED演讲:「想得细」

从表-2可以看到,在「半身TED演讲」数据集上的TPSM领先幅度较小,这是因为在该数据上TPSM的提升往往在细节上。

例如下中MRAA模型生成的人物,手部细节是严重不足的,看起来更像是一团大肉瘤,而TPSM模型生成的手部还可以依稀看得出手指的模样。所以在细节的重构上,TPSM的效果更好。

之所以能够「想得更细」,得益于TPSM的第三个创新点,TPSM加入了额外的辅助Loss,通过更合理的工作量分配,来鼓励模型取得更高质量的输出,该辅助Loss基于仿射变换(affine transformation)可以在训练过程中为模型提供额外的约束。

总结一下

由于图像驱动任务有非常多特性技术细节,想要彻底说清楚这些技术细节至少可以追溯到2018年ECCV上的X2face,并且绕不开2019年NeurIPS上真正被学界大规模认可的图像驱动模型FOMM(First order motion model for image animation)。

如果你发现自己在读完之后还是一团云里雾里的话,实属正常。

此外,本文仅从算法原理上分析了TPSM效果可能会更好的原因,但至于其大规模应用效果如何,还有待时间的检验。

文章来源: blog.csdn.net,作者:AI视觉网奇,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/jacke121/article/details/125137512

- 点赞

- 收藏

- 关注作者

评论(0)