MySQL会丢数据吗?

在业务高峰期临时提升性能的方法。

WAL机制保证只要redo log和binlog保证持久化到磁盘,就能确保MySQL异常重启后,数据可以恢复。

binlog的写入机制

事务执行过程中:

- 先把日志写到binlog cache

- 事务提交时,再把binlog cache写到binlog文件

一个事务的binlog不该被拆开,不论事务多大,也要确保一次性写入。这就涉及binlog cache的保存问题。

系统给binlog cache分配了一片内存,每个线程一个,但是共用同一份binlog文件。参数 binlog_cache_size控制单个线程内binlog cache所占内存的大小。若超过该参数值,就要暂存到磁盘。

事务提交时,执行器把binlog cache里的完整事务写入binlog,并清空binlog cache。

- binlog写盘状态

TODO

图中的: - write

把日志写入到文件系统的page cache,并没有把数据持久化到磁盘,所以速度较快 - fsync

将数据持久化到磁盘。一般认为fsync才占磁盘的IOPS

write 和fsync的时机,由参数sync_binlog控制:

- sync_binlog=0,每次提交事务都只write,不fsync

- sync_binlog=1,每次提交事务都会执行fsync

- sync_binlog=N(N>1),每次提交事务都write,但累积N个事务后才fsync

因此,在出现I/O瓶颈的场景,将sync_binlog设置成一个较大值,可提升性能。在实际的业务场景中,考虑到丢失日志量的可控性,一般不建议将这个参数设成0,推荐将其设置为100~1000中的某个数值。

但将sync_binlog设置为N,对应的风险是:若主机发生异常重启,会丢失最近N个事务的binlog日志。

redo log的写入机制

接下来,我们再说说redo log的写入机制。

事务在执行过程中,生成的redo log是要先写到redo log buffer的。

- 那redo log buffer的内容,是不是每次生成后都要直接持久化到磁盘呢?

不需要。

若事务执行期间MySQL异常重启,那这部分日志就丢了。由于事务也尚未提交,所以这时日志丢了也没有损失。

- 那事务还没提交时,redo log buffer中的部分日志有没有可能被持久化到磁盘呢?

会有。

这个问题,要从redo log可能存在的三种状态说起。这三种状态,对应的就是图2 中的三个颜色块。

- MySQL redo log存储状态

TODO

三种状态: - 存在redo log buffer

物理上是在MySQL进程内存 - 写到磁盘(write),但还没持久化(fsync)

物理上是在文件系统的page cache - 持久化到磁盘,即hard disk

日志写到redo log buffer很快,wirte到page cache也差不多,但持久化到磁盘就很慢了。

InnoDB提供innodb_flush_log_at_trx_commit参数控制redo log的写入策略:

- 0,每次事务提交时都只是把redo log留在redo log buffer中

- 1,每次事务提交时都将redo log直接持久化到磁盘

- 2,每次事务提交时都只是把redo log写到page cache

InnoDB的一个后台线程,会每隔1s把redo log buffer中的日志,调用write写到文件系统的page cache,然后调用fsync持久化到磁盘。

事务执行中间过程的redo log也是直接写在redo log buffer,这些redo log也会被后台线程一起持久化到磁盘。即一个没有提交的事务的redo log,也可能已经持久化到磁盘。

除了后台线程每s一次的轮询操作,还有两种场景会让一个未提交的事务的redo log写入磁盘:

- redo log buffer占用的空间即将达到 innodb_log_buffer_size的一半,后台线程会主动写盘

由于这个事务并未提交,所以这个写盘动作只是write,没有调用fsync,即只留在文件系统的page cache。 - 并行的事务提交时,顺带将该事务的redo log buffer持久化到磁盘

假设一个事务A执行到一半,已经写了一些redo log到buffer,这时另外一个线程的事务B提交,若innodb_flush_log_at_trx_commit是1,则事务B要把redo log buffer里的日志全部持久化到磁盘。这时,就会带上事务A在redo log buffer里的日志一起持久化到磁盘。

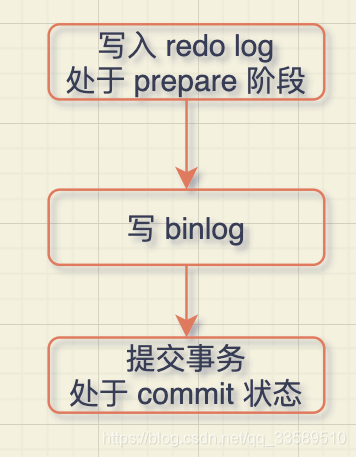

两阶段提交的过程,时序上redo log先prepare,再写binlog,最后再把redo log commit。

若把innodb_flush_log_at_trx_commit置1,则redo log在prepare阶段就要持久化一次,因为有一个崩溃恢复逻辑是要依赖于prepare 的redo log,再加上binlog来恢复的。

每s一次的后台轮询刷盘,再加上崩溃恢复,InnoDB就认为redo log在commit时无需fsync,只write到文件系统的page cache就够了。

通常我们说MySQL的“双1”配置,指的就是sync_binlog、innodb_flush_log_at_trx_commit都是1。即一个事务完整提交前,需要等待两次刷盘:

- redo log(prepare 阶段)

- binlog

那这意味着我从MySQL看到TPS是2w,每秒就会写四万次磁盘。但我用工具测试,磁盘能力也就2w左右,怎么能实现2w TPS?

得用组提交(group commit)来解释了。

日志逻辑序列号(log sequence number,LSN)

LSN单调递增,对应redo log的写入点。比如写入length长度的redo log, 则LSN+length。

LSN也会写到InnoDB的数据,以确保数据页不会被多次执行重复的redo log。

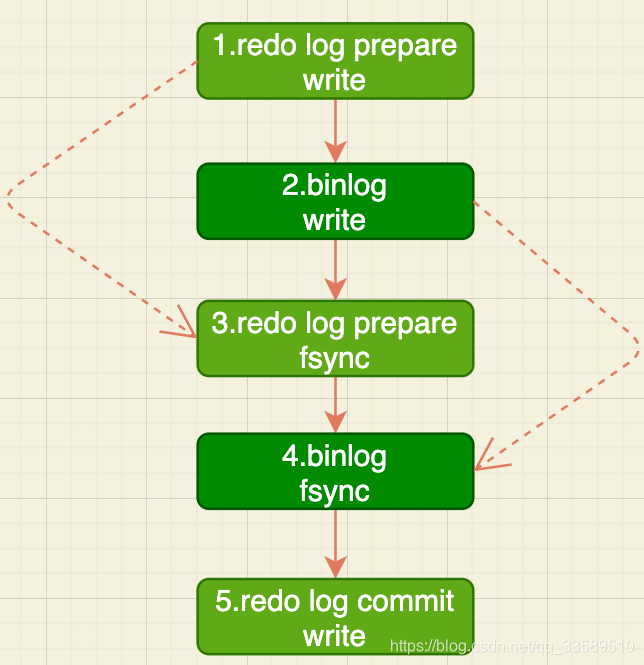

如图3所示,是三个并发事务(trx1, trx2, trx3)在prepare 阶段,都写完redo log buffer,持久化到磁盘的过程,对应的LSN分别是50、120 和160。

- redo log 组提交

TODO - trx1第一个到达,被选为这组的leader

- 等trx1要开始写盘,组里已经有了三个事务,LSN也变成了160

- trx1去写盘时,带的就是LSN=160。所以,等trx1返回时,所有LSN≤160的redo log,都已被持久化到磁盘

- 这时,trx2和trx3就可直接返回

所以,一次组提交里,组员越多,节约磁盘IOPS效果越好。但若只有单线程压测,则只能老老实实地一个事务对应一次持久化操作。

在并发更新场景下,第一个事务写完redo log buffer后,接下来这个fsync越晚调用,组员可能越多,节约IOPS效果越好。

为了让一次fsync带的组员更多,MySQL采取优化:拖时间。

- 两阶段提交

写binlog实际上分成两步:

- 先把binlog从binlog cache中写到磁盘上的binlog文件

- 调用fsync持久化

MySQL为了让组提交效果更好,把redo log做fsync的时间拖到了step1后面:

- 两阶段提交细化

这样的话,binlog也可以组提交。上图的step4时,若有多个事务的binlog已经写完,也是一起持久化的,这样也能减少IOPS。

一般step3执行很快,所以binlog的write、fsync间隔时间很短,导致能集合到一起持久化的binlog较少,因此binlog的组提交的效果通常不如redo log的效果。

若想提升binlog组提交效果,可设置:

- binlog_group_commit_sync_delay参数

延迟多少微秒后才调用fsync - binlog_group_commit_sync_no_delay_count参数

累积多少次以后才调用fsync

这两个条件是或的关系,即只要有一个满足条件就会调用fsync。

这样的话,binlog_group_commit_sync_delay = 0 时,binlog_group_commit_sync_no_delay_count就无效了。

WAL是减少磁盘写,可每次提交事务都要写redo log和binlog,这磁盘的读写次数也没变少呀?s所以现在就能理解了,WAL主要得益于:

- redo log 和 binlog都是顺序写,磁盘的顺序写比随机写速度要快

- 组提交机制,可大幅度降低磁盘IOPS

所以,若MySQL出现IO性能瓶颈,可通过如下方法优化:

- 设置 binlog_group_commit_sync_delay 、binlog_group_commit_sync_no_delay_count,减少binlog写盘次数

该方案是基于“额外的故意等待”来实现的,因此可能会增加语句的响应时间,但不会丢数据 - 将sync_binlog 设为大于1的值(推荐100~1000)

风险是,主机掉电时会丢binlog日志。 - 将innodb_flush_log_at_trx_commit设为2

风险是,主机掉电的时候会丢数据。

不推荐把innodb_flush_log_at_trx_commit 设成0。因为此时表示redo log只保存在内存,这样MySQL本身异常重启也会丢数据,风险太大。而redo log写到文件系统的page cache的速度是很快的,所以将该参数设成2跟设成0性能差不多,但这样做MySQL异常重启时就不会丢数据了。

小结

MySQL是“怎么保证redo log和binlog是完整的”。

crash-safe

-

执行一个update后,再执行hexdump直接查看ibd文件内容,为什么没有看到数据有改变?

可能因为WAL。update语句执行完后,InnoDB只保证写完了redo log、内存,可能还没来得及将数据写磁盘。 -

为什么binlog cache是每个线程自己维护的,而redo log buffer是全局共用?

binlog不能“被打断”。一个事务的binlog必须连续写,因此要整个事务完成后,再一起写到文件。

而redo log没有这个要求,中间有生成的日志可以写到redo log buffer。redo log buffer中的内容还能“搭便车”,其他事务提交的时候可以被一起写到磁盘。 -

事务执行期间,还没到提交阶段,若发生crash,redo log肯定丢了,这会不会导致主备不一致呢?

不会。因为此时binlog还在binlog cache,没发给备库。crash之后,redo log和binlog都没有了,从业务角度看这个事务也没有提交,所以数据是一致的。 -

若binlog写完盘以后发生crash,这时还没给客户端答复就重启了。等客户端再重连进来,发现事务已经提交成功了,这是不是bug?

不是。设想一下更极端场景,整个事务都提交成功,redo log commit完成了,备库也收到binlog并执行了。但主库和客户端网络断了,导致事务成功的包返回不回去,这时客户端也会收到“网络断开”的异常。这种也只能算是事务成功的,不能认为是bug。

实际上DB的crash-safe保证的是:

- 如果客户端收到事务成功的消息,事务就一定持久化了

- 如果客户端收到事务失败(比如主键冲突、回滚等)的消息,事务就一定失败了

- 如果客户端收到“执行异常”的消息,应用需要重连后通过查询当前状态来继续后续的逻辑。此时DB只需要保证内部(数据和日志之间,主库和备库之间)一致即可。

- 点赞

- 收藏

- 关注作者

评论(0)