pkuseg分词库以及使用

1、什么是pkuseg

pkuseg 是由北京大学语言计算与机器学习研究组研制推出的一套全新的中文分词工具包。github地址: https://github.com/lancopku/pkuseg-python

2、特点

-

多领域分词。不同于以往的通用中文分词工具,此工具包同时致力于为不同领域的数据提供个性化的预训练模型。根据待分词文本的领域特点,用户可以自由地选择不同的模型。 我们目前支持了新闻领域,网络领域,医药领域,旅游领域,以及混合领域的分词预训练模型。在使用中,如果用户明确待分词的领域,可加载对应的模型进行分词。如果用户无法确定具体领域,推荐使用在混合领域上训练的通用模型。各领域分词样例可参考 example.txt。

-

高分词准确率。相比于其他的分词工具包,该工具包在不同领域的数据上都大幅提高了分词的准确度。根据测试结果,pkuseg分别在示例数据集(MSRA和CTB8)上降低了79.33%和63.67%的分词错误率。

-

支持用户自训练模型。支持用户使用全新的标注数据进行训练。

-

支持词性标注。

3、编译和安装

pip install pkuseg

之后通过import pkuseg来引用

4、使用方式

4.1 默认配置分词

(如果用户无法确定分词领域,推荐使用默认模型分词)

import pkuseg

seg = pkuseg.pkuseg() # 以默认配置加载模型

text = seg.cut('我爱北京天安门') # 进行分词

print(text)

运行结果:

4.2 细领域分词

(如果用户明确分词领域,推荐使用细领域模型分词)

import pkuseg

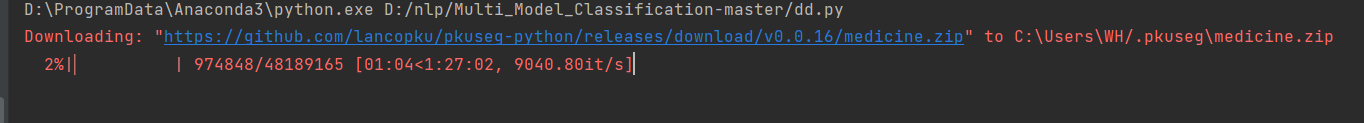

seg = pkuseg.pkuseg(model_name='medicine') # 程序会自动下载所对应的细领域模型

text = seg.cut('我爱北京天安门') # 进行分词

print(text)

4.3 词性标注

各词性标签的详细含义可参考 tags.txt

import pkuseg

seg = pkuseg.pkuseg(postag=True) # 开启词性标注功能

text = seg.cut('我爱北京天安门') # 进行分词和词性标注

print(text)

4.4 对文件分词

import pkuseg

# 对input.txt的文件分词输出到output.txt中

# 开10个进程

pkuseg.test('input.txt', 'output.txt', nthread=10)

4.5 额外使用用户自定义词典

import pkuseg

seg = pkuseg.pkuseg(user_dict='my_dict.txt') # 给定用户词典为当前目录下的"my_dict.txt"

text = seg.cut('我爱北京天安门') # 进行分词

print(text)

4.6 使用自训练模型分词(以CTB8模型为例)

import pkuseg

seg = pkuseg.pkuseg(model_name='./ctb8') # 假设用户已经下载好了ctb8的模型并放在了'./ctb8'目录下,通过设置model_name加载该模型

text = seg.cut('我爱北京天安门') # 进行分词

print(text)

4.7 训练新模型 (模型随机初始化)

import pkuseg

# 训练文件为'msr_training.utf8'

# 测试文件为'msr_test_gold.utf8'

# 训练好的模型存到'./models'目录下

训练模式下会保存最后一轮模型作为最终模型

# 目前仅支持utf-8编码,训练集和测试集要求所有单词以单个或多个空格分开

pkuseg.train('msr_training.utf8', 'msr_test_gold.utf8', './models')

4.8 fine-tune训练(从预加载的模型继续训练)

import pkuseg

# 训练文件为'train.txt'

# 测试文件为'test.txt'

# 加载'./pretrained'目录下的模型,训练好的模型保存在'./models',训练10轮

pkuseg.train('train.txt', 'test.txt', './models', train_iter=10, init_model='./pretrained')

4.9 参数说明

1)模型配置

pkuseg.pkuseg(model_name = "default", user_dict = "default", postag = False)

model_name 模型路径。

"default",默认参数,表示使用我们预训练好的混合领域模型(仅对pip下载的用户)。

"news", 使用新闻领域模型。

"web", 使用网络领域模型。

"medicine", 使用医药领域模型。

"tourism", 使用旅游领域模型。

model_path, 从用户指定路径加载模型。

user_dict 设置用户词典。

"default", 默认参数,使用我们提供的词典。

None, 不使用词典。

dict_path, 在使用默认词典的同时会额外使用用户自定义词典,可以填自己的用户词典的路径,词典格式为一行一个词(如果选择进行词性标注并且已知该词的词性,则在该行写下词和词性,中间用tab字符隔开)。

postag 是否进行词性分析。

False, 默认参数,只进行分词,不进行词性标注。

True, 会在分词的同时进行词性标注。

2)对文件进行分词

pkuseg.test(readFile, outputFile, model_name = "default", user_dict = "default", postag = False, nthread = 10)

readFile 输入文件路径。

outputFile 输出文件路径。

model_name 模型路径。同pkuseg.pkuseg

user_dict 设置用户词典。同pkuseg.pkuseg

postag 设置是否开启词性分析功能。同pkuseg.pkuseg

nthread 测试时开的进程数。

3)模型训练

pkuseg.train(trainFile, testFile, savedir, train_iter = 20, init_model = None)

trainFile 训练文件路径。

testFile 测试文件路径。

savedir 训练模型的保存路径。

train_iter 训练轮数。

init_model 初始化模型,默认为None表示使用默认初始化,用户可以填自己想要初始化的模型的路径如init_model='./models/'。

4.10 多进程分词

当将以上代码示例置于文件中运行时,如涉及多进程功能,请务必使用if name == '_main_’保护全局语句,详见多进程分词。

5、预训练模型

从pip安装的用户在使用细领域分词功能时,只需要设置model_name字段为对应的领域即可,会自动下载对应的细领域模型。

从github下载的用户则需要自己下载对应的预训练模型,并设置model_name字段为预训练模型路径。预训练模型可以在release部分下载。以下是对预训练模型的说明:

news: 在MSRA(新闻语料)上训练的模型。

web: 在微博(网络文本语料)上训练的模型。

medicine: 在医药领域上训练的模型。

tourism: 在旅游领域上训练的模型。

mixed: 混合数据集训练的通用模型。随pip包附带的是此模型。

参考:

del_name字段为预训练模型路径。预训练模型可以在release部分下载。以下是对预训练模型的说明:

news: 在MSRA(新闻语料)上训练的模型。

web: 在微博(网络文本语料)上训练的模型。

medicine: 在医药领域上训练的模型。

tourism: 在旅游领域上训练的模型。

mixed: 混合数据集训练的通用模型。随pip包附带的是此模型。

参考:

- 点赞

- 收藏

- 关注作者

评论(0)