为什么要将样本方差除以 N-1

为什么要将样本方差除以 N-1?

介绍

在本文中,我们将推导出用于计算正态分布数据的平均值和方差的众所周知的公式,以便回答文章标题中的问题。但是,对于那些对这个问题的"为什么"不感兴趣而只对"何时"感兴趣的读者来说,答案很简单:

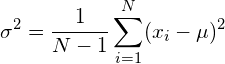

如果必须同时估计数据的均值和方差(通常为这种情况),则除以 N-1,使得方差得到如下:

另一方面,如果已知真实总体的均值使得只需要估计方差,则除以 N,使得方差得到如下:

前者是您通常需要的,而后者的一个例子是对白高斯噪声扩散的估计。由于已知白高斯噪声的平均值为零,因此在这种情况下只需要估计方差。

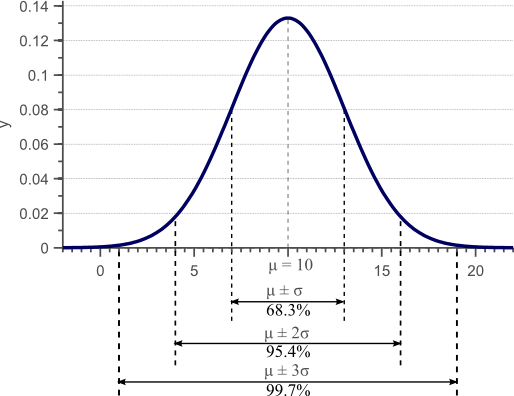

如果数据呈正态分布,我们可以通过其平均值 和方差完全表征它。

和方差完全表征它。  方差是标准差

方差是标准差 的平方,它表示每个数据点与平均值的平均偏差。换句话说,方差表示数据的散布。对于正态分布数据,68.3% 的观测值的值介于 和

的平方,它表示每个数据点与平均值的平均偏差。换句话说,方差表示数据的散布。对于正态分布数据,68.3% 的观测值的值介于 和

之间。下图显示了具有均值

之间。下图显示了具有均值 和方差

和方差 的高斯密度函数:

的高斯密度函数:

**图 1.**高斯密度函数。对于正态分布数据,68% 的样本落在由平均值加上和减去标准差定义的区间内。

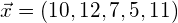

通常,我们无法访问数据的完整总体。在上面的示例中,我们通常可以使用一些观测值,但我们无法访问定义图的 x 轴的所有可能的观测值。例如,我们可能有以下一组观察结果:

| 观察值标识 | 观测值 |

|---|---|

| 观察1 | 10 |

| 观察2 | 12 |

| 观察 3 | 7 |

| 观察4 | 5 |

| 意见5 | 11 |

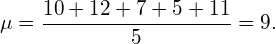

如果我们现在通过总结所有值并除以观测值的数量来计算经验平均值,则我们有:

(1)

通常,我们假设经验平均值接近分布的实际未知平均值,从而假设观测到的数据是从具有均值 的高斯分布中抽样的。在此示例中,分布的实际均值为 10,因此经验均值确实接近实际均值。

的高斯分布中抽样的。在此示例中,分布的实际均值为 10,因此经验均值确实接近实际均值。

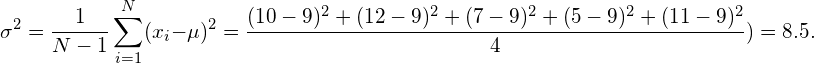

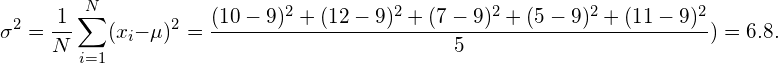

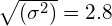

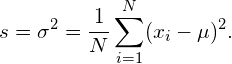

数据的方差计算如下:

(2)

同样,我们通常假设这种经验方差接近基础分布的实际和未知方差。在此示例中,实际方差为 9,因此经验方差确实接近实际方差。

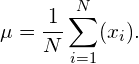

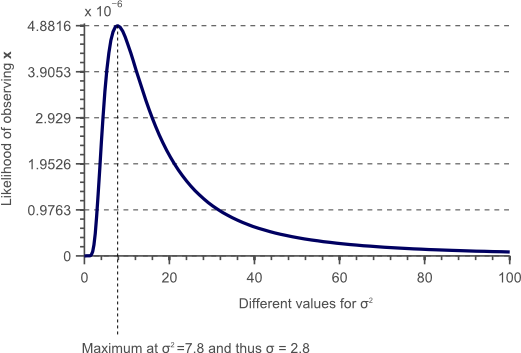

现在的问题是,为什么用于计算经验平均值和经验方差的公式是正确的。实际上,另一个经常用于计算方差的公式定义如下:

(3)

等式(2)和(3)之间的唯一区别是前者除以N-1,而后者除以N。这两个公式实际上都是正确的,但何时使用哪一个取决于情况。

在以下各节中,我们将完全推导出最能近似正态分布的未知方差和均值的公式,给定来自该分布的几个样本。我们将展示在哪些情况下将方差除以 N,在哪些情况下用 N-1 进行归一化。

近似参数(均值或方差)的公式称为估计器。在下文中,我们将用 和

来表示分布的真实和未知参数。估计器(例如经验平均值和经验方差)表示为

来表示分布的真实和未知参数。估计器(例如经验平均值和经验方差)表示为 和

和 。

。

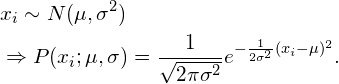

为了找到最优估计器,我们首先需要一个分析表达式来表示观察特定数据点 的可能性,因为总体以给定的均值

的可能性,因为总体以给定的均值 和标准差

和标准差 正态分布。具有已知参数的正态分布通常表示为

正态分布。具有已知参数的正态分布通常表示为 。然后似然函数为:

。然后似然函数为:

(4)

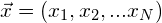

为了计算均值和方差,我们显然需要来自此分布的多个样本。在下文中,设 vector 是包含所有可用样本(例如,表 1 中示例中的所有值)的向量。如果所有这些样本在统计上都是独立的,我们可以将它们的联合似然函数写成所有单个似然的总和:

vector 是包含所有可用样本(例如,表 1 中示例中的所有值)的向量。如果所有这些样本在统计上都是独立的,我们可以将它们的联合似然函数写成所有单个似然的总和:

(5)

将方程(4)插入方程(5),然后得到这个联合概率密度函数的解析表达式:

(6)

方程(6)在后面的章节中将很重要,并将用于推导高斯分布的均值和方差的估计器的已知表达式。

最小方差,无偏估计器

要确定估计器是否是"好"估计器,我们首先需要定义"好"估计器到底是什么。估计器的优劣取决于两个度量,即其偏差和方差(是的,我们将讨论均值估计器的方差和方差估计器的方差)。本节将简要讨论这两种措施。

参数偏差

想象一下,我们可以获得整个种群的不同(不相交)子集。与前面的示例类似,想象一下,除了表 1 中的数据之外,我们还有一个表 2 和一个表 3,它们具有不同的观测值。然后,一个好的均值估计器将是一个平均等于实际均值的估计器。尽管我们可以接受这样一种观点,即来自一个数据子集的经验平均值不等于实际平均值,如我们的示例所示,一个好的估计器应该确保来自所有子集的估计平均值的平均值等于实际平均值。此约束在数学上表示,指出估计器的预期值应等于实际参数值:

(7) ![\begin{align*} &E[\mu] = \hat{\mu}\ &E[\sigma^2] = \hat{\sigma^2} \end{align*}](https://img-blog.csdnimg.cn/img_convert/1f814b0e394e7a618dac471c8b18f1ed.png)

如果上述条件成立,则估计器称为"无偏估计器"。如果条件不成立,则估计器被称为"偏倚",因为平均而言,它们将低估或高估参数的真实值。

参数方差

无偏估计器保证平均而言,它们产生的估计值等于实际参数。但是,这并不意味着每个估计值都是一个好的估计值。例如,如果实际均值为 10,则无偏估计器可以将一个总体子集的均值估计为 50,在另一个子集上估计为 -30。那么估计值的预期值确实会是 10,这等于实际参数,但估计器的质量显然也取决于每个估计值的散布。生成总体的五个不同子集的估计值(10,15,5,12,8)的估计器是无偏的,就像产生估计值(50,-30,100,-90,10)的估计器一样。但是,来自第一个估计器的所有估计值都比来自第二个估计器的估计值更接近真实值。

因此,一个好的估计器不仅具有低偏差,而且还会产生低方差。此方差表示为估计器的均方误差:

![\begin{align*} &Var(\mu) = E[(\hat{\mu} - \mu)^2]\ &Var(\sigma^2) = E[(\hat{\sigma} - \sigma)^2] \end{align*}](https://img-blog.csdnimg.cn/img_convert/ef8364dfbf8abf111fae4d355173327c.png)

因此,一个好的估计器是一个低偏差、低方差估计器。如果存在这样的估计器,则最优估计器是没有偏差且方差低于任何其他可能的估计器的估计器。这样的估计器称为最小方差、无偏 (MVU) 估计器。在下一节中,我们将推导出高斯分布的均值和方差估计器的解析表达式。我们将证明,正态分布方差的 MVU 估计器要求我们在某些假设 下除以方差,如果这些假设不成立,则要求我们除以 N-1。

下除以方差,如果这些假设不成立,则要求我们除以 N-1。

最大似然估计

尽管可以使用许多技术来获得基于总体数据子集的参数估计器,但最简单的可能是最大似然法。

观测的概率 由等式(6)定义为

由等式(6)定义为 。如果我们固定[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-iRTKZUWt-1642131626193)(https://www.visiondummy.com/wp-content/ql-cache/quicklatex.com-b651e573373603e1a528b436ca082146_l3.png)]并

。如果我们固定[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-iRTKZUWt-1642131626193)(https://www.visiondummy.com/wp-content/ql-cache/quicklatex.com-b651e573373603e1a528b436ca082146_l3.png)]并 在这个函数中,在让

在这个函数中,在让 变化的同时,我们得到如图1所示的高斯分布。但是,我们也可以选择固定

变化的同时,我们得到如图1所示的高斯分布。但是,我们也可以选择固定 的,让

的,让 和/或

和/或 变化。例如,我们可以像在前面的

变化。例如,我们可以像在前面的 示例中一样进行选择。我们也选择一个固定

示例中一样进行选择。我们也选择一个固定 的,我们让

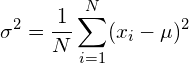

的,我们让 变化。图2显示了每个不同值的图,

变化。图2显示了每个不同值的图, 用于所提出的固定

用于所提出的固定 和

和 分布:

分布:

**图 2.**此图显示了观察固定数据 的可能性,如果数据正态分布与所选的固定

的可能性,如果数据正态分布与所选的固定 值一起绘制,则与变化

值一起绘制,则与变化 的各种值绘制。

的各种值绘制。

在上图中,我们 通过对

通过对 固定

固定 的.结果曲线中的每个点表示观测值

的.结果曲线中的每个点表示观测值 是具有参数

是具有参数 的高斯分布样本的可能性。与最高可能性相对应的参数值很可能是定义数据来源分布的参数。因此,我们可以通过在此似然曲线

的高斯分布样本的可能性。与最高可能性相对应的参数值很可能是定义数据来源分布的参数。因此,我们可以通过在此似然曲线 中找到最大值来确定最优值。在此示例中,最大值为

中找到最大值来确定最优值。在此示例中,最大值为 ,使得标准差为

,使得标准差为 。事实上,如果我们以传统方式计算方差,使用给定

。事实上,如果我们以传统方式计算方差,使用给定 的,我们会发现它等于7.8:

的,我们会发现它等于7.8:

因此,基于样本数据计算方差的公式是通过找到最大似然函数的峰值来简单推导的。此外,我们没有修复 ,而是让两者

,而是让两者 同时

同时 变化。然后,找到两个估计变量对应于在二维似然函数中查找最大值。

变化。然后,找到两个估计变量对应于在二维似然函数中查找最大值。

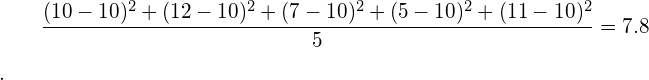

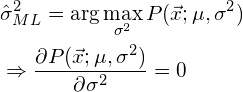

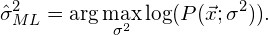

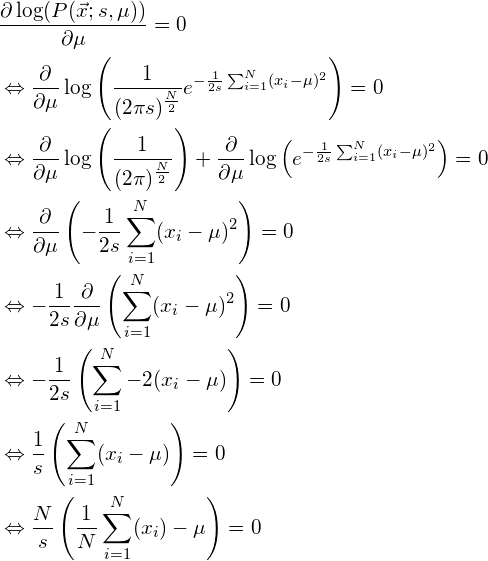

为了找到函数的最大值,我们只需将其导数设置为零。如果我们想找到具有两个变量的函数的最大值,我们计算每个变量的偏导数,并将两者都设置为零。在下文中,设 为使用最大似然法获得的总体均值的最优估计器,并设

为使用最大似然法获得的总体均值的最优估计器,并设 为方差的最优估计器。为了最大化似然函数,我们只需计算其(偏)导数并将其设置为零,如下所示:

为方差的最优估计器。为了最大化似然函数,我们只需计算其(偏)导数并将其设置为零,如下所示:

和

在以下段落中,我们将使用此技术获取 和

的 MVU 估计量。我们考虑两种情况:

的 MVU 估计量。我们考虑两种情况:

第一种情况假定分布 的真实均值是已知的。因此,我们只需要估计方差,然后问题对应于在一维似然函数中找到最大值,参数化为

的真实均值是已知的。因此,我们只需要估计方差,然后问题对应于在一维似然函数中找到最大值,参数化为 。虽然这种情况在实践中并不经常发生,但它肯定有实际应用。例如,如果我们知道一个信号(例如图像中像素的颜色值)应该具有特定的值,但该信号已被白噪声(平均值为零的高斯噪声)污染,那么分布的平均值是已知的,我们只需要估计方差。

。虽然这种情况在实践中并不经常发生,但它肯定有实际应用。例如,如果我们知道一个信号(例如图像中像素的颜色值)应该具有特定的值,但该信号已被白噪声(平均值为零的高斯噪声)污染,那么分布的平均值是已知的,我们只需要估计方差。

第二种情况涉及真实均值和真实方差均未知的情况。这是您最常遇到的情况,您将根据样本数据获得均值和方差的估计值。

在接下来的段落中,我们将展示每个事例导致不同的 MVU 估计器。更具体地说,第一种情况要求方差估计器归一化为 MVU,而第二种情况要求除以

MVU,而第二种情况要求除以 为 MVU。

为 MVU。

如果均值已知,则估计方差

参数估计

如果分布的真实均值已知,则似然函数仅在 上参数 化。然后,获得最大似然估计器对应于求解:

化。然后,获得最大似然估计器对应于求解:

(8)

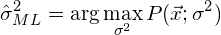

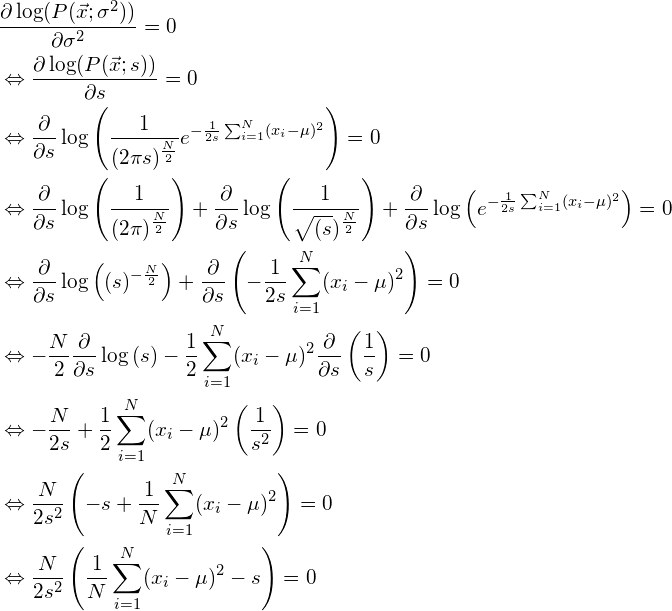

然而,由于函数中的指数 ,计算由方程(6)定义的导数是相当复杂的。事实上,最大化对数似然函数比使似然函数本身容易得多。由于对数是单调函数,因此最大值将是相同的。因此,我们改为解决以下问题:

,计算由方程(6)定义的导数是相当复杂的。事实上,最大化对数似然函数比使似然函数本身容易得多。由于对数是单调函数,因此最大值将是相同的。因此,我们改为解决以下问题:

(9)

在下面,我们设置 以获得更简单的表示法。为了得到对数似然函数的最大值,我们简单地计算方程(6)的对数导数并将其设置为零:

以获得更简单的表示法。为了得到对数似然函数的最大值,我们简单地计算方程(6)的对数导数并将其设置为零:

很明显,如果 ,那么上述问题的唯一可能的解决方案是:

,那么上述问题的唯一可能的解决方案是:

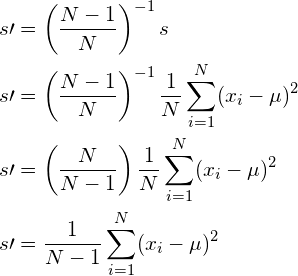

(10)

请注意,这个最大似然估计器 确实是计算正态数据方差的传统公式。归一化因子为

确实是计算正态数据方差的传统公式。归一化因子为 。

。

但是,最大似然法不能保证提供无偏估计器。另一方面,如果获得的估计器是无偏的,则最大似然法确实保证估计器也是最小方差,从而保证MVU。因此,我们需要检查等式(10)中的估计器是否无偏。

绩效评估

为了检查由方程(10)定义的估计器是否无偏,我们需要检查方程(7)的条件是否成立,从而

![\begin{equation*} E[s] = \hat{s}.\end{equation*}](https://img-blog.csdnimg.cn/img_convert/43b1655c793009ec3b715db1df5b6be1.png)

为此,我们将等式(10)插入并![E[s]](https://img-blog.csdnimg.cn/img_convert/a1db0b2f246fe9affe670188c46e64e7.png) 写如下:

写如下:

![\begin{align*} E[s] &= E \left[\frac{1}{N}\sum_{i=1}^N(x_i - \mu)^2 \right] = \frac{1}{N} \sum_{i=1}^N E \left[(x_i - \mu)^2 \right] = \frac{1}{N} \sum_{i=1}^N E \left[x_i^2 - 2x_i \mu + \mu^2 \right]\ &= \frac{1}{N} \left( N E[x_i^2] -2N \mu E[x_i] + N \mu^2 \right) \ &= \frac{1}{N} \left(N E[x_i^2] -2N \mu^2 + N \mu^2 \right) \ &= \frac{1}{N} \left( N E[x_i^2] -N \mu^2 \right) \ \end{align*}](https://img-blog.csdnimg.cn/img_convert/0d8973bd363ecfcf2978412c4469abcd.png)

此外,方差的一个重要属性是,真正的方差 可以写成

可以写成![\hat{s} = E[x_i^2] - E[x_i]^2](https://img-blog.csdnimg.cn/img_convert/1c96c22e91cde54a7dcea1bb202b761b.png) 这样。

这样。 ![E[x_i^2] = \hat{s} + E[x_i]^2 = \hat{s} + \mu^2](https://img-blog.csdnimg.cn/img_convert/cf4c41159bbc4da41cd82610b09df484.png) 在上面的等式中使用此属性可得到:

在上面的等式中使用此属性可得到:

![\begin{align*} E[s] &= \frac{1}{N} \left( N E[x_i^2] -N \mu^2 \right) \ &= \frac{1}{N} \left( N \hat{s} + N \mu^2 -N \mu^2 \right)\ &= \frac{1}{N} \left( N \hat{s} \right)\ &= \hat{s} \end{align*}](https://img-blog.csdnimg.cn/img_convert/3d90969b3e7e3ea19d2d1bc0260de8a6.png)

因为![E[s]=\hat{s}](https://img-blog.csdnimg.cn/img_convert/9c8b3284814bedd8a1b95de77f8cff51.png) ,等式(7)所示的条件成立,因此得到的数据方差

,等式(7)所示的条件成立,因此得到的数据方差 的估计器是无偏的。此外,由于最大似然法保证无偏估计器也是最小方差 (MVU),这意味着不存在其他估计器可以比此处获得的估计器做得更好。

的估计器是无偏的。此外,由于最大似然法保证无偏估计器也是最小方差 (MVU),这意味着不存在其他估计器可以比此处获得的估计器做得更好。

因此,如果基础分布的真实平均值已知 ,我们必须

,我们必须 在计算正态分布数据的方差时除以而不是通过。

在计算正态分布数据的方差时除以而不是通过。

如果均值未知,则估计方差

参数估计

在上一节中,分布的真实平均值是已知的,因此我们只需要找到数据方差的估计器。但是,如果不知道真实均值,则还必须找到均值的估计器。此外,方差估计器使用此均值估计值。因此,我们将证明先前获得的方差估计器不再是无偏的。此外,我们将证明,在这种情况下,我们可以通过除以 而不是由 来"不偏"估计器

而不是由 来"不偏"估计器 ,这会略微增加估计器的方差。

,这会略微增加估计器的方差。

和以前一样,我们使用最大似然法来获得基于对数似然函数的估计器。我们首先找到以下各项的 ML 估计器:

ML 估计器:

如果 为 ,则很明显,上述等式仅在以下情况下才有解:

为 ,则很明显,上述等式仅在以下情况下才有解:

(11)

请注意,这确实是计算分布平均值的众所周知的公式。虽然我们都知道这个公式,但我们现在证明它是正态分布的真值和未知均值 的最大似然估计器。现在,我们只假设我们之前发现的由方程(10)定义的方差

的最大似然估计器。现在,我们只假设我们之前发现的由方程(10)定义的方差 估计器仍然是MVU方差估计器。然而,在下一节中,我们将证明这个估计器现在不再是无偏的。

估计器仍然是MVU方差估计器。然而,在下一节中,我们将证明这个估计器现在不再是无偏的。

绩效评估

为了检查真实均值

的估计器是否无偏,我们必须确保方程(7)的条件成立:

的估计器是否无偏,我们必须确保方程(7)的条件成立:

![\begin{equation*} E[\mu] = E \left[\frac{1}{N} \sum_{i=1}^N (x_i) \right] = \frac{1}{N}\sum_{i=1}^N E[x_i] = \frac{1}{N} N E[x_i] = \frac{1}{N} N \hat{\mu} = \hat{\mu}.\end{equation*}](https://img-blog.csdnimg.cn/img_convert/00a6ab1cab59a0c50d7386c9265f4ad2.png)

因为![E[\mu] = \hat{\mu}](https://img-blog.csdnimg.cn/img_convert/36c61be5d90941c25fcee6443a5799d1.png) ,这意味着所获得的分布均值的估计量是无偏的。由于最大似然法保证在估计器无偏的情况下提供最小方差估计器,因此我们证明了这是

,这意味着所获得的分布均值的估计量是无偏的。由于最大似然法保证在估计器无偏的情况下提供最小方差估计器,因此我们证明了这是 均值的 MVU 估计器。

均值的 MVU 估计器。

为了检查先前发现的方差

为了检查先前发现的方差 估计器是否仍然无偏,如果它基于经验均值而不是真实均值

估计器是否仍然无偏,如果它基于经验均值而不是真实均值

,我们只需将得到的估计器

,我们只需将得到的估计器 插入方程

插入方程 (10)的早期派生估计器中:

(10)的早期派生估计器中:

![\begin{align*} s &= \sigma^2 = \frac{1}{N}\sum_{i=1}^N(x_i - \mu)^2\ &=\frac{1}{N}\sum_{i=1}^N \left(x_i - \frac{1}{N} \sum_{i=1}^N (x_i) \right)^2\ &=\frac{1}{N}\sum_{i=1}^N \left[x_i^2 - 2 x_i \frac{1}{N} \sum_{i=1}^N (x_i) + \left(\frac{1}{N} \sum_{i=1}^N (x_i) \right)^2 \right]\ &=\frac{\sum_{i=1}^N x_i^2}{N} - \frac{2\sum_{i=1}^N x_i \sum_{i=1}^N x_i}{N^2} + \left(\frac{\sum_{i=1}^N x_i}{N} \right)^2\ &=\frac{\sum_{i=1}^N x_i^2}{N} - \frac{2\sum_{i=1}^N x_i \sum_{i=1}^N x_i}{N^2} + \left(\frac{\sum_{i=1}^N x_i}{N} \right)2\&=\frac{\sum_{i=1}N x_i^2}{N} - \left(\frac{\sum_{i=1}^N x_i}{N} \right)^2\ \end{align*}](https://img-blog.csdnimg.cn/img_convert/3cc0d81c4a044540f78e9c8087bc61f3.png)

为了检查估计器是否仍然无偏,我们现在需要再次检查方程(7)的条件是否成立:

![\begin{align*} E[s] &= E \left[ \frac{\sum_{i=1}^N x_i^2}{N} - \left(\frac{\sum_{i=1}^N x_i}{N} \right)^2 \right ] \ & = \frac{\sum_{i=1}^N E[x_i^2]}{N} - \frac{E[(\sum_{i=1}^N x_i)2]}{N2} \ \end{align*}](https://img-blog.csdnimg.cn/img_convert/a9d4bf9a1cacd367dc58d66b10353d03.png)

如上一节所述,方差的一个重要属性是,真正的方差 可以这样写:

可以这样写: ![E[x_i^2] = \hat{s} + E[x_i]^2 = \hat{s} + \mu^2](https://img-blog.csdnimg.cn/img_convert/cf4c41159bbc4da41cd82610b09df484.png)

![\hat{s} = E[x_i^2] - E[x_i]^2](https://img-blog.csdnimg.cn/img_convert/fa988207673900dedb045f6e6768cfad.png) 在上面的等式中使用此属性可得到:

在上面的等式中使用此属性可得到:

![\begin{align*} E[s] &= \frac{\sum_{i=1}^N E[x_i^2]}{N} - \frac{E[(\sum_{i=1}^N x_i)2]}{N2} \ &= s + \mu^2 - \frac{E[(\sum_{i=1}^N x_i)2]}{N2} \ &= s + \mu^2 - \frac{E[\sum_{i=1}^N x_i^2 + \sum_i^N \sum_{j\neq i}^N x_i x_j]}{N^2} \ &= s + \mu^2 - \frac{E[N(s+\mu^2) + \sum_i^N \sum_{j\neq i}^N x_i x_j]}{N^2} \ &= s + \mu^2 - \frac{N(s+\mu^2) + \sum_i^N \sum_{j\neq i}^N E[x_i] E[x_j]}{N^2} \ &= s + \mu^2 - \frac{N(s+\mu^2) + N(N-1)\mu2}{N2} \ &= s + \mu^2 - \frac{N(s+\mu^2) + N2\mu2 -N\mu2}{N2} \&= s + \mu^2 - \frac{s+\mu^2 + N\mu^2 -\mu^2}{N} \ &= s + \mu^2 - \frac{s}{N} - \frac{\mu^2}{N} - \mu^2 + \frac{\mu^2}{N}\ &= s - \frac{s}{N}\ &= s \left( 1 - \frac{1}{N} \right)\ &= s \left(\frac{N-1}{N} \right) \end{align*}](https://img-blog.csdnimg.cn/img_convert/b89d4799fe35871804d7b4c99f73e2f0.png)

因为很明显![E[s] \neq \hat{s}](https://img-blog.csdnimg.cn/img_convert/7b82330bc690c0deaeada6cf91b7c910.png) ,这表明分布方差的估计器不再是无偏的。实际上,这个估计器平均低估了与因子

,这表明分布方差的估计器不再是无偏的。实际上,这个估计器平均低估了与因子 的真实方差。当样本数接近无穷大(

的真实方差。当样本数接近无穷大( )时,此偏差收敛于零。然而,对于小样本集,偏倚是有意义的,应该消除。

)时,此偏差收敛于零。然而,对于小样本集,偏倚是有意义的,应该消除。

修正偏差

由于偏差只是一个因素,我们可以通过缩放由方程(10)定义的偏倚估计 器来消除它。因此,我们定义一个新的、无偏见的估计

器来消除它。因此,我们定义一个新的、无偏见的估计 值如下:

值如下:

这个估计器现在是无偏的,并且确实类似于计算方差的传统公式,其中我们除以 而不是。

而不是。  但是,请注意,生成的估计器不再是最小方差估计器,而是所有无偏估计器中具有最小方差的估计器。如果我们除以

但是,请注意,生成的估计器不再是最小方差估计器,而是所有无偏估计器中具有最小方差的估计器。如果我们除以 ,则估计器是偏倚的,如果我们除以

,则估计器是偏倚的,如果我们除以 ,则估计器不是最小方差估计器。但是,一般来说,具有偏倚估计器比具有略高的方差估计器要差得多。因此,如果总体的均值未知,则应使用除

,则估计器不是最小方差估计器。但是,一般来说,具有偏倚估计器比具有略高的方差估计器要差得多。因此,如果总体的均值未知,则应使用除 以而不是除

以而不是除 以 。

以 。

结论

在本文中,我们展示了用于计算正态分布数据的均值和方差的常用公式的来源。此外,我们已经证明,方差估计器公式中的归一化因子应该是 总体的真实均值是否已知,并且应该是平均值本身也必须估计

总体的真实均值是否已知,并且应该是平均值本身也必须估计 的情况。

的情况。

总结

文章名称

为什么要将样本方差除以 N-1?

描述

在本文中,我们解释了为什么以及在计算正态分布数据的样本方差时除以 N 或 N-1。我们推导公式来计算最大似然参数估计值的均值和方差。

文章来源: blog.csdn.net,作者:irrationality,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/weixin_54227557/article/details/122490771

- 点赞

- 收藏

- 关注作者

评论(0)