机器学习西瓜书笔记——绪论

机器学习西瓜书笔记——绪论

1.1引言

什么是机器学习?

人是通过经验学习; 而机器学习的主要内容是在计算机上从数据中产生“模型”(model) 的算法,模型的作用是更好的预测、判断未发生的样例。

1.2基本术语

主要基本概念

- 数据集(data set) : 整个所有数据样本; 所有西瓜提供的数据

- 样本(sample) : 所有西瓜是数据集,一个西瓜就是样本

- 属性(attribute): 西瓜对应的特征,比如颜色,而对应的值就是属性值

- 样本空间(sample space)/属性空间(attribute space) : 属性张成的空间

- 特征向量(feature vector): 每个西瓜可以对应多种属性特征,可以看成一个多维的向量,一个样本对应一个特征向量。

- 训练集(training set): 用于训练模型时的数据集

- 训练样本(training sample): 用于训练模型时的样本

- 标记(label) :如果说属性对应的判断的特征依据,那么标记就是判断的结果,比如“好瓜"

- 样例(example): 样本 + 标记 = 样例

- 泛化(generalization): 有训练集学习得到的模型适用于新样本的能力

分类与回归

- 如果预测的值是离散的则称为分类,比如预测西瓜是”好瓜“还是”坏瓜“; 特殊的如果预测的只有两类则称为”二分类“,即”正类“和”反类“;y往往取{-1, 1}或者{0,1};

- 如果预测的值是连续的则称为回归,比如预测西瓜的成熟度;y往往取R

有监督与无监督学习

根据训练数据是否具有标记信息,学习任务分为监督学习和无监督学习

- 监督学习是有标记;例如分类和回归;

- 无监督学习是没有标记;例如聚类;聚类是将训练集分为若干个组(簇),这些组的概念是事先不知道的,学习过程中使用的训练样本是通常不具有标记信息的。

1.3假设空间

由于训练集始终是有限的,所以通过训练学习,往往通过所有训练样本的假设不止一个,这些满足训练集的假设组成样本空间;

1.4归纳偏好

归纳偏好的产生是为了解决从假设空间中随机选出假设对新样本进行预测的问题。归纳偏好可以看做是学习算法自身在一个可能有很庞大的假设空间中对假设进行选择的启发式或”价值观“。

2.模型评估

2.1模型评估与过拟合

训练误差(training error):

学习器在实际的预测输出与样本真实输出之间的差异称为误差(error), 学习器在训练集上的误差即为训练误差,也称为经验误差(empirical error). 学习器在新样本上的误差称为泛化误差。

过拟合与欠拟合:

- 学习器训练的目的是得到样本的“普遍规律”,拥有更好的泛化能力,然后当训练过头的时候,很可能把训练样本自身的一些特点当作了所有潜在样本的普遍规律导致在新样本中的泛化能力下降,则称为过拟合;相反如果训练不足,则称为欠拟合。

- 过拟合的通常表现是:loss(训练) 小, loss(测试)大; 欠拟合的表现是两者都偏小。

- 欠拟合比较容易克服,例如在决策树学习中扩展分支;过拟合无法彻底避免,是NP难问题,只能缓解。

2.2评估方法

testing data测试集划分保留方法

1.留出法

- 留出法是在保证训练集测试集互斥的原则下对数据集进行比例划分,一般将2/3 ~ 4/5用于训练

- “分层采样”,保持划分时的类别比例,目的是为了不打乱原有的数据分布,减小估计偏差。

2.交叉验证法

- 先将数据集划分为k个互斥的相似的数据子集,选其中k-1个用于数据训练,剩下的一组用于测试,所以可以划分k组训练/测试集,所有可以进行k次训练测试得到k个结果,求平均作为最终结果。

- 如果k=m, 则是“留一法”,有点是训练往往更好,缺点是当样本数据大时计算量太大。

3.自助法

- 对于m个样本的数据集,采取放回重抽的方式抽取m次样本,把抽到的所有样本作为训练集,余下的作为测试集(约占0.368)

- 对于数据集小、难以有效划分训练/测试集时有用;数据集充足时一般采用前两种方法;

- 缺点是自助法产生的数据集改变了原始的数据集的分布,引起估计偏差。

调参与最终模型

大多数算法都有参数需要设定,不同的参数得到的模型和效果也不一样,所以需要”调整参数“。 从训练集中划分出验证集(validation set),基于验证集上的性能来进行模型的选择和调参。

2.3性能度量

2.3.1第一类:一种算法一个数据集

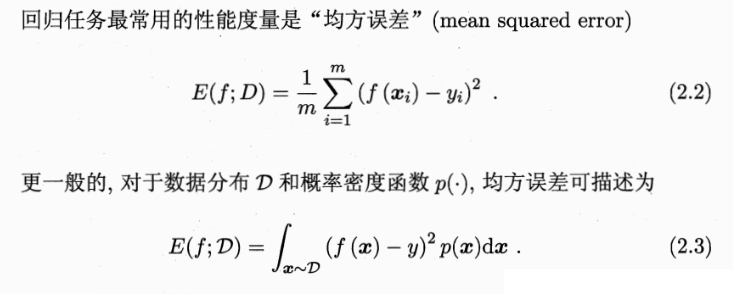

1.均方误差(mean squared error): 适用于回归任务的性能度量

2.精度(accuracy)与误差(error) :

适用于二分类和多分类任务;

误差率 = 预测值与实际值不同的样本数 / 样本总数;

精度 = 1 - 误差率

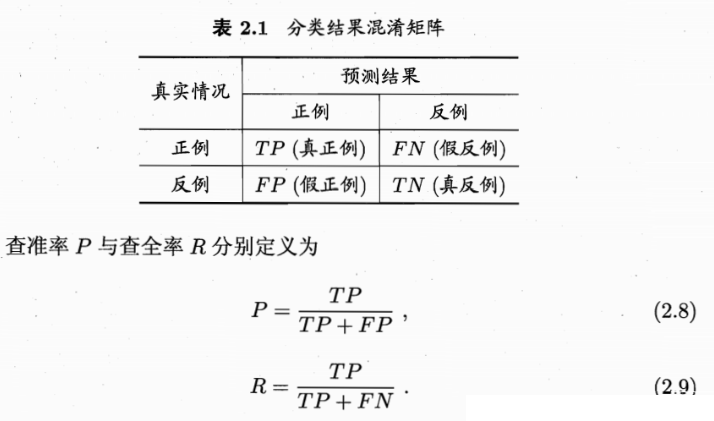

3.查准率(precision)与查全率(recall)和F1: 适用于二分类问题

2.3.2第二类:多种算法一个数据集

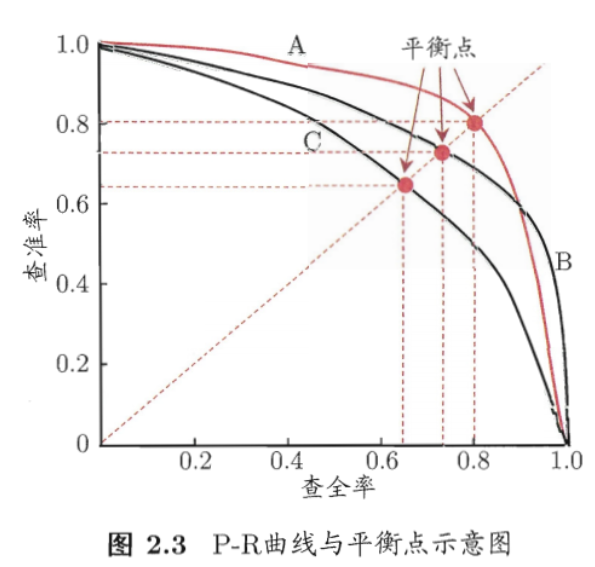

P-R图:

P-R图的横轴是查全率R, 纵轴是差准率。

如果确定上图中A,B,C三种算法在同一数据集的性能优劣?

- 首先B,C进行比较,C的曲线完全被B包住,则此时B的性能一定是比B要好的。

- 然后如何比较有交叉的A和B:可以通过比较积分面积、平均F1、平均Fbeta以及EBP来大致 确定。

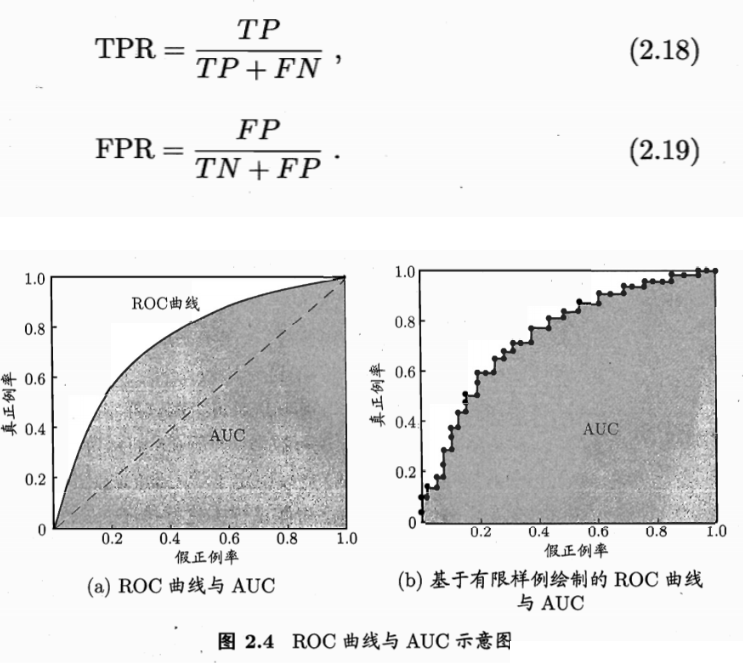

ROC图:

ROC曲线的横轴是假正例率(FPR), 纵轴是真正例率(TPR);

由于样例个数是有限的,实际中绘制上图b中的ROC曲线

与P-R曲线相似,可以通过: 1.是否被包住 2.积分面积 来比较性能

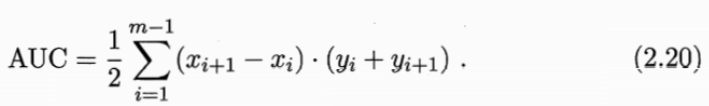

AUC

可以通过对ROC曲线做积分面积得到

排序损失loss

两者的关系:AUC = 1 \- Lrank

2.3.3第三类:多种训练集一种算法

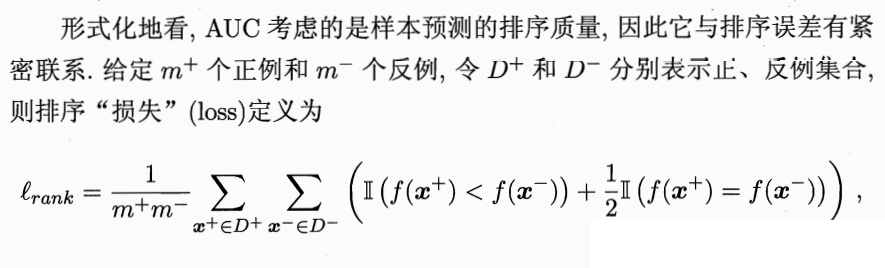

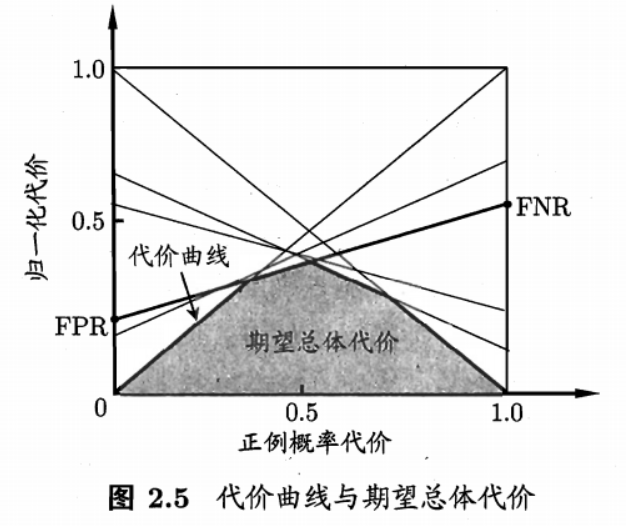

代价敏感错误率与代价曲线:预测值与实际值不同出现误差,但是不同的预测错误造成的影响是不同的,由此引入代价以及代价矩阵;在非均等的代价下,ROC曲线不能直接反映出学习器的期望总体代价,而代价曲线可以;

代价敏感(cost-sensitive)错误

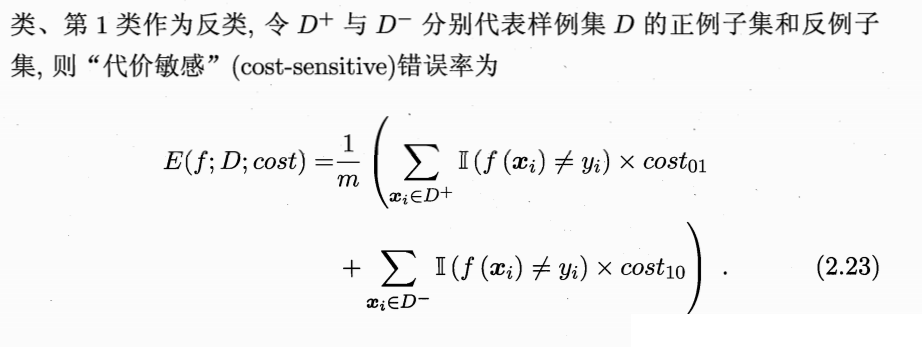

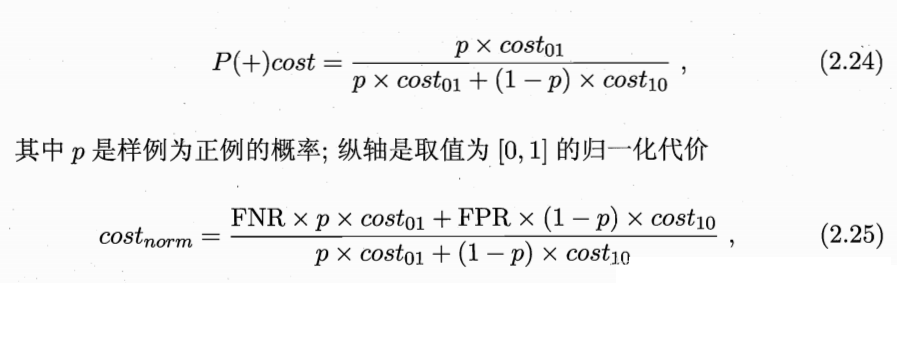

代价曲线:

横轴是正例概率代价,纵轴是归一化代价

代价曲线的绘制:

文章来源: blog.csdn.net,作者:irrationality,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/weixin_54227557/article/details/122508302

- 点赞

- 收藏

- 关注作者

评论(0)