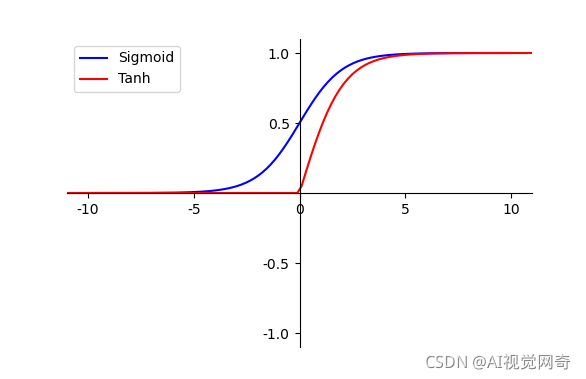

tanh relu可视化

【摘要】

直接截断的话,分割网络不收敛

说明tanh之后不能加relu函数

激活函数需要放在relu之后。

# !/usr/bin/python #encoding:utf-8import mathimport matplotlib.pyplot as pltimport numpy as npimport matplo...

直接截断的话,分割网络不收敛

说明tanh之后不能加relu函数

激活函数需要放在relu之后。

-

# !/usr/bin/python #encoding:utf-8

-

import math

-

import matplotlib.pyplot as plt

-

import numpy as np

-

import matplotlib as mpl

-

import torch

-

-

mpl.rcParams['axes.unicode_minus'] = False

-

-

def sigmoid(x):

-

return 1.0 / (1.0 + np.exp(-x))

-

-

fig = plt.figure(figsize=(6, 4))

-

ax = fig.add_subplot(111)

-

-

x = np.linspace(-10, 10,num=200)

-

y = sigmoid(x)

-

# tanh = 2 * sigmoid(2 * x) - 1

-

-

tanh= (math.e**(x)-math.e**(-x))/(math.e**(x)+math.e**(-x))

-

-

-

for i in range(len(tanh)):

-

tanh[i]=0 if tanh[i]<0 else tanh[i]

-

# tanh[i]=max(tanh[i], alpha * tanh[i]

文章来源: blog.csdn.net,作者:AI视觉网奇,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/jacke121/article/details/120796997

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)