用了的都说好 | 详解16个Pandas函数,让你的 “数据清洗” 能力提高100倍!

持续分享Excel、MySQL、Python领域干货。戳公众号链接戳【数据分析与统计学之美】,关注这个有一点点东西的公众号。还可获取四个原创文档《Python自动化办公手册》、《Excel数据透视表大全手册》、《Python基础查询手册》、《Mysql基础查询手册》

昨天为大家发布了一篇文章,深受大家的喜欢。

总结了这67个pandas函数,完美解决数据处理,拿来即用!

趁热打铁,黄同学今天再次为大家 “详解16Pandas函数”,真滴超级好用!

本文介绍

你有没有这样一种感觉,为什么到自己手上的数据,总是乱七八糟?

作为一个数据分析师来说,数据清洗是必不可少的环节。有时候由于数据太乱,往往需要花费我们很多时间去处理它。因此掌握更多的数据清洗方法,会让你的能力调高100倍。

本文基于此,讲述Pandas中超级好用的str矢量化字符串函数,学了之后,瞬间感觉自己的数据清洗能力提高了。

1个数据集,16个Pandas函数

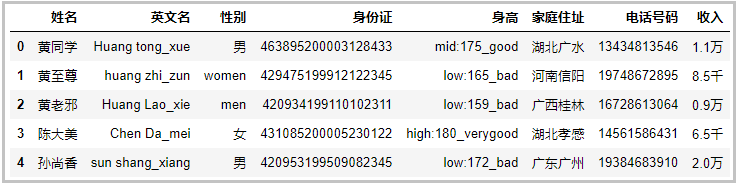

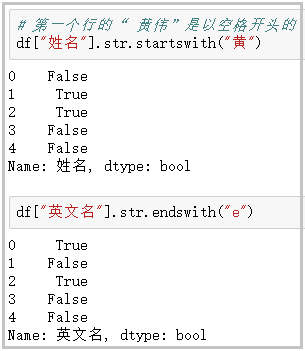

数据集是黄同学精心为大家编造,只为了帮助大家学习到知识。数据集如下:

import pandas as pd

df ={'姓名':[' 黄同学','黄至尊','黄老邪 ','陈大美','孙尚香'], '英文名':['Huang tong_xue','huang zhi_zun','Huang Lao_xie','Chen Da_mei','sun shang_xiang'], '性别':['男','women','men','女','男'], '身份证':['463895200003128433','429475199912122345','420934199110102311','431085200005230122','420953199509082345'], '身高':['mid:175_good','low:165_bad','low:159_bad','high:180_verygood','low:172_bad'], '家庭住址':['湖北广水','河南信阳','广西桂林','湖北孝感','广东广州'], '电话号码':['13434813546','19748672895','16728613064','14561586431','19384683910'], '收入':['1.1万','8.5千','0.9万','6.5千','2.0万']}

df = pd.DataFrame(df)

df

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

结果如下:

观察上述数据,数据集是乱的。接下来,我们就用16个Pandas来对上述数据,进行数据清洗。

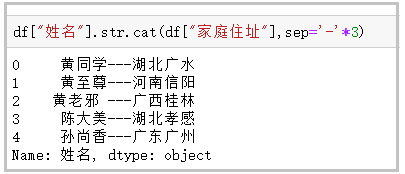

① cat函数:用于字符串的拼接

df["姓名"].str.cat(df["家庭住址"],sep='-'*3)

- 1

结果如下:

② contains:判断某个字符串是否包含给定字符

df["家庭住址"].str.contains("广")

- 1

结果如下:

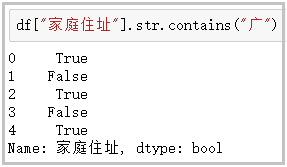

③ startswith/endswith:判断某个字符串是否以…开头/结尾

# 第一个行的“ 黄伟”是以空格开头的

df["姓名"].str.startswith("黄")

df["英文名"].str.endswith("e")

- 1

- 2

- 3

结果如下:

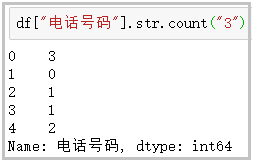

④ count:计算给定字符在字符串中出现的次数

df["电话号码"].str.count("3")

- 1

结果如下:

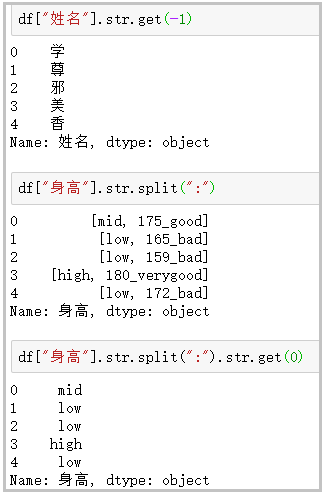

⑤ get:获取指定位置的字符串

df["姓名"].str.get(-1)

df["身高"].str.split(":")

df["身高"].str.split(":").str.get(0)

- 1

- 2

- 3

结果如下:

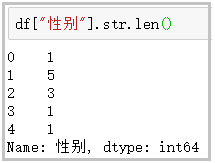

⑥ len:计算字符串长度

df["性别"].str.len()

- 1

结果如下:

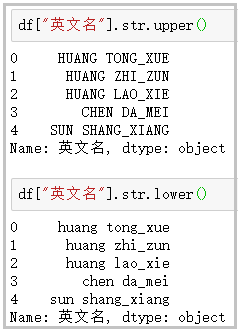

⑦ upper/lower:英文大小写转换

df["英文名"].str.upper()

df["英文名"].str.lower()

- 1

- 2

结果如下:

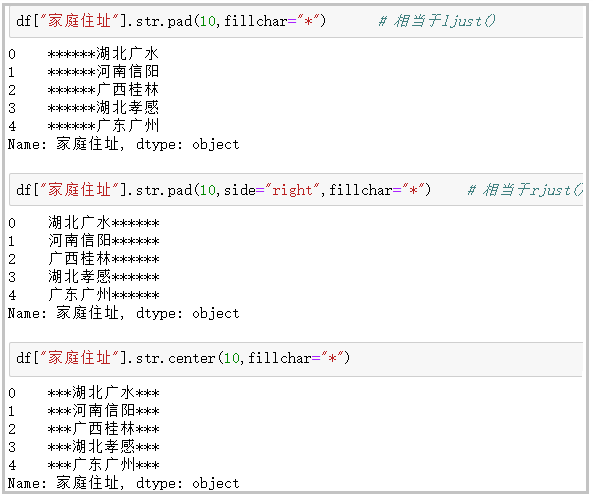

⑧ pad+side参数/center:在字符串的左边、右边或左右两边添加给定字符

df["家庭住址"].str.pad(10,fillchar="*") # 相当于ljust()

df["家庭住址"].str.pad(10,side="right",fillchar="*") # 相当于rjust()

df["家庭住址"].str.center(10,fillchar="*")

- 1

- 2

- 3

结果如下:

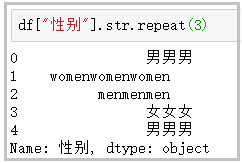

⑨ repeat:重复字符串几次

df["性别"].str.repeat(3)

- 1

结果如下:

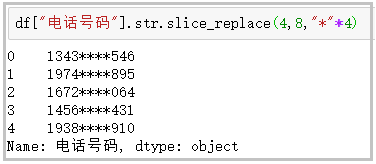

⑩ slice_replace:使用给定的字符串,替换指定的位置的字符

df["电话号码"].str.slice_replace(4,8,"*"*4)

- 1

结果如下:

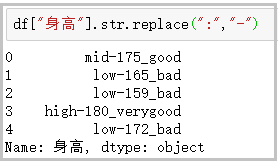

⑪ replace:将指定位置的字符,替换为给定的字符串

df["身高"].str.replace(":","-")

- 1

结果如下:

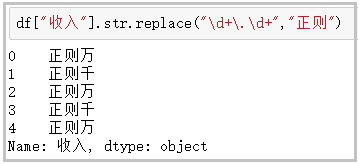

⑫ replace:将指定位置的字符,替换为给定的字符串(接受正则表达式)

- replace中传入正则表达式,才叫好用;

- 先不要管下面这个案例有没有用,你只需要知道,使用正则做数据清洗多好用;

df["收入"].str.replace("\d+\.\d+","正则")

- 1

结果如下:

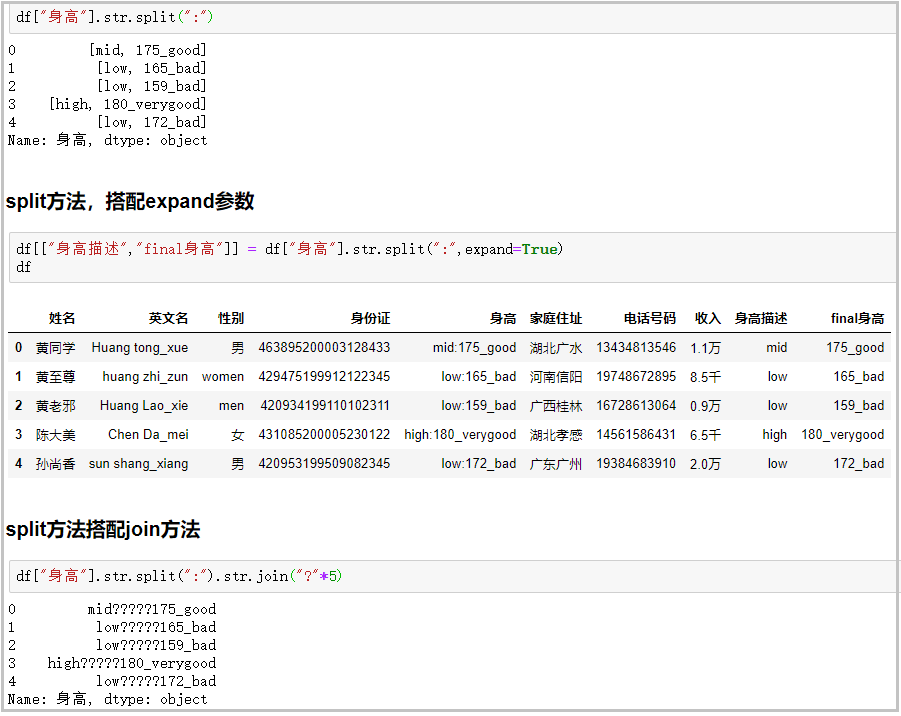

⑬ split方法+expand参数:搭配join方法功能很强大

# 普通用法

df["身高"].str.split(":")

# split方法,搭配expand参数

df[["身高描述","final身高"]] = df["身高"].str.split(":",expand=True)

df

# split方法搭配join方法

df["身高"].str.split(":").str.join("?"*5)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

结果如下:

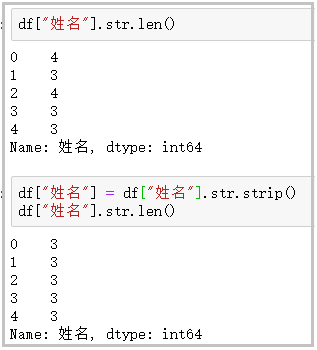

⑭ strip/rstrip/lstrip:去除空白符、换行符

df["姓名"].str.len()

df["姓名"] = df["姓名"].str.strip()

df["姓名"].str.len()

- 1

- 2

- 3

结果如下:

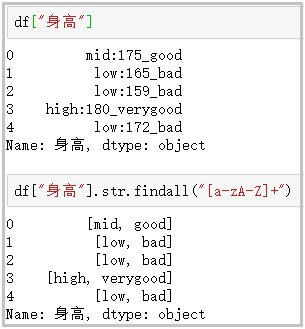

⑮ findall:利用正则表达式,去字符串中匹配,返回查找结果的列表

- findall使用正则表达式,做数据清洗,真的很香!

df["身高"]

df["身高"].str.findall("[a-zA-Z]+")

- 1

- 2

结果如下:

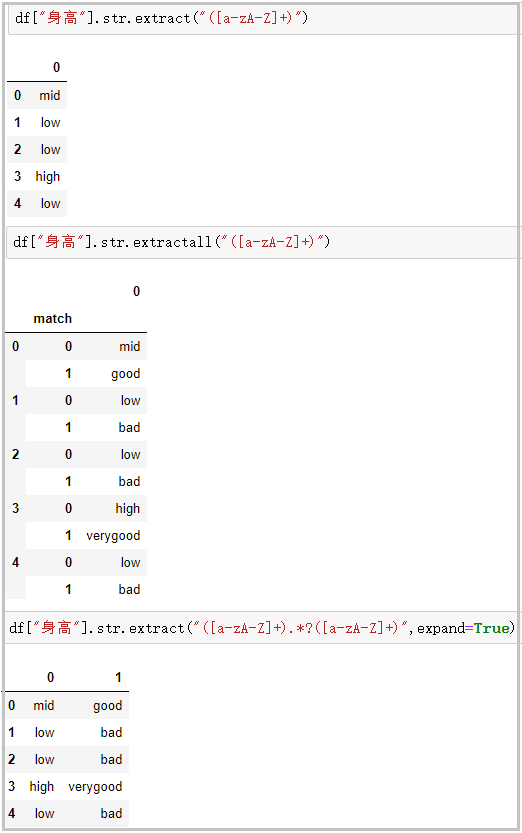

⑯ extract/extractall:接受正则表达式,抽取匹配的字符串(一定要加上括号)

df["身高"].str.extract("([a-zA-Z]+)")

# extractall提取得到复合索引

df["身高"].str.extractall("([a-zA-Z]+)")

# extract搭配expand参数

df["身高"].str.extract("([a-zA-Z]+).*?([a-zA-Z]+)",expand=True)

- 1

- 2

- 3

- 4

- 5

结果如下:

今天的文章,黄同学就为你讲述到这里,希望能够对你有所帮助。

文章来源: blog.csdn.net,作者:数据分析与统计学之美,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/weixin_41261833/article/details/114761062

- 点赞

- 收藏

- 关注作者

评论(0)