经典/最新计算机视觉论文及代码推荐

今日推荐几篇最新/经典计算机视觉方向的论文,涉及诸多方面,都是CVPR2022录用的文章,具体内容详见论文原文和代码链接。

新主干!MPViT:用于密集预测的多路径视觉Transformer

- 论文题目:MPViT : Multi-Path Vision Transformer for Dense Prediction

- 论文链接:https://arxiv.org/abs/2112.11010

- 代码链接:https://github.com/youngwanLEE/MPViT

-

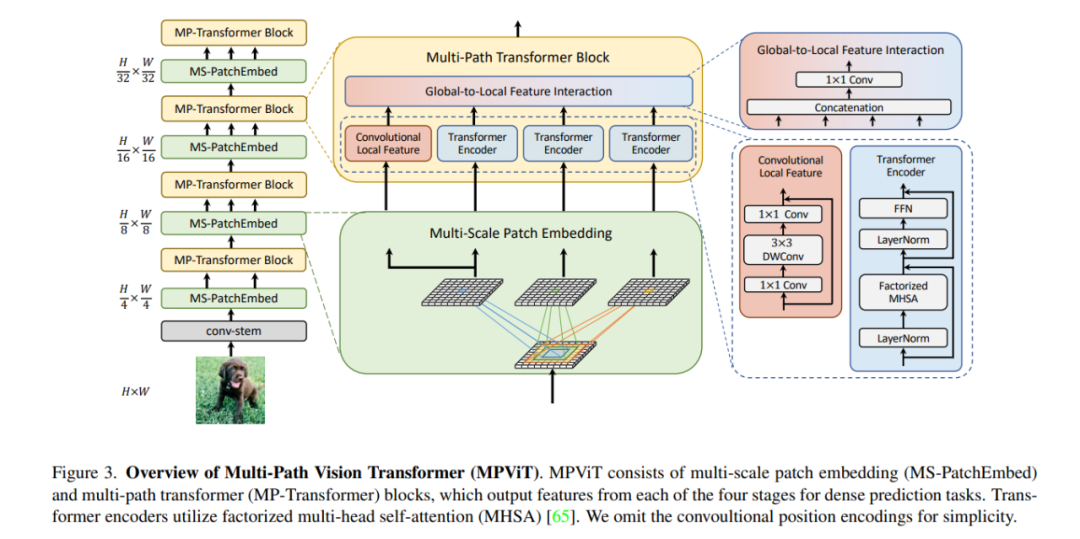

在这项工作中,作者以不同于现有Transformer的视角,探索多尺度path embedding与multi-path结构,提出了Multi-path Vision Transformer(MPViT)。

-

通过使用 overlapping convolutional patch embedding,MPViT同时嵌入相同大小的patch特征。然后,将不同尺度的Token通过多条路径独立地输入Transformer encoders,并对生成的特征进行聚合,从而在同一特征级别上实现精细和粗糙的特征表示。

-

在特征聚合步骤中,引入了一个global-to-local feature interaction(GLI)过程,该过程将卷积局部特征与Transformer的全局特征连接起来,同时利用了卷积的局部连通性和Transformer的全局上下文

Mobile-Former来了!微软提出:MobileNet+Transformer轻量化并行网络

-

论文题目:Mobile-Former: Bridging MobileNet and Transformer

-

论文链接:https://arxiv.org/abs/2108.05895

-

代码链接:https://github.com/ACheun9/Pytorch-implementation-of-Mobile-Former

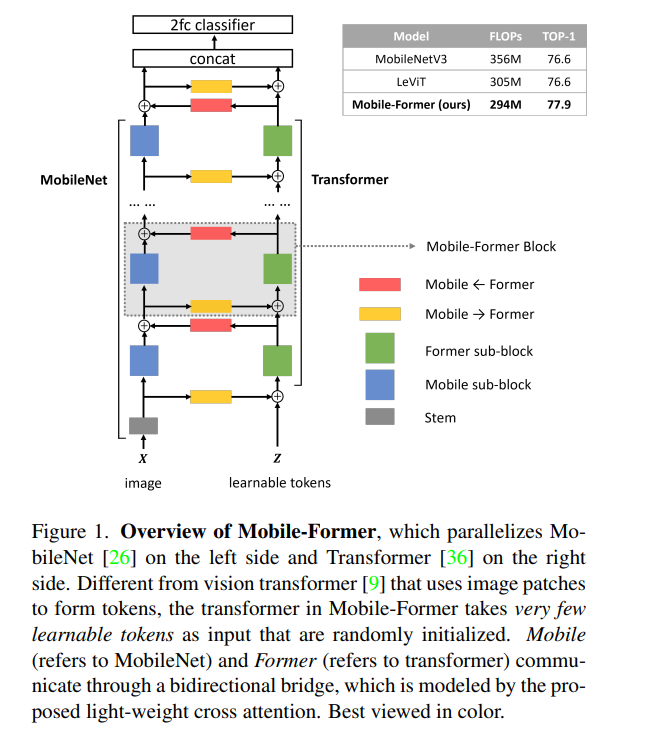

在本文中,作者将设计范式从串联向并联转变,提出了一种新的MobileNet和Transformer并行化,并在两者之间建立双向桥接(见图)。将其命名为Mobile-Former,其中Mobile指MobileNet, Former指transformer。Mobile以图像为输入堆叠mobile block(或inverted bottleneck)。它利用高效的depthwise和pointwise卷积来提取像素级的局部特征。前者以一些可学习的token作为输入,叠加multi-head attention和前馈网络(FFN)。这些token用于对图像的全局特征进行编码。

Mobile-Former是MobileNet和Transformer的并行设计,中间有一个双向桥接。这种结构利用了MobileNet在局部处理和Transformer在全局交互方面的优势。并且该桥接可以实现局部和全局特征的双向融合。与最近在视觉Transformer上的工作不同,Mobile-Former中的Transformer包含非常少的随机初始化的token(例如少于6个token),从而导致计算成本低。

MetaFormer

-

论文题目:MetaFormer Is Actually What You Need for Vision

-

论文链接:https://arxiv.org/abs/2111.11418

-

代码链接:https://github.com/sail-sg/poolformer

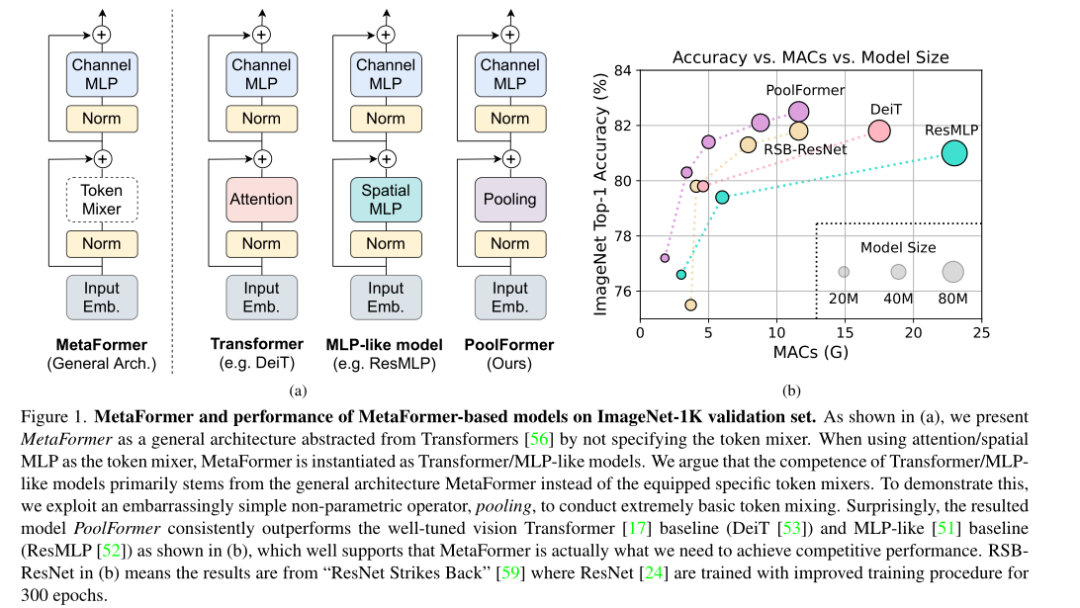

Transformer在计算机视觉任务中显示出巨大的潜力。人们普遍认为,基于注意力的token mixer module对它们的能力贡献最大。然而,最近的研究表明,Transformer中基于注意力的模块可以被空间MLPs替代,并且生成的模型仍然表现良好。基于这一观察,我们假设Transformer的一般架构,而不是特定的token mixer模块对模型的性能更为重要。为了验证这一点,我们特意将Transformers中的注意力模块替换为简单空间池化操作符,来实现基本的token mixing 。令人惊讶的是,我们观察到被称为PoolFormer的衍生模型,在多个计算机视觉任务上实现有竞争力的性能。

后续

下一期最新/经典视觉cvpr顶会论文敬请期待!

文章来源: blog.csdn.net,作者:小小谢先生,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/xiewenrui1996/article/details/126533951

- 点赞

- 收藏

- 关注作者

评论(0)