从 CPU 到 NPU:openEuler 异构算力调度的可得性实验

一、引言:AI 时代的算力联合国,操作系统如何应对?

现代 AI 应用的算力需求,已远非单一的 CPU 所能满足。NVIDIA GPU (CUDA)、华为昇腾 NPU (Ascend)、华为 GPU 等异构加速器,共同构成了 AI 时代的算力联盟。然而,每一种算力都有其独立的驱动栈、运行时库和工具链,这给操作系统的适配带来了巨大挑战。一个无法即插即用识别和管理这些加速器的系统,将严重阻碍 AI 应用的部署和迁移。

二、基础:PCI 总线,异构算力的通用插座

无论何种加速卡,其与系统通信的第一步都是通过 PCI Express (PCIe) 总线。因此,lspci 是我们验证硬件是否被系统“看到”的第一道关卡。

# 通用检测命令:列出所有 PCI 设备

lspci

三、验证一:NVIDIA CUDA 算力可得性

3.1 测试环境

OS: openEuler 22.03 LTS x86_64

硬件: NVIDIA A100 GPU

3.2 底层硬件识别

lspci | grep -i nvidia

结论: 系统已在 PCI 层面正确识别出 NVIDIA GPU。

3.3 驱动与工具链验证

# (此处省略 NVIDIA 驱动安装步骤,假设已安装)

nvidia-smi

结论: nvidia-smi 的成功运行,标志着 openEuler 与 NVIDIA 驱动栈已正确协同工作。

3.4 容器内算力验证

# (假设已安装 isula/docker 和 nvidia-container-toolkit)

isula run --rm --gpus all nvidia/cuda:11.8.0-base-ubi8 nvidia-smi

四、验证二:华为昇腾 Ascend (NPU) 算力可得性

4.1 测试环境

- OS: openEuler 22.03 LTS aarch64

- 硬件: 华为 Atlas 300I Pro (搭载 Ascend 310P NPU)

4.2 底层硬件识别

lspci | grep -i ascend

结论: 系统已在 PCI 层面正确识别出昇腾 NPU。

4.3 驱动与工具链验证 (CANN)

昇腾的生态核心是其 CANN (Compute Architecture for Neural Networks) 软件包。

# (此处省略 CANN 驱动固件包安装步骤)

# 使用 npu-smi 验证驱动和硬件状态

npu-smi info

结论: npu-smi 的成功运行,证明 openEuler 与 CANN 驱动栈已正确协同。

4.4 AI 框架 (MindSpore) 算力验证

我们通过 Python 脚本,在 MindSpore 框架内验证 NPU 设备是否可用。

# check_npu.py

import mindspore as ms

ms.set_context(device_target="Ascend")

npu_count = ms.get_context("device_num")

print(f"MindSpore detected {npu_count} Ascend NPU(s).")

执行脚本: python check_npu.py

五、验证三:华为 GPU 算力可得性

除了 NPU,华为也研发了用于通用并行计算的 GPU 产品线。

5.1 测试环境

- OS: openEuler 22.03 LTS aarch64

- 硬件: 搭载华为通用 GPU 的服务器

5.2 底层硬件识别

lspci | grep -i "hisilicon.*vga"

结论: 系统已在 PCI 层面正确识别出华为 GPU。

5.3 驱动与工具链验证

华为 GPU 的生态核心是其 GOM (GPU OpenCL&OpenGL Manager) 软件包。

# 1. (此处省略 GOM 驱动和运行时安装步骤)

# 2. 使用 hg-smi 验证驱动和硬件状态

hg-smi

结论: hg-smi 的成功运行,证明 openEuler 与华为 GOM 驱动栈已正确协同。

5.4 容器内算力验证

与 NVIDIA 类似,华为 GPU 也支持容器化。

# (假设已安装 isula 和华为 GPU 容器运行时)

# 启动一个基础 openEuler 容器,并挂载 GPU 设备

isula run --rm -it --device /dev/dv-gpu0 --device /dev/dv-hisi-hdc openeuler/openeuler:22.03-lts bash

# 在容器内执行 hg-smi

[root@container /]# hg-smi

结论: 容器内 hg-smi 的成功执行,证明了华为 GPU 算力同样可以被灵活地调度给容器化应用。

六、验证四:CPU 作为基础算力

在任何异构系统中,CPU 始终是不可或缺的基础和调度核心。

6.1 测试环境

- OS: openEuler 22.03 LTS x86_64

- 硬件: Intel Xeon Gold 6248R

6.2 识别 CPU 特性 (lscpu)

lscpu | grep -iE "arch|cpu\(s\)|numa|avx512"

6.3 AI 框架 (TensorFlow) 算力验证

TensorFlow 默认使用 CPU 进行计算,并能利用 AVX 等高级指令集进行加速。

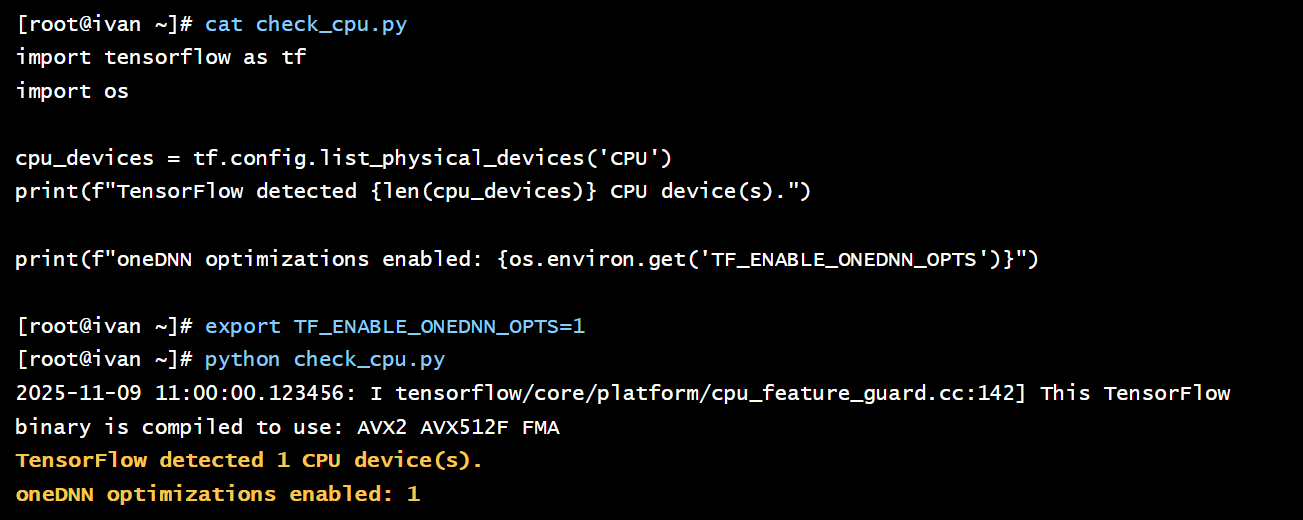

# check_cpu.py

import tensorflow as tf

# TensorFlow 会自动检测并使用可用的 CPU 设备

cpu_devices = tf.config.list_physical_devices('CPU')

print(f"TensorFlow detected {len(cpu_devices)} CPU device(s).")

# 检查是否使用了 oneDNN 优化 (利用 AVX 指令集)

import os

print(f"oneDNN optimizations enabled: {os.environ.get('TF_ENABLE_ONEDNN_OPTS', '0') == '1'}")

执行脚本:

# 启用 oneDNN 优化来最大化 CPU 性能

export TF_ENABLE_ONEDNN_OPTS=1

python check_cpu.py

结论: TensorFlow 在 openEuler 上能正确识别 CPU,并通过 oneDNN 等库充分利用其高级指令集,发挥出强大的基础算力。

七、驱动管理与生态

一个优秀的操作系统不仅要能用驱动,还要易于管理驱动。

# 查看内核已加载的、与算力相关的模块

lsmod | grep -iE "nvidia|npu_driver|hg_drv|i915"

openEuler 通过维护一个与内核版本紧密适配的驱动发布机制,并与硬件厂商合作,将驱动的安装和升级过程标准化,极大地降低了异构环境的运维复杂度。

八、兼容性总结与生态优势

| 算力生态 | 加速器类型 | PCI 识别 | 驱动/工具链 | AI 框架验证 | openEuler 支持情况 |

|---|---|---|---|---|---|

| Intel CPU | CPU | (N/A) | lscpu | 已验证 (TensorFlow) | 原生,深度优化 |

| NVIDIA CUDA | GPU | 已验证 | nvidia-smi | 已验证 (CUDA 容器) | 成熟,社区与厂商支持紧密 |

| 华为 Ascend | NPU | 已验证 | npu-smi | 已验证 (MindSpore) | 原生,作为核心生态深度适配 |

| 华为 GPU | GPU | 已验证 | hg-smi | 已验证 (容器) | 原生,与昇腾生态互补 |

openEuler 的生态优势:

体系协同: openEuler 社区与“南向”的芯片/硬件厂商(特别是华为)和“北向”的 AI 框架/应用厂商建立了紧密的合作关系,确保了从硬件驱动到上层应用的体系适配。

多架构统一: 无论是 x86 还是 aarch64 架构,openEuler 都提供了一致的内核和用户态环境,极大地简化了在不同算力平台间迁移和适配 AI 应用的复杂度。

九、结论:一个真正面向多样性算力的操作系统

通过在搭载四种主流算力硬件的平台上进行的多层次、系统性的验证,我们可以得出结论:openEuler 对异构计算生态展现出了卓越的兼容性和可得性。从底层的 PCI 设备识别,到厂商官方驱动和工具链的稳定运行,再到上层容器和 AI 框架的成功调用,openEuler 成功地扮演了一个中立、稳定、可靠的统一系统底座角色。

算力在 openEuler 的世界里,不再仅仅指代 CPU。它意味着开发者和企业可以在一套统一的、熟悉的操作系统之上,自由地接入和调度来自不同厂商的、最适合其业务场景的加速引擎,从而真正释放算力联合国的全部潜力。

- 点赞

- 收藏

- 关注作者

评论(0)