ChatGPT平替!LocalAI+cpolar让大模型在笔记本电脑跑起来,数据全程不联网

前言

当你需要处理商业合同却担心GPT泄露机密时,LocalAI给出了完美解决方案——这个开源项目让Llama、Stable Diffusion等大模型直接运行在个人设备上,所有数据处理全程不离开本地网络。最令人惊喜的是它突破性地支持CPU推理,我的四年老笔记本也能流畅运行7B参数模型,彻底消除了AI使用的硬件门槛。现在我用它处理客户合同,再也不用担心敏感信息上传云端,这种"隐私安全感"是商业AI服务无法比拟的。

在法律文书处理场景中,LocalAI的"私有化部署"特性展现出独特优势——我将客户的保密协议导入本地模型,让AI辅助生成条款建议,整个过程文档从未离开办公电脑。而"模型切换"功能则让我能随时在法律专用模型和通用写作模型间切换,这种灵活性比单一功能的AI工具实用得多。记得有次周末在家加班,通过LocalAI的"离线语音转写"功能处理会议录音,生成的文字稿准确率达95%,完全满足后续整理需求。

但本地部署的AI服务存在一个使用局限:当你外出时,就无法访问家里的算力资源。上个月在客户现场需要紧急生成方案配图,我只能用手机版AI工具妥协,结果因风格不符导致方案修改。这种"设备绑定"的工作模式,在移动办公场景下显得格外不便。

cpolar内网穿透技术完美解决了这一痛点。通过在办公电脑部署cpolar,我将LocalAI的8080端口映射为公网地址,现在用酒店的公共电脑也能安全调用家里的大模型服务。最关键的是,cpolar采用"端到端加密"传输,即使在不安全的网络环境下使用AI生成敏感内容也不用担心数据泄露。上周帮客户修改专利申请书时,我通过4G网络访问LocalAI,用其"专业术语优化"功能提升文案严谨性,客户完全没察觉我是在咖啡厅完成的这项工作。

更值得称道的是cpolar的"访问白名单"功能。我将常用设备的IP添加到信任列表,即使链接意外泄露,非授权设备也无法访问AI服务,这种双重安全机制比商业云服务更可靠。现在我的法律咨询团队都配备了LocalAI+cpolar组合,既能享受AI辅助的效率提升,又能确保客户数据的绝对安全,这种"鱼与熊掌兼得"的体验彻底改变了我们的工作方式。

本文主要介绍如何在本地服务器部署无需依托高昂价格的GPU,也可以在本地运行离线AI项目的开源AI神器LoaclAI,并结合cpolar内网穿透轻松实现远程使用的超详细教程。

【视频教程】

1. Docker部署

本例使用Ubuntu 22.04进行演示,使用Docker进行部署

安装好Docker后,打开终端执行这行命令启动容器即可:

sudo docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-cpu

这里使用的镜像是仅使用CPU来运行的镜像,如果大家有Nvidia显卡的好GPU,也可以使用下方命令拉取支持N卡的镜像来运行容器:

sudo docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12

更多项目配置与使用详情大家也可以访问作者的github主页进行查看:https://github.com/mudler/LocalAI

2. 简单使用演示

容器启动后,我们在Ubuntu中使用浏览器访问 http://localhost:8080 即可打开LocalAI的Web UI页面:

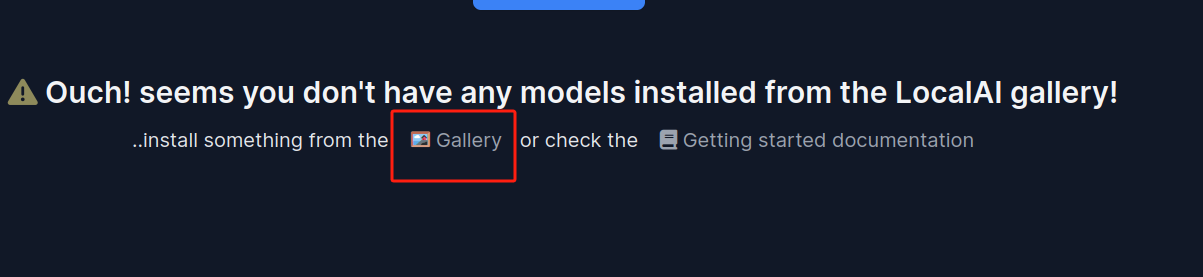

能看到页面中央提示我们现在还没有添加大模型,我们可以点击Gallery,在跳转页面选择一个大模型:

可以看到在这个界面中有600多个大模型,并且可以根据用途标签(文字转语音、图片生成、文章生成等等)进行筛选或者在下方输入框搜索指定的模型:

我这里以添加llama-3.2-1b模型来进行演示:点击install按钮安装等待完成即可

安装完成后,点击页面上方导航条中的HOME回到主页即可发现刚刚添加的llama-3.2模型:

想要使用这个AI大模型,点击上方导航中的chat即可与它聊天了:

点击右侧的模型选择,下拉框中会显示你已经安装的大模型:

目前我只安装了这一个,如果想继续安装其他大模型,可以点击页面上方导航栏中的Models进行选择:(跳转的就是首次挑选模型安装的那个页面)

3. 安装cpolar内网穿透

不过我们目前只能在本地局域网内访问刚刚部署的LocalAI来使用AI大模型聊天,如果想不在同一局域网内时,也能在外部网络环境使用手机、平板、电脑等设备远程访问与使用它,应该怎么办呢?我们可以使用cpolar内网穿透工具来实现远程访问的需求。无需公网IP,也不用设置路由器那么麻烦。

下面是安装cpolar步骤:

使用一键脚本安装命令:

sudo curl https://get.cpolar.sh | sh

安装完成后,执行下方命令查看cpolar服务状态:(如图所示即为正常启动)

sudo systemctl status cpolar

Cpolar安装和成功启动服务后,在浏览器上输入ubuntu主机IP加9200端口访问Cpolar管理界面,使用Cpolar官网注册的账号登录,登录后即可看到cpolar web 配置界面,接下来在web 界面配置即可:

4. 配置公网地址

登录cpolar web UI管理界面后,点击左侧仪表盘的隧道管理——创建隧道:

- 隧道名称:可自定义,本例使用了: localai ,注意不要与已有的隧道名称重复

- 协议:http

- 本地地址:8080

- 域名类型:随机域名

- 地区:选择China Top

点击创建:

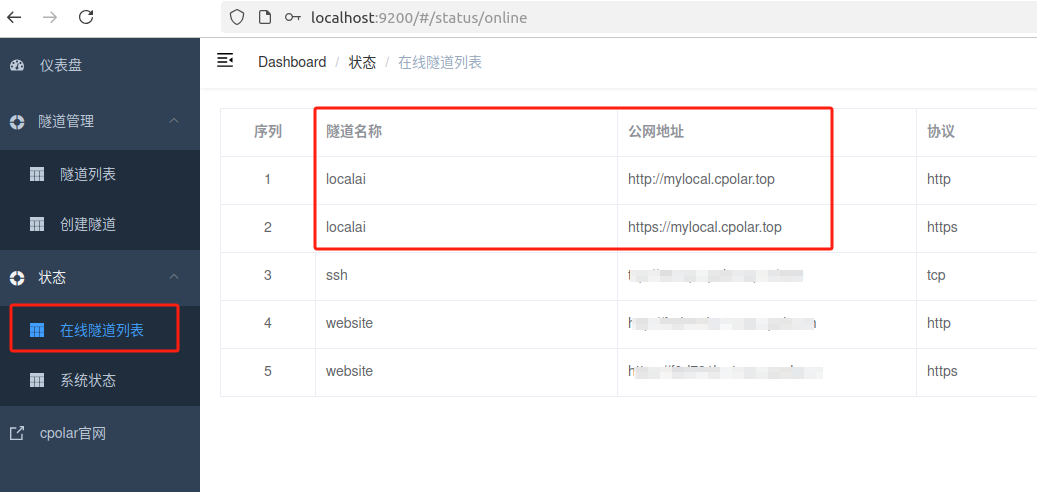

创建成功后,打开左侧在线隧道列表,可以看到刚刚通过创建隧道生成了两个公网地址,接下来就可以在其他电脑或者移动端设备(异地)上,使用任意一个地址在浏览器中访问即可。

如图所示,现在就已经成功实现使用公网地址异地远程访问本地部署的LocalAI来用AI大模型聊天啦!

小结

为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。

如果有长期使用LocalAI,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来配置公网地址。

5. 配置固定公网地址

由于以上使用cpolar所创建的隧道使用的是随机公网地址,24小时内会随机变化,不利于长期远程访问。因此我们可以为其配置二级子域名,该地址为固定地址,不会随机变化。

注意需要将cpolar套餐升级至基础套餐或以上,且每个套餐对应的带宽不一样。【cpolar.cn已备案】

点击左侧的预留,选择保留二级子域名,地区选择china top,然后设置一个二级子域名名称,我这里演示使用的是mylocal,大家可以自定义。填写备注信息,点击保留。

保留成功后复制保留的二级子域名地址:

登录cpolar web UI管理界面,点击左侧仪表盘的隧道管理——隧道列表,找到所要配置的隧道localai,点击右侧的编辑。

修改隧道信息,将保留成功的二级子域名配置到隧道中

- 域名类型:选择二级子域名

- Sub Domain:填写保留成功的二级子域名

- 地区: China Top

点击更新

更新完成后,打开在线隧道列表,此时可以看到随机的公网地址已经发生变化,地址名称也变成了保留和固定的二级子域名名称。

最后,我们使用固定的公网地址在任意设备的浏览器中访问,可以看到成功访问本地部署的LocalAI Web UI页面,这样一个永久不会变化的二级子域名公网网址即设置好了。

以上就是如何在本地Ubuntu系统使用Docker快速部署开源AI服务LocalAI,并安装cpolar内网穿透工具配置固定不变的二级子域名公网地址,实现随时随地远程在线与AI大模型交互的全部流程,感谢您的观看,有任何问题欢迎留言交流。

**总结:**在追求智能化与隐私保护并重的时代,LocalAI如同一座"隐形堡垒"守护着用户的数据疆界。而cpolar则为这座堡垒打开了安全可控的通道——这不仅是技术上的突破,更是对数字时代个人权利的一次有力捍卫。

- 点赞

- 收藏

- 关注作者

评论(0)