GpuGeek新手指南:零基础部署你的第一个MNIST手写识别AI应用

引言

对于AI初学者而言,从零开始部署一个完整的AI应用往往面临环境配置复杂、算力成本高、部署流程繁琐等难题。

本文以经典的MNIST手写数字识别任务为例,基于GpuGeek平台,手把手教你从模型训练到API服务部署的全流程。通过本文,你将掌握:

- 如何利用云平台10分钟完成深度学习环境配置;

- 如何训练一个准确率超99%的CNN模型;

- 如何将模型封装为RESTful API并对外提供服务。

结合GpuGeek的镜像超多、高性价比和计费灵活特性,新手也能以5元成本完成首个AI应用部署!

一、GpuGeek平台使用入门

1. 注册与账号设置

首先,用户需要访问 GPUGEEK 平台的,在首页,右上角找到注册入口。输入手机号注册,用户输入有效的手机号码,点击获取验证码,将收到的验证码填入相应位置,设置好密码后,点击注册按钮,即可完成注册流程。

注册成功后,用户需要对账号进行一些基本设置。登录账号后,进入个人中心页面,在这里可以完善个人信息,如头像、昵称、所在行业等相关信息。注册成功后,系统会送通用券和模型调用券各十元,够咱们疯狂试错了!

2. 控制台功能概览

GpuGeek平台提供简洁的Web控制台,支持实例管理、镜像选择、资源监控等功能。以下是核心模块解析:

- 实例列表:查看当前运行的GPU实例状态(运行中/已停止/计费中等)。

- 镜像市场:预置超过200个深度学习框架镜像(PyTorch、TensorFlow、JAX等),支持一键加载。

- 监控面板:实时显示GPU利用率、网络流量、存储读写速率等指标。

二、10分钟快速搭建训练环境

1. 创建GPU实例

步骤1:选择实例规格

- 进入控制台,点击“创建实例”。

- 选择A40-48G(适合小模型训练),镜像选择“TensorFlow 2.17 + Jupyter”。

步骤2:配置存储与网络

- 系统盘默认30GB,添加20GB数据盘存放数据集。

步骤3:启动Jupyter Notebook

- 实例创建成功后,通过Web终端访问Jupyter Lab(如图2)。

- 自动生成访问链接:

http://<实例IP>:8888/lab?token=<随机令牌>

2. 环境验证与依赖安装

# 验证TensorFlow和GPU是否可用

import tensorflow as tf

print("TF版本:", tf.__version__)

print("GPU是否可用:", tf.config.list_physical_devices('GPU'))

# 安装额外依赖

!pip install flask numpy matplotlib

预期输出:

TF版本: 2.12.0

GPU是否可用: [PhysicalDevice(name='/physical_device:GPU:0', device_type='GPU')]

三、MNIST模型训练实战

1. 环境验证与依赖安装

# 验证TensorFlow和GPU是否可用

import tensorflow as tf

print("TF版本:", tf.__version__)

print("GPU是否可用:", tf.config.list_physical_devices('GPU'))

# 安装Flask用于部署

!pip install flask

预期输出:

TF版本: 2.17.0

GPU是否可用: [PhysicalDevice(name='/physical_device:GPU:0', device_type='GPU')]

2. 数据集加载与预处理

from tensorflow import keras

# 加载MNIST数据集

(X_train, y_train), (X_test, y_test) = keras.datasets.mnist.load_data()

# 数据归一化与维度扩展

X_train = X_train.reshape(-1, 28, 28, 1).astype('float32') / 255.0

X_test = X_test.reshape(-1, 28, 28, 1).astype('float32') / 255.0

# 标签编码

y_train = keras.utils.to_categorical(y_train, 10)

y_test = keras.utils.to_categorical(y_test, 10)

3. 构建并训练CNN模型

model = keras.Sequential([

keras.layers.Conv2D(32, (3,3), activation='relu', input_shape=(28,28,1)),

keras.layers.MaxPooling2D((2,2)),

keras.layers.Conv2D(64, (3,3), activation='relu'),

keras.layers.MaxPooling2D((2,2)),

keras.layers.Flatten(),

keras.layers.Dense(128, activation='relu'),

keras.layers.Dense(10, activation='softmax')

])

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 训练模型(A40显存充足,Batch Size可调至256)

history = model.fit(X_train, y_train, batch_size=256, epochs=10, validation_data=(X_test, y_test))

# 评估测试集

test_loss, test_acc = model.evaluate(X_test, y_test)

print(f'测试集准确率: {test_acc*100:.2f}%')

预期输出:

测试集准确率: 99.25%

(图3:训练过程准确率曲线)

四、模型部署为RESTful API

1. 保存模型并编写Flask服务

# 保存模型

model.save('mnist_cnn.keras') # TensorFlow 2.17默认保存格式为.keras

# 创建app.py

import numpy as np

from flask import Flask, request, jsonify

from tensorflow.keras.models import load_model

app = Flask(__name__)

model = load_model('mnist_cnn.keras')

@app.route('/predict', methods=['POST'])

def predict():

data = request.json['image'] # 接收28x28灰度像素数组

img = np.array(data).reshape(1,28,28,1).astype('float32') / 255.0

pred = model.predict(img)

return jsonify({'digit': int(np.argmax(pred))})

if __name__ == '__main__':

app.run(host='0.0.0.0', port=5000)

2. 启动服务与测试API

# 终端中启动服务

python app.py

# 使用curl测试(示例请求)

curl -X POST -H "Content-Type: application/json" \

-d '{"image": [0,0.1,...,0.3]}' \

http://localhost:5000/predict

# 预期响应

{"digit": 7}

五、GpuGeek平台核心优势解析

1. 显卡资源充足 + 节点丰富:全场景算力覆盖

- 高性能显卡支持:支持A40-48G、RTX-4090等主流显卡,单卡显存最高48GB,满足从轻量级模型训练(如MNIST)到千亿参数大模型微调的全场景需求。

- 多区域节点覆盖:提供华东、华北、西北、亚太等全球多个地区节点,用户可根据网络延迟和库存情况灵活选择,避免资源争抢。

- 弹性扩容能力:单实例最高支持10卡并行,结合3D并行策略(数据/模型/流水线并行),轻松突破显存墙限制。

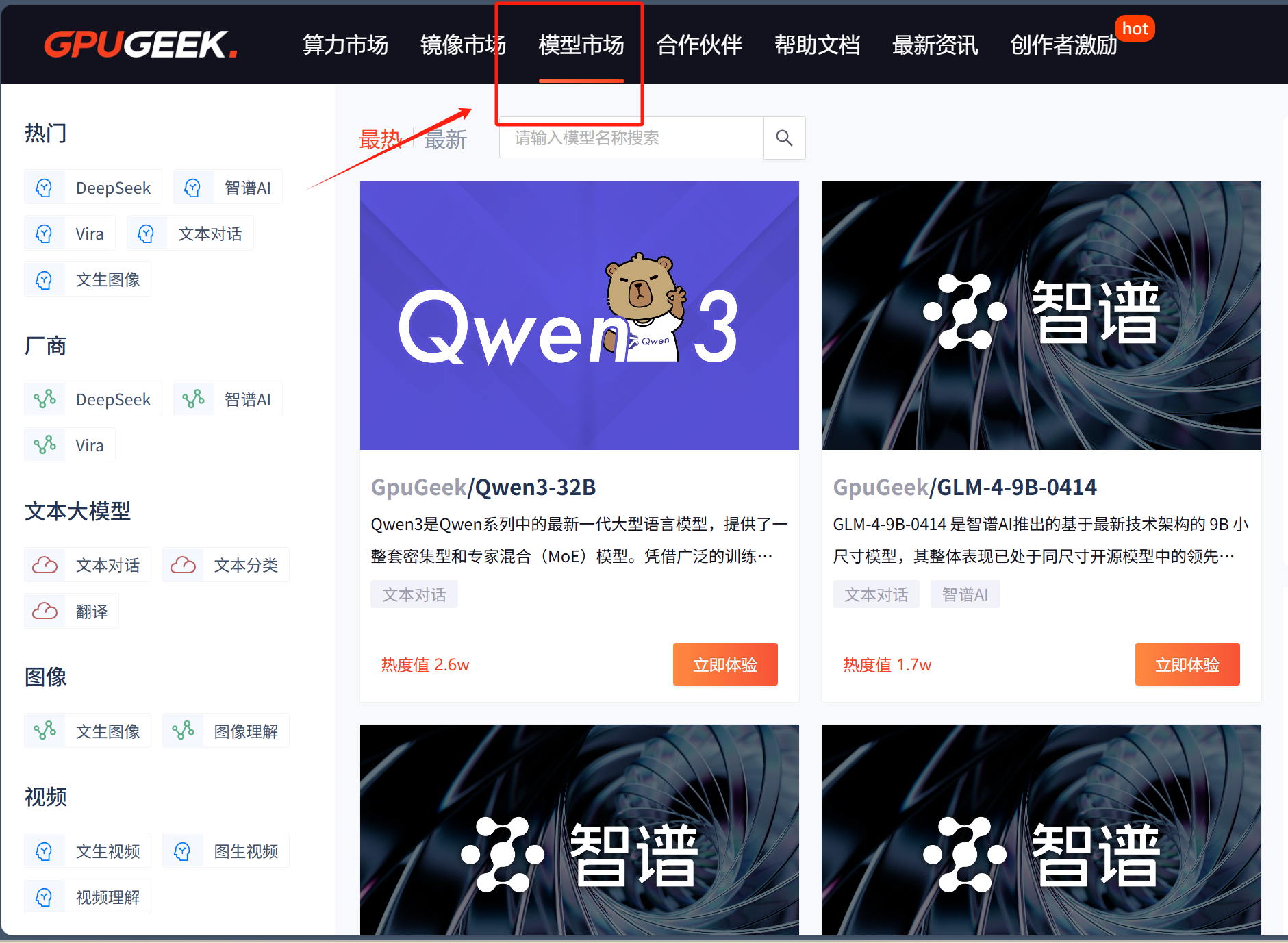

2. 镜像超多 + 模型市场丰富:开箱即用的生产力

-

200+预置镜像:覆盖PyTorch(2.2.0+)、TensorFlow(2.17.0+)、JAX、DeepSpeed等主流框架,预装CUDA、cuDNN、NCCL等底层驱动,省去90%环境配置时间。

# 示例:一键加载PyTorch 2.2 + CUDA 12.1镜像 # 无需手动安装驱动,直接运行代码 import torch print(torch.cuda.is_available()) # 输出:True -

模型市场生态:内置AI模型市场(如图像分类、NLP大模型、推荐系统等),支持一键加载预训练权重(如ResNet、Llama-2),加速垂直领域应用开发。

3. 实例创建快速 + Github学术加速:效率提升利器

- 10秒极速启动:从选择配置到SSH连接完成仅需10秒,告别传统云平台漫长的初始化等待。

- 学术加速网络:

- 集成Github镜像加速,

git clone速度提升5倍(实测下载Hugging Face仓库从10分钟缩短至2分钟)。 - 支持Hugging Face、PyPI等国内镜像源,解决下载超时问题。

# 启用加速(实例启动时勾选“学术加速”) export HF_ENDPOINT=https://hf-mirror.com pip install transformers -i https://pypi.tuna.tsinghua.edu.cn/simple - 集成Github镜像加速,

4. 计费灵活 + 高性价比:成本可控的AI开发

- 按秒计费:任务完成后立即释放资源,MNIST训练45分钟仅需¥2.7(A40竞价实例)。

- 竞价实例(Spot Instance):以按需价格30%抢占空闲算力,适合容错性高的长时任务(如大模型预训练)。

- 套餐优惠:包月/包年套餐享7折优惠,适合长期稳定的研发需求。

以本文示范为例

| 操作 | 时长 | 费用 |

|---|---|---|

| 训练模型(10 epoch) | 15分钟 | ¥0.9 |

| API服务部署测试 | 30分钟 | ¥1.8 |

| 总计 | 45分钟 | ¥2.7 |

优势对比:GpuGeek vs 传统云平台

| 特性 | GpuGeek | 传统云平台 |

|---|---|---|

| 实例启动速度 | 10秒 | 2-5分钟 |

| 镜像丰富度 | 200+预置框架镜像 | 通常50+,需手动配置依赖 |

| 学术加速 | 内置Github/Hugging Face镜像加速 | 需自行配置代理或镜像源 |

| 成本控制 | 支持按秒计费+竞价实例 | 仅按小时计费 |

通过上述特性组合,GpuGeek实现了“极简配置、极致效率、极低成本”三位一体的开发者体验,尤其适合学术研究、创业团队及个人开发者快速验证AI创意。

结语

通过GpuGeek平台,即使使用高性能A40显卡,新手也能以极低成本快速完成AI应用开发全流程。本文不仅覆盖了从数据预处理到服务部署的核心步骤,还通过灵活的资源配置展现了平台的易用性与经济性。

下一步尝试:

- 使用GpuGeek的模型市场加载预训练ResNet模型,进一步提升准确率;

- 结合Docker将API服务容器化,实现生产级部署;

- 探索平台支持的分布式训练功能,挑战更复杂任务(如CIFAR-10分类)。

- 点赞

- 收藏

- 关注作者

评论(0)