一种高性能计算和数据中心网络架构:InfiniBand(IB),低延迟、高带宽、可扩展性!

InfiniBand(IB)是一种高性能计算和数据中心网络架构,其设计目标是通过提供低延迟、高带宽以及可扩展性来满足大规模计算和数据传输的需求。让我们深入了解InfiniBand的基本概念。

InfiniBand网络采用点对点的直连架构。每个设备,如服务器、存储设备或其他计算资源,都通过InfiniBand适配器直接连接到网络,形成一个点对点的通信结构。这种设计有助于降低通信的延迟,提高整体性能。

InfiniBand网络的物理层和数据链路层规定了数据在传输过程中的基本原则。物理层负责传输比特流,而数据链路层则处理流控、错误检测和纠错等任务。这两个层次的协同工作确保了数据在InfiniBand网络中的可靠传输。

InfiniBand网络支持不同的传输速率,通常以Gbps(千兆比特每秒)为单位。例如,InfiniBand架构最初支持的是单数据率(SDR)为20 Gbps、双数据率(DDR)为40 Gbps,以及四数据率(QDR)为80 Gbps。随着技术的进步,还出现了更高速率的版本,如四teen数据率(FDR)为56 Gbps和电信号强化(EDR)为100 Gbps。

网络拓扑

InfiniBand网络支持多种拓扑结构,使其适用于各种应用场景。

- 总线拓扑(Bus Topology): 设备连接到单一的总线上,适用于小规模集群。

- 环形拓扑(Ring Topology): 设备按环形连接,形成封闭的通信环境。

- 树状拓扑(Tree Topology): 设备以分层的树状结构连接,提供更好的可扩展性。

- 网状拓扑(Mesh Topology): 设备以网状连接,适用于大规模、高性能计算环境。

InfiniBand的灵活拓扑结构使其适用于不同规模和性能需求的应用。

通过 InfiniBand 传输数据

在传统的互连结构中,操作系统通常是共享网络资源的唯一所有者,这导致应用程序无法直接访问网络。相反,数据传输通常需要依赖操作系统将数据从应用程序的虚拟缓冲区传输到网络堆栈和线路。然而,InfiniBand技术的引入改变了这一传统的网络交互模式。

在传统网络结构中,应用程序需要通过操作系统来实现数据的传输。

这个过程包括:

-

应用程序缓冲区: 数据通常存储在应用程序的缓冲区中,等待被传输。

-

操作系统介入: 应用程序通过系统调用等方式请求操作系统将数据传输到网络堆栈中。

-

网络堆栈传输: 操作系统将数据从应用程序缓冲区传输到网络堆栈,其中包括协议栈的处理,例如TCP/IP协议。

-

网络线路传输: 最终,数据通过网络线路传输到目标节点。

这种结构下,应用程序无法直接控制网络的数据传输,而是依赖于操作系统进行中介。

InfiniBand技术的突出特点之一是以应用为中心的网络交互方式。这种方式下,应用程序能够直接通过网络进行数据的交换,而无需直接涉及操作系统。以下是InfiniBand实现应用为中心方式的关键机制:

远程直接内存访问(RDMA)

InfiniBand网络支持远程直接内存访问(RDMA)技术。通过RDMA,应用程序可以在不涉及操作系统的情况下直接访问和交换内存中的数据。这种直接的内存访问方式消除了传统网络结构中的中介步骤,大大降低了数据传输的延迟。

用户空间网络堆栈

InfiniBand网络允许在用户空间中实现网络堆栈,使得应用程序能够直接处理网络协议。这样一来,应用程序不再需要通过操作系统的内核空间进行数据传输,而是可以直接在用户空间中完成网络操作,提高了效率和灵活性。

零拷贝技术

InfiniBand还支持零拷贝技术,通过这一技术,应用程序可以直接在内存中操纵数据,而无需将数据复制到中间缓冲区。这降低了数据传输的开销,提高了效率。

通过InfiniBand实现应用为中心的网络交互方式,带来了一系列优势,并与传统网络结构形成了关键区别:

1、低延迟

由于应用程序能够直接进行数据交换,而无需经过多层的操作系统介入,因此InfiniBand网络实现了更低的传输延迟。这对于对延迟要求较高的应用场景非常重要。

2、高带宽

InfiniBand的应用为中心方式能够更有效地利用网络资源,提高了整体的带宽利用率。这使得InfiniBand网络在大规模数据传输和高性能计算等方面表现出色。

3、高效能

通过支持RDMA、用户空间网络堆栈和零拷贝技术,InfiniBand实现了更为高效的数据传输方式。这种高效能直接影响到应用程序的性能和响应速度。

4、灵活性

应用为中心的方式使得应用程序更灵活地控制数据传输和网络操作,无需过多依赖于操作系统的限制。这为应用程序提供了更大的自主性和定制性。

InfiniBand 架构与 TCP/IP

InfiniBand架构与传统的TCP/IP模型在网络通信中有着显著的差异,尤其在分布式存储和高性能计算领域的应用上。

InfiniBand 架构

InfiniBand架构分为五层,类似于传统的TCP/IP模型。这五层分别是:

- 物理层: 处理硬件接口、电气和光学传输等底层细节。

- 数据链路层: 负责数据的封装和解封装,错误检测和纠正。

- 网络层: 处理数据的路由和转发,确保数据在不同设备之间的正确传递。

- 传输层: 负责端到端的可靠数据传输,包括流控制和错误恢复。

- 应用层: 提供网络服务给应用程序,如传输控制协议(TCP)、用户数据报协议(UDP)等。

InfiniBand在分布式存储领域,尤其是在分布式并行计算(DPC)场景的存储前端网络中得到广泛应用。其强调高性能、低延迟,适用于大规模并行计算机集群和需要高吞吐量的应用场景。

TCP/IP则更为普遍地应用于商业网络和一般互联网通信。它是目前互联网通信的主流协议,用于支持各种应用,包括网页浏览、电子邮件、文件传输等。

InfiniBand架构通过引入远程直接内存访问(RDMA)技术等创新,解决了网络传输过程中服务器端数据处理的延迟问题。RDMA技术允许通过网络接口直接访问内存数据,无需内核干预,从而实现高吞吐量和低延迟的网络通信。

传统的TCP/IP网络通信通常涉及通过内核进行消息传输,导致数据移动和复制成本较高。这在高并发、低延迟应用场景下表现出一定的局限性。

InfiniBand的RDMA技术和应用为中心的设计使其特别适合大规模并行计算机集群,提供高性能、低延迟的数据传输。然而,它在普通商业网络中的应用相对有限。

TCP/IP是互联网通信的事实标准,适用于各种应用场景。然而,其在高性能计算和大规模并行计算方面的性能限制,使得在这些领域需要更高性能的解决方案。

支持的上层协议

InfiniBand架构支持多种上层协议,这些协议在不同的应用场景中发挥着关键作用。

1. SCSI 协议(小型计算机系统接口)

SCSI是一种用于计算机和外部设备之间数据传输的标准接口协议。它支持各种外围设备,包括磁盘驱动器、打印机和其他存储和输入输出设备。在InfiniBand架构中,SCSI协议的支持使得InfiniBand能够与各种外围设备进行高效的数据传输,为存储和I/O操作提供了通用的标准接口。

2. IPoIB 协议(IP over InfiniBand)

IPoIB协议允许通过InfiniBand网络进行IP数据传输。它是InfiniBand与TCP/IP协议栈相集成的关键协议,使得InfiniBand在互联网和商业网络中能够无缝地与现有的IP网络进行通信。IPoIB协议的支持扩展了InfiniBand的应用领域,使其能够在更广泛的网络环境中发挥作用。

3. SDP 协议(套接字直接协议)

SDP(Socket Direct Protocol)协议是为通过InfiniBand网络进行套接字通信而设计的协议。它提供高性能、低延迟的数据传输,为需要快速而可靠通信的应用程序提供了支持。SDP协议的引入使得InfiniBand成为一种适用于更广泛应用领域的通信协议,尤其在需要低延迟的场景中表现优异。

4. MPI(消息传递接口)

MPI(Message Passing Interface)是一种在并行计算中进行进程间通信的标准协议。它常用于高性能计算(HPC)应用程序,其中多个处理单元需要协同工作。通过支持MPI协议,InfiniBand架构为HPC应用提供了高效、可靠的消息传递机制,促进了大规模并行计算的发展。

这些上层协议的支持使得InfiniBand不仅在高性能计算环境中表现出色,同时也适用于大规模存储、网络通信以及其他需要高性能和低延迟的应用场景。这丰富的协议支持为InfiniBand架构赋予了灵活性和广泛的适用性。

远程直接内存访问(RDMA)

InfiniBand网络最引人注目的特性之一是远程直接内存访问(RDMA)。RDMA允许数据在不涉及主机CPU的情况下直接在内存中传输,从而降低了通信的延迟和CPU的负担。这对于高性能计算和数据中心应用非常重要,特别是在需要大规模数据传输的场景下。

举例来说,当一台服务器需要从另一台服务器的内存中读取或写入数据时,使用RDMA可以避免涉及中间步骤,直接在两台服务器之间进行数据传输,提高了数据传输的效率和速度。

InfiniBand网络在性能方面表现出色,这使其成为高性能计算领域的首选网络架构之一。以下是一些导致其性能优势的关键因素:

-

低延迟: InfiniBand网络的点对点直连结构以及支持RDMA技术,使其具有低延迟的特点,适用于对通信延迟要求较高的应用。

-

高吞吐量: 高传输速率和并行性质使InfiniBand能够支持大规模数据集的高吞吐量传输,对于需要大量数据处理的应用非常重要,例如科学计算、模拟和人工智能等领域。

-

可扩展性: 不同拓扑结构的支持以及InfiniBand架构的设计使其在大规模计算集群中具有出色的可扩展性。

InfiniBand网络在多个领域得到广泛应用,其中一些典型的应用场景包括:

-

超级计算: InfiniBand在超级计算环境中广泛应用,支持大规模并行计算任务,提供出色的性能和可扩展性。

-

数据中心: 用于连接服务器、存储系统和其他网络设备,满足数据中心对高性能和低延迟的需求。

-

人工智能: 在深度学习和机器学习等人工智能领域,InfiniBand网络能够支持大规模数据集的快速传输和分布式计算。

与以太网等其他网络技术相比,InfiniBand在某些方面具有独特的优势。然而,不同的应用场景可能需要根据具体需求选择合适的网络技术。以下是一些比较方面:

-

延迟与带宽: InfiniBand通常在延迟和带宽方面表现更为出色,适用于对性能要求较高的应用。

-

成本与普及度: 以太网技术更为普及,而InfiniBand设备和基础设施通常较为昂贵,因此在一些低成本和小规模场景中可能不是首选。

-

应用领域: InfiniBand在高性能计算和数据中心等特定领域表现卓越,而以太网则更广泛应用于企业和通用数据传输。

硬件中的传输层连接

在InfiniBand架构中,传输层的设计采用了一种特殊的方式,通过建立虚拟通道来连接两个应用程序,从而实现它们在完全独立的地址空间中进行通信。这种设计优势在于利用直接硬件数据传输,从而提高通信效率和性能。

InfiniBand引入了虚拟通道的概念,这是在传输层中用于连接两个应用程序的通道。通过建立虚拟通道,不同的数据流可以在网络中独立传输,而无需相互竞争网络带宽。每个虚拟通道都有自己的特定属性和服务质量,使得通信能够更加灵活和高效。

InfiniBand架构中的传输层设计中,消息直接通过硬件进行传输,无需主机处理器的干预。这一特性被实现通过引入远程直接内存访问(RDMA)技术,允许数据在网络适配器之间直接传递,绕过主机内存。这种直接硬件数据传输的方式带来了多重优势:

1、提高通信效率

通过直接硬件传输,消息在网络中的传输路径更为直接,减少了数据传输的中间步骤。这有助于提高通信效率,降低了传输的延迟。

2、提升性能

无需主机处理器的干预意味着数据可以更快速地在网络适配器之间传递。这对于高性能计算和大规模并行计算等对性能要求较高的应用场景非常重要。

3、降低系统开销

直接硬件数据传输减少了在数据传输过程中涉及主机处理器的操作,从而降低了系统的开销。这对于提升系统整体的性能和资源利用率具有积极影响。

在消息传输过程中,硬件中的传输层通过虚拟通道实现两个应用程序的连接。消息直接通过硬件传输,无需主机处理器的干预。一旦消息到达接收端,它将直接传递到接收应用程序的缓冲区,无需经过额外的处理步骤。这种设计有效地减少了传输的复杂性和时间成本,有助于实现高效、低延迟的通信。

InfiniBand网络的进阶特性

网络安全性与管理

随着网络攻击的不断演进,网络安全性成为网络设计的重要考虑因素之一。InfiniBand网络通过加密和身份验证等手段提高了数据传输的安全性。同时,网络管理工具的不断改进也使得对InfiniBand网络进行更加精细的监控和管理成为可能。

网络虚拟化

网络虚拟化是一种在物理网络基础上创建多个虚拟网络的技术。InfiniBand在这方面取得了一些进展,支持将物理网络资源划分为多个逻辑网络,从而提高网络资源的利用率和灵活性。这对于云计算和多租户环境中的资源管理非常重要。

HDR InfiniBand

HDR(200 Gbps)是InfiniBand架构中的一代新产品,为网络提供了更高的传输速率。HDR InfiniBand在支持大规模数据中心和高性能计算方面具有显著的优势,推动了InfiniBand网络在超级计算和数据密集型应用中的地位。

开源项目与标准化

InfiniBand技术在一定程度上受到开源社区的关注,有一些开源项目致力于推动InfiniBand技术的进一步发展。此外,InfiniBand Trade Association(IBTA)等组织也在不断推动InfiniBand技术的标准化,以确保其在不同设备和厂商之间的互操作性。

随着计算和数据需求的不断增长,InfiniBand网络将继续在高性能计算、大规模数据处理以及人工智能等领域发挥关键作用。未来的发展趋势可能包括更高速率的InfiniBand版本、更加智能的网络管理和优化,以及与其他新兴技术的融合,如光网络和量子计算。

总结

InfiniBand架构以其卓越的性能和低延迟的特性成为高性能计算和数据中心网络的首选解决方案。通过深入探讨InfiniBand的各个层次,包括物理层、链路层、网络层、传输层和上层协议,我们了解了其独特的设计和优势。

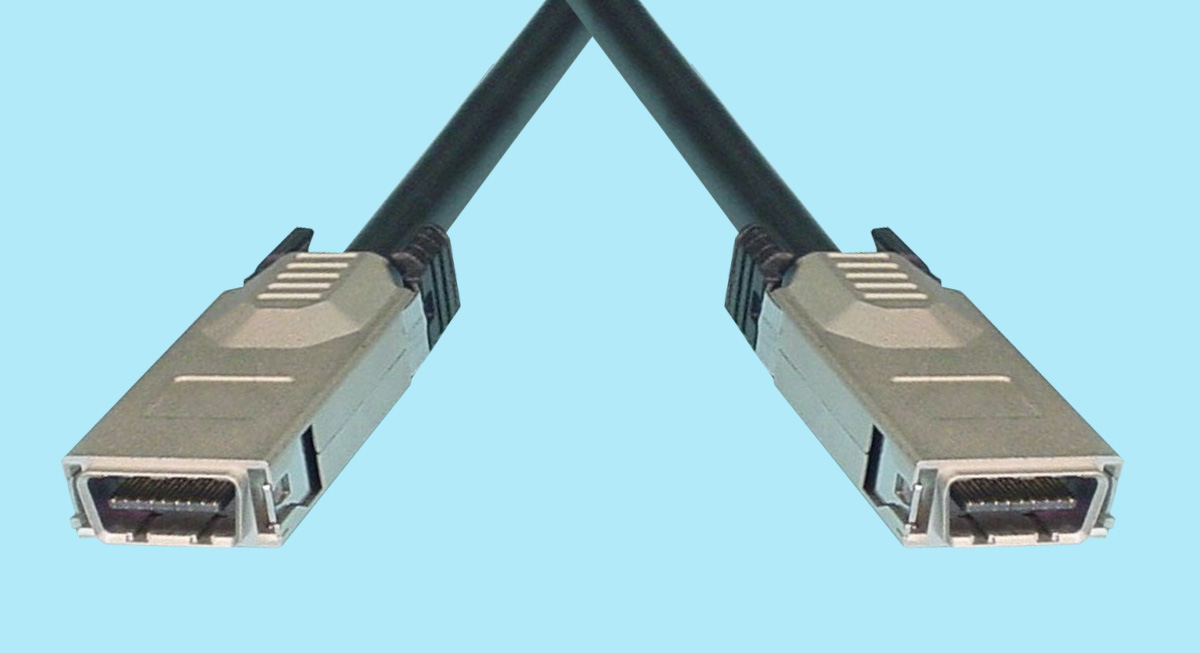

在物理层,InfiniBand采用多种传输介质和硬件规格,包括电缆、光纤和连接器,以支持高带宽、低延迟的数据传输。在链路层,本地标识符(LID)和转发表的使用为数据包的定位和传输提供了关键支持。网络层的子网划分和子网管理器的角色确保了网络的灵活性和高效性。传输层引入了远程直接内存访问(RDMA)技术,通过硬件级别的数据传输实现了低延迟和高吞吐量。

InfiniBand的应用广泛涵盖了高性能计算、大规模并行计算、云计算、机器学习和人工智能等领域。其在数据中心网络中的卓越表现,使其成为处理大规模数据传输和复杂计算任务的理想选择。随着对计算能力和数据中心规模的不断增长,InfiniBand作为一种高性能互连技术,将继续在科学、工程和商业领域发挥至关重要的作用。其未来的发展将持续推动科技创新和高性能计算的进步。

- 点赞

- 收藏

- 关注作者

评论(0)