大模型部署手记(12)LLaMa2+Chinese-LLaMA-Plus-2-7B+Windows+text-gen+中文对话

【摘要】 大模型部署手记(12)LLaMa2+Chinese-LLaMA-Plus-2-7B+Windows+text-gen+中文对话

1.简介:

组织机构:Meta(Facebook)

代码仓:https://github.com/facebookresearch/llama

模型:chinese-alpaca-2-7b-hf

下载:使用百度网盘下载

硬件环境:暗影精灵7Plus

Windows版本:Windows 11家庭中文版 Insider Preview 22H2

内存 32G

GPU显卡:Nvidia GTX 3080 Laptop (16G)

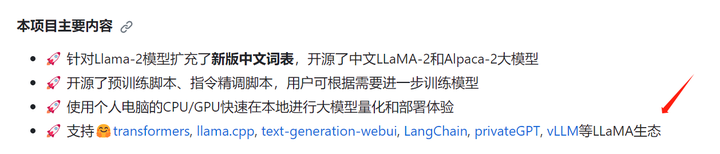

的README.md可以看出,中文LLaMA&Alpaca大模型支持不同的LLaMA生态:

这里面有

-

transformers

-

llama.cpp

-

text-generation-webui:

-

LangChain

-

privateGPT

-

vLLM

等多种。

在这里也介绍了不同环境上的部署方式:

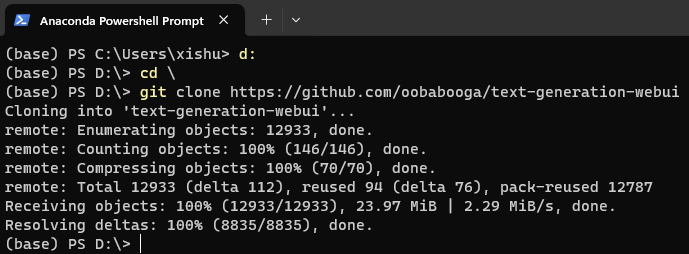

2.代码和模型下载:

d:

cd \

git clone https://github.com/oobabooga/text-generation-webui

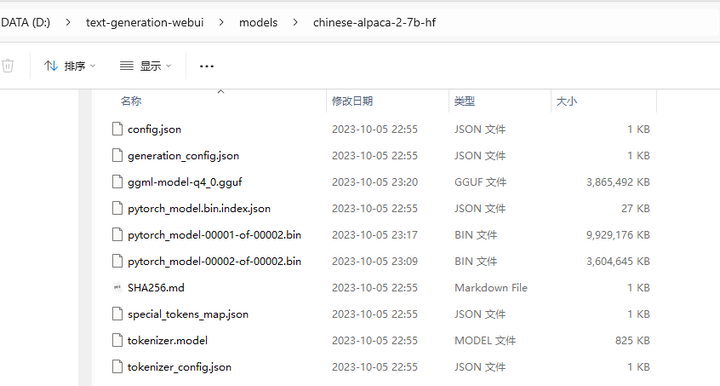

在 https://bbs.huaweicloud.com/blogs/412543下载的完整版权重目录 D:\llama.cpp\models2\chinese-alpaca-2-7b-hf 复制到 D:\text-generation-webui\models 目录下:

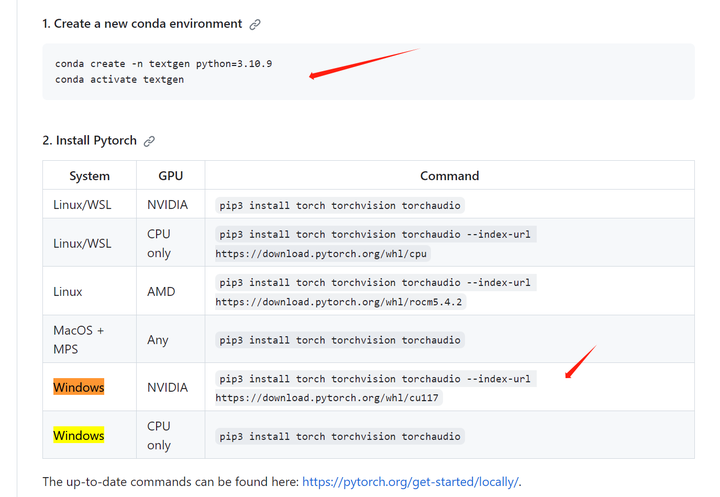

3.安装依赖

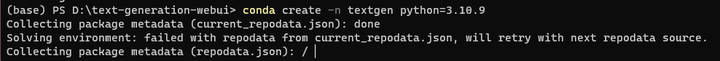

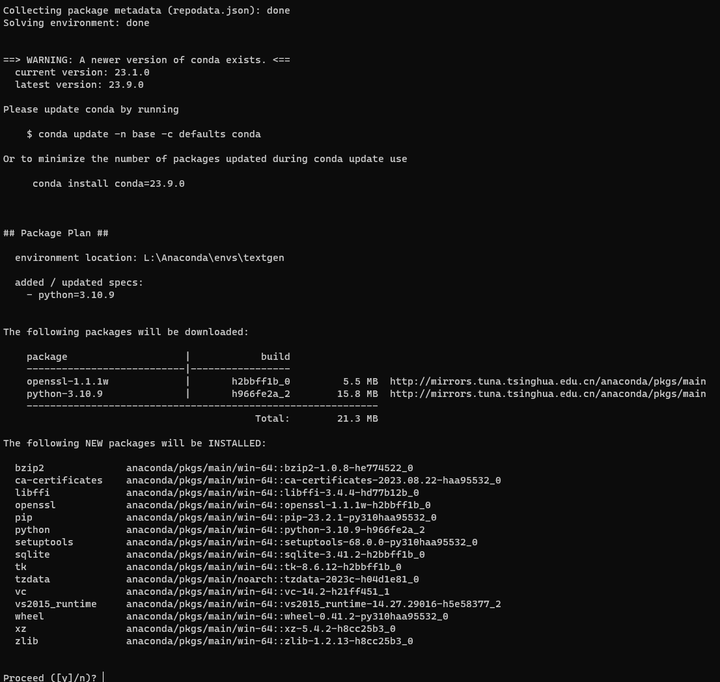

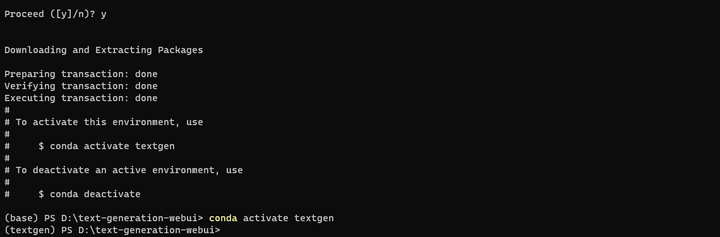

创建conda环境

conda create -n textgen python=3.10.9

conda activate textgen

cd text-generation-webui

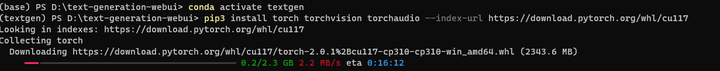

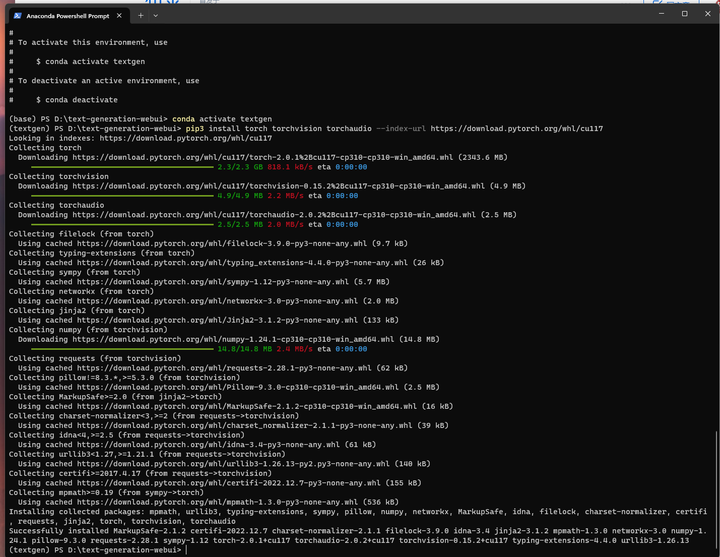

安装pytorch

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu117

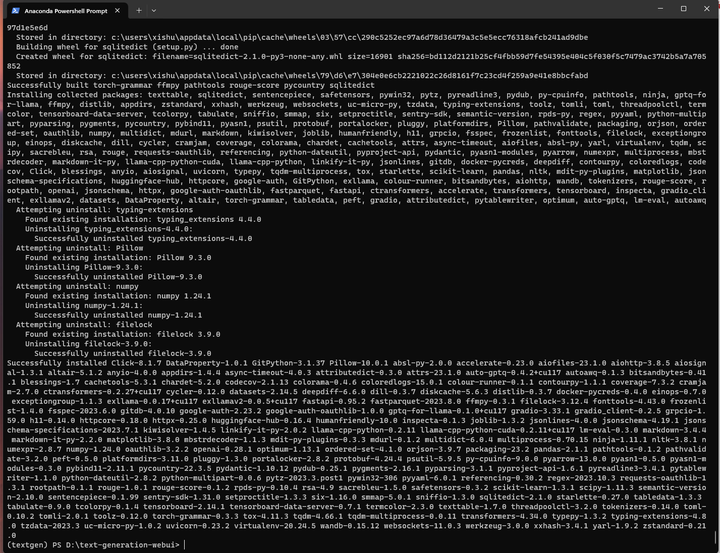

安装依赖:

pip install -r requirements.txt

4.部署验证

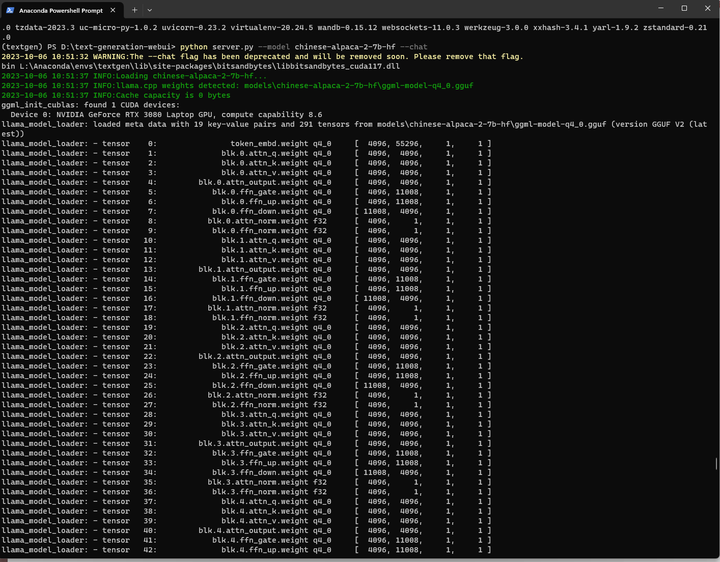

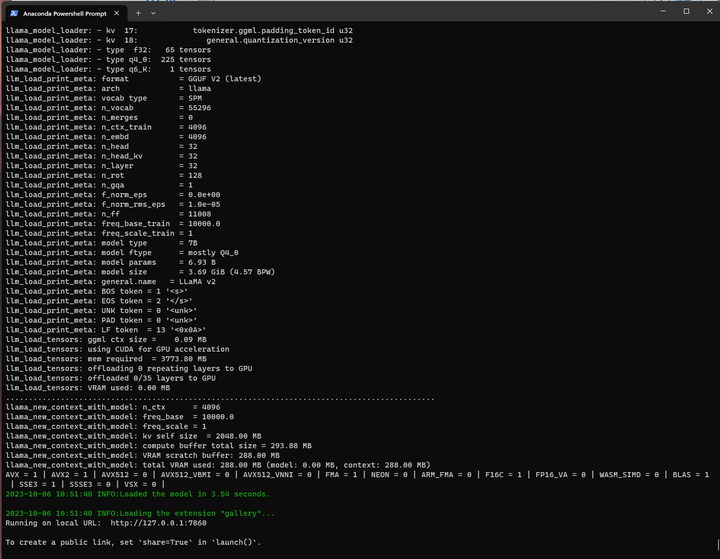

加载模型并启动:

python server.py --model chinese-alpaca-2-7b-hf --chat

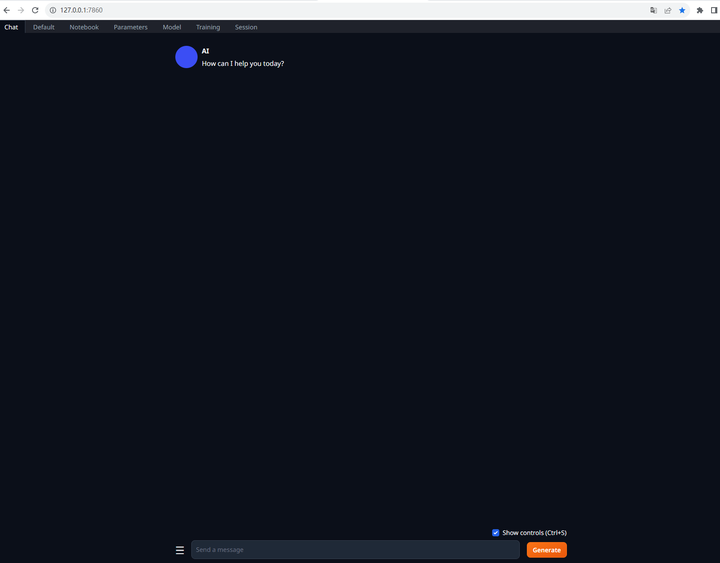

打开地址:

可以参考下面的指引操作:

在打开的网页中,依次选择Chat setting->Instruction template,在Instruction template中下拉选择Llama-v2,并将Context输入框中的Answer the questions.提示语替换为You are a helpful assistant. 你是一个乐于助人的助手。,最后回到Text generation界面,在input输入框中输入你的指令,即可与chinese-alpaca-2对话了。

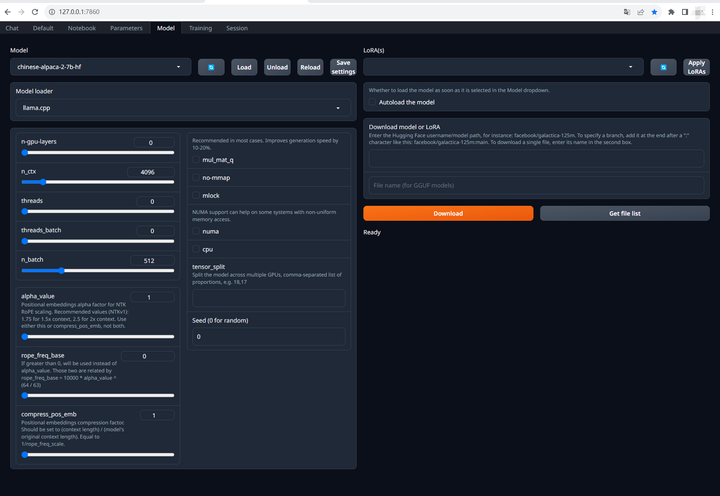

不过张小白点击Model,发现这个模型已经加载上去了!

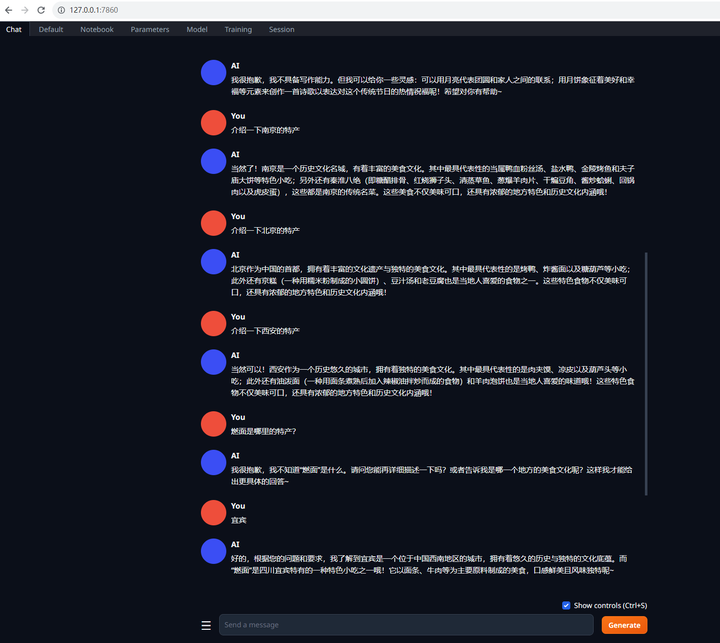

回到Chat屏幕,可以跟AI对话:

这个部署起来还是非常快的。

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)