在Windows GPU上体验FastChat

【摘要】 在Windows GPU上体验FastChat

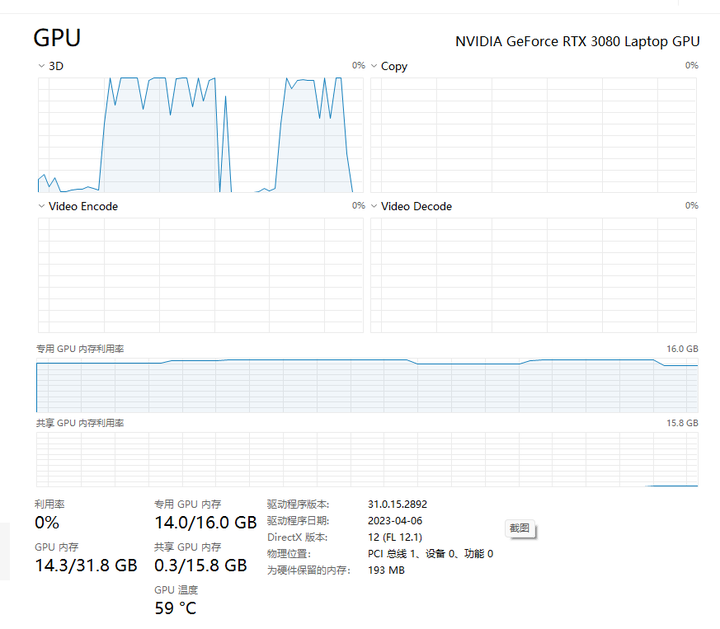

由于张小白的暗影精灵机器是Nvidia GeoForce RTX 3080 Laptop GPU。张小白心想在这台机器上应该也能玩转FastChat的吧?

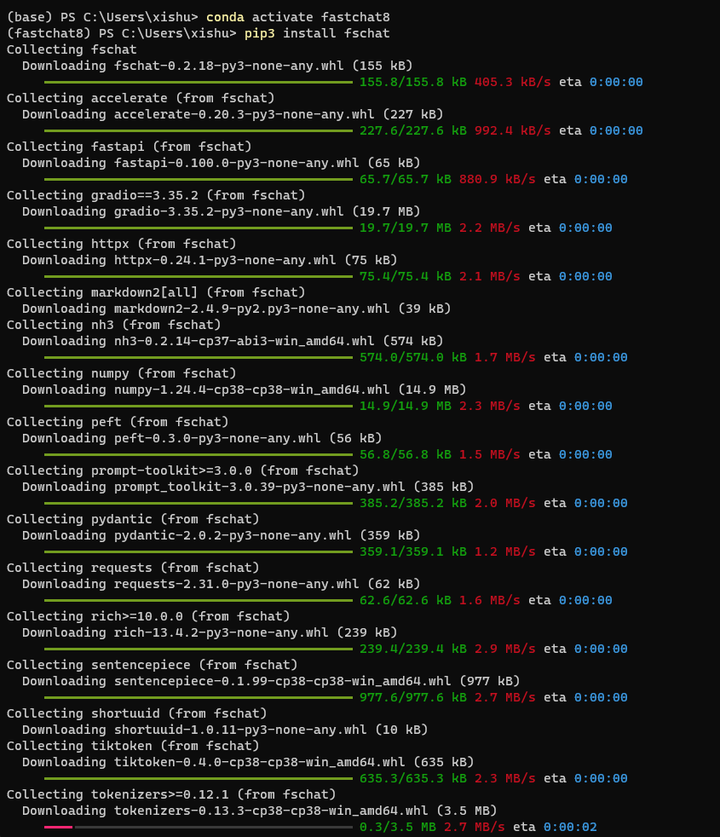

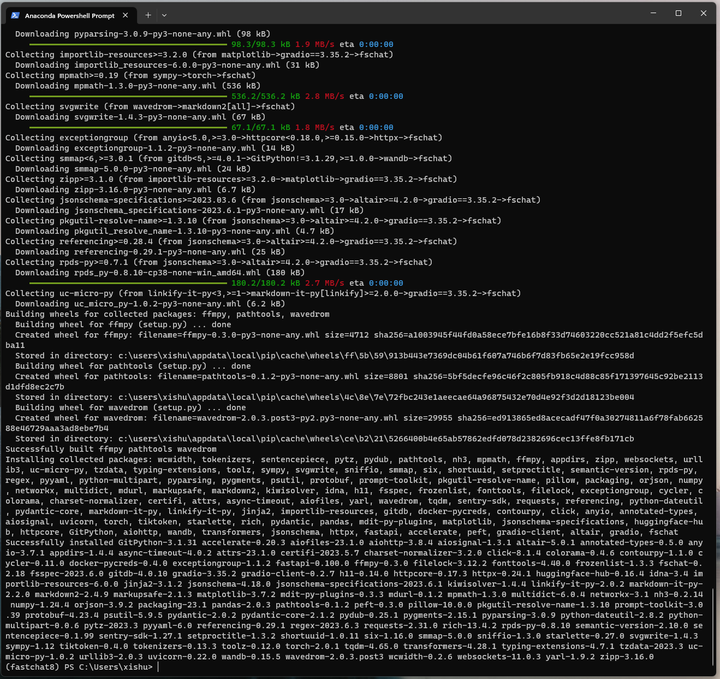

打开Anaconda命令行,创建conda环境:

conda create -n fastchat8 python=3.8

conda activate fastchat8

pip3 install fschat

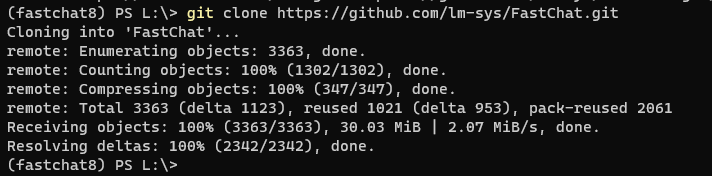

切换到L盘,下载FastChat代码仓:

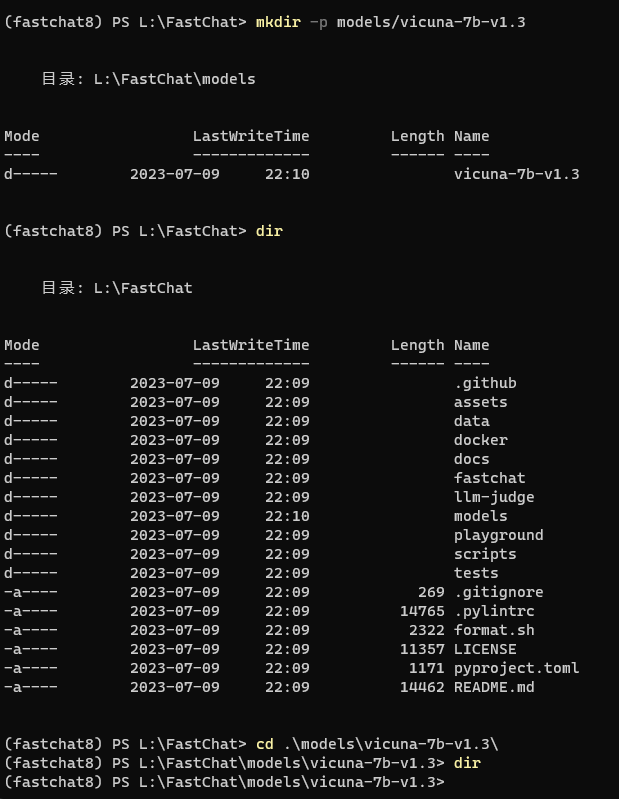

创建models相关目录:

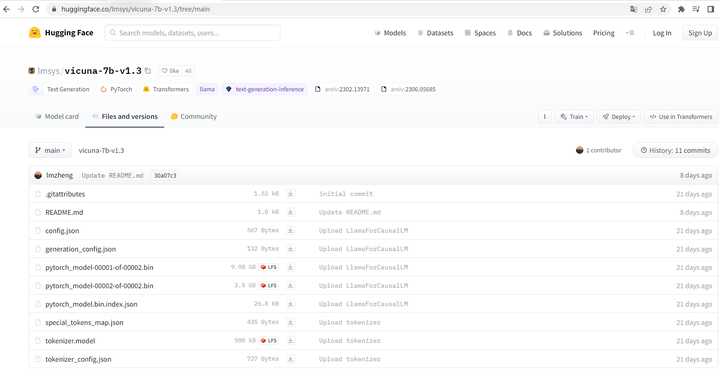

打开模型相关的网站:https://huggingface.co/lmsys/vicuna-7b-v1.3/tree/main

将左边的相关文件下载到本地,并复制到前面的models目录下。

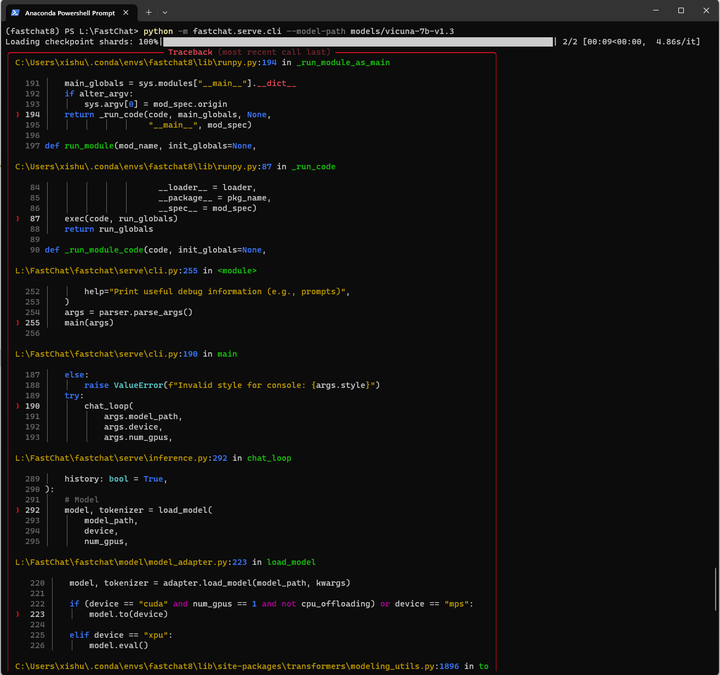

执行看看:

python -m fastchat.serve.cli --model-path models/vicuna-7b-v1.3

显然,通过fastchat安装的pytorch是2.0的非CUDA版本,无法满足需要。

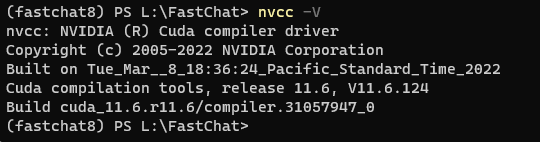

查看CUDA版本:11.6

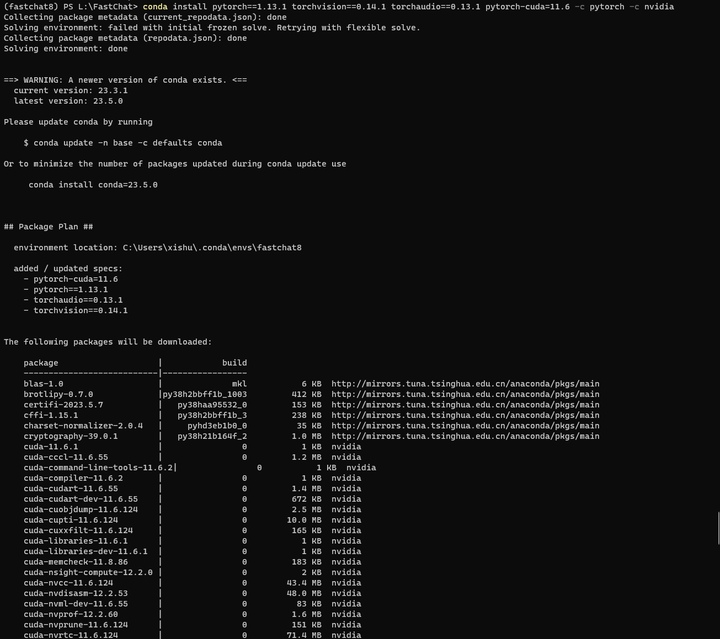

安装CUDA版pytorch,从历史版本中搜索到命令为:

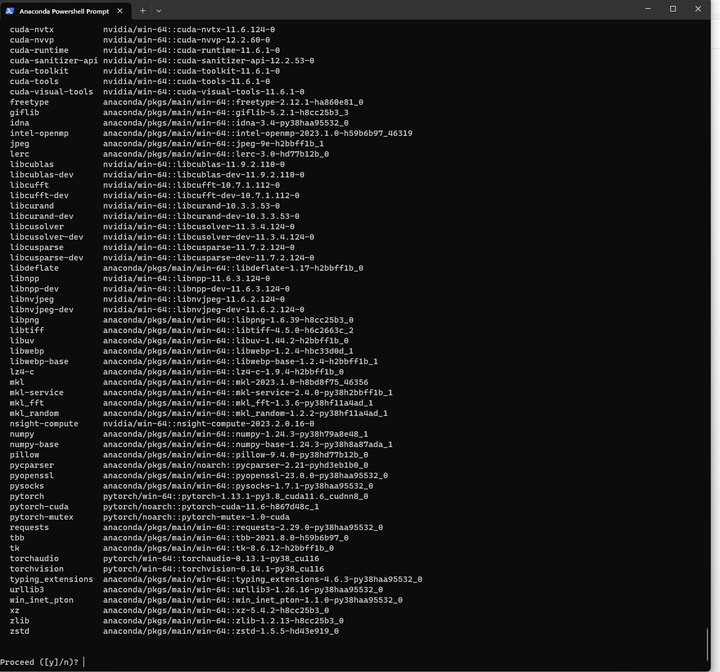

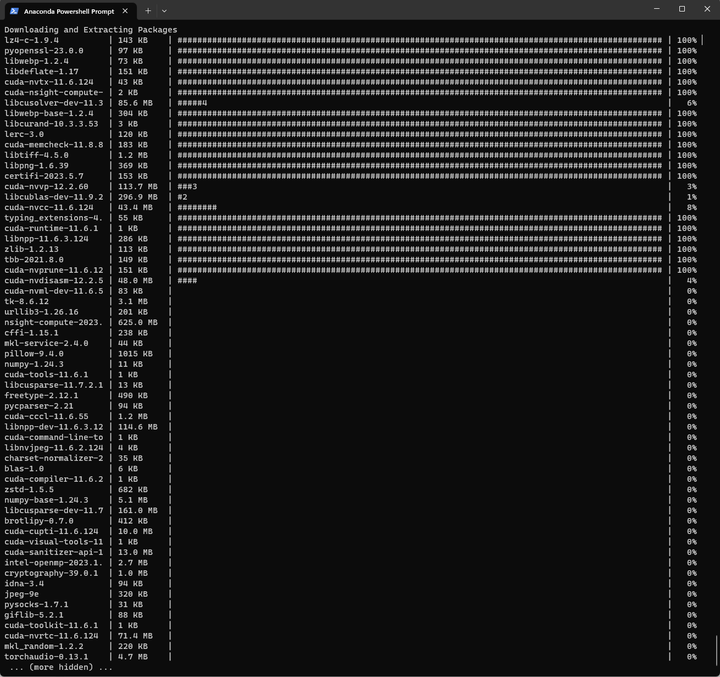

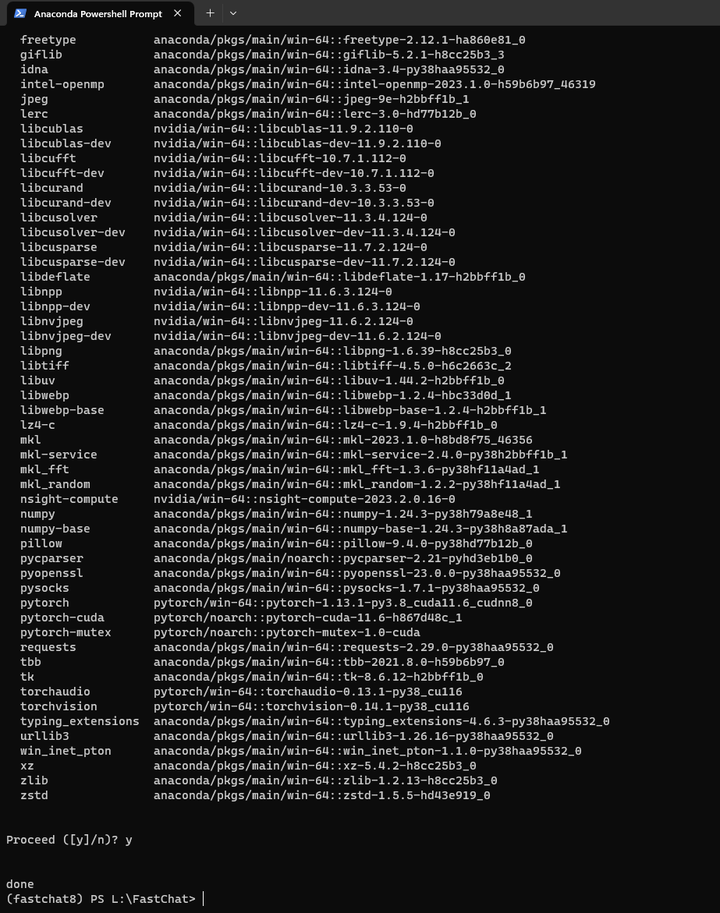

conda install pytorch==1.13.1 torchvision==0.14.1 torchaudio==0.13.1 pytorch-cuda=11.6 -c pytorch -c nvidia

耐心等待后,按Y继续:

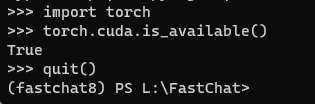

验证下PyTorch是否支持CUDA:

是支持的。

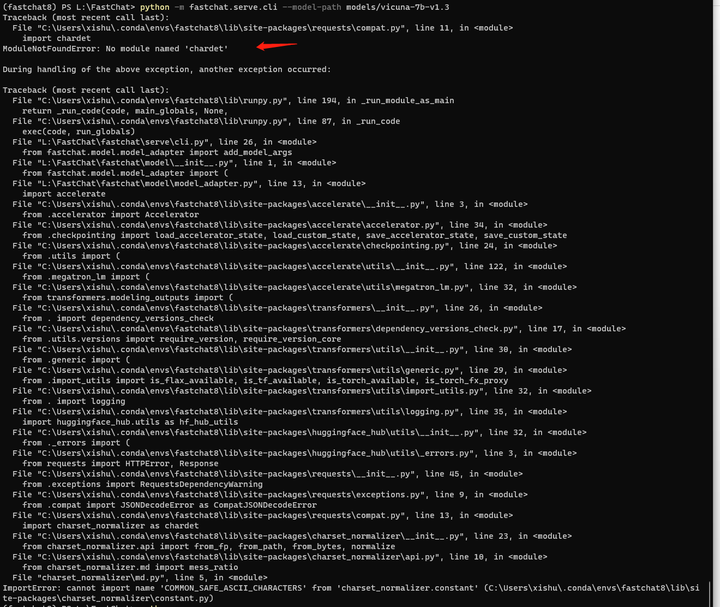

再次执行:python -m fastchat.serve.cli --model-path models/vicuna-7b-v1.3

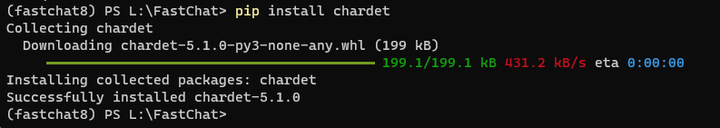

看来是缺包,那么就安装一下:

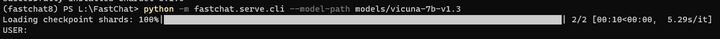

再来:python -m fastchat.serve.cli --model-path models/vicuna-7b-v1.3

启动后,进入提示页面了。

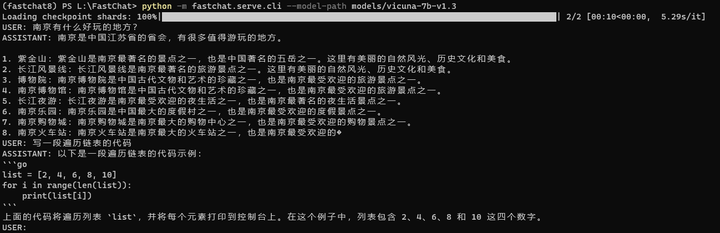

输入一些对话试试:

在运算的过程中,GPU能到100%,计算完毕后,使用率又降了下来:

好像没啥问题。

看来Nvidia GPU应该都是支持的呢!

(全文完,谢谢阅读)

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)