神经网络的基本概念、架构和训练方法

神经网络是一种由多个神经元按照一定的拓扑结构相互连接而成的计算模型。其灵感来自于人类大脑中神经元之间的相互作用。

在过去的几十年里,神经网络一直是人工智能领域中的热门研究方向之一。随着深度学习的兴起,神经网络的应用越来越广泛。本文将详细介绍神经网络的基本概念、架构和训练方法。

基本概念

神经元

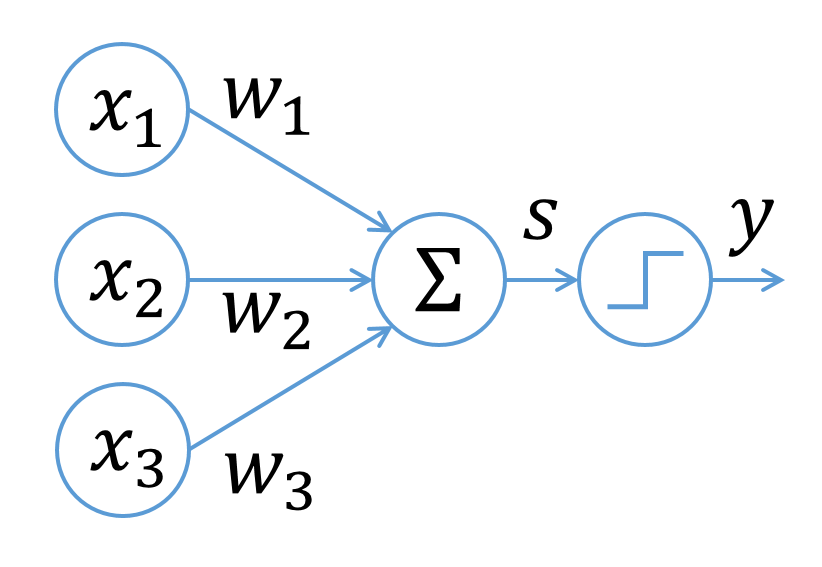

神经元是神经网络的基本组成单元。它接收输入信号,通过对输入信号的处理产生输出信号。每个神经元都有多个输入和一个输出。输入可以是其他神经元的输出,也可以是外部输入信号。输出则通常会被传递给其他神经元。

神经元的输出通常是由激活函数计算得到的。常见的激活函数包括sigmoid函数、ReLU函数、tanh函数等。不同的激活函数有不同的性质,可以根据具体的任务需求选择不同的激活函数。

神经网络的拓扑结构

神经网络的拓扑结构通常由三部分组成:输入层、隐藏层和输出层。输入层接受外部输入信号,隐藏层和输出层则由多个神经元组成。隐藏层和输出层之间的连接方式决定了神经网络的拓扑结构。常见的拓扑结构包括前馈神经网络、循环神经网络和卷积神经网络等。

前馈神经网络是最常见的神经网络结构之一,其拓扑结构为输入层、若干个隐藏层和输出层。前馈神经网络的每个神经元只与下一层的神经元相连接,不存在环路。

循环神经网络是一种带有反馈连接的神经网络,它的拓扑结构可以被表示为一个循环。循环神经网络具有记忆功能,可以处理序列数据。

卷积神经网络是专门用于处理图像和语音等二维或三维数据的神经网络。它的拓扑结构采用卷积操作,可以有效地提取图像和语音中的特征。

神经网络的训练

神经网络的训练通常分为前向传播和反向传播两个步骤。前向传播是指从输入层到输出层的信号传递过程,输出层的输出信号会被与实际输出进行比较,从而得到误差。反向传播则是根据误差信号,从输出层往回逐层调整神经元的权重和偏置,从而使得误差最小化。

具体地,神经网络的训练可以采用梯度下降法。梯度下降法通过对损失函数求导,找到使得损失函数最小的权重和偏置。损失函数通常采用均方误差函数、交叉熵函数等。

在训练过程中,通常需要采用一些技巧来提高神经网络的性能。比如,为了避免过拟合,可以采用正则化技巧;为了加快训练速度,可以采用批量梯度下降法等。

神经网络的应用

神经网络在图像识别、语音识别、自然语言处理等领域都有广泛的应用。以下是几个典型的应用案例。

图像识别

神经网络在图像识别方面的应用最为广泛。深度学习领域最著名的应用案例之一就是ImageNet图像识别挑战赛。该比赛要求参赛者使用给定的训练集训练一个模型,在测试集上识别图像的类别。在2012年之前,该比赛的错误率一直很高。但自从2012年AlexNet模型问世以来,错误率大幅下降,创造了历史性的突破。自此之后,神经网络在图像识别方面的应用得到了广泛的发展。

语音识别

神经网络在语音识别方面的应用也非常成功。语音识别系统通常包括三个部分:前端特征提取、声学模型和语言模型。前端特征提取可以将语音信号转化为频谱图或梅尔倒谱系数等形式的特征向量。声学模型可以将这些特征向量转化为声学单元序列。语言模型则可以根据声学单元序列预测出最有可能的文本输出。

神经网络在语音识别方面的应用可以追溯到20世纪80年代。但是,由于当时计算能力和数据量的限制,神经网络的应用受到了很大的限制。随着深度学习的兴起,神经网络在语音识别方面的应用取得了巨大的进展。目前,基于神经网络的语音识别系统已经成为主流,包括谷歌、微软、百度等公司都在这一领域有所涉猎。

自然语言处理

神经网络在自然语言处理方面的应用也非常成功。自然语言处理主要包括文本分类、命名实体识别、情感分析等任务。这些任务通常需要将自然语言转化为向量表示,然后再利用神经网络对向量进行分类或回归。目前,基于神经网络的自然语言处理模型已经在很多应用场景中得到了广泛的应用,包括智能客服、机器翻译、智能搜索等。

神经网络的发展趋势

随着深度学习的发展,神经网络在各个领域的应用不断扩大。但是,神经网络的训练过程仍然存在一些问题,比如训练时间长、收敛不稳定等。未来,我们可以期待更加高效和稳定的训练算法的出现。同时,神经网络的结构也会不断演化,比如引入更多的注意力机制、使用更加灵活的网络结构等。此外,神经网络的应用也将不断扩展到更加复杂的领域,比如自动驾驶、机器人等。

总之,神经网络是深度学习的核心技术之一,它通过模拟人脑神经元的方式实现了复杂的信息处理功能。神经网络在图像识别、语音识别、自然语言处理等领域都有广泛的应用。随着深度学习的发展,神经网络的应用也将不断扩展和深化,为人工智能的发展带来更大的推动力。

- 点赞

- 收藏

- 关注作者

评论(0)